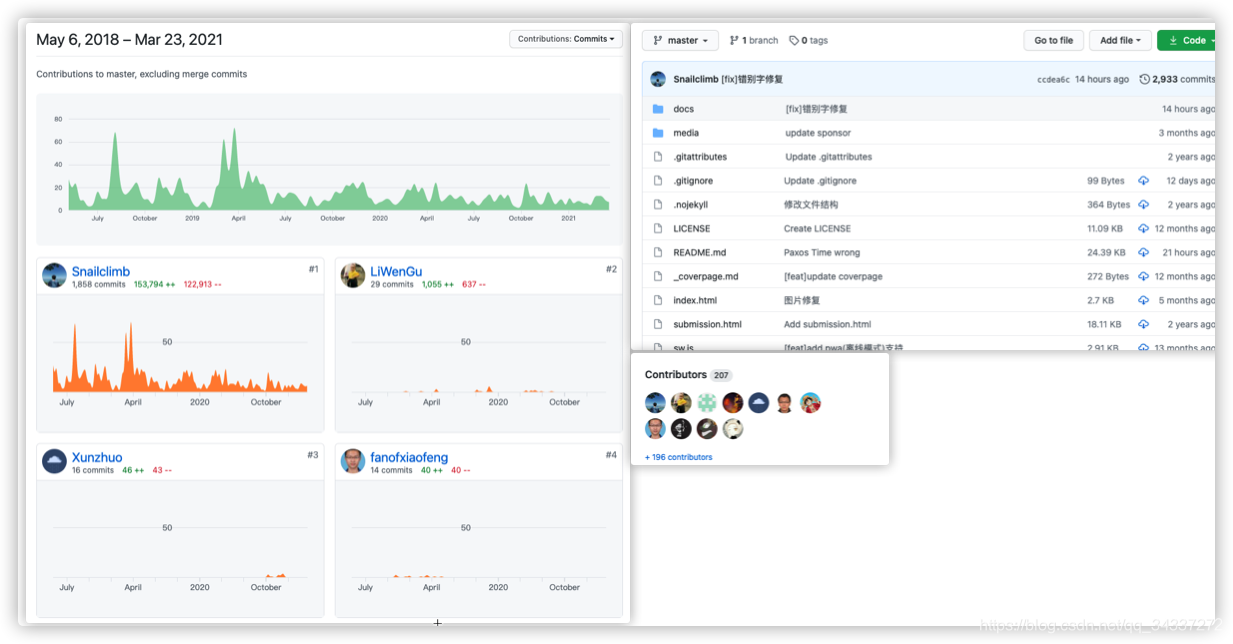

Compare commits

42 Commits

c1fc5ac09c

...

9d9b55a2ae

| Author | SHA1 | Date | |

|---|---|---|---|

|

|

9d9b55a2ae | ||

|

|

818ccbca79 | ||

|

|

fcdbe12190 | ||

|

|

f3754a92d4 | ||

|

|

72019c2b09 | ||

|

|

a19b2744b0 | ||

|

|

19cb0cd775 | ||

|

|

372cb240ca | ||

|

|

954364882e | ||

|

|

3f2471340c | ||

|

|

0d8c0c0fb3 | ||

|

|

f3c36f2916 | ||

|

|

5678155022 | ||

|

|

ef93bec410 | ||

|

|

d993af3421 | ||

|

|

76b220540b | ||

|

|

a13c531f35 | ||

|

|

881bc5c591 | ||

|

|

22e3ef1efc | ||

|

|

9153648dba | ||

|

|

4df51f86e9 | ||

|

|

6bdc809e2f | ||

|

|

72c52dba3e | ||

|

|

893c673f1c | ||

|

|

2975f2f244 | ||

|

|

a788fc300d | ||

|

|

7f877f8e5f | ||

|

|

8f8d7c102a | ||

|

|

cf9e96aa6c | ||

|

|

566c75d5a4 | ||

|

|

675d97ce1b | ||

|

|

fac0c7698d | ||

|

|

be1b2f46ce | ||

|

|

be6c1faa03 | ||

|

|

7703240ba3 | ||

|

|

638181bf70 | ||

|

|

44e5cfa5d2 | ||

|

|

e5d5c357b3 | ||

|

|

db776f0fd2 | ||

|

|

dff5130082 | ||

|

|

8f2cc4b8b2 | ||

|

|

bc083f989c |

29

.github/workflows/test.yml

vendored

Normal file

@ -0,0 +1,29 @@

|

||||

name: Docs Test

|

||||

|

||||

on:

|

||||

- push

|

||||

- pull_request

|

||||

|

||||

jobs:

|

||||

test-docs:

|

||||

name: Test docs

|

||||

runs-on: ubuntu-latest

|

||||

steps:

|

||||

- name: Checkout

|

||||

uses: actions/checkout@v3

|

||||

|

||||

- name: Install pnpm

|

||||

uses: pnpm/action-setup@v2

|

||||

with:

|

||||

run_install: true

|

||||

|

||||

- name: Setup Node.js

|

||||

uses: actions/setup-node@v3

|

||||

with:

|

||||

node-version: 18

|

||||

cache: pnpm

|

||||

|

||||

- name: Build test

|

||||

env:

|

||||

NODE_OPTIONS: --max_old_space_size=4096

|

||||

run: pnpm docs:build

|

||||

13

.gitignore

vendored

@ -1,15 +1,14 @@

|

||||

/node_modules

|

||||

/package-lock.json

|

||||

node_modules/

|

||||

# *.drawio

|

||||

*.drawio.bkp

|

||||

.DS_Store

|

||||

# VS Code Config file

|

||||

.vscode/

|

||||

# Vuepress Cache

|

||||

.cache/

|

||||

# Vuepress Temp

|

||||

.temp/

|

||||

# Vuepress Output

|

||||

# VuePress Cache

|

||||

**/.vuepress/.cache/

|

||||

# VuePress Temp

|

||||

**/.vuepress/.temp/

|

||||

# VuePress Output

|

||||

dist/

|

||||

# Build files

|

||||

packages/*/lib/

|

||||

|

||||

4

.husky/pre-commit

Executable file

@ -0,0 +1,4 @@

|

||||

#!/bin/sh

|

||||

. "$(dirname "$0")/_/husky.sh"

|

||||

|

||||

pnpm nano-staged

|

||||

20

.markdownlint.json

Normal file

@ -0,0 +1,20 @@

|

||||

{

|

||||

"default": true,

|

||||

"MD003": {

|

||||

"style": "atx"

|

||||

},

|

||||

"MD004": {

|

||||

"style": "dash"

|

||||

},

|

||||

"MD013": false,

|

||||

"MD024": {

|

||||

"allow_different_nesting": true

|

||||

},

|

||||

"MD035": {

|

||||

"style": "---"

|

||||

},

|

||||

"MD040": false,

|

||||

"MD045": false,

|

||||

"MD046": false,

|

||||

"MD049": false

|

||||

}

|

||||

4

.markdownlintignore

Normal file

@ -0,0 +1,4 @@

|

||||

**/node_modules/**

|

||||

|

||||

# markdown snippets

|

||||

*.snippet.md

|

||||

15

.prettierignore

Normal file

@ -0,0 +1,15 @@

|

||||

# Vuepress Cache

|

||||

**/.vuepress/.cache/**

|

||||

# Vuepress Temp

|

||||

**/.vuepress/.temp/**

|

||||

# Vuepress Output

|

||||

dist/

|

||||

|

||||

# Node modules

|

||||

node_modules/

|

||||

|

||||

# pnpm lock file

|

||||

pnpm-lock.yaml

|

||||

|

||||

index.html

|

||||

sw.js

|

||||

375

README.en.md

@ -1,375 +0,0 @@

|

||||

<p style="text-align:center">

|

||||

<a href="https://github.com/Snailclimb/JavaGuide" target="_blank">

|

||||

<img src="https://oss.javaguide.cn/github/javaguide/csdn/1c00413c65d1995993bf2b0daf7b4f03.png" width=""/>

|

||||

</a>

|

||||

</p>

|

||||

<p style="text-align:center">

|

||||

<a href="https://javaguide.cn/"><img src="https://img.shields.io/badge/阅读-read-brightgreen.svg" alt="阅读"></a>

|

||||

<img src="https://img.shields.io/github/stars/Snailclimb/JavaGuide" alt="stars"/>

|

||||

<img src="https://img.shields.io/github/forks/Snailclimb/JavaGuide" alt="forks"/>

|

||||

<img src="https://img.shields.io/github/issues/Snailclimb/JavaGuide" alt="issues"/>

|

||||

</p>

|

||||

<h3 style="text-align:center">Recommended</h3>

|

||||

<table>

|

||||

<tbody>

|

||||

<tr>

|

||||

<td style="text-align:center" valign="middle">

|

||||

<a href="https://sourl.cn/e7ee87">

|

||||

<img src="https://oss.javaguide.cn/xingqiu/xingqiu.png" style="margin: 0 auto;width:850px" /></a>

|

||||

</td>

|

||||

</tr>

|

||||

</tbody>

|

||||

</table>

|

||||

|

||||

|

||||

## Java

|

||||

|

||||

### Basis

|

||||

|

||||

**Knowledge points/interview questions**: (Must see:+1: ):

|

||||

|

||||

- [Java Basics Knowledge Points/Interview Questions Summary(1)](docs/java/basis/java-basic-questions-01.md)

|

||||

- [Java Basics Knowledge Points/Interview Questions Summary(2)](docs/java/basis/java-basic-questions-01.md)

|

||||

- [Java Basics Knowledge Points/Interview Questions Summary(3)](docs/java/basis/java-basic-questions-01.md)

|

||||

|

||||

**Important Knowledge Points Explained:**

|

||||

|

||||

- [Why only value passing in Java?](docs/java/basis/why-thereis-only-value-passing-in-java.md)

|

||||

- [What is the reflection mechanism? What are the application scenarios of reflection mechanism?](docs/java/basis/反射机制详解.md)

|

||||

- (docs/java/basis/proxy-model-detail.md) [proxy-model-detail: static proxy + JDK/CGLIB dynamic proxy practice](docs/java/basis/代理模式详解.md)

|

||||

- [What are the common IO models and what is the difference between BIO, NIO, AIO in Java?](docs/java/basis/io模型详解.md)

|

||||

- [BigDecimal solve floating point problem](docs/java/basis/bigdecimal.md)

|

||||

|

||||

### Collection

|

||||

|

||||

1. **[Java collection FAQ summary](docs/java/collection/java集合框架基础知识&面试题总结.md)** (must see :+1:)

|

||||

2. [Summary of considerations for using Java containers](docs/java/collection/java集合使用注意事项.md)

|

||||

3. **source code analysis** : [ArrayList source code + expansion mechanism analysis](docs/java/collection/arraylist-source-code.md),

|

||||

[HashMap(JDK1.8) source code + underlying data structure analysis](docs/java/collection/ hashmap-source-code.md),

|

||||

[ConcurrentHashMap source code + underlying data structure analysis](docs/java/collection/concurrent-hash-map-source-code.md)

|

||||

|

||||

### Concurrency

|

||||

|

||||

**Knowledge/Interview Questions:** (Must see :+1:)

|

||||

|

||||

1. **[Java concurrency basic common interview questions summary](docs/java/concurrent/java并发基础常见面试题总结.md)**

|

||||

2. **[Java concurrency advanced common interview questions summary](docs/java/concurrent/java并发进阶常见面试题总结.md)**

|

||||

|

||||

**Important Knowledge Points Explained:**

|

||||

|

||||

1. **Thread pool**: [Java thread pool learning summary](./docs/java/concurrent/java-thread-pool-summary.md), [Java thread pooling best practices](./docs/java/concurrent/java-thread-pool-best-practices.md)

|

||||

2. [ThreadLocal keyword resolution](docs/java/concurrent/threadlocal.md)

|

||||

3. [Java concurrency container summary](docs/java/concurrent/java-concurrent-collections.md)

|

||||

4. [Atomic atomic class summary](docs/java/concurrent/atomic-classes.md)

|

||||

5. [AQS principle and AQS synchronization component summary](docs/java/concurrent/aqs.md)

|

||||

6. [Getting Started with CompletableFuture](docs/java/concurrent/completablefuture-intro.md)

|

||||

|

||||

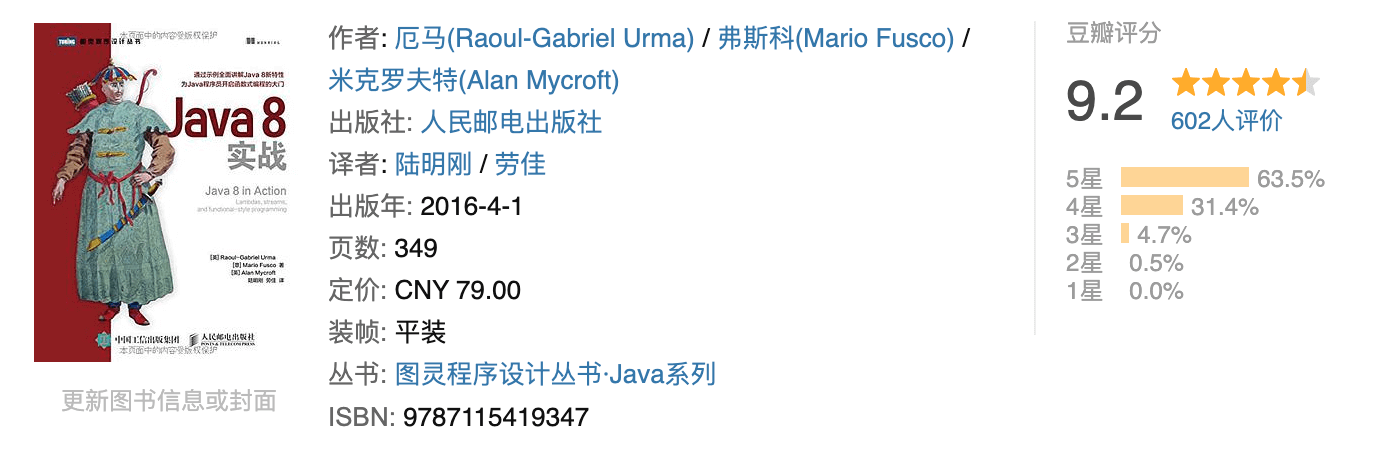

### JVM (must see :+1:)

|

||||

|

||||

This part of JVM mainly refers to [JVM Virtual Machine Specification-Java8 ](https://docs.oracle.com/javase/specs/jvms/se8/html/index.html) and Mr. Zhou's [In-depth Understanding of Java Virtual Machine (3rd Edition)](https://book.douban.com/subject/34907497/) (Highly recommended to read more than once!) .

|

||||

|

||||

1. **[Java Memory Regions](https://javaguide.cn/java/jvm/jvm-garbage-collection/)**

|

||||

2. **[JVM Garbage Collection](https://javaguide.cn/java/jvm/jvm-garbage-collection/)**

|

||||

3. [JDK monitoring and troubleshooting tools](https://javaguide.cn/java/jvm/jdk-monitoring-and-troubleshooting-tools/)

|

||||

4. [Class file structure](https://javaguide.cn/java/jvm/class-file-structure/)

|

||||

5. **[Class loading process](https://javaguide.cn/java/jvm/class-loading-process/)**

|

||||

6. [Class loader](https://javaguide.cn/java/jvm/classloader/)

|

||||

7. **[[To be completed] Summary of the most important JVM parameters (half of the translation is perfected)](https://javaguide.cn/java/jvm/jvm-parameters-intro/)**

|

||||

8. **[[Extra Meal] The Big White Word takes you through the JVM](https://javaguide.cn/java/jvm/jvm-intro/)**

|

||||

|

||||

### New features

|

||||

|

||||

1. **Java 8**: [Java 8 new features summary](docs/java/new-features/Java8新特性总结.md), [Java8 common new features summary](docs/java/new-features/java8-common-new-features.md)

|

||||

2. **Java9~Java15** : [An article to take you through the important new features of JDK9~15!](./docs/java/new-features/java新特性总结.md)

|

||||

|

||||

### Tips

|

||||

|

||||

1. [JAD decompile](docs/java/tips/JAD反编译tricks.md)

|

||||

2. [Handy for locating common Java performance problems](./docs/java/tips/locate-performance-problems/手把手教你定位常见Java性能问题.md)

|

||||

|

||||

|

||||

## Computer Basics

|

||||

|

||||

👉 **[Illustrated Computer Fundamentals PDF Download](https://mp.weixin.qq.com/s?__biz=Mzg2OTA0Njk0OA==&mid=100021725&idx=1&sn=2db9664ca25363139a81691043e9fd8f&chksm=4ea19a1679d61300d8990f7e43bfc7f476577a81b712cf0f9c6f6552a8b219bc081efddb5c54#rd)** .

|

||||

|

||||

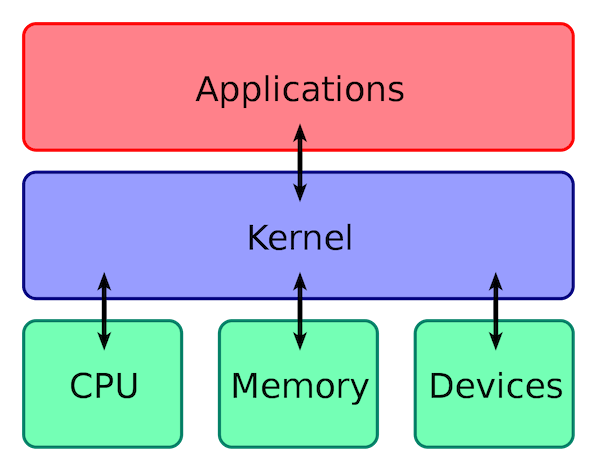

### Operating system

|

||||

|

||||

1. [OS FAQ summary!](docs/cs-basics/operating-system/操作系统常见面试题&知识点总结.md)

|

||||

2. [Backend programmer essential Linux basics summary](docs/cs-basics/operating-system/linux-intro.md)

|

||||

3. [Introduction to Shell Programming](docs/cs-basics/operating-system/shell-intro.md)

|

||||

|

||||

### Networking

|

||||

|

||||

1. [Computer Network Common Interview Questions](docs/cs-basics/network/计算机网络常见面试题.md)

|

||||

2. [Xie Xiren teacher's "computer network" content summary](docs/cs-basics/network/谢希仁老师的《计算机网络》内容总结.md)

|

||||

|

||||

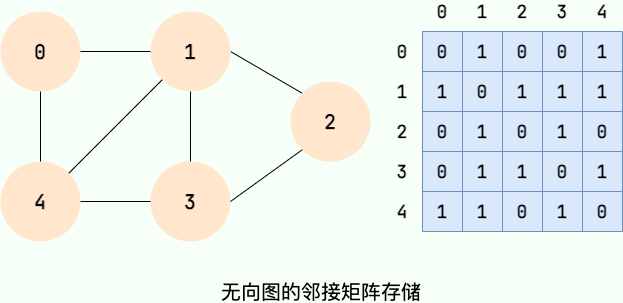

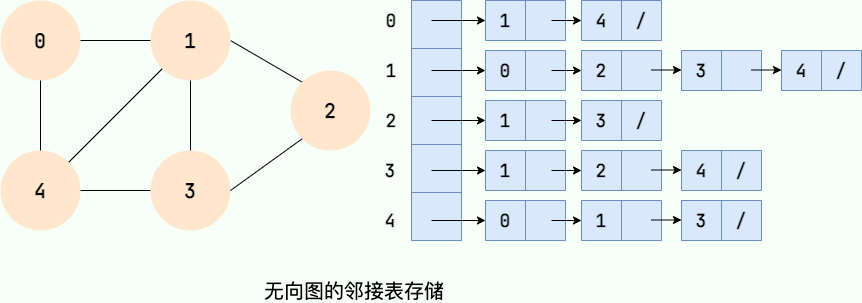

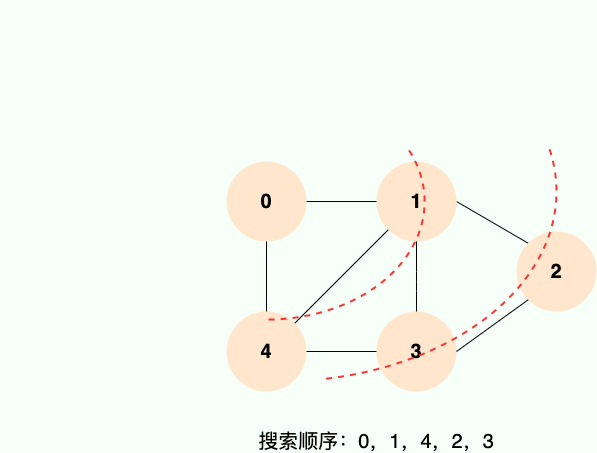

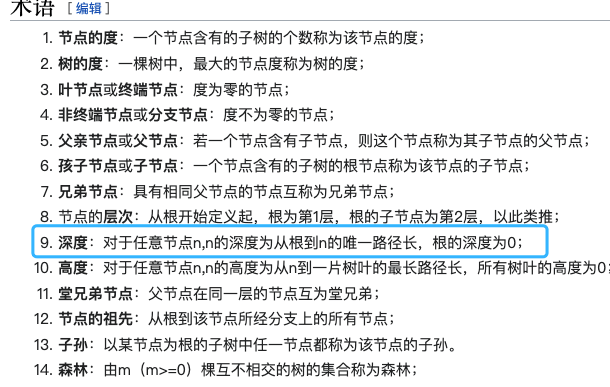

### Data Structures

|

||||

|

||||

**Diagrammatic Data Structures :**

|

||||

|

||||

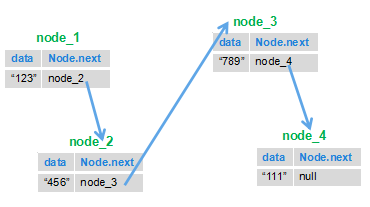

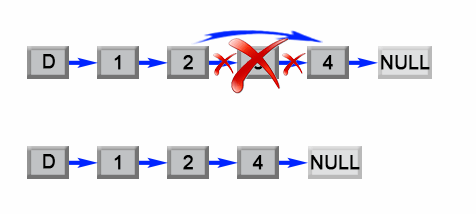

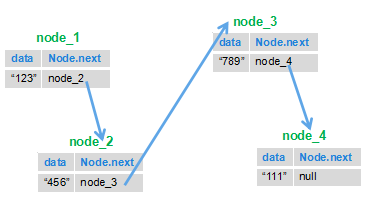

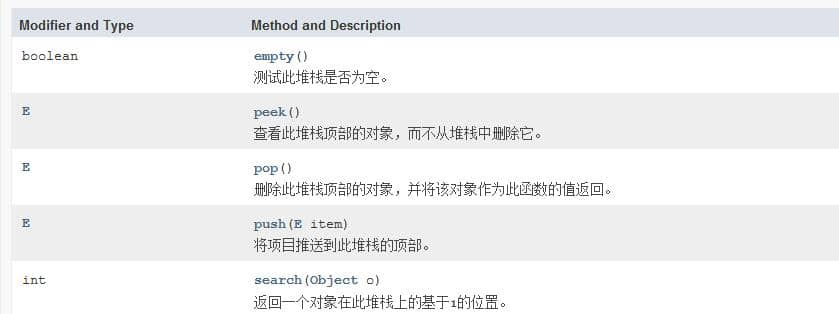

1. [Linear data structure :array, chain table, stack, queue](docs/cs-basics/data-structure/线性数据结构.md)

|

||||

2. [diagram](docs/cs-basics/data-structure/图.md)

|

||||

3. [heap](docs/cs-basics/data-structure/堆.md)

|

||||

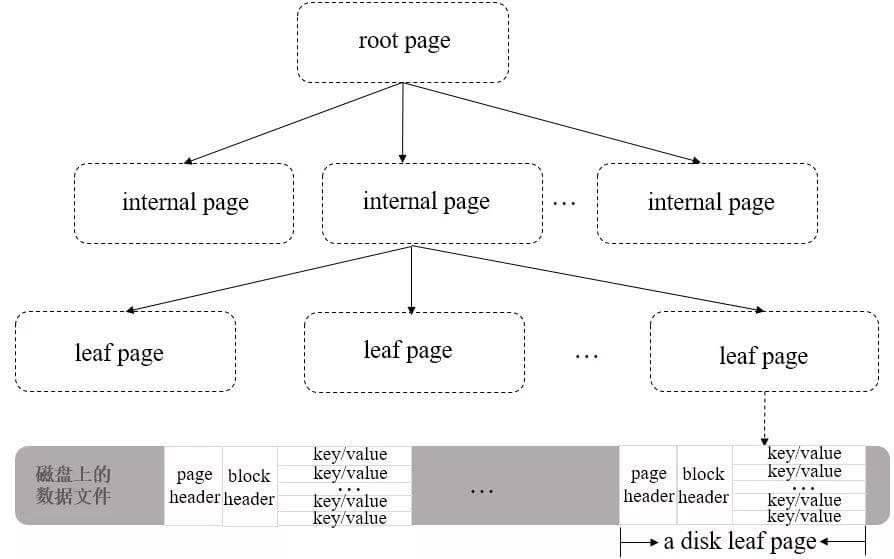

4. [tree](docs/cs-basics/data-structure/树.md) : focus on [red-black-tree](docs/cs-basics/data-structure/红黑树.md), B-, B+, B* tree, LSM tree

|

||||

|

||||

Other common data structures : 1.

|

||||

|

||||

1. [Bloom filter](docs/cs-basics/data-structure/bloom-filter.md)

|

||||

|

||||

|

||||

### Algorithm

|

||||

|

||||

This part of the algorithm is very important, if you do not know how to learn the algorithm, you can look at what I wrote.

|

||||

|

||||

- [Recommended Algorithm Learning Books + Resources](https://www.zhihu.com/question/323359308/answer/1545320858) 。

|

||||

- [如何刷Leetcode?](https://www.zhihu.com/question/31092580/answer/1534887374)

|

||||

|

||||

**Summary of common algorithm problems** :

|

||||

|

||||

- [Several Common String Algorithm Questions Summarized ](docs/cs-basics/algorithms/几道常见的字符串算法题.md)

|

||||

- [Summary of several common algorithm problems of the chain table ](docs/cs-basics/algorithms/几道常见的链表算法题.md)

|

||||

- [Link offer some programming questions](docs/cs-basics/algorithms/剑指offer部分编程题.md)

|

||||

|

||||

In addition,[GeeksforGeeks]( https://www.geeksforgeeks.org/fundamentals-of-algorithms/) This site summarizes the common algorithms, which are more comprehensive and systematic.

|

||||

|

||||

## Database

|

||||

|

||||

### MySQL

|

||||

|

||||

**Summary:**

|

||||

|

||||

1. [Database Basics Summary](docs/database/数据库基础知识.md)

|

||||

2. **[MySQL Knowledge Summary](docs/database/mysql/mysql知识点&面试题总结.md)** (Must see:+1:)

|

||||

5. [MySQL High Performance Optimization Specification Recommendations](docs/database/mysql/mysql-high-performance-optimization-specification-recommendations.md)

|

||||

|

||||

**Important knowledge points:**

|

||||

|

||||

1. [Transaction isolation level (graphic detail)](docs/database/mysql/transaction-isolation-level.md)

|

||||

2. [MySQL's Three Major Logs (binlog, redo log and undo log) Explained](docs/database/mysql/mysql-logs.md)

|

||||

3. [InnoDB storage engine implementation of MVCC](docs/database/mysql/innodb-implementation-of-mvcc.md)

|

||||

4. [How does a SQL statement get executed in MySQL?](docs/database/mysql/how-sql-executed-in-mysql.md)

|

||||

5. [Character set details: Why is it not recommended to use utf8 in MySQL?](docs/database/字符集.md)

|

||||

6. [A little thought on how to store time in the database](docs/database/mysql/some-thoughts-on-database-storage-time.md)

|

||||

|

||||

### Redis

|

||||

|

||||

1. [Redis FAQ Summary](docs/database/redis/redis-questions-01.md)

|

||||

2. [3 common cache read and write strategies](docs/database/redis/3-commonly-used-cache-read-and-write-strategies.md)

|

||||

|

||||

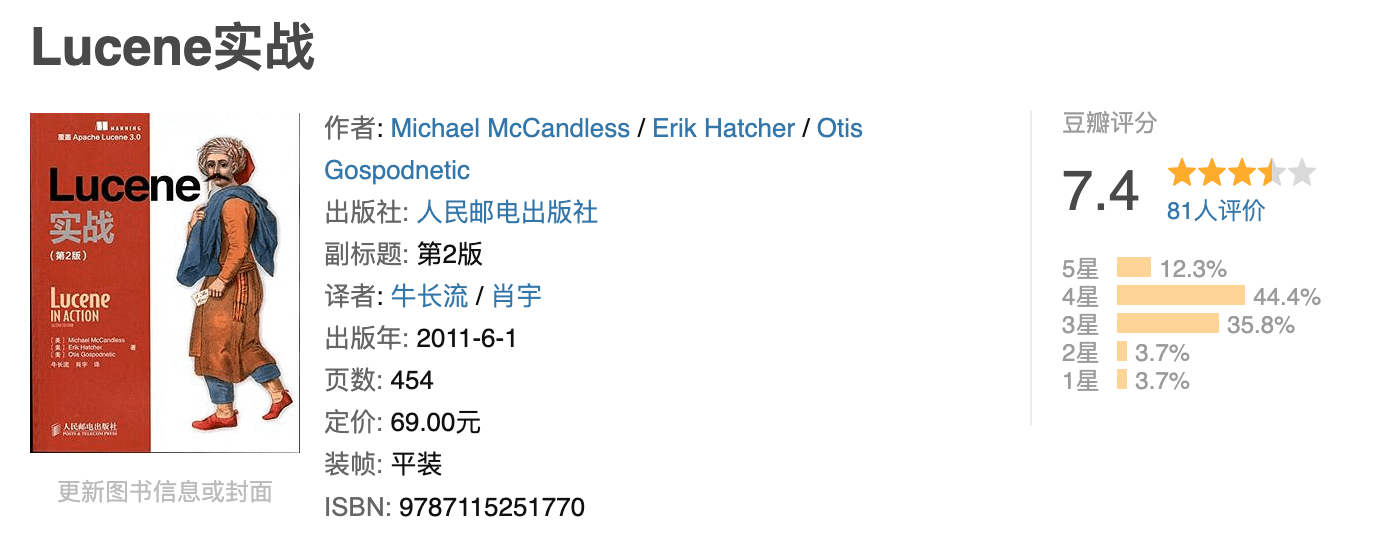

## Search Engine

|

||||

|

||||

It is used to improve search efficiency and functions similarly to browser search engines. The more common search engines are Elasticsearch (recommended) and Solr.

|

||||

|

||||

## System design

|

||||

|

||||

### System design essential foundation

|

||||

|

||||

#### RESTful API

|

||||

|

||||

When we do back-end development, our main job is to provide APIs for front-end or other back-end services such as APIs for querying user data. a RESTful API is an API built on REST, and it is an API designed to be better used.

|

||||

|

||||

Related reading: [RestFul API Brief Tutorial](docs/system-design/basis/RESTfulAPI.md)

|

||||

|

||||

#### Name

|

||||

|

||||

During programming, you must pay attention to naming. Because a good naming is a comment, others will know what your variable, method or class does as soon as they see your naming!

|

||||

|

||||

Read more about: [Java Naming](docs/system-design/naming.md) 。

|

||||

|

||||

### Common frameworks

|

||||

|

||||

If you have not touched Java Web development, you can first look at my summary of [J2EE Basics](docs/system-design/J2EE基础知识.md). Although much of the content in this article is now obsolete, it will give you a deeper understanding of Java backend technology development.

|

||||

|

||||

#### Spring/SpringBoot (must see :+1:)

|

||||

|

||||

**Knowledge/Interview Questions:**

|

||||

|

||||

1. **[Spring FAQ Summary](docs/system-design/framework/spring/Spring常见问题总结.md)**

|

||||

2. **[SpringBoot Getting Started Guide](https://github.com/Snailclimb/springboot-guide)**

|

||||

|

||||

**Important Knowledge Points Explained:** 1.

|

||||

|

||||

1. **[Spring/Spring Boot common annotations summary! Arrangement!](./docs/system-design/framework/spring/Spring&SpringBoot常用注解总结.md)**

|

||||

2. **[Spring Transaction Summary](docs/system-design/framework/spring/Spring事务总结.md)**

|

||||

3. [What design patterns are used in Spring?](docs/system-design/framework/spring/Spring设计模式总结.md)

|

||||

4. **[SpringBoot auto-assembly principle?"](docs/system-design/framework/spring/SpringBoot自动装配原理.md)**

|

||||

|

||||

#### MyBatis

|

||||

|

||||

[MyBatis Common Interview Questions Summary](docs/system-design/framework/mybatis/mybatis-interview.md)

|

||||

|

||||

### Security

|

||||

|

||||

#### Certification Authorization

|

||||

|

||||

**[Fundamentals of Certification Authorization](docs/system-design/security/basis-of-authority-certification.md)** In this article I will introduce the common concepts of authentication and authorization: **Authentication**, **Authorization** and **Cookie**, **Session**, Token, **OAuth 2**, **SSO**. If you are not clear about these concepts, we suggest you read this article properly.

|

||||

|

||||

- **JWT** : JWT (JSON Web Token) is a form of authentication, where a JWT is essentially a signed piece of data in JSON format. Since it is signed, the recipient can verify its authenticity. Related reading.

|

||||

- [JWT Pros and Cons Analysis and Solutions to Common Problems](docs/system-design/security/jwt优缺点分析以及常见问题解决方案.md)

|

||||

- [Demo for beginners to get started with Spring Security With JWT](https://github.com/Snailclimb/spring-security-jwt-guide)

|

||||

|

||||

- **SSO(Single Sign On)**: **SSO(Single Sign On)** that is, single sign on means that a user has the right to access other systems related to him/her by logging into one of the multiple subsystems. For example, after we logged into Jingdong Finance, we also successfully logged into Jingdong Supermarket, Jingdong Home Appliances and other subsystems of Jingdong. Related reading: [**SSO Single Sign-On is enough to read this article! **](docs/system-design/security/sso-intro.md)

|

||||

|

||||

#### Data Desensitization

|

||||

|

||||

Data desensitization means that we deform sensitive information data according to specific rules, for example, we replace certain digits of cell phone numbers and ID numbers with *.

|

||||

|

||||

### Timed tasks

|

||||

|

||||

Recently, some friends asked about timing task related issues. So, I simply wrote an article to summarize some concepts of timed tasks and some common timed task technology options: ["Java Timed Tasks Revealed"].(./docs/system-design/定时任务.md)

|

||||

|

||||

## Distributed

|

||||

|

||||

### CAP theory and BASE theory

|

||||

|

||||

CAP is also the combination of the initials Consistency, Availability, and Partition Tolerance.

|

||||

|

||||

**BASE** is an acronym for **Basically Available**, **Soft-state**, and **Eventually Consistent**. The BASE theory is the result of a trade-off between consistency and availability in the CAP, and is derived from a summary of distributed practices for large-scale Internet systems, evolving from the CAP theorem, which significantly reduces our system requirements.

|

||||

|

||||

Related reading: [CAP Theory and BASE Theory Explained](docs/distributed-system/theorem&algorithm&protocol/cap&base-theorem.md)

|

||||

|

||||

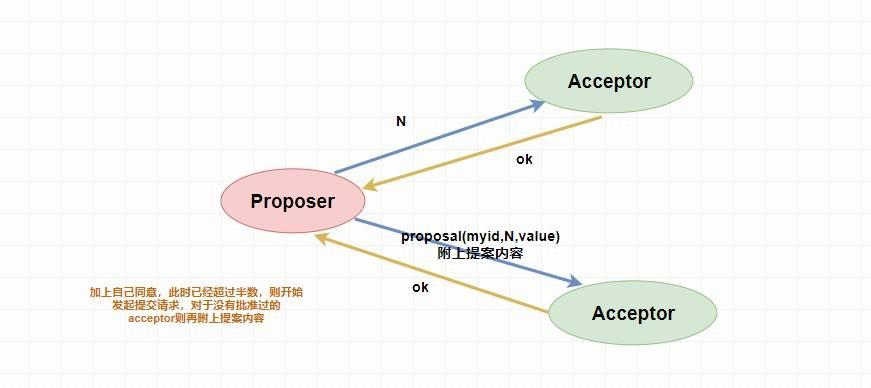

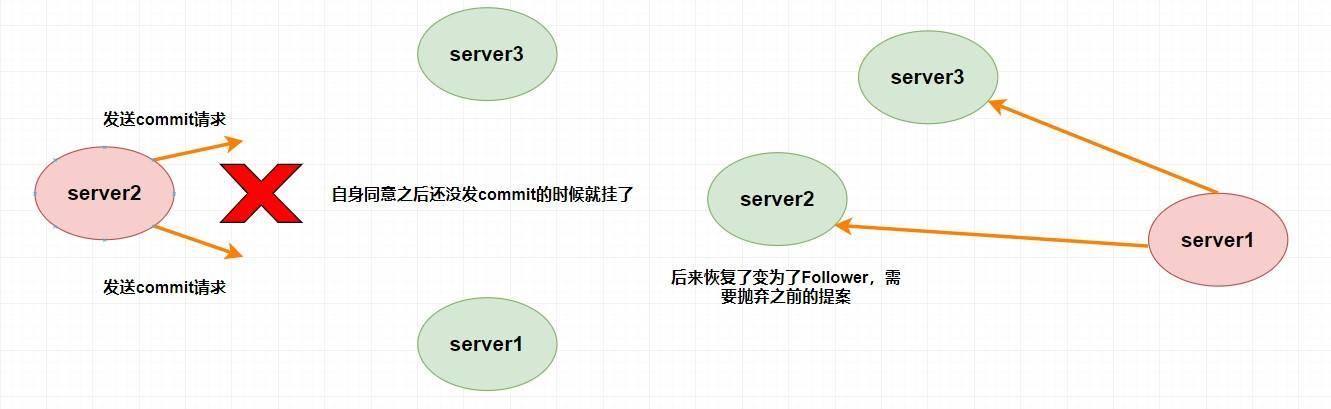

### Paxos algorithm and Raft algorithm

|

||||

|

||||

The **Paxos algorithm** was born in 1990 as a classical algorithm for solving the consistency of distributed systems. However, since the Paxos algorithm was very difficult to understand and implement, there were continuous attempts to simplify it. Only in 2013 was a distributed consistency algorithm born that is easier to understand and implement than the Paxos algorithm - the **Raft algorithm**.

|

||||

|

||||

### RPC

|

||||

|

||||

RPC makes calling remote service calls as easy as calling local methods.

|

||||

|

||||

Dubbo is a home-grown RPC framework , open source by Ali . Related reading.

|

||||

|

||||

- [Dubbo FAQ Summary](docs/distributed-system/rpc/dubbo.md)

|

||||

|

||||

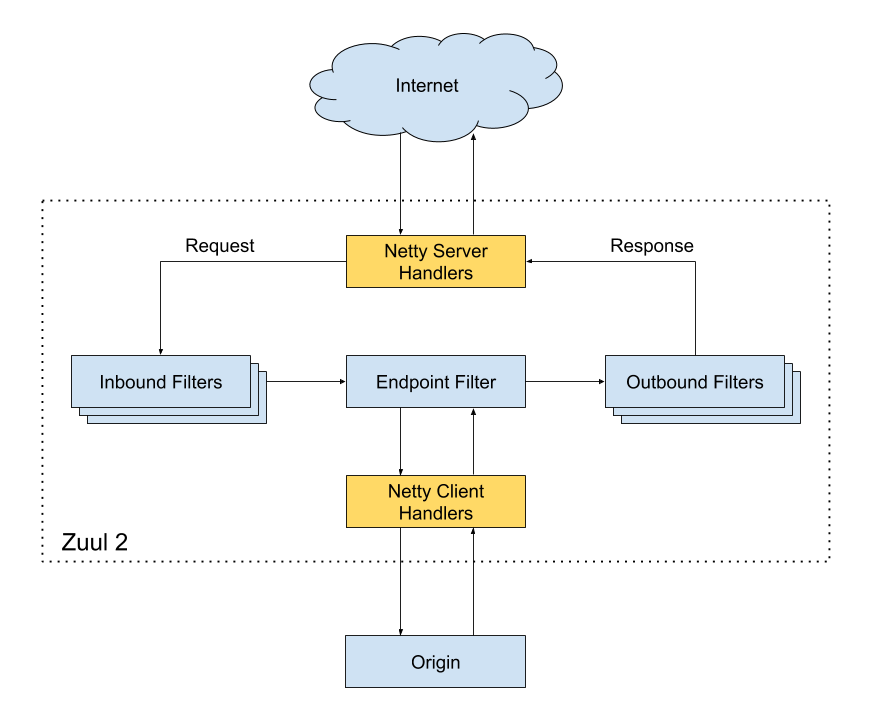

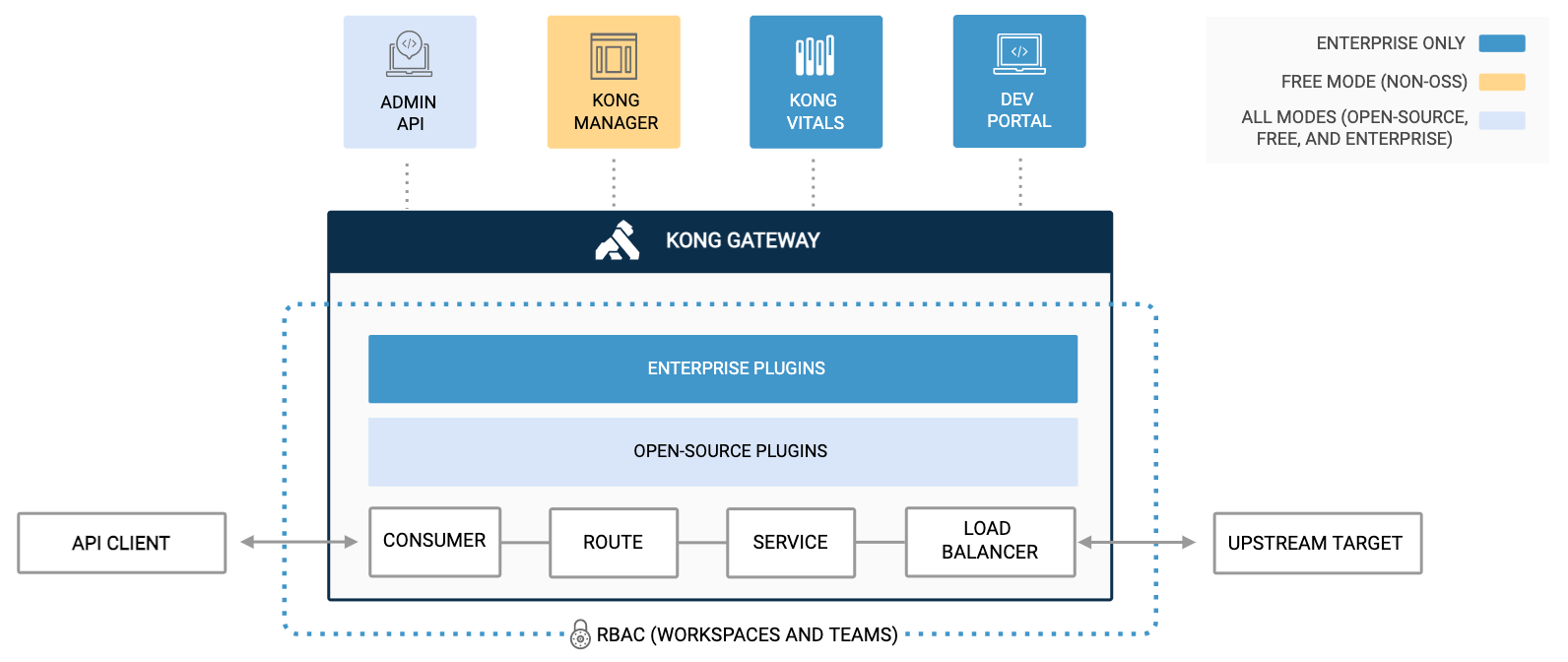

### API gateway

|

||||

|

||||

Gateways are mainly used for request forwarding, security authentication, protocol conversion, and disaster recovery.

|

||||

|

||||

Related reading.

|

||||

|

||||

- [Why gateways? What common gateway systems do you know of?](docs/distributed-system/api-gateway.md)

|

||||

- [Design and Implementation of Shepherd, a 10 Billion Dollar API Gateway Service](https://tech.meituan.com/2021/05/20/shepherd-api-gateway.html)

|

||||

|

||||

### Distributed IDs

|

||||

|

||||

In complex distributed systems, a large amount of data and messages often need to be uniquely identified. For example, after the data volume is too large, it is often necessary to split the data into libraries and tables, and after the splitting of the libraries and tables, a unique ID is needed to identify a piece of data or a message, and the self-incrementing ID of the database obviously cannot meet the demand. Related reading: [Why distributed id? What are the distributed id generation solutions?](docs/distributed-system/distributed-id.md)

|

||||

|

||||

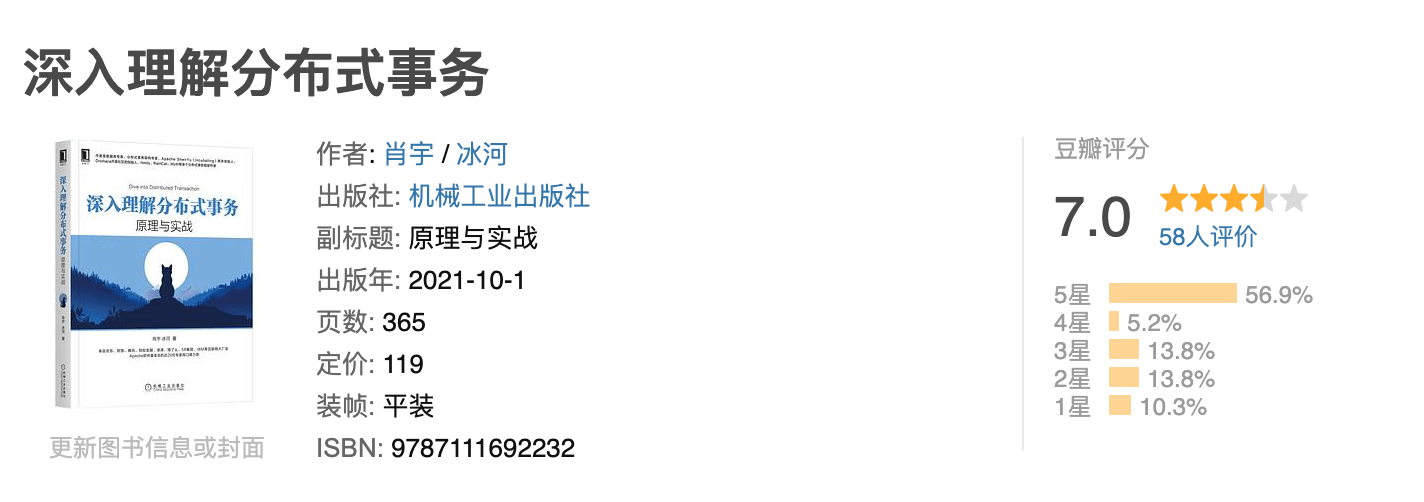

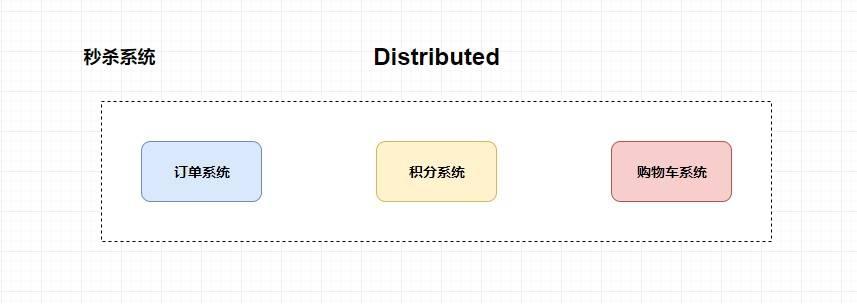

### Distributed transactions

|

||||

|

||||

** A distributed transaction is one in which the participants of the transaction, the server supporting the transaction, the resource server, and the transaction manager are located on different nodes of different distributed systems. **

|

||||

|

||||

Simply put, a large operation consists of different small operations that are distributed across different servers and belong to different applications, and the distributed transaction needs to guarantee that all of these small operations either succeed or fail. Essentially, distributed transactions are about ensuring data consistency across different databases.

|

||||

|

||||

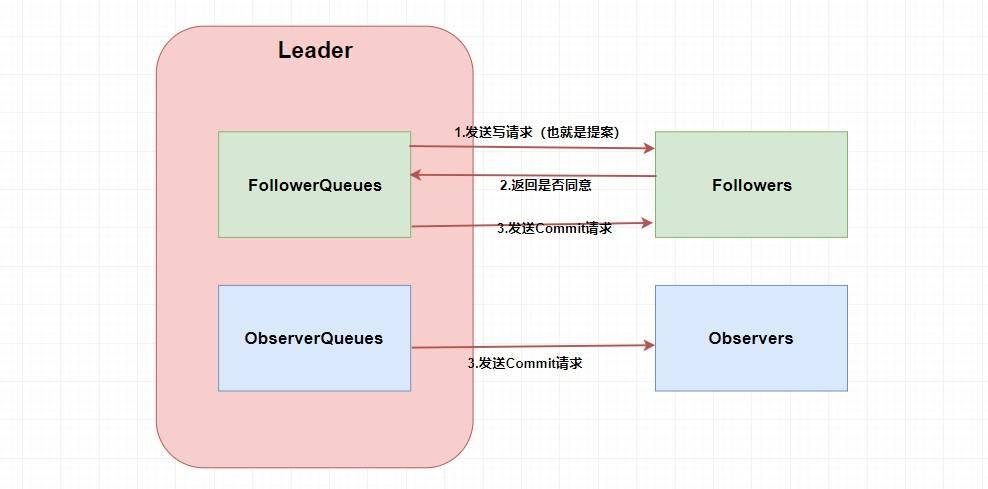

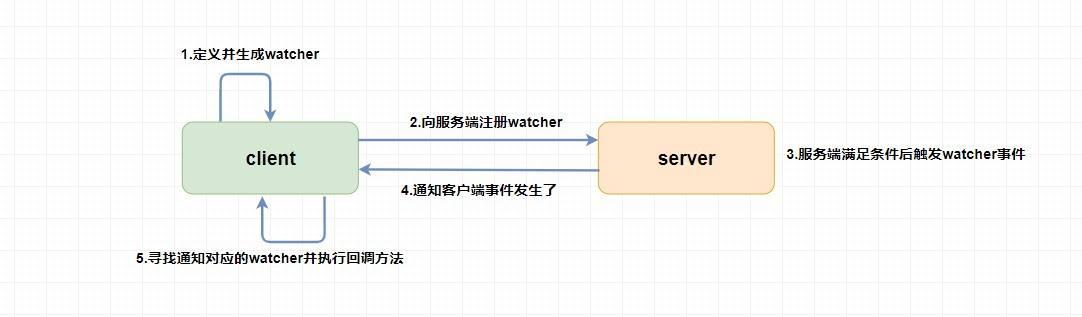

### Distributed Orchestration

|

||||

|

||||

**ZooKeeper**.

|

||||

|

||||

> The first two articles may have content overlapping parts, we recommend reading them both.

|

||||

|

||||

1. [[Getting Started] Summary of ZooKeeper-related concepts](docs/distributed-system/分布式协调/zookeeper/zookeeper-intro.md)

|

||||

2. [[Advanced] Summary of ZooKeeper Related Concepts](docs/distributed-system/分布式协调/zookeeper/zookeeper-plus.md)

|

||||

3. [[Hands-on] ZooKeeper hands-on](docs/distributed-system/分布式协调/zookeeper/zookeeper-in-action.md)

|

||||

|

||||

## High performance

|

||||

|

||||

### Message Queues

|

||||

|

||||

Message queues are used in distributed systems primarily for decoupling and peak shaving. Related reading: [Message Queues FAQ Summary](docs/high-performance/message-queue/message-queue.md)。

|

||||

|

||||

1. **RabbitMQ** : [Getting Started with RabbitMQ](docs/high-performance/message-queue/rabbitmq-intro.md)

|

||||

2. **RocketMQ** : [Getting Started with RocketMQ](docs/high-performance/message-queue/rocketmq-intro)、[A few simple questions and answers for RocketMQ](docs/high-performance/message-queue/rocketmq-questions.md)

|

||||

3. **Kafka** : [Kafka FAQ Summary](docs/high-performance/message-queue/kafka知识点&面试题总结.md)

|

||||

|

||||

### Read-write separation & split database and split table

|

||||

|

||||

Read-write separation is mainly to separate the database read and write operations on different database nodes. The master server is responsible for writes and the slave server is responsible for reads. Alternatively, one master and one slave or one master and multiple slaves can be used.

|

||||

|

||||

Read-write separation can substantially improve read performance and marginally improve write performance. Therefore, read-write separation is more suitable for scenarios where there are more concurrent read requests from a single machine.

|

||||

|

||||

Library and table separation is to solve the problem of continuous database performance degradation due to the excessive amount of library and table data.

|

||||

|

||||

Common library and table splitting tools are: `sharding-jdbc` (Dangdang), `TSharding` (Mushroom Street), `MyCAT` (based on Cobar), `Cobar` (Alibaba).... We recommend using `sharding-jdbc`. Because, `sharding-jdbc` is a lightweight `Java` framework, served as a `jar` package, no extra O&M work for us, and good compatibility.

|

||||

|

||||

Related reading: [read-write separation & sharding summary of common problems](docs/high-performance/读写分离&分库分表.md)

|

||||

|

||||

### Load Balancing

|

||||

|

||||

Load balancing systems are often used to distribute tasks such as user request processing to multiple servers to improve the performance and reliability of a website, application or database.

|

||||

|

||||

Common load balancing systems include 3 types.

|

||||

|

||||

1. **DNS load balancing**: generally used to achieve geographic level balancing.

|

||||

2. **Hardware Load Balancing**: Load balancing is achieved through a separate hardware device such as F5 (hardware is usually expensive).

|

||||

3. **Software load balancing**: Load balancing is achieved by load balancing software such as Nginx.

|

||||

|

||||

## High Availability

|

||||

|

||||

Highly available describes a system that is available most of the time and can provide services to us. High availability means that the system is available even in the event of a hardware failure or system upgrade.

|

||||

|

||||

Related reading: **"[How to design a highly available system? What are the areas to consider?](docs/high-availability/高可用系统设计.md)》** 。

|

||||

|

||||

### Flow limiting

|

||||

|

||||

Flow limiting considers how to respond to system failures from the perspective of user access pressure.

|

||||

|

||||

The purpose of flow limiting is to limit the frequency of requests received by the server-side interface to prevent the service from hanging. For example, if an interface is limited to 100 requests per second, requests that exceed the limit are either dropped or placed in a queue for processing. Limiting the flow can effectively deal with the excessive number of burst requests. Related reading: [What is flow limiting? What are the flow limiting algorithms?](docs/high-availability/limit-request.md)

|

||||

|

||||

### Downgrading

|

||||

|

||||

Downgrading is the consideration of how to respond to system failures from the perspective of system functional priorities.

|

||||

|

||||

Service degradation refers to the strategic downgrading of some services and pages based on the current business situation and traffic when the server is under pressure, in order to free up server resources to ensure the normal operation of core tasks.

|

||||

|

||||

### Meltdown

|

||||

|

||||

Meltdown and degradation are two concepts that are easily confused and do not have the same meaning.

|

||||

|

||||

Downgrades are intended to deal with failures of the system itself, while meltdowns are intended to deal with failures of external systems or third-party systems on which the current system depends.

|

||||

|

||||

### Queuing

|

||||

|

||||

An alternative type of flow limitation, analogous to real-world queuing. If you've played League of Legends, you'll know that every time there's an event, you have to go through a queue to get into the game.

|

||||

|

||||

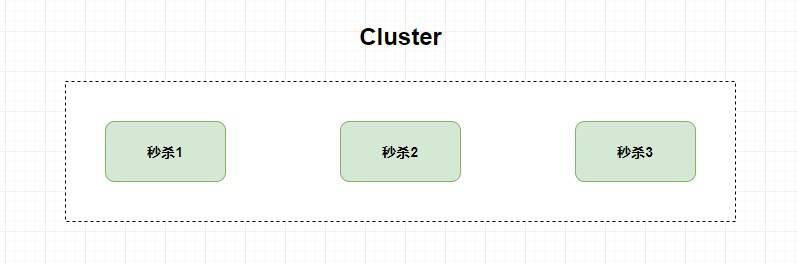

### Clustering

|

||||

|

||||

Deploy multiple copies of the same service to avoid single points of failure.

|

||||

|

||||

### Timeout and retry mechanism

|

||||

|

||||

** Once a user's request goes beyond a certain time without a response, the request is ended and an exception is thrown. ** Failure to set a timeout may result in slow response times, or even a buildup of requests that prevents the system from processing them.

|

||||

|

||||

In addition, the number of retries is generally set to 3. More retries will not be beneficial, but will add pressure to the server (some scenarios may not be suitable to use the failure retry mechanism).

|

||||

|

||||

### Disaster recovery design and offsite multi-live

|

||||

|

||||

**Disaster recovery** = disaster recovery + backup.

|

||||

|

||||

- **Backup** : Backup several copies of all important data generated by the system.

|

||||

- **Disaster Tolerant** : Create two identical systems in offsite locations. When the system in one place suddenly hangs, the whole application system can be switched to the other one so that the system can provide services normally.

|

||||

|

||||

**Offsite Multi-Live** describes the deployment of services offsite and the simultaneous provisioning of services to the outside world. The main difference from traditional disaster recovery design is "multi-live", i.e., all sites are providing services to the public at the same time. Off-site multiplication is designed to deal with unexpected situations such as fires, earthquakes, and other natural or perceived disasters.

|

||||

|

||||

Related reading.

|

||||

|

||||

- [Read this article to understand off-site multi-live](https://mp.weixin.qq.com/s/T6mMDdtTfBuIiEowCpqu6Q)

|

||||

- [Four steps to build offsite multi-live](https://mp.weixin.qq.com/s/hMD-IS__4JE5_nQhYPYSTg)

|

||||

- ["Learning Architecture from Scratch" - 28 | Guarantees for Highly Available Business: Offsite Multi-Live Architecture](http://gk.link/a/10pKZ)

|

||||

|

||||

## About the Author

|

||||

|

||||

- [Personal Introduction Q & A](https://javaguide.cn/about-the-author/)

|

||||

- [I used to be an Internet addict too](https://javaguide.cn/about-the-author/internet-addiction-teenager/)

|

||||

- [Feelings after one month of onboarding](https://javaguide.cn/about-the-author/feelings-after-one-month-of-induction-training/)

|

||||

- [Feelings from graduation to six months of employment](https://javaguide.cn/about-the-author/feelings-of-half-a-year-from-graduation-to-entry/)

|

||||

- [A training institution stole my article into a video also on the B station popular](https://javaguide.cn/about-the-author/my-article-was-stolen-and-made-into-video-and-it-became-popular/)

|

||||

|

||||

## Public

|

||||

|

||||

If you want to follow my updated articles and the dry goods I share in real time, you can follow my public number.

|

||||

|

||||

**《Java Interview Blitz》:** A PDF version of "Java Interview Blitz" derived from this document specifically for interviews [Public](#公众号) Reply back to **"Interview Blitz "** and get it for free!

|

||||

|

||||

<div align="center">

|

||||

<img src="https://oss.javaguide.cn/github/javaguide/gongzhonghaoxuanchuan.png" style="margin: 0 auto;" />

|

||||

</div>

|

||||

|

||||

|

||||

146

README.md

@ -1,46 +1,39 @@

|

||||

推荐你通过在线阅读网站进行阅读,体验更好,速度更快!

|

||||

|

||||

* **[JavaGuide 在线阅读网站(新版,推荐👍)](https://javaguide.cn/)**

|

||||

* [JavaGuide 在线阅读版(老版)](https://snailclimb.gitee.io/javaguide/#/)

|

||||

- **[JavaGuide 在线阅读网站(新版,推荐 👍)](https://javaguide.cn/)**

|

||||

- [JavaGuide 在线阅读版(老版)](https://snailclimb.gitee.io/javaguide/#/)

|

||||

|

||||

[<img src="https://oss.javaguide.cn/xingqiu/xingqiu.png" style="width:850px;margin: 0 auto" />](https://sourl.cn/e7ee87)

|

||||

|

||||

<div align="center">

|

||||

<p>

|

||||

<a href="https://javaguide.cn/about-the-author/zhishixingqiu-two-years.html">

|

||||

<img src="https://oss.javaguide.cn/xingqiu/xingqiu.png" style="margin: 0 auto; width: 850px;" />

|

||||

</a>

|

||||

</p>

|

||||

<p>

|

||||

<a href="https://github.com/Snailclimb/JavaGuide" target="_blank">

|

||||

<img src="https://oss.javaguide.cn/github/javaguide/csdn/1c00413c65d1995993bf2b0daf7b4f03.png" width="" />

|

||||

</a>

|

||||

</p>

|

||||

<p>

|

||||

<a href="https://javaguide.cn/"><img src="https://img.shields.io/badge/阅读-read-brightgreen.svg" alt="阅读" /></a>

|

||||

<img src="https://img.shields.io/github/stars/Snailclimb/JavaGuide" alt="stars" />

|

||||

<img src="https://img.shields.io/github/forks/Snailclimb/JavaGuide" alt="forks" />

|

||||

<img src="https://img.shields.io/github/issues/Snailclimb/JavaGuide" alt="issues" />

|

||||

</p>

|

||||

<p>

|

||||

<a href="https://github.com/Snailclimb/JavaGuide">Github</a> |

|

||||

<a href="https://gitee.com/SnailClimb/JavaGuide">Gitee</a>

|

||||

</p>

|

||||

</div>

|

||||

|

||||

[](https://github.com/Snailclimb/JavaGuide)

|

||||

|

||||

[](https://javaguide.cn/)

|

||||

|

||||

|

||||

|

||||

|

||||

[GitHub](https://github.com/Snailclimb/JavaGuide) | [Gitee](https://gitee.com/SnailClimb/JavaGuide)

|

||||

|

||||

</div>

|

||||

|

||||

> 1. **面试专版** :准备面试的小伙伴可以考虑面试专版:[《Java 面试指北 》](https://javaguide.cn/zhuanlan/java-mian-shi-zhi-bei.html) (质量很高,专为面试打造,配合 JavaGuide 食用)。

|

||||

> 1. **知识星球** :专属面试小册/一对一交流/简历修改/专属求职指南,欢迎加入 [JavaGuide 知识星球](https://javaguide.cn/about-the-author/zhishixingqiu-two-years.html)(点击链接即可查看星球的详细介绍,一定一定一定确定自己真的需要再加入,一定一定要看完详细介绍之后再加我)。

|

||||

> 2. **转载须知** :以下所有文章如非文首说明为转载皆为我(Guide 哥)的原创,转载在文首注明出处,如发现恶意抄袭/搬运,会动用法律武器维护自己的权益。让我们一起维护一个良好的技术创作环境!

|

||||

> 1. **转载须知** :以下所有文章如非文首说明为转载皆为我(Guide)的原创,转载在文首注明出处,如发现恶意抄袭/搬运,会动用法律武器维护自己的权益。让我们一起维护一个良好的技术创作环境!

|

||||

|

||||

<div align="center">

|

||||

<img src="https://oss.javaguide.cn/github/javaguide/gongzhonghaoxuanchuan.png" style="margin: 0 auto;" />

|

||||

<img src="https://oss.javaguide.cn/github/javaguide/gongzhonghaoxuanchuan.png" style="margin: 0 auto;" />

|

||||

</div>

|

||||

|

||||

<!-- #region home -->

|

||||

|

||||

## 项目相关

|

||||

|

||||

* [项目介绍](./docs/javaguide/intro.md)

|

||||

* [贡献指南](./docs/javaguide/contribution-guideline.md)

|

||||

* [常见问题](./docs/javaguide/faq.md)

|

||||

* [项目待办](./docs/javaguide/todo.md)

|

||||

- [项目介绍](./docs/javaguide/intro.md)

|

||||

- [贡献指南](./docs/javaguide/contribution-guideline.md)

|

||||

- [常见问题](./docs/javaguide/faq.md)

|

||||

- [项目待办](./docs/javaguide/todo.md)

|

||||

|

||||

## Java

|

||||

|

||||

@ -74,15 +67,15 @@

|

||||

|

||||

**源码分析** :

|

||||

|

||||

* [ArrayList 源码+扩容机制分析](./docs/java/collection/arraylist-source-code.md)

|

||||

* [HashMap(JDK1.8)源码+底层数据结构分析](./docs/java/collection/hashmap-source-code.md)

|

||||

* [ConcurrentHashMap 源码+底层数据结构分析](./docs/java/collection/concurrent-hash-map-source-code.md)

|

||||

- [ArrayList 源码+扩容机制分析](./docs/java/collection/arraylist-source-code.md)

|

||||

- [HashMap(JDK1.8)源码+底层数据结构分析](./docs/java/collection/hashmap-source-code.md)

|

||||

- [ConcurrentHashMap 源码+底层数据结构分析](./docs/java/collection/concurrent-hash-map-source-code.md)

|

||||

|

||||

### IO

|

||||

|

||||

* [IO 基础知识总结](./docs/java/io/io-basis.md)

|

||||

* [IO 设计模式总结](./docs/java/io/io-design-patterns.md)

|

||||

* [IO 模型详解](./docs/java/io/io-model.md)

|

||||

- [IO 基础知识总结](./docs/java/io/io-basis.md)

|

||||

- [IO 设计模式总结](./docs/java/io/io-design-patterns.md)

|

||||

- [IO 模型详解](./docs/java/io/io-model.md)

|

||||

|

||||

### 并发

|

||||

|

||||

@ -100,11 +93,11 @@

|

||||

- [Java 并发容器总结](./docs/java/concurrent/java-concurrent-collections.md)

|

||||

- [Atomic 原子类总结](./docs/java/concurrent/atomic-classes.md)

|

||||

- [AQS 详解](./docs/java/concurrent/aqs.md)

|

||||

- [CompletableFuture详解](./docs/java/concurrent/completablefuture-intro.md)

|

||||

- [CompletableFuture 详解](./docs/java/concurrent/completablefuture-intro.md)

|

||||

|

||||

### JVM (必看 :+1:)

|

||||

|

||||

JVM 这部分内容主要参考 [JVM 虚拟机规范-Java8 ](https://docs.oracle.com/javase/specs/jvms/se8/html/index.html) 和周志明老师的[《深入理解Java虚拟机(第3版)》](https://book.douban.com/subject/34907497/) (强烈建议阅读多遍!)。

|

||||

JVM 这部分内容主要参考 [JVM 虚拟机规范-Java8 ](https://docs.oracle.com/javase/specs/jvms/se8/html/index.html) 和周志明老师的[《深入理解 Java 虚拟机(第 3 版)》](https://book.douban.com/subject/34907497/) (强烈建议阅读多遍!)。

|

||||

|

||||

- **[Java 内存区域](./docs/java/jvm/memory-area.md)**

|

||||

- **[JVM 垃圾回收](./docs/java/jvm/jvm-garbage-collection.md)**

|

||||

@ -117,7 +110,7 @@ JVM 这部分内容主要参考 [JVM 虚拟机规范-Java8 ](https://docs.oracle

|

||||

|

||||

### 新特性

|

||||

|

||||

- **Java 8** :[Java 8 新特性总结(翻译)](./docs/java/new-features/java8-tutorial-translate.md)、[Java8常用新特性总结](./docs/java/new-features/java8-common-new-features.md)

|

||||

- **Java 8** :[Java 8 新特性总结(翻译)](./docs/java/new-features/java8-tutorial-translate.md)、[Java8 常用新特性总结](./docs/java/new-features/java8-common-new-features.md)

|

||||

- [Java 9 新特性概览](./docs/java/new-features/java9.md)

|

||||

- [Java 10 新特性概览](./docs/java/new-features/java10.md)

|

||||

- [Java 11 新特性概览](./docs/java/new-features/java11.md)

|

||||

@ -148,10 +141,10 @@ JVM 这部分内容主要参考 [JVM 虚拟机规范-Java8 ](https://docs.oracle

|

||||

|

||||

**重要知识点详解** :

|

||||

|

||||

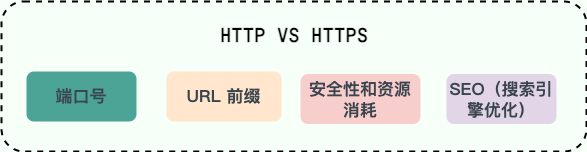

- [OSI 和 TCP/IP 网络分层模型详解(基础)](./docs/cs-basics/network/osi&tcp-ip-model.md)

|

||||

- [OSI 和 TCP/IP 网络分层模型详解(基础)](./docs/cs-basics/network/osi-and-tcp-ip-model.md)

|

||||

- [应用层常见协议总结(应用层)](./docs/cs-basics/network/application-layer-protocol.md)

|

||||

- [HTTP vs HTTPS(应用层)](./docs/cs-basics/network/http&https.md)

|

||||

- [HTTP 1.0 vs HTTP 1.1(应用层)](./docs/cs-basics/network/http1.0&http1.1.md)

|

||||

- [HTTP vs HTTPS(应用层)](./docs/cs-basics/network/http-vs-https.md)

|

||||

- [HTTP 1.0 vs HTTP 1.1(应用层)](./docs/cs-basics/network/http1.0-vs-http1.1.md)

|

||||

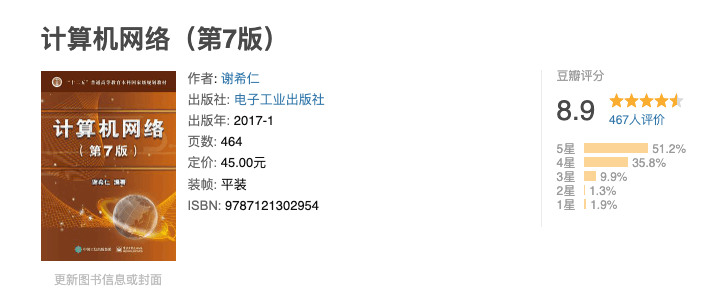

- [HTTP 常见状态码(应用层)](./docs/cs-basics/network/http-status-codes.md)

|

||||

- [DNS 域名系统详解(应用层)](./docs/cs-basics/network/dns.md)

|

||||

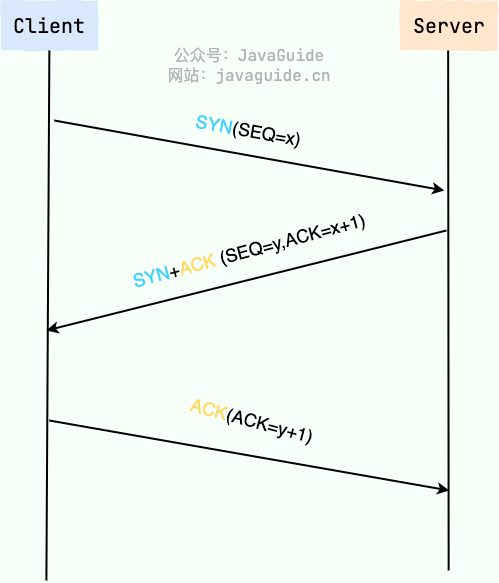

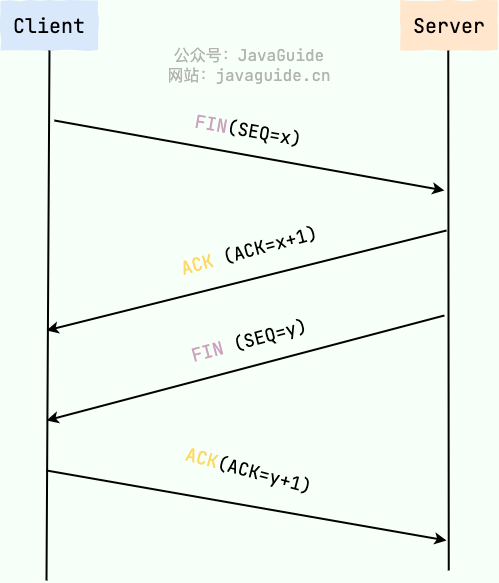

- [TCP 三次握手和四次挥手(传输层)](./docs/cs-basics/network/tcp-connection-and-disconnection.md)

|

||||

@ -166,7 +159,7 @@ JVM 这部分内容主要参考 [JVM 虚拟机规范-Java8 ](https://docs.oracle

|

||||

- [线性数据结构 :数组、链表、栈、队列](./docs/cs-basics/data-structure/linear-data-structure.md)

|

||||

- [图](./docs/cs-basics/data-structure/graph.md)

|

||||

- [堆](./docs/cs-basics/data-structure/heap.md)

|

||||

- [树](./docs/cs-basics/data-structure/tree.md) :重点关注[红黑树](./docs/cs-basics/data-structure/red-black-tree.md)、B-,B+,B*树、LSM树

|

||||

- [树](./docs/cs-basics/data-structure/tree.md) :重点关注[红黑树](./docs/cs-basics/data-structure/red-black-tree.md)、B-,B+,B\*树、LSM 树

|

||||

|

||||

其他常用数据结构 :

|

||||

|

||||

@ -176,17 +169,17 @@ JVM 这部分内容主要参考 [JVM 虚拟机规范-Java8 ](https://docs.oracle

|

||||

|

||||

算法这部分内容非常重要,如果你不知道如何学习算法的话,可以看下我写的:

|

||||

|

||||

* [算法学习书籍+资源推荐](https://www.zhihu.com/question/323359308/answer/1545320858) 。

|

||||

* [如何刷Leetcode?](https://www.zhihu.com/question/31092580/answer/1534887374)

|

||||

- [算法学习书籍+资源推荐](https://www.zhihu.com/question/323359308/answer/1545320858) 。

|

||||

- [如何刷 Leetcode?](https://www.zhihu.com/question/31092580/answer/1534887374)

|

||||

|

||||

**常见算法问题总结** :

|

||||

|

||||

* [几道常见的字符串算法题总结 ](./docs/cs-basics/algorithms/string-algorithm-problems.md)

|

||||

* [几道常见的链表算法题总结 ](./docs/cs-basics/algorithms/linkedlist-algorithm-problems.md)

|

||||

* [剑指 offer 部分编程题](./docs/cs-basics/algorithms/the-sword-refers-to-offer.md)

|

||||

* [十大经典排序算法](./docs/cs-basics/algorithms/10-classical-sorting-algorithms.md)

|

||||

- [几道常见的字符串算法题总结 ](./docs/cs-basics/algorithms/string-algorithm-problems.md)

|

||||

- [几道常见的链表算法题总结 ](./docs/cs-basics/algorithms/linkedlist-algorithm-problems.md)

|

||||

- [剑指 offer 部分编程题](./docs/cs-basics/algorithms/the-sword-refers-to-offer.md)

|

||||

- [十大经典排序算法](./docs/cs-basics/algorithms/10-classical-sorting-algorithms.md)

|

||||

|

||||

另外,[GeeksforGeeks]( https://www.geeksforgeeks.org/fundamentals-of-algorithms/) 这个网站总结了常见的算法 ,比较全面系统。

|

||||

另外,[GeeksforGeeks](https://www.geeksforgeeks.org/fundamentals-of-algorithms/) 这个网站总结了常见的算法 ,比较全面系统。

|

||||

|

||||

## 数据库

|

||||

|

||||

@ -196,9 +189,8 @@ JVM 这部分内容主要参考 [JVM 虚拟机规范-Java8 ](https://docs.oracle

|

||||

- [NoSQL 基础知识总结](./docs/database/nosql.md)

|

||||

- [字符集详解](./docs/database/character-set.md)

|

||||

- SQL :

|

||||

- [SQL语法基础知识总结](./docs/database/sql/sql-syntax-summary.md)

|

||||

- [SQL常见面试题总结](./docs/database/sql/sql-questions-01.md)

|

||||

|

||||

- [SQL 语法基础知识总结](./docs/database/sql/sql-syntax-summary.md)

|

||||

- [SQL 常见面试题总结](./docs/database/sql/sql-questions-01.md)

|

||||

|

||||

### MySQL

|

||||

|

||||

@ -209,14 +201,14 @@ JVM 这部分内容主要参考 [JVM 虚拟机规范-Java8 ](https://docs.oracle

|

||||

|

||||

**重要知识点:**

|

||||

|

||||

- [MySQL索引详解](./docs/database/mysql/mysql-index.md)

|

||||

- [MySQL事务隔离级别图文详解)](./docs/database/mysql/transaction-isolation-level.md)

|

||||

- [MySQL三大日志(binlog、redo log和undo log)详解](./docs/database/mysql/mysql-logs.md)

|

||||

- [MySQL 索引详解](./docs/database/mysql/mysql-index.md)

|

||||

- [MySQL 事务隔离级别图文详解)](./docs/database/mysql/transaction-isolation-level.md)

|

||||

- [MySQL 三大日志(binlog、redo log 和 undo log)详解](./docs/database/mysql/mysql-logs.md)

|

||||

- [InnoDB 存储引擎对 MVCC 的实现](./docs/database/mysql/innodb-implementation-of-mvcc.md)

|

||||

- [SQL 语句在 MySQL 中的执行过程](./docs/database/mysql/how-sql-executed-in-mysql.md)

|

||||

- [MySQL 查询缓存详解](./docs/database/mysql/mysql-query-cache.md)

|

||||

- [MySQL执行计划分析](./docs/database/mysql/mysql-query-execution-plan.md)

|

||||

- [MySQL自增主键一定是连续的吗](./docs/database/mysql/mysql-auto-increment-primary-key-continuous.md)

|

||||

- [MySQL 执行计划分析](./docs/database/mysql/mysql-query-execution-plan.md)

|

||||

- [MySQL 自增主键一定是连续的吗](./docs/database/mysql/mysql-auto-increment-primary-key-continuous.md)

|

||||

- [MySQL 时间类型数据存储建议](./docs/database/mysql/some-thoughts-on-database-storage-time.md)

|

||||

- [MySQL 隐式转换造成索引失效](./docs/database/mysql/index-invalidation-caused-by-implicit-conversion.md)

|

||||

|

||||

@ -229,7 +221,7 @@ JVM 这部分内容主要参考 [JVM 虚拟机规范-Java8 ](https://docs.oracle

|

||||

|

||||

**重要知识点:**

|

||||

|

||||

- [3种常用的缓存读写策略详解](./docs/database/redis/3-commonly-used-cache-read-and-write-strategies.md)

|

||||

- [3 种常用的缓存读写策略详解](./docs/database/redis/3-commonly-used-cache-read-and-write-strategies.md)

|

||||

- [Redis 5 种基本数据结构详解](./docs/database/redis/redis-data-structures-01.md)

|

||||

- [Redis 3 种特殊数据结构详解](./docs/database/redis/redis-data-structures-02.md)

|

||||

- [Redis 持久化机制详解](./docs/database/redis/redis-persistence.md)

|

||||

@ -244,7 +236,7 @@ JVM 这部分内容主要参考 [JVM 虚拟机规范-Java8 ](https://docs.oracle

|

||||

|

||||

## 搜索引擎

|

||||

|

||||

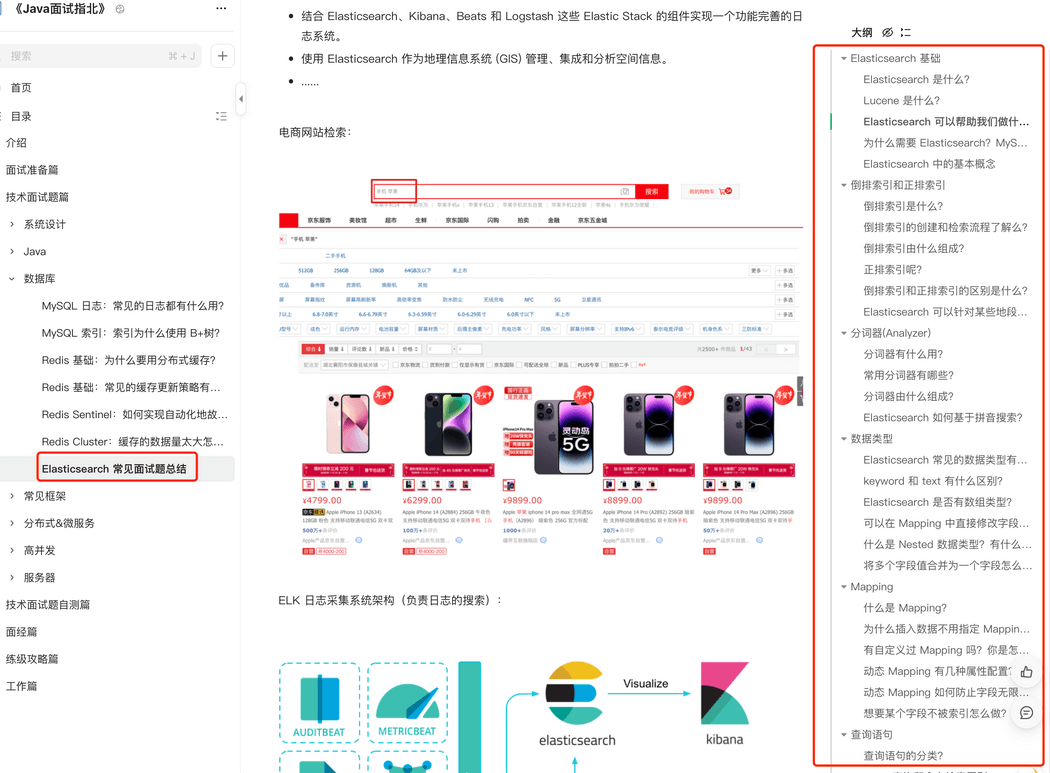

[Elasticsearch常见面试题总结(付费)](./docs/database/elasticsearch/elasticsearch-questions-01.md)

|

||||

[Elasticsearch 常见面试题总结(付费)](./docs/database/elasticsearch/elasticsearch-questions-01.md)

|

||||

|

||||

|

||||

|

||||

@ -260,13 +252,13 @@ JVM 这部分内容主要参考 [JVM 虚拟机规范-Java8 ](https://docs.oracle

|

||||

|

||||

### Docker

|

||||

|

||||

* [Docker 核心概念总结](./docs/tools/docker/docker-intro.md)

|

||||

* [Docker 实战](./docs/tools/docker/docker-in-action.md)

|

||||

- [Docker 核心概念总结](./docs/tools/docker/docker-intro.md)

|

||||

- [Docker 实战](./docs/tools/docker/docker-in-action.md)

|

||||

|

||||

### Git

|

||||

|

||||

* [Git 核心概念总结](./docs/tools/git/git-intro.md)

|

||||

* [Github 实用小技巧总结](./docs/tools/git/github-tips.md)

|

||||

- [Git 核心概念总结](./docs/tools/git/git-intro.md)

|

||||

- [Github 实用小技巧总结](./docs/tools/git/github-tips.md)

|

||||

|

||||

## 系统设计

|

||||

|

||||

@ -308,14 +300,13 @@ JVM 这部分内容主要参考 [JVM 虚拟机规范-Java8 ](https://docs.oracle

|

||||

|

||||

- [认证授权基础概念详解](./docs/system-design/security/basis-of-authority-certification.md)

|

||||

- [JWT 基础概念详解](./docs/system-design/security/jwt-intro.md)

|

||||

- [JWT 优缺点分析以及常见问题解决方案](./docs/system-design/security/advantages&disadvantages-of-jwt.md)

|

||||

- [JWT 优缺点分析以及常见问题解决方案](./docs/system-design/security/advantages-and-disadvantages-of-jwt.md)

|

||||

- [SSO 单点登录详解](./docs/system-design/security/sso-intro.md)

|

||||

- [权限系统设计详解](./docs/system-design/security/design-of-authority-system.md)

|

||||

|

||||

|

||||

#### 数据脱敏

|

||||

|

||||

数据脱敏说的就是我们根据特定的规则对敏感信息数据进行变形,比如我们把手机号、身份证号某些位数使用 * 来代替。

|

||||

数据脱敏说的就是我们根据特定的规则对敏感信息数据进行变形,比如我们把手机号、身份证号某些位数使用 \* 来代替。

|

||||

|

||||

#### 敏感词过滤

|

||||

|

||||

@ -333,10 +324,10 @@ JVM 这部分内容主要参考 [JVM 虚拟机规范-Java8 ](https://docs.oracle

|

||||

|

||||

### 理论&算法&协议

|

||||

|

||||

- [CAP 理论和 BASE 理论详解](./docs/distributed-system/theorem&algorithm&protocol/cap&base-theorem.md)

|

||||

- [Paxos 算法详解](./docs/distributed-system/theorem&algorithm&protocol/paxos-algorithm.md)

|

||||

- [Raft 算法详解](./docs/distributed-system/theorem&algorithm&protocol/raft-algorithm.md)

|

||||

- [Gossip 协议详解](./docs/distributed-system/theorem&algorithm&protocol/gossip-protocl.md)

|

||||

- [CAP 理论和 BASE 理论详解](./docs/distributed-system/protocol/cap-and-base-theorem.md)

|

||||

- [Paxos 算法详解](./docs/distributed-system/protocol/paxos-algorithm.md)

|

||||

- [Raft 算法详解](./docs/distributed-system/protocol/raft-algorithm.md)

|

||||

- [Gossip 协议详解](./docs/distributed-system/protocol/gossip-protocl.md)

|

||||

|

||||

### API 网关

|

||||

|

||||

@ -360,8 +351,8 @@ JVM 这部分内容主要参考 [JVM 虚拟机规范-Java8 ](https://docs.oracle

|

||||

|

||||

### RPC

|

||||

|

||||

* [RPC 基础常见知识点&面试题总结](./docs/distributed-system/rpc/rpc-intro.md)

|

||||

* [Dubbo 常见知识点&面试题总结](./docs/distributed-system/rpc/dubbo.md)

|

||||

- [RPC 基础常见知识点&面试题总结](./docs/distributed-system/rpc/rpc-intro.md)

|

||||

- [Dubbo 常见知识点&面试题总结](./docs/distributed-system/rpc/dubbo.md)

|

||||

|

||||

### ZooKeeper

|

||||

|

||||

@ -411,7 +402,7 @@ JVM 这部分内容主要参考 [JVM 虚拟机规范-Java8 ](https://docs.oracle

|

||||

|

||||

### 降级&熔断

|

||||

|

||||

[降级&熔断详解](./docs/high-availability/fallback&circuit-breaker.md)

|

||||

[降级&熔断详解](./docs/high-availability/fallback-and-circuit-breaker.md)

|

||||

|

||||

### 超时&重试

|

||||

|

||||

@ -423,16 +414,16 @@ JVM 这部分内容主要参考 [JVM 虚拟机规范-Java8 ](https://docs.oracle

|

||||

|

||||

### 灾备设计和异地多活

|

||||

|

||||

**灾备** = 容灾+备份。

|

||||

**灾备** = 容灾+备份。

|

||||

|

||||

* **备份** : 将系统所产生的的所有重要数据多备份几份。

|

||||

* **容灾** : 在异地建立两个完全相同的系统。当某个地方的系统突然挂掉,整个应用系统可以切换到另一个,这样系统就可以正常提供服务了。

|

||||

- **备份** : 将系统所产生的的所有重要数据多备份几份。

|

||||

- **容灾** : 在异地建立两个完全相同的系统。当某个地方的系统突然挂掉,整个应用系统可以切换到另一个,这样系统就可以正常提供服务了。

|

||||

|

||||

**异地多活** 描述的是将服务部署在异地并且服务同时对外提供服务。和传统的灾备设计的最主要区别在于“多活”,即所有站点都是同时在对外提供服务的。异地多活是为了应对突发状况比如火灾、地震等自然或者人为灾害。

|

||||

|

||||

## Star 趋势

|

||||

|

||||

|

||||

|

||||

|

||||

## 公众号

|

||||

|

||||

@ -440,3 +431,4 @@ JVM 这部分内容主要参考 [JVM 虚拟机规范-Java8 ](https://docs.oracle

|

||||

|

||||

|

||||

|

||||

<!-- #endregion home -->

|

||||

|

||||

@ -1,14 +1,15 @@

|

||||

import { defineUserConfig } from "vuepress";

|

||||

import { themeConfig } from "./themeConfig";

|

||||

import { searchPlugin } from "@vuepress/plugin-search";

|

||||

import { searchProPlugin } from "vuepress-plugin-search-pro";

|

||||

|

||||

import theme from "./theme.js";

|

||||

|

||||

export default defineUserConfig({

|

||||

dest: "./dist",

|

||||

theme: themeConfig,

|

||||

shouldPrefetch: false,

|

||||

|

||||

title: "JavaGuide(Java面试+学习指南)",

|

||||

description:

|

||||

"「Java学习指北+Java面试指南」一份涵盖大部分 Java 程序员所需要掌握的核心知识。准备 Java 面试,复习 Java 知识点,首选 JavaGuide! ",

|

||||

|

||||

head: [

|

||||

// meta

|

||||

["meta", { name: "robots", content: "all" }],

|

||||

@ -43,28 +44,20 @@ export default defineUserConfig({

|

||||

s.parentNode.insertBefore(hm, s);

|

||||

})();`,

|

||||

],

|

||||

["link", { rel: "stylesheet", href: "/iconfont/iconfont.css" }],

|

||||

["link", { rel: "icon", href: "/favicon.ico" }],

|

||||

],

|

||||

|

||||

locales: {

|

||||

"/": {

|

||||

lang: "zh-CN",

|

||||

},

|

||||

},

|

||||

plugins: [

|

||||

searchPlugin({

|

||||

// https://v2.vuepress.vuejs.org/zh/reference/plugin/search.html

|

||||

// 排除首页

|

||||

isSearchable: (page) => page.path !== "/",

|

||||

maxSuggestions: 10,

|

||||

hotKeys: ["s", "/"],

|

||||

// 用于在页面的搜索索引中添加额外字段

|

||||

getExtraFields: () => [],

|

||||

locales: {

|

||||

"/": {

|

||||

placeholder: "搜索",

|

||||

},

|

||||

},

|

||||

}),

|

||||

],

|

||||

|

||||

theme,

|

||||

|

||||

plugins: [searchProPlugin({ indexContent: true })],

|

||||

|

||||

pagePatterns: ["**/*.md", "!*.snippet.md", "!.vuepress", "!node_modules"],

|

||||

|

||||

shouldPrefetch: false,

|

||||

});

|

||||

|

||||

@ -1,10 +1,19 @@

|

||||

import { navbar } from "vuepress-theme-hope";

|

||||

|

||||

export const navbarConfig = navbar([

|

||||

export default navbar([

|

||||

{ text: "面试指南", icon: "java", link: "/home.md" },

|

||||

{

|

||||

text: "知识星球",

|

||||

icon: "code",

|

||||

link: "/about-the-author/zhishixingqiu-two-years.md",

|

||||

},

|

||||

{ text: "开源项目", icon: "github", link: "/open-source-project/" },

|

||||

{ text: "技术书籍", icon: "book", link: "/books/" },

|

||||

{ text: "程序人生", icon: "article", link: "/high-quality-technical-articles/" },

|

||||

{

|

||||

text: "程序人生",

|

||||

icon: "article",

|

||||

link: "/high-quality-technical-articles/",

|

||||

},

|

||||

{

|

||||

text: "网站相关",

|

||||

icon: "about",

|

||||

|

||||

@ -1,223 +0,0 @@

|

||||

@font-face {

|

||||

font-family: "iconfont"; /* Project id 2922463 */

|

||||

src: url('iconfont.woff2?t=1660530571134') format('woff2'),

|

||||

url('iconfont.woff?t=1660530571134') format('woff'),

|

||||

url('iconfont.ttf?t=1660530571134') format('truetype');

|

||||

}

|

||||

|

||||

.iconfont {

|

||||

font-family: "iconfont" !important;

|

||||

font-size: 16px;

|

||||

font-style: normal;

|

||||

-webkit-font-smoothing: antialiased;

|

||||

-moz-osx-font-smoothing: grayscale;

|

||||

}

|

||||

|

||||

.icon-history:before {

|

||||

content: "\e752";

|

||||

}

|

||||

|

||||

.icon-experience:before {

|

||||

content: "\e72b";

|

||||

}

|

||||

|

||||

.icon-code:before {

|

||||

content: "\e7fc";

|

||||

}

|

||||

|

||||

.icon-interview:before {

|

||||

content: "\e65d";

|

||||

}

|

||||

|

||||

.icon-about:before {

|

||||

content: "\e6e5";

|

||||

}

|

||||

|

||||

.icon-search:before {

|

||||

content: "\e7de";

|

||||

}

|

||||

|

||||

.icon-featured:before {

|

||||

content: "\e633";

|

||||

}

|

||||

|

||||

.icon-codelibrary-fill:before {

|

||||

content: "\e84b";

|

||||

}

|

||||

|

||||

.icon-tool:before {

|

||||

content: "\e70c";

|

||||

}

|

||||

|

||||

.icon-highavailable:before {

|

||||

content: "\ea23";

|

||||

}

|

||||

|

||||

.icon-big-data:before {

|

||||

content: "\e632";

|

||||

}

|

||||

|

||||

.icon-work:before {

|

||||

content: "\e8d7";

|

||||

}

|

||||

|

||||

.icon-project:before {

|

||||

content: "\e702";

|

||||

}

|

||||

|

||||

.icon-article:before {

|

||||

content: "\e672";

|

||||

}

|

||||

|

||||

.icon-a-MachineLearning:before {

|

||||

content: "\e617";

|

||||

}

|

||||

|

||||

.icon-github:before {

|

||||

content: "\e673";

|

||||

}

|

||||

|

||||

.icon-rss:before {

|

||||

content: "\e768";

|

||||

}

|

||||

|

||||

.icon-mianshi:before {

|

||||

content: "\e614";

|

||||

}

|

||||

|

||||

.icon-et-performance:before {

|

||||

content: "\e623";

|

||||

}

|

||||

|

||||

.icon-virtual_machine:before {

|

||||

content: "\e73f";

|

||||

}

|

||||

|

||||

.icon-basic:before {

|

||||

content: "\e67b";

|

||||

}

|

||||

|

||||

.icon-container:before {

|

||||

content: "\e641";

|

||||

}

|

||||

|

||||

.icon-MQ:before {

|

||||

content: "\e684";

|

||||

}

|

||||

|

||||

.icon-redis:before {

|

||||

content: "\e619";

|

||||

}

|

||||

|

||||

.icon-mysql:before {

|

||||

content: "\e613";

|

||||

}

|

||||

|

||||

.icon-recommend:before {

|

||||

content: "\e639";

|

||||

}

|

||||

|

||||

.icon-chat:before {

|

||||

content: "\e66a";

|

||||

}

|

||||

|

||||

.icon-tips:before {

|

||||

content: "\e62a";

|

||||

}

|

||||

|

||||

.icon-chajian1:before {

|

||||

content: "\e69d";

|

||||

}

|

||||

|

||||

.icon-star:before {

|

||||

content: "\e61d";

|

||||

}

|

||||

|

||||

.icon-docker1:before {

|

||||

content: "\e659";

|

||||

}

|

||||

|

||||

.icon-zuozhe:before {

|

||||

content: "\e688";

|

||||

}

|

||||

|

||||

.icon-pdf:before {

|

||||

content: "\e740";

|

||||

}

|

||||

|

||||

.icon-suanfaku:before {

|

||||

content: "\e63a";

|

||||

}

|

||||

|

||||

.icon-jichushuju:before {

|

||||

content: "\e60c";

|

||||

}

|

||||

|

||||

.icon-people-network-full:before {

|

||||

content: "\e865";

|

||||

}

|

||||

|

||||

.icon-git:before {

|

||||

content: "\e708";

|

||||

}

|

||||

|

||||

.icon-luxianchaxun:before {

|

||||

content: "\e622";

|

||||

}

|

||||

|

||||

.icon-computer:before {

|

||||

content: "\e601";

|

||||

}

|

||||

|

||||

.icon-framework:before {

|

||||

content: "\e69e";

|

||||

}

|

||||

|

||||

.icon-Tools:before {

|

||||

content: "\ed5f";

|

||||

}

|

||||

|

||||

.icon-xitongsheji:before {

|

||||

content: "\e63e";

|

||||

}

|

||||

|

||||

.icon-database:before {

|

||||

content: "\e8e4";

|

||||

}

|

||||

|

||||

.icon-security-fill:before {

|

||||

content: "\e78b";

|

||||

}

|

||||

|

||||

.icon-docker:before {

|

||||

content: "\e616";

|

||||

}

|

||||

|

||||

.icon-java:before {

|

||||

content: "\e6e0";

|

||||

}

|

||||

|

||||

.icon-book:before {

|

||||

content: "\e7c7";

|

||||

}

|

||||

|

||||

.icon-network:before {

|

||||

content: "\e67a";

|

||||

}

|

||||

|

||||

.icon-caozuoxitong:before {

|

||||

content: "\e686";

|

||||

}

|

||||

|

||||

.icon-gaojixiaozuzhibeifen:before {

|

||||

content: "\e756";

|

||||

}

|

||||

|

||||

.icon-distributed-network:before {

|

||||

content: "\e8d5";

|

||||

}

|

||||

|

||||

.icon-intellijidea:before {

|

||||

content: "\ebd1";

|

||||

}

|

||||

|

||||

@ -1,8 +1,10 @@

|

||||

export const aboutTheAuthor = [

|

||||

import { arraySidebar } from "vuepress-theme-hope";

|

||||

|

||||

export const aboutTheAuthor = arraySidebar([

|

||||

{

|

||||

text: "个人经历",

|

||||

icon: "zuozhe",

|

||||

collapsable: false,

|

||||

collapsible: false,

|

||||

children: [

|

||||

"internet-addiction-teenager",

|

||||

"my-college-life",

|

||||

@ -14,7 +16,7 @@ export const aboutTheAuthor = [

|

||||

{

|

||||

text: "杂谈",

|

||||

icon: "chat",

|

||||

collapsable: false,

|

||||

collapsible: false,

|

||||

children: [

|

||||

"writing-technology-blog-six-years",

|

||||

"my-article-was-stolen-and-made-into-video-and-it-became-popular",

|

||||

@ -22,4 +24,4 @@ export const aboutTheAuthor = [

|

||||

"zhishixingqiu-two-years",

|

||||

],

|

||||

},

|

||||

];

|

||||

]);

|

||||

|

||||

@ -1,4 +1,6 @@

|

||||

export const books = [

|

||||

import { arraySidebar } from "vuepress-theme-hope";

|

||||

|

||||

export const books = arraySidebar([

|

||||

{

|

||||

text: "计算机基础",

|

||||

link: "cs-basics",

|

||||

@ -30,4 +32,4 @@ export const books = [

|

||||

link: "distributed-system",

|

||||

icon: "distributed-network",

|

||||

},

|

||||

];

|

||||

]);

|

||||

|

||||

@ -1,9 +1,11 @@

|

||||

export const highQualityTechnicalArticles = [

|

||||

import { arraySidebar } from "vuepress-theme-hope";

|

||||

|

||||

export const highQualityTechnicalArticles = arraySidebar([

|

||||

{

|

||||

text: "练级攻略",

|

||||

icon: "et-performance",

|

||||

prefix: "advanced-programmer/",

|

||||

collapsable: false,

|

||||

collapsible: false,

|

||||

children: [

|

||||

"the-growth-strategy-of-the-technological-giant",

|

||||

"seven-tips-for-becoming-an-advanced-programmer",

|

||||

@ -14,10 +16,10 @@ export const highQualityTechnicalArticles = [

|

||||

text: "个人经历",

|

||||

icon: "experience",

|

||||

prefix: "personal-experience/",

|

||||

collapsable: false,

|

||||

collapsible: false,

|

||||

children: [

|

||||

"four-year-work-in-tencent-summary",

|

||||

"two-years-of-back-end-develop--experience-in-didi&toutiao",

|

||||

"two-years-of-back-end-develop--experience-in-didi-and-toutiao",

|

||||

"8-years-programmer-work-summary",

|

||||

"huawei-od-275-days",

|

||||

],

|

||||

@ -26,7 +28,7 @@ export const highQualityTechnicalArticles = [

|

||||

text: "程序员",

|

||||

icon: "code",

|

||||

prefix: "programmer/",

|

||||

collapsable: false,

|

||||

collapsible: false,

|

||||

children: [

|

||||

"how-do-programmers-publish-a-technical-book",

|

||||

"efficient-book-publishing-and-practice-guide",

|

||||

@ -36,7 +38,7 @@ export const highQualityTechnicalArticles = [

|

||||

text: "面试",

|

||||

icon: "interview",

|

||||

prefix: "interview/",

|

||||

collapsable: false,

|

||||

collapsible: false,

|

||||

children: [

|

||||

"the-experience-of-get-offer-from-over-20-big-companies",

|

||||

"the-experience-and-thinking-of-an-interview-experienced-by-an-older-programmer",

|

||||

@ -52,10 +54,10 @@ export const highQualityTechnicalArticles = [

|

||||

text: "工作",

|

||||

icon: "work",

|

||||

prefix: "work/",

|

||||

collapsable: false,

|

||||

collapsible: false,

|

||||

children: [

|

||||

"get-into-work-mode-quickly-when-you-join-a-company",

|

||||

"employee-performance",

|

||||

],

|

||||

},

|

||||

];

|

||||

]);

|

||||

|

||||

@ -1,10 +1,11 @@

|

||||

import { sidebar } from "vuepress-theme-hope";

|

||||

import { highQualityTechnicalArticles } from "./sidebar/high-quality-technical-articles";

|

||||

import { aboutTheAuthor } from "./sidebar/about-the-author";

|

||||

import { books } from "./sidebar/books";

|

||||

import { openSourceProject } from "./sidebar/open-source-project";

|

||||

|

||||

export const sidebarConfig = sidebar({

|

||||

import { aboutTheAuthor } from "./about-the-author.js";

|

||||

import { books } from "./books.js";

|

||||

import { highQualityTechnicalArticles } from "./high-quality-technical-articles.js";

|

||||

import { openSourceProject } from "./open-source-project.js";

|

||||

|

||||

export default sidebar({

|

||||

// 应该把更精确的路径放置在前边

|

||||

"/open-source-project/": openSourceProject,

|

||||

"/books/": books,

|

||||

@ -25,6 +26,7 @@ export const sidebarConfig = sidebar({

|

||||

prefix: "interview-preparation/",

|

||||

children: [

|

||||

"teach-you-how-to-prepare-for-the-interview-hand-in-hand",

|

||||

"resume-guide",

|

||||

"key-points-of-interview",

|

||||

"project-experience-guide",

|

||||

"interview-experience",

|

||||

@ -173,10 +175,10 @@ export const sidebarConfig = sidebar({

|

||||

icon: "star",

|

||||

collapsible: true,

|

||||

children: [

|

||||

"osi&tcp-ip-model",

|

||||

"osi-and-tcp-ip-model",

|

||||

"application-layer-protocol",

|

||||

"http&https",

|

||||

"http1.0&http1.1",

|

||||

"http-vs-https",

|

||||

"http1.0-vs-http1.1",

|

||||

"http-status-codes",

|

||||

"dns",

|

||||

"tcp-connection-and-disconnection",

|

||||

@ -198,10 +200,7 @@ export const sidebarConfig = sidebar({

|

||||

text: "Linux",

|

||||

collapsible: true,

|

||||

icon: "linux",

|

||||

children: [

|

||||

"linux-intro",

|

||||

"shell-intro",

|

||||

],

|

||||

children: ["linux-intro", "shell-intro"],

|

||||

},

|

||||

],

|

||||

},

|

||||

@ -420,7 +419,7 @@ export const sidebarConfig = sidebar({

|

||||

children: [

|

||||

"basis-of-authority-certification",

|

||||

"jwt-intro",

|

||||

"advantages&disadvantages-of-jwt",

|

||||

"advantages-and-disadvantages-of-jwt",

|

||||

"sso-intro",

|

||||

"design-of-authority-system",

|

||||

"sentive-words-filter",

|

||||

@ -442,9 +441,9 @@ export const sidebarConfig = sidebar({

|

||||

{

|

||||

text: "理论&算法&协议",

|

||||

icon: "suanfaku",

|

||||

prefix: "theorem&algorithm&protocol/",

|

||||

prefix: "protocol/",

|

||||

children: [

|

||||

"cap&base-theorem",