mirror of

https://github.com/Snailclimb/JavaGuide

synced 2025-07-28 12:22:17 +08:00

docs: add linter

This commit is contained in:

parent

893c673f1c

commit

6bdc809e2f

19

.markdownlint.json

Normal file

19

.markdownlint.json

Normal file

@ -0,0 +1,19 @@

|

||||

{

|

||||

"default": true,

|

||||

"MD003": {

|

||||

"style": "atx"

|

||||

},

|

||||

"MD004": {

|

||||

"style": "dash"

|

||||

},

|

||||

"MD013": false,

|

||||

"MD024": {

|

||||

"allow_different_nesting": true

|

||||

},

|

||||

"MD035": {

|

||||

"style": "---"

|

||||

},

|

||||

"MD040": false,

|

||||

"MD046": false,

|

||||

"MD049": false

|

||||

}

|

||||

4

.markdownlintignore

Normal file

4

.markdownlintignore

Normal file

@ -0,0 +1,4 @@

|

||||

**/node_modules/**

|

||||

|

||||

# markdown snippets

|

||||

*.snippet.md

|

||||

15

.prettierignore

Normal file

15

.prettierignore

Normal file

@ -0,0 +1,15 @@

|

||||

# Vuepress Cache

|

||||

**/.vuepress/.cache/**

|

||||

# Vuepress Temp

|

||||

**/.vuepress/.temp/**

|

||||

# Vuepress Output

|

||||

dist/

|

||||

|

||||

# Node modules

|

||||

node_modules/

|

||||

|

||||

# pnpm lock file

|

||||

pnpm-lock.yaml

|

||||

|

||||

index.html

|

||||

sw.js

|

||||

@ -2,7 +2,11 @@ import { navbar } from "vuepress-theme-hope";

|

||||

|

||||

export default navbar([

|

||||

{ text: "面试指南", icon: "java", link: "/home.md" },

|

||||

{ text: "知识星球", icon: "code", link: "/about-the-author/zhishixingqiu-two-years.md" },

|

||||

{

|

||||

text: "知识星球",

|

||||

icon: "code",

|

||||

link: "/about-the-author/zhishixingqiu-two-years.md",

|

||||

},

|

||||

{ text: "开源项目", icon: "github", link: "/open-source-project/" },

|

||||

{ text: "技术书籍", icon: "book", link: "/books/" },

|

||||

{

|

||||

|

||||

@ -11,7 +11,7 @@ tag:

|

||||

|

||||

> Leetcode:给定两个非空链表来表示两个非负整数。位数按照逆序方式存储,它们的每个节点只存储单个数字。将两数相加返回一个新的链表。

|

||||

>

|

||||

>你可以假设除了数字 0 之外,这两个数字都不会以零开头。

|

||||

> 你可以假设除了数字 0 之外,这两个数字都不会以零开头。

|

||||

|

||||

示例:

|

||||

|

||||

@ -23,11 +23,11 @@ tag:

|

||||

|

||||

### 问题分析

|

||||

|

||||

Leetcode官方详细解答地址:

|

||||

Leetcode 官方详细解答地址:

|

||||

|

||||

https://leetcode-cn.com/problems/add-two-numbers/solution/

|

||||

https://leetcode-cn.com/problems/add-two-numbers/solution/

|

||||

|

||||

> 要对头结点进行操作时,考虑创建哑节点dummy,使用dummy->next表示真正的头节点。这样可以避免处理头节点为空的边界问题。

|

||||

> 要对头结点进行操作时,考虑创建哑节点 dummy,使用 dummy->next 表示真正的头节点。这样可以避免处理头节点为空的边界问题。

|

||||

|

||||

我们使用变量来跟踪进位,并从包含最低有效位的表头开始模拟逐

|

||||

位相加的过程。

|

||||

@ -36,7 +36,7 @@ Leetcode官方详细解答地址:

|

||||

|

||||

### Solution

|

||||

|

||||

**我们首先从最低有效位也就是列表 l1和 l2 的表头开始相加。注意需要考虑到进位的情况!**

|

||||

**我们首先从最低有效位也就是列表 l1 和 l2 的表头开始相加。注意需要考虑到进位的情况!**

|

||||

|

||||

```java

|

||||

/**

|

||||

@ -76,8 +76,8 @@ public ListNode addTwoNumbers(ListNode l1, ListNode l2) {

|

||||

|

||||

## 2. 翻转链表

|

||||

|

||||

|

||||

### 题目描述

|

||||

|

||||

> 剑指 offer:输入一个链表,反转链表后,输出链表的所有元素。

|

||||

|

||||

|

||||

@ -88,7 +88,6 @@ public ListNode addTwoNumbers(ListNode l1, ListNode l2) {

|

||||

|

||||

### Solution

|

||||

|

||||

|

||||

```java

|

||||

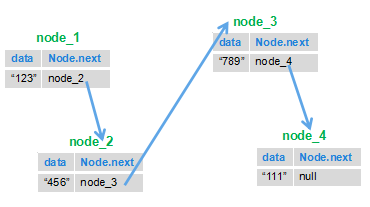

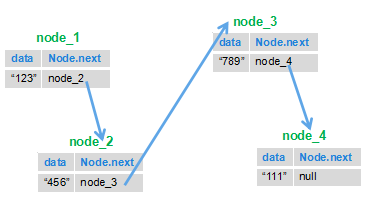

public class ListNode {

|

||||

int val;

|

||||

@ -102,7 +101,7 @@ public class ListNode {

|

||||

|

||||

```java

|

||||

/**

|

||||

*

|

||||

*

|

||||

* @author Snailclimb

|

||||

* @date 2018年9月19日

|

||||

* @Description: TODO

|

||||

@ -162,18 +161,17 @@ public class Solution {

|

||||

1

|

||||

```

|

||||

|

||||

## 3. 链表中倒数第k个节点

|

||||

## 3. 链表中倒数第 k 个节点

|

||||

|

||||

### 题目描述

|

||||

|

||||

> 剑指offer: 输入一个链表,输出该链表中倒数第k个结点。

|

||||

> 剑指 offer: 输入一个链表,输出该链表中倒数第 k 个结点。

|

||||

|

||||

### 问题分析

|

||||

|

||||

> **链表中倒数第k个节点也就是正数第(L-K+1)个节点,知道了只一点,这一题基本就没问题!**

|

||||

|

||||

首先两个节点/指针,一个节点 node1 先开始跑,指针 node1 跑到 k-1 个节点后,另一个节点 node2 开始跑,当 node1 跑到最后时,node2 所指的节点就是倒数第k个节点也就是正数第(L-K+1)个节点。

|

||||

> **链表中倒数第 k 个节点也就是正数第(L-K+1)个节点,知道了只一点,这一题基本就没问题!**

|

||||

|

||||

首先两个节点/指针,一个节点 node1 先开始跑,指针 node1 跑到 k-1 个节点后,另一个节点 node2 开始跑,当 node1 跑到最后时,node2 所指的节点就是倒数第 k 个节点也就是正数第(L-K+1)个节点。

|

||||

|

||||

### Solution

|

||||

|

||||

@ -221,9 +219,7 @@ public class Solution {

|

||||

}

|

||||

```

|

||||

|

||||

|

||||

## 4. 删除链表的倒数第N个节点

|

||||

|

||||

## 4. 删除链表的倒数第 N 个节点

|

||||

|

||||

> Leetcode:给定一个链表,删除链表的倒数第 n 个节点,并且返回链表的头结点。

|

||||

|

||||

@ -248,8 +244,7 @@ public class Solution {

|

||||

|

||||

### 问题分析

|

||||

|

||||

|

||||

我们注意到这个问题可以容易地简化成另一个问题:删除从列表开头数起的第 (L - n + 1)个结点,其中 L是列表的长度。只要我们找到列表的长度 L,这个问题就很容易解决。

|

||||

我们注意到这个问题可以容易地简化成另一个问题:删除从列表开头数起的第 (L - n + 1)个结点,其中 L 是列表的长度。只要我们找到列表的长度 L,这个问题就很容易解决。

|

||||

|

||||

|

||||

|

||||

@ -299,16 +294,13 @@ public class Solution {

|

||||

**复杂度分析:**

|

||||

|

||||

- **时间复杂度 O(L)** :该算法对列表进行了两次遍历,首先计算了列表的长度 LL 其次找到第 (L - n)(L−n) 个结点。 操作执行了 2L-n2L−n 步,时间复杂度为 O(L)O(L)。

|

||||

- **空间复杂度 O(1)** :我们只用了常量级的额外空间。

|

||||

|

||||

|

||||

- **空间复杂度 O(1)** :我们只用了常量级的额外空间。

|

||||

|

||||

**进阶——一次遍历法:**

|

||||

|

||||

> 链表中倒数第 N 个节点也就是正数第(L-N+1)个节点。

|

||||

|

||||

> 链表中倒数第N个节点也就是正数第(L-N+1)个节点。

|

||||

|

||||

其实这种方法就和我们上面第四题找“链表中倒数第k个节点”所用的思想是一样的。**基本思路就是:** 定义两个节点 node1、node2;node1 节点先跑,node1节点 跑到第 n+1 个节点的时候,node2 节点开始跑.当node1 节点跑到最后一个节点时,node2 节点所在的位置就是第 (L-n ) 个节点(L代表总链表长度,也就是倒数第 n+1 个节点)

|

||||

其实这种方法就和我们上面第四题找“链表中倒数第 k 个节点”所用的思想是一样的。**基本思路就是:** 定义两个节点 node1、node2;node1 节点先跑,node1 节点 跑到第 n+1 个节点的时候,node2 节点开始跑.当 node1 节点跑到最后一个节点时,node2 节点所在的位置就是第 (L-n ) 个节点(L 代表总链表长度,也就是倒数第 n+1 个节点)

|

||||

|

||||

```java

|

||||

/**

|

||||

@ -345,25 +337,21 @@ public class Solution {

|

||||

}

|

||||

```

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

## 5. 合并两个排序的链表

|

||||

|

||||

### 题目描述

|

||||

|

||||

> 剑指offer:输入两个单调递增的链表,输出两个链表合成后的链表,当然我们需要合成后的链表满足单调不减规则。

|

||||

> 剑指 offer:输入两个单调递增的链表,输出两个链表合成后的链表,当然我们需要合成后的链表满足单调不减规则。

|

||||

|

||||

### 问题分析

|

||||

|

||||

我们可以这样分析:

|

||||

我们可以这样分析:

|

||||

|

||||

1. 假设我们有两个链表 A,B;

|

||||

2. A的头节点A1的值与B的头结点B1的值比较,假设A1小,则A1为头节点;

|

||||

3. A2再和B1比较,假设B1小,则,A1指向B1;

|

||||

4. A2再和B2比较

|

||||

就这样循环往复就行了,应该还算好理解。

|

||||

1. 假设我们有两个链表 A,B;

|

||||

2. A 的头节点 A1 的值与 B 的头结点 B1 的值比较,假设 A1 小,则 A1 为头节点;

|

||||

3. A2 再和 B1 比较,假设 B1 小,则,A1 指向 B1;

|

||||

4. A2 再和 B2 比较

|

||||

就这样循环往复就行了,应该还算好理解。

|

||||

|

||||

考虑通过递归的方式实现!

|

||||

|

||||

@ -396,8 +384,7 @@ public ListNode Merge(ListNode list1,ListNode list2) {

|

||||

}else{

|

||||

list2.next = Merge(list1, list2.next);

|

||||

return list2;

|

||||

}

|

||||

}

|

||||

}

|

||||

}

|

||||

```

|

||||

|

||||

|

||||

@ -7,14 +7,14 @@ tag:

|

||||

|

||||

## 斐波那契数列

|

||||

|

||||

**题目描述:**

|

||||

**题目描述:**

|

||||

|

||||

大家都知道斐波那契数列,现在要求输入一个整数n,请你输出斐波那契数列的第n项。

|

||||

大家都知道斐波那契数列,现在要求输入一个整数 n,请你输出斐波那契数列的第 n 项。

|

||||

n<=39

|

||||

|

||||

**问题分析:**

|

||||

|

||||

可以肯定的是这一题通过递归的方式是肯定能做出来,但是这样会有一个很大的问题,那就是递归大量的重复计算会导致内存溢出。另外可以使用迭代法,用fn1和fn2保存计算过程中的结果,并复用起来。下面我会把两个方法示例代码都给出来并给出两个方法的运行时间对比。

|

||||

可以肯定的是这一题通过递归的方式是肯定能做出来,但是这样会有一个很大的问题,那就是递归大量的重复计算会导致内存溢出。另外可以使用迭代法,用 fn1 和 fn2 保存计算过程中的结果,并复用起来。下面我会把两个方法示例代码都给出来并给出两个方法的运行时间对比。

|

||||

|

||||

**示例代码:**

|

||||

|

||||

@ -57,24 +57,24 @@ public int Fibonacci(int n) {

|

||||

|

||||

**题目描述:**

|

||||

|

||||

一只青蛙一次可以跳上1级台阶,也可以跳上2级。求该青蛙跳上一个n级的台阶总共有多少种跳法。

|

||||

一只青蛙一次可以跳上 1 级台阶,也可以跳上 2 级。求该青蛙跳上一个 n 级的台阶总共有多少种跳法。

|

||||

|

||||

**问题分析:**

|

||||

|

||||

正常分析法:

|

||||

|

||||

> a.如果两种跳法,1阶或者2阶,那么假定第一次跳的是一阶,那么剩下的是n-1个台阶,跳法是f(n-1);

|

||||

> b.假定第一次跳的是2阶,那么剩下的是n-2个台阶,跳法是f(n-2)

|

||||

> c.由a,b假设可以得出总跳法为: f(n) = f(n-1) + f(n-2)

|

||||

> a.如果两种跳法,1 阶或者 2 阶,那么假定第一次跳的是一阶,那么剩下的是 n-1 个台阶,跳法是 f(n-1);

|

||||

> b.假定第一次跳的是 2 阶,那么剩下的是 n-2 个台阶,跳法是 f(n-2)

|

||||

> c.由 a,b 假设可以得出总跳法为: f(n) = f(n-1) + f(n-2)

|

||||

> d.然后通过实际的情况可以得出:只有一阶的时候 f(1) = 1 ,只有两阶的时候可以有 f(2) = 2

|

||||

|

||||

找规律分析法:

|

||||

|

||||

> f(1) = 1, f(2) = 2, f(3) = 3, f(4) = 5, 可以总结出f(n) = f(n-1) + f(n-2)的规律。但是为什么会出现这样的规律呢?假设现在6个台阶,我们可以从第5跳一步到6,这样的话有多少种方案跳到5就有多少种方案跳到6,另外我们也可以从4跳两步跳到6,跳到4有多少种方案的话,就有多少种方案跳到6,其他的不能从3跳到6什么的啦,所以最后就是f(6) = f(5) + f(4);这样子也很好理解变态跳台阶的问题了。

|

||||

> f(1) = 1, f(2) = 2, f(3) = 3, f(4) = 5, 可以总结出 f(n) = f(n-1) + f(n-2)的规律。但是为什么会出现这样的规律呢?假设现在 6 个台阶,我们可以从第 5 跳一步到 6,这样的话有多少种方案跳到 5 就有多少种方案跳到 6,另外我们也可以从 4 跳两步跳到 6,跳到 4 有多少种方案的话,就有多少种方案跳到 6,其他的不能从 3 跳到 6 什么的啦,所以最后就是 f(6) = f(5) + f(4);这样子也很好理解变态跳台阶的问题了。

|

||||

|

||||

**所以这道题其实就是斐波那契数列的问题。**

|

||||

|

||||

代码只需要在上一题的代码稍做修改即可。和上一题唯一不同的就是这一题的初始元素变为 1 2 3 5 8.....而上一题为1 1 2 3 5 .......。另外这一题也可以用递归做,但是递归效率太低,所以我这里只给出了迭代方式的代码。

|

||||

代码只需要在上一题的代码稍做修改即可。和上一题唯一不同的就是这一题的初始元素变为 1 2 3 5 8.....而上一题为 1 1 2 3 5 .......。另外这一题也可以用递归做,但是递归效率太低,所以我这里只给出了迭代方式的代码。

|

||||

|

||||

**示例代码:**

|

||||

|

||||

@ -103,20 +103,20 @@ int jumpFloor(int number) {

|

||||

|

||||

**题目描述:**

|

||||

|

||||

一只青蛙一次可以跳上1级台阶,也可以跳上2级……它也可以跳上n级。求该青蛙跳上一个n级的台阶总共有多少种跳法。

|

||||

一只青蛙一次可以跳上 1 级台阶,也可以跳上 2 级……它也可以跳上 n 级。求该青蛙跳上一个 n 级的台阶总共有多少种跳法。

|

||||

|

||||

**问题分析:**

|

||||

|

||||

假设n>=2,第一步有n种跳法:跳1级、跳2级、到跳n级

|

||||

跳1级,剩下n-1级,则剩下跳法是f(n-1)

|

||||

跳2级,剩下n-2级,则剩下跳法是f(n-2)

|

||||

假设 n>=2,第一步有 n 种跳法:跳 1 级、跳 2 级、到跳 n 级

|

||||

跳 1 级,剩下 n-1 级,则剩下跳法是 f(n-1)

|

||||

跳 2 级,剩下 n-2 级,则剩下跳法是 f(n-2)

|

||||

......

|

||||

跳n-1级,剩下1级,则剩下跳法是f(1)

|

||||

跳n级,剩下0级,则剩下跳法是f(0)

|

||||

所以在n>=2的情况下:

|

||||

跳 n-1 级,剩下 1 级,则剩下跳法是 f(1)

|

||||

跳 n 级,剩下 0 级,则剩下跳法是 f(0)

|

||||

所以在 n>=2 的情况下:

|

||||

f(n)=f(n-1)+f(n-2)+...+f(1)

|

||||

因为f(n-1)=f(n-2)+f(n-3)+...+f(1)

|

||||

所以f(n)=2*f(n-1) 又f(1)=1,所以可得**f(n)=2^(number-1)**

|

||||

因为 f(n-1)=f(n-2)+f(n-3)+...+f(1)

|

||||

所以 f(n)=2\*f(n-1) 又 f(1)=1,所以可得**f(n)=2^(number-1)**

|

||||

|

||||

**示例代码:**

|

||||

|

||||

@ -128,11 +128,11 @@ int JumpFloorII(int number) {

|

||||

|

||||

**补充:**

|

||||

|

||||

java中有三种移位运算符:

|

||||

java 中有三种移位运算符:

|

||||

|

||||

1. “<<” : **左移运算符**,等同于乘2的n次方

|

||||

2. “>>”: **右移运算符**,等同于除2的n次方

|

||||

3. “>>>” : **无符号右移运算符**,不管移动前最高位是0还是1,右移后左侧产生的空位部分都以0来填充。与>>类似。

|

||||

1. “<<” : **左移运算符**,等同于乘 2 的 n 次方

|

||||

2. “>>”: **右移运算符**,等同于除 2 的 n 次方

|

||||

3. “>>>” : **无符号右移运算符**,不管移动前最高位是 0 还是 1,右移后左侧产生的空位部分都以 0 来填充。与>>类似。

|

||||

|

||||

```java

|

||||

int a = 16;

|

||||

@ -140,7 +140,6 @@ int b = a << 2;//左移2,等同于16 * 2的2次方,也就是16 * 4

|

||||

int c = a >> 2;//右移2,等同于16 / 2的2次方,也就是16 / 4

|

||||

```

|

||||

|

||||

|

||||

## 二维数组查找

|

||||

|

||||

**题目描述:**

|

||||

@ -152,8 +151,8 @@ int c = a >> 2;//右移2,等同于16 / 2的2次方,也就是16 / 4

|

||||

这一道题还是比较简单的,我们需要考虑的是如何做,效率最快。这里有一种很好理解的思路:

|

||||

|

||||

> 矩阵是有序的,从左下角来看,向上数字递减,向右数字递增,

|

||||

> 因此从左下角开始查找,当要查找数字比左下角数字大时。右移

|

||||

> 要查找数字比左下角数字小时,上移。这样找的速度最快。

|

||||

> 因此从左下角开始查找,当要查找数字比左下角数字大时。右移

|

||||

> 要查找数字比左下角数字小时,上移。这样找的速度最快。

|

||||

|

||||

**示例代码:**

|

||||

|

||||

@ -180,11 +179,11 @@ public boolean Find(int target, int [][] array) {

|

||||

|

||||

**题目描述:**

|

||||

|

||||

请实现一个函数,将一个字符串中的空格替换成“%20”。例如,当字符串为We Are Happy.则经过替换之后的字符串为We%20Are%20Happy。

|

||||

请实现一个函数,将一个字符串中的空格替换成“%20”。例如,当字符串为 We Are Happy.则经过替换之后的字符串为 We%20Are%20Happy。

|

||||

|

||||

**问题分析:**

|

||||

|

||||

这道题不难,我们可以通过循环判断字符串的字符是否为空格,是的话就利用append()方法添加追加“%20”,否则还是追加原字符。

|

||||

这道题不难,我们可以通过循环判断字符串的字符是否为空格,是的话就利用 append()方法添加追加“%20”,否则还是追加原字符。

|

||||

|

||||

或者最简单的方法就是利用:replaceAll(String regex,String replacement)方法了,一行代码就可以解决。

|

||||

|

||||

@ -203,7 +202,7 @@ public String replaceSpace(StringBuffer str) {

|

||||

out.append(b);

|

||||

}

|

||||

}

|

||||

return out.toString();

|

||||

return out.toString();

|

||||

}

|

||||

```

|

||||

|

||||

@ -213,7 +212,7 @@ public String replaceSpace(StringBuffer str) {

|

||||

public String replaceSpace(StringBuffer str) {

|

||||

//return str.toString().replaceAll(" ", "%20");

|

||||

//public String replaceAll(String regex,String replacement)

|

||||

//用给定的替换替换与给定的regular expression匹配的此字符串的每个子字符串。

|

||||

//用给定的替换替换与给定的regular expression匹配的此字符串的每个子字符串。

|

||||

//\ 转义字符. 如果你要使用 "\" 本身, 则应该使用 "\\". String类型中的空格用“\s”表示,所以我这里猜测"\\s"就是代表空格的意思

|

||||

return str.toString().replaceAll("\\s", "%20");

|

||||

}

|

||||

@ -223,25 +222,22 @@ public String replaceSpace(StringBuffer str) {

|

||||

|

||||

**题目描述:**

|

||||

|

||||

给定一个double类型的浮点数base和int类型的整数exponent。求base的exponent次方。

|

||||

给定一个 double 类型的浮点数 base 和 int 类型的整数 exponent。求 base 的 exponent 次方。

|

||||

|

||||

**问题解析:**

|

||||

|

||||

这道题算是比较麻烦和难一点的一个了。我这里采用的是**二分幂**思想,当然也可以采用**快速幂**。

|

||||

更具剑指offer书中细节,该题的解题思路如下:

|

||||

1.当底数为0且指数<0时,会出现对0求倒数的情况,需进行错误处理,设置一个全局变量;

|

||||

2.判断底数是否等于0,由于base为double型,所以不能直接用==判断

|

||||

3.优化求幂函数(二分幂)。

|

||||

当n为偶数,a^n =(a^n/2)*(a^n/2);

|

||||

当n为奇数,a^n = a^[(n-1)/2] * a^[(n-1)/2] * a。时间复杂度O(logn)

|

||||

更具剑指 offer 书中细节,该题的解题思路如下: 1.当底数为 0 且指数<0 时,会出现对 0 求倒数的情况,需进行错误处理,设置一个全局变量; 2.判断底数是否等于 0,由于 base 为 double 型,所以不能直接用==判断 3.优化求幂函数(二分幂)。

|

||||

当 n 为偶数,a^n =(a^n/2)_(a^n/2);

|

||||

当 n 为奇数,a^n = a^[(n-1)/2] _ a^[(n-1)/2] \* a。时间复杂度 O(logn)

|

||||

|

||||

**时间复杂度**:O(logn)

|

||||

|

||||

**示例代码:**

|

||||

|

||||

```java

|

||||

public class Solution {

|

||||

boolean invalidInput=false;

|

||||

public class Solution {

|

||||

boolean invalidInput=false;

|

||||

public double Power(double base, int exponent) {

|

||||

//如果底数等于0并且指数小于0

|

||||

//由于base为double型,不能直接用==判断

|

||||

@ -286,7 +282,7 @@ public class Solution {

|

||||

}

|

||||

```

|

||||

|

||||

当然这一题也可以采用笨方法:累乘。不过这种方法的时间复杂度为O(n),这样没有前一种方法效率高。

|

||||

当然这一题也可以采用笨方法:累乘。不过这种方法的时间复杂度为 O(n),这样没有前一种方法效率高。

|

||||

|

||||

```java

|

||||

// 使用累乘

|

||||

@ -311,17 +307,17 @@ public double powerAnother(double base, int exponent) {

|

||||

**问题解析:**

|

||||

|

||||

这道题有挺多种解法的,给大家介绍一种我觉得挺好理解的方法:

|

||||

我们首先统计奇数的个数假设为n,然后新建一个等长数组,然后通过循环判断原数组中的元素为偶数还是奇数。如果是则从数组下标0的元素开始,把该奇数添加到新数组;如果是偶数则从数组下标为n的元素开始把该偶数添加到新数组中。

|

||||

我们首先统计奇数的个数假设为 n,然后新建一个等长数组,然后通过循环判断原数组中的元素为偶数还是奇数。如果是则从数组下标 0 的元素开始,把该奇数添加到新数组;如果是偶数则从数组下标为 n 的元素开始把该偶数添加到新数组中。

|

||||

|

||||

**示例代码:**

|

||||

|

||||

时间复杂度为O(n),空间复杂度为O(n)的算法

|

||||

时间复杂度为 O(n),空间复杂度为 O(n)的算法

|

||||

|

||||

```java

|

||||

public class Solution {

|

||||

public void reOrderArray(int [] array) {

|

||||

//如果数组长度等于0或者等于1,什么都不做直接返回

|

||||

if(array.length==0||array.length==1)

|

||||

if(array.length==0||array.length==1)

|

||||

return;

|

||||

//oddCount:保存奇数个数

|

||||

//oddBegin:奇数从数组头部开始添加

|

||||

@ -335,7 +331,7 @@ public class Solution {

|

||||

for(int i=0;i<array.length;i++){

|

||||

//如果数为基数新数组从头开始添加元素

|

||||

//如果为偶数就从oddCount(数组中的奇数个数)开始添加元素

|

||||

if((array[i]&1)==1)

|

||||

if((array[i]&1)==1)

|

||||

newArray[oddBegin++]=array[i];

|

||||

else newArray[oddCount++]=array[i];

|

||||

}

|

||||

@ -346,26 +342,26 @@ public class Solution {

|

||||

}

|

||||

```

|

||||

|

||||

## 链表中倒数第k个节点

|

||||

## 链表中倒数第 k 个节点

|

||||

|

||||

**题目描述:**

|

||||

|

||||

输入一个链表,输出该链表中倒数第k个结点

|

||||

输入一个链表,输出该链表中倒数第 k 个结点

|

||||

|

||||

**问题分析:**

|

||||

|

||||

**一句话概括:**

|

||||

两个指针一个指针p1先开始跑,指针p1跑到k-1个节点后,另一个节点p2开始跑,当p1跑到最后时,p2所指的指针就是倒数第k个节点。

|

||||

两个指针一个指针 p1 先开始跑,指针 p1 跑到 k-1 个节点后,另一个节点 p2 开始跑,当 p1 跑到最后时,p2 所指的指针就是倒数第 k 个节点。

|

||||

|

||||

**思想的简单理解:**

|

||||

前提假设:链表的结点个数(长度)为n。

|

||||

规律一:要找到倒数第k个结点,需要向前走多少步呢?比如倒数第一个结点,需要走n步,那倒数第二个结点呢?很明显是向前走了n-1步,所以可以找到规律是找到倒数第k个结点,需要向前走n-k+1步。

|

||||

前提假设:链表的结点个数(长度)为 n。

|

||||

规律一:要找到倒数第 k 个结点,需要向前走多少步呢?比如倒数第一个结点,需要走 n 步,那倒数第二个结点呢?很明显是向前走了 n-1 步,所以可以找到规律是找到倒数第 k 个结点,需要向前走 n-k+1 步。

|

||||

|

||||

**算法开始:**

|

||||

|

||||

1. 设两个都指向head的指针p1和p2,当p1走了k-1步的时候,停下来。p2之前一直不动。

|

||||

2. p1的下一步是走第k步,这个时候,p2开始一起动了。至于为什么p2这个时候动呢?看下面的分析。

|

||||

3. 当p1走到链表的尾部时,即p1走了n步。由于我们知道p2是在p1走了k-1步才开始动的,也就是说p1和p2永远差k-1步。所以当p1走了n步时,p2走的应该是在n-(k-1)步。即p2走了n-k+1步,此时巧妙的是p2正好指向的是规律一的倒数第k个结点处。

|

||||

1. 设两个都指向 head 的指针 p1 和 p2,当 p1 走了 k-1 步的时候,停下来。p2 之前一直不动。

|

||||

2. p1 的下一步是走第 k 步,这个时候,p2 开始一起动了。至于为什么 p2 这个时候动呢?看下面的分析。

|

||||

3. 当 p1 走到链表的尾部时,即 p1 走了 n 步。由于我们知道 p2 是在 p1 走了 k-1 步才开始动的,也就是说 p1 和 p2 永远差 k-1 步。所以当 p1 走了 n 步时,p2 走的应该是在 n-(k-1)步。即 p2 走了 n-k+1 步,此时巧妙的是 p2 正好指向的是规律一的倒数第 k 个结点处。

|

||||

这样是不是很好理解了呢?

|

||||

|

||||

**考察内容:**

|

||||

@ -410,7 +406,7 @@ public class Solution {

|

||||

//如果节点个数小于所求的倒数第k个节点,则返回空

|

||||

if(count<a) return null;

|

||||

return pre;

|

||||

|

||||

|

||||

}

|

||||

}

|

||||

```

|

||||

@ -425,7 +421,7 @@ public class Solution {

|

||||

|

||||

链表的很常规的一道题,这一道题思路不算难,但自己实现起来真的可能会感觉无从下手,我是参考了别人的代码。

|

||||

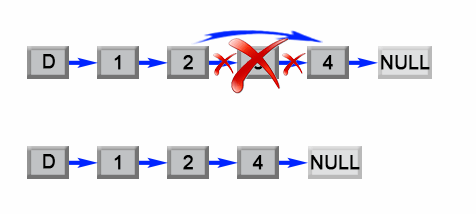

思路就是我们根据链表的特点,前一个节点指向下一个节点的特点,把后面的节点移到前面来。

|

||||

就比如下图:我们把1节点和2节点互换位置,然后再将3节点指向2节点,4节点指向3节点,这样以来下面的链表就被反转了。

|

||||

就比如下图:我们把 1 节点和 2 节点互换位置,然后再将 3 节点指向 2 节点,4 节点指向 3 节点,这样以来下面的链表就被反转了。

|

||||

|

||||

|

||||

|

||||

@ -475,9 +471,9 @@ public class Solution {

|

||||

我们可以这样分析:

|

||||

|

||||

1. 假设我们有两个链表 A,B;

|

||||

2. A的头节点A1的值与B的头结点B1的值比较,假设A1小,则A1为头节点;

|

||||

3. A2再和B1比较,假设B1小,则,A1指向B1;

|

||||

4. A2再和B2比较。。。。。。。

|

||||

2. A 的头节点 A1 的值与 B 的头结点 B1 的值比较,假设 A1 小,则 A1 为头节点;

|

||||

3. A2 再和 B1 比较,假设 B1 小,则,A1 指向 B1;

|

||||

4. A2 再和 B2 比较。。。。。。。

|

||||

就这样循环往复就行了,应该还算好理解。

|

||||

|

||||

**考察内容:**

|

||||

@ -509,10 +505,10 @@ public class Solution {

|

||||

return list1;

|

||||

}

|

||||

ListNode mergeHead = null;

|

||||

ListNode current = null;

|

||||

ListNode current = null;

|

||||

//当list1和list2不为空时

|

||||

while(list1!=null && list2!=null){

|

||||

//取较小值作头结点

|

||||

//取较小值作头结点

|

||||

if(list1.val <= list2.val){

|

||||

if(mergeHead == null){

|

||||

mergeHead = current = list1;

|

||||

@ -561,7 +557,7 @@ public ListNode Merge(ListNode list1,ListNode list2) {

|

||||

}else{

|

||||

list2.next = Merge(list1, list2.next);

|

||||

return list2;

|

||||

}

|

||||

}

|

||||

}

|

||||

```

|

||||

|

||||

@ -569,17 +565,17 @@ public ListNode Merge(ListNode list1,ListNode list2) {

|

||||

|

||||

**题目描述:**

|

||||

|

||||

用两个栈来实现一个队列,完成队列的Push和Pop操作。 队列中的元素为int类型。

|

||||

用两个栈来实现一个队列,完成队列的 Push 和 Pop 操作。 队列中的元素为 int 类型。

|

||||

|

||||

**问题分析:**

|

||||

|

||||

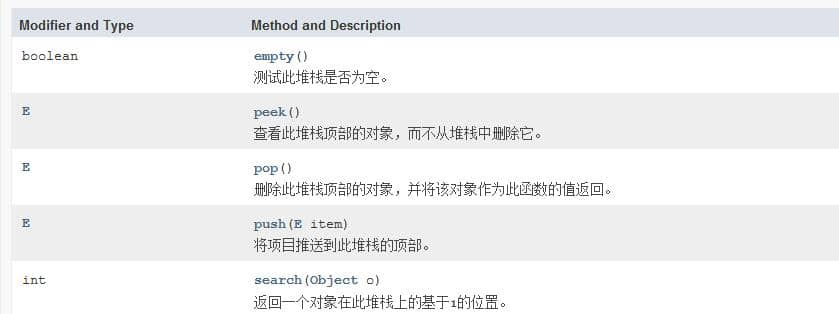

先来回顾一下栈和队列的基本特点:

|

||||

**栈:**后进先出(LIFO)

|

||||

**队列:** 先进先出

|

||||

很明显我们需要根据JDK给我们提供的栈的一些基本方法来实现。先来看一下Stack类的一些基本方法:

|

||||

很明显我们需要根据 JDK 给我们提供的栈的一些基本方法来实现。先来看一下 Stack 类的一些基本方法:

|

||||

|

||||

|

||||

既然题目给了我们两个栈,我们可以这样考虑当push的时候将元素push进stack1,pop的时候我们先把stack1的元素pop到stack2,然后再对stack2执行pop操作,这样就可以保证是先进先出的。(负[pop]负[pop]得正[先进先出])

|

||||

既然题目给了我们两个栈,我们可以这样考虑当 push 的时候将元素 push 进 stack1,pop 的时候我们先把 stack1 的元素 pop 到 stack2,然后再对 stack2 执行 pop 操作,这样就可以保证是先进先出的。(负[pop]负[pop]得正[先进先出])

|

||||

|

||||

**考察内容:**

|

||||

|

||||

@ -590,16 +586,16 @@ public ListNode Merge(ListNode list1,ListNode list2) {

|

||||

```java

|

||||

//左程云的《程序员代码面试指南》的答案

|

||||

import java.util.Stack;

|

||||

|

||||

|

||||

public class Solution {

|

||||

Stack<Integer> stack1 = new Stack<Integer>();

|

||||

Stack<Integer> stack2 = new Stack<Integer>();

|

||||

|

||||

|

||||

//当执行push操作时,将元素添加到stack1

|

||||

public void push(int node) {

|

||||

stack1.push(node);

|

||||

}

|

||||

|

||||

|

||||

public int pop() {

|

||||

//如果两个队列都为空则抛出异常,说明用户没有push进任何元素

|

||||

if(stack1.empty()&&stack2.empty()){

|

||||

@ -621,37 +617,37 @@ public class Solution {

|

||||

|

||||

**题目描述:**

|

||||

|

||||

输入两个整数序列,第一个序列表示栈的压入顺序,请判断第二个序列是否为该栈的弹出顺序。假设压入栈的所有数字均不相等。例如序列1,2,3,4,5是某栈的压入顺序,序列4,5,3,2,1是该压栈序列对应的一个弹出序列,但4,3,5,1,2就不可能是该压栈序列的弹出序列。(注意:这两个序列的长度是相等的)

|

||||

输入两个整数序列,第一个序列表示栈的压入顺序,请判断第二个序列是否为该栈的弹出顺序。假设压入栈的所有数字均不相等。例如序列 1,2,3,4,5 是某栈的压入顺序,序列 4,5,3,2,1 是该压栈序列对应的一个弹出序列,但 4,3,5,1,2 就不可能是该压栈序列的弹出序列。(注意:这两个序列的长度是相等的)

|

||||

|

||||

**题目分析:**

|

||||

|

||||

这道题想了半天没有思路,参考了Alias的答案,他的思路写的也很详细应该很容易看懂。

|

||||

这道题想了半天没有思路,参考了 Alias 的答案,他的思路写的也很详细应该很容易看懂。

|

||||

作者:Alias

|

||||

https://www.nowcoder.com/questionTerminal/d77d11405cc7470d82554cb392585106

|

||||

来源:牛客网

|

||||

|

||||

【思路】借用一个辅助的栈,遍历压栈顺序,先讲第一个放入栈中,这里是1,然后判断栈顶元素是不是出栈顺序的第一个元素,这里是4,很显然1≠4,所以我们继续压栈,直到相等以后开始出栈,出栈一个元素,则将出栈顺序向后移动一位,直到不相等,这样循环等压栈顺序遍历完成,如果辅助栈还不为空,说明弹出序列不是该栈的弹出顺序。

|

||||

【思路】借用一个辅助的栈,遍历压栈顺序,先讲第一个放入栈中,这里是 1,然后判断栈顶元素是不是出栈顺序的第一个元素,这里是 4,很显然 1≠4,所以我们继续压栈,直到相等以后开始出栈,出栈一个元素,则将出栈顺序向后移动一位,直到不相等,这样循环等压栈顺序遍历完成,如果辅助栈还不为空,说明弹出序列不是该栈的弹出顺序。

|

||||

|

||||

举例:

|

||||

|

||||

入栈1,2,3,4,5

|

||||

入栈 1,2,3,4,5

|

||||

|

||||

出栈4,5,3,2,1

|

||||

出栈 4,5,3,2,1

|

||||

|

||||

首先1入辅助栈,此时栈顶1≠4,继续入栈2

|

||||

首先 1 入辅助栈,此时栈顶 1≠4,继续入栈 2

|

||||

|

||||

此时栈顶2≠4,继续入栈3

|

||||

此时栈顶 2≠4,继续入栈 3

|

||||

|

||||

此时栈顶3≠4,继续入栈4

|

||||

此时栈顶 3≠4,继续入栈 4

|

||||

|

||||

此时栈顶4=4,出栈4,弹出序列向后一位,此时为5,,辅助栈里面是1,2,3

|

||||

此时栈顶 4 = 4,出栈 4,弹出序列向后一位,此时为 5,,辅助栈里面是 1,2,3

|

||||

|

||||

此时栈顶3≠5,继续入栈5

|

||||

此时栈顶 3≠5,继续入栈 5

|

||||

|

||||

此时栈顶5=5,出栈5,弹出序列向后一位,此时为3,,辅助栈里面是1,2,3

|

||||

此时栈顶 5=5,出栈 5,弹出序列向后一位,此时为 3,,辅助栈里面是 1,2,3

|

||||

|

||||

….

|

||||

依次执行,最后辅助栈为空。如果不为空说明弹出序列不是该栈的弹出顺序。

|

||||

依次执行,最后辅助栈为空。如果不为空说明弹出序列不是该栈的弹出顺序。

|

||||

|

||||

**考察内容:**

|

||||

|

||||

@ -683,4 +679,4 @@ public class Solution {

|

||||

return s.empty();

|

||||

}

|

||||

}

|

||||

```

|

||||

```

|

||||

|

||||

@ -57,7 +57,6 @@ tag:

|

||||

1. 判断给定数据是否存在:比如判断一个数字是否存在于包含大量数字的数字集中(数字集很大,5 亿以上!)、 防止缓存穿透(判断请求的数据是否有效避免直接绕过缓存请求数据库)等等、邮箱的垃圾邮件过滤、黑名单功能等等。

|

||||

2. 去重:比如爬给定网址的时候对已经爬取过的 URL 去重。

|

||||

|

||||

|

||||

## 编码实战

|

||||

|

||||

### 通过 Java 编程手动实现布隆过滤器

|

||||

@ -242,12 +241,12 @@ System.out.println(filter.mightContain(2));

|

||||

|

||||

Redis v4.0 之后有了 Module(模块/插件) 功能,Redis Modules 让 Redis 可以使用外部模块扩展其功能 。布隆过滤器就是其中的 Module。详情可以查看 Redis 官方对 Redis Modules 的介绍 :https://redis.io/modules

|

||||

|

||||

另外,官网推荐了一个 RedisBloom 作为 Redis 布隆过滤器的 Module,地址:https://github.com/RedisBloom/RedisBloom

|

||||

另外,官网推荐了一个 RedisBloom 作为 Redis 布隆过滤器的 Module,地址:https://github.com/RedisBloom/RedisBloom

|

||||

其他还有:

|

||||

|

||||

* redis-lua-scaling-bloom-filter(lua 脚本实现):https://github.com/erikdubbelboer/redis-lua-scaling-bloom-filter

|

||||

* pyreBloom(Python 中的快速 Redis 布隆过滤器) :https://github.com/seomoz/pyreBloom

|

||||

* ......

|

||||

- redis-lua-scaling-bloom-filter(lua 脚本实现):https://github.com/erikdubbelboer/redis-lua-scaling-bloom-filter

|

||||

- pyreBloom(Python 中的快速 Redis 布隆过滤器) :https://github.com/seomoz/pyreBloom

|

||||

- ......

|

||||

|

||||

RedisBloom 提供了多种语言的客户端支持,包括:Python、Java、JavaScript 和 PHP。

|

||||

|

||||

@ -287,7 +286,7 @@ root@21396d02c252:/data# redis-cli

|

||||

|

||||

可选参数:

|

||||

|

||||

* expansion:如果创建了一个新的子过滤器,则其大小将是当前过滤器的大小乘以`expansion`。默认扩展值为 2。这意味着每个后续子过滤器将是前一个子过滤器的两倍。

|

||||

- expansion:如果创建了一个新的子过滤器,则其大小将是当前过滤器的大小乘以`expansion`。默认扩展值为 2。这意味着每个后续子过滤器将是前一个子过滤器的两倍。

|

||||

|

||||

### 实际使用

|

||||

|

||||

|

||||

@ -14,7 +14,7 @@ tag:

|

||||

|

||||

但是,图形结构的元素之间的关系是任意的。

|

||||

|

||||

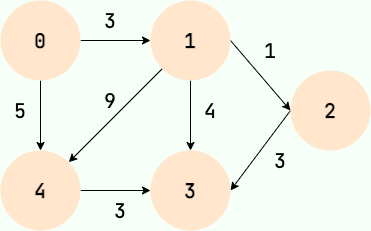

**何为图呢?** 简单来说,图就是由顶点的有穷非空集合和顶点之间的边组成的集合。通常表示为:**G(V,E)**,其中,G表示一个图,V表示顶点的集合,E表示边的集合。

|

||||

**何为图呢?** 简单来说,图就是由顶点的有穷非空集合和顶点之间的边组成的集合。通常表示为:**G(V,E)**,其中,G 表示一个图,V 表示顶点的集合,E 表示边的集合。

|

||||

|

||||

下图所展示的就是图这种数据结构,并且还是一张有向图。

|

||||

|

||||

@ -25,24 +25,28 @@ tag:

|

||||

## 图的基本概念

|

||||

|

||||

### 顶点

|

||||

|

||||

图中的数据元素,我们称之为顶点,图至少有一个顶点(非空有穷集合)

|

||||

|

||||

对应到好友关系图,每一个用户就代表一个顶点。

|

||||

|

||||

### 边

|

||||

|

||||

顶点之间的关系用边表示。

|

||||

|

||||

对应到好友关系图,两个用户是好友的话,那两者之间就存在一条边。

|

||||

|

||||

### 度

|

||||

|

||||

度表示一个顶点包含多少条边,在有向图中,还分为出度和入度,出度表示从该顶点出去的边的条数,入度表示进入该顶点的边的条数。

|

||||

|

||||

对应到好友关系图,度就代表了某个人的好友数量。

|

||||

|

||||

### 无向图和有向图

|

||||

边表示的是顶点之间的关系,有的关系是双向的,比如同学关系,A是B的同学,那么B也肯定是A的同学,那么在表示A和B的关系时,就不用关注方向,用不带箭头的边表示,这样的图就是无向图。

|

||||

|

||||

有的关系是有方向的,比如父子关系,师生关系,微博的关注关系,A是B的爸爸,但B肯定不是A的爸爸,A关注B,B不一定关注A。在这种情况下,我们就用带箭头的边表示二者的关系,这样的图就是有向图。

|

||||

边表示的是顶点之间的关系,有的关系是双向的,比如同学关系,A 是 B 的同学,那么 B 也肯定是 A 的同学,那么在表示 A 和 B 的关系时,就不用关注方向,用不带箭头的边表示,这样的图就是无向图。

|

||||

|

||||

有的关系是有方向的,比如父子关系,师生关系,微博的关注关系,A 是 B 的爸爸,但 B 肯定不是 A 的爸爸,A 关注 B,B 不一定关注 A。在这种情况下,我们就用带箭头的边表示二者的关系,这样的图就是有向图。

|

||||

|

||||

### 无权图和带权图

|

||||

|

||||

@ -55,16 +59,18 @@ tag:

|

||||

|

||||

|

||||

## 图的存储

|

||||

|

||||

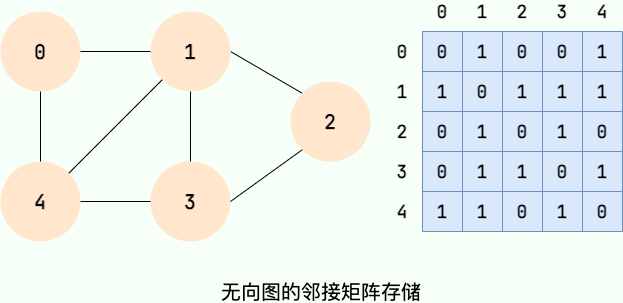

### 邻接矩阵存储

|

||||

|

||||

邻接矩阵将图用二维矩阵存储,是一种较为直观的表示方式。

|

||||

|

||||

如果第i个顶点和第j个顶点之间有关系,且关系权值为n,则 `A[i][j]=n` 。

|

||||

如果第 i 个顶点和第 j 个顶点之间有关系,且关系权值为 n,则 `A[i][j]=n` 。

|

||||

|

||||

在无向图中,我们只关心关系的有无,所以当顶点i和顶点j有关系时,`A[i][j]`=1,当顶点i和顶点j没有关系时,`A[i][j]`=0。如下图所示:

|

||||

在无向图中,我们只关心关系的有无,所以当顶点 i 和顶点 j 有关系时,`A[i][j]`=1,当顶点 i 和顶点 j 没有关系时,`A[i][j]`=0。如下图所示:

|

||||

|

||||

|

||||

|

||||

值得注意的是:**无向图的邻接矩阵是一个对称矩阵,因为在无向图中,顶点i和顶点j有关系,则顶点j和顶点i必有关系。**

|

||||

值得注意的是:**无向图的邻接矩阵是一个对称矩阵,因为在无向图中,顶点 i 和顶点 j 有关系,则顶点 j 和顶点 i 必有关系。**

|

||||

|

||||

|

||||

|

||||

@ -74,7 +80,7 @@ tag:

|

||||

|

||||

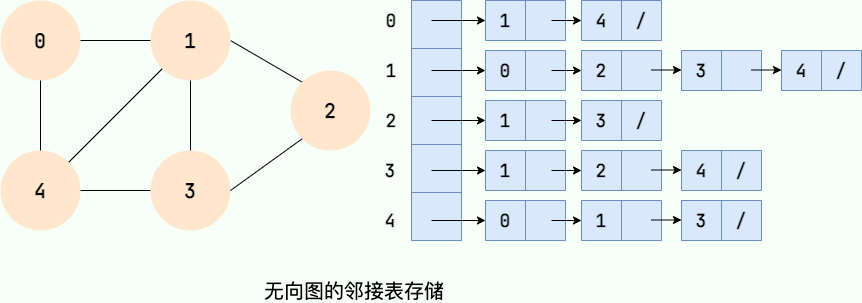

针对上面邻接矩阵比较浪费内存空间的问题,诞生了图的另外一种存储方法—**邻接表** 。

|

||||

|

||||

邻接链表使用一个链表来存储某个顶点的所有后继相邻顶点。对于图中每个顶点Vi,把所有邻接于Vi的顶点Vj链成一个单链表,这个单链表称为顶点Vi的 **邻接表**。如下图所示:

|

||||

邻接链表使用一个链表来存储某个顶点的所有后继相邻顶点。对于图中每个顶点 Vi,把所有邻接于 Vi 的顶点 Vj 链成一个单链表,这个单链表称为顶点 Vi 的 **邻接表**。如下图所示:

|

||||

|

||||

|

||||

|

||||

@ -82,38 +88,40 @@ tag:

|

||||

|

||||

大家可以数一数邻接表中所存储的元素的个数以及图中边的条数,你会发现:

|

||||

|

||||

- 在无向图中,邻接表元素个数等于边的条数的两倍,如左图所示的无向图中,边的条数为7,邻接表存储的元素个数为14。

|

||||

- 在有向图中,邻接表元素个数等于边的条数,如右图所示的有向图中,边的条数为8,邻接表存储的元素个数为8。

|

||||

- 在无向图中,邻接表元素个数等于边的条数的两倍,如左图所示的无向图中,边的条数为 7,邻接表存储的元素个数为 14。

|

||||

- 在有向图中,邻接表元素个数等于边的条数,如右图所示的有向图中,边的条数为 8,邻接表存储的元素个数为 8。

|

||||

|

||||

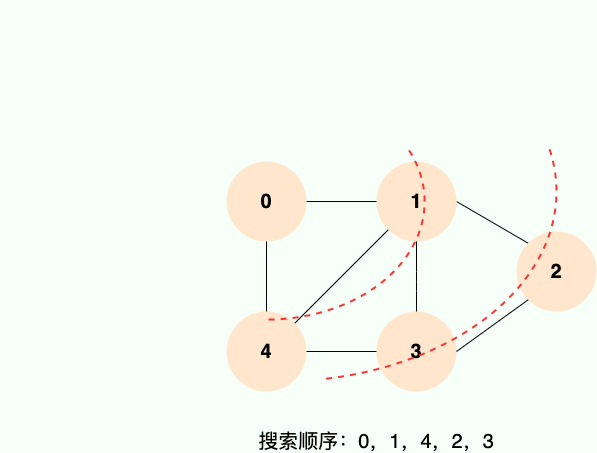

## 图的搜索

|

||||

|

||||

### 广度优先搜索

|

||||

|

||||

广度优先搜索就像水面上的波纹一样一层一层向外扩展,如下图所示:

|

||||

|

||||

|

||||

|

||||

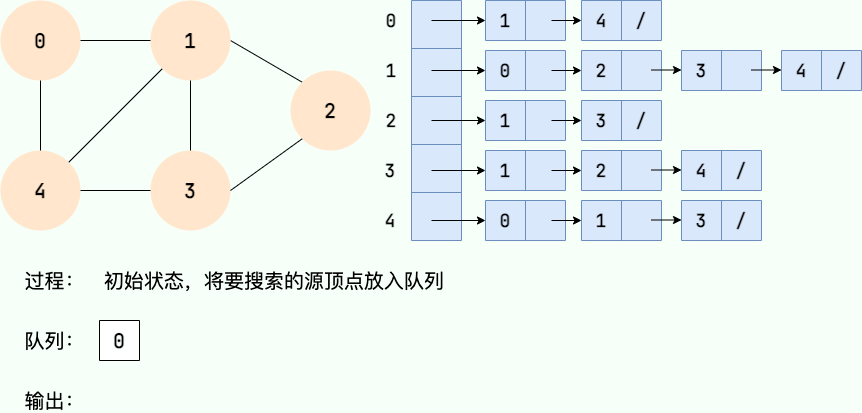

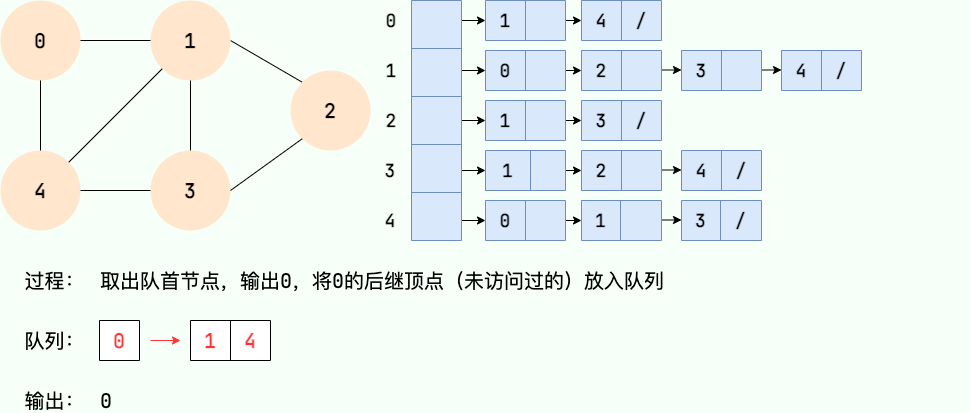

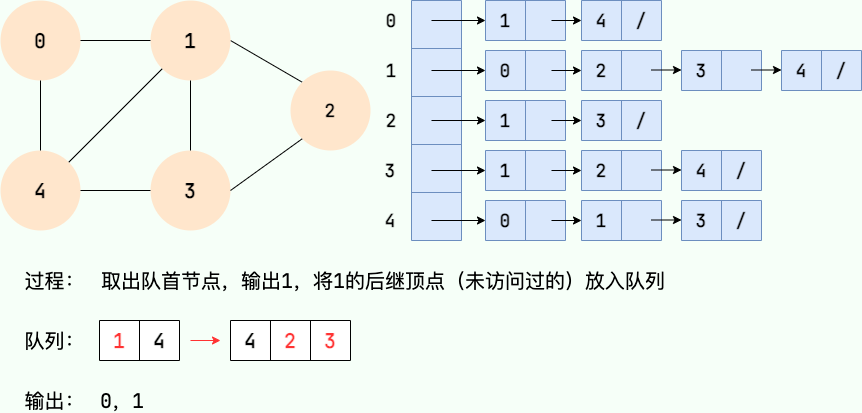

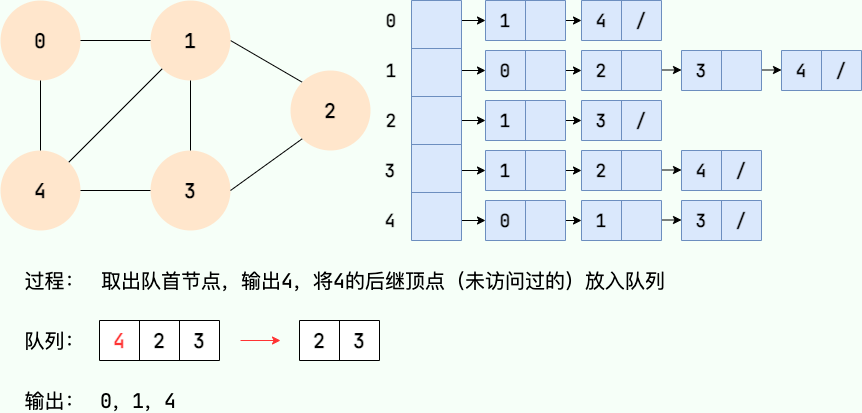

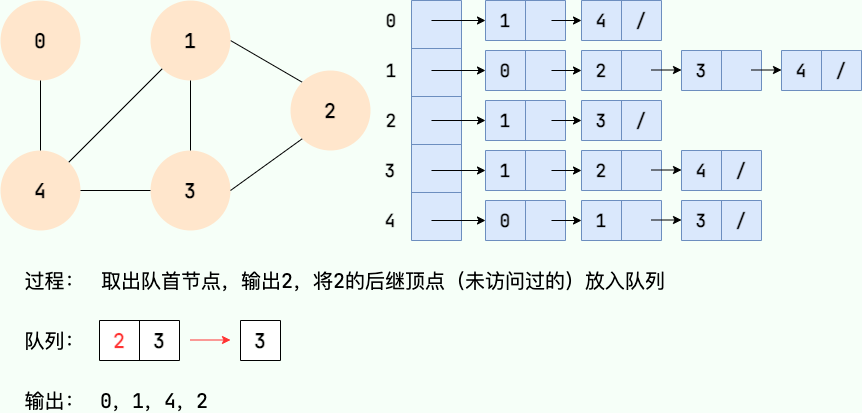

**广度优先搜索的具体实现方式用到了之前所学过的线性数据结构——队列** 。具体过程如下图所示:

|

||||

|

||||

**第1步:**

|

||||

**第 1 步:**

|

||||

|

||||

|

||||

|

||||

**第2步:**

|

||||

**第 2 步:**

|

||||

|

||||

|

||||

|

||||

**第3步:**

|

||||

**第 3 步:**

|

||||

|

||||

|

||||

|

||||

**第4步:**

|

||||

**第 4 步:**

|

||||

|

||||

|

||||

|

||||

**第5步:**

|

||||

**第 5 步:**

|

||||

|

||||

|

||||

|

||||

**第6步:**

|

||||

**第 6 步:**

|

||||

|

||||

|

||||

|

||||

@ -123,30 +131,28 @@ tag:

|

||||

|

||||

|

||||

|

||||

|

||||

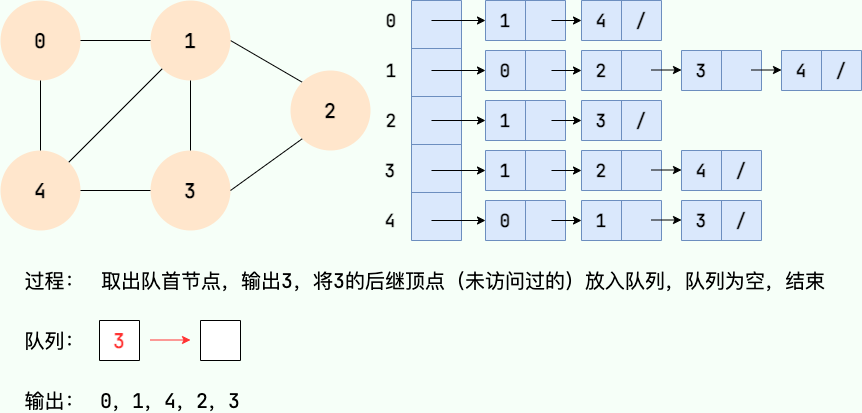

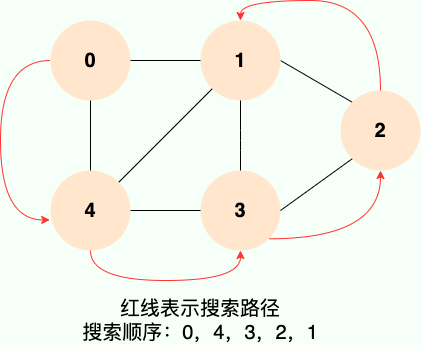

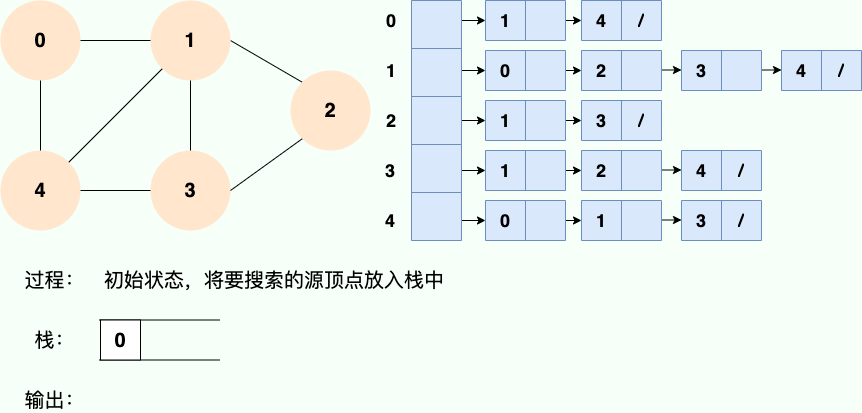

**和广度优先搜索类似,深度优先搜索的具体实现用到了另一种线性数据结构——栈** 。具体过程如下图所示:

|

||||

|

||||

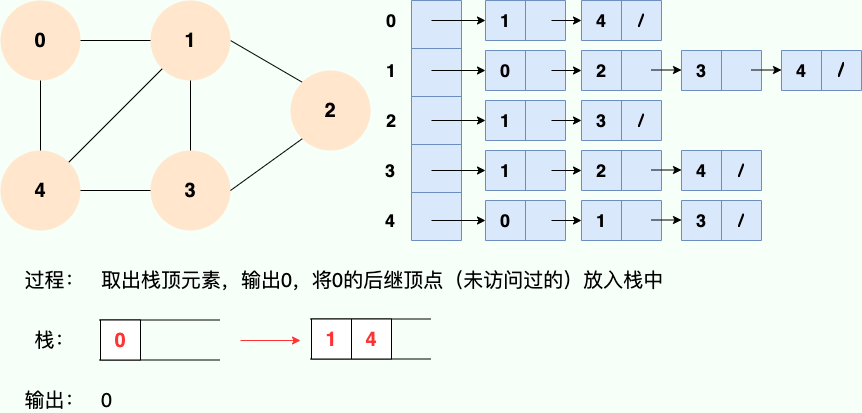

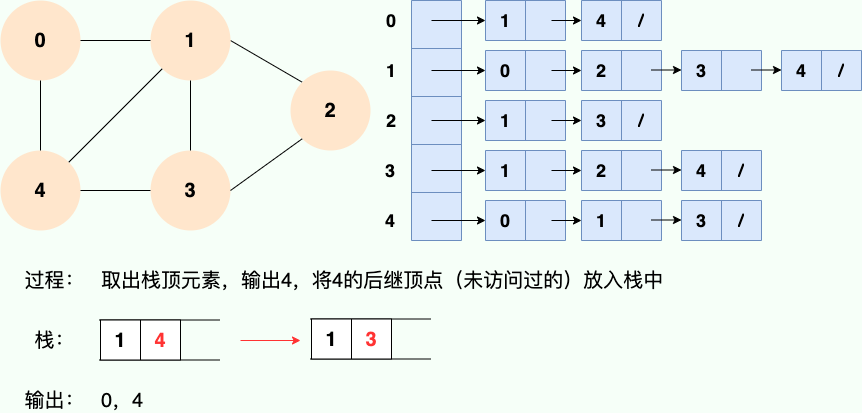

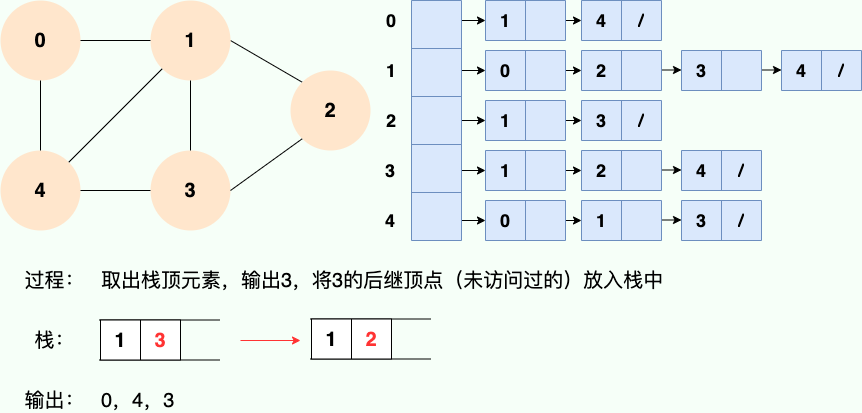

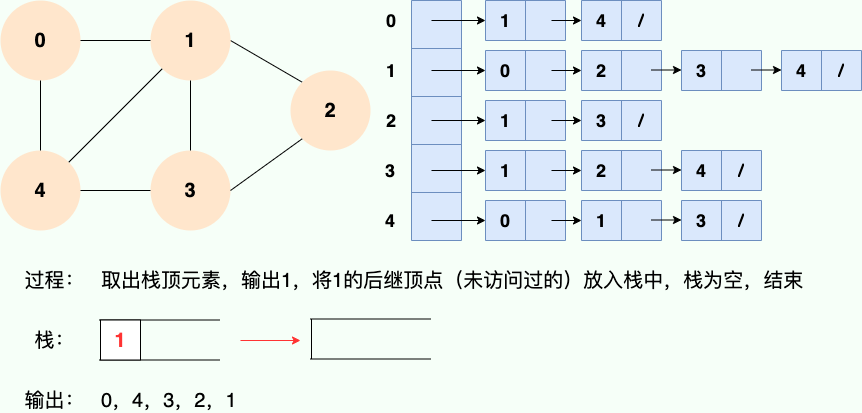

**第1步:**

|

||||

**第 1 步:**

|

||||

|

||||

|

||||

|

||||

**第2步:**

|

||||

**第 2 步:**

|

||||

|

||||

|

||||

|

||||

**第3步:**

|

||||

**第 3 步:**

|

||||

|

||||

|

||||

|

||||

**第4步:**

|

||||

**第 4 步:**

|

||||

|

||||

|

||||

|

||||

**第5步:**

|

||||

**第 5 步:**

|

||||

|

||||

|

||||

|

||||

**第6步:**

|

||||

**第 6 步:**

|

||||

|

||||

|

||||

|

||||

|

||||

@ -23,11 +23,12 @@ tag:

|

||||

|

||||

|

||||

|

||||

第1个和第2个是堆。第1个是最大堆,每个节点都比子树中所有节点大。第2个是最小堆,每个节点都比子树中所有节点小。

|

||||

第 1 个和第 2 个是堆。第 1 个是最大堆,每个节点都比子树中所有节点大。第 2 个是最小堆,每个节点都比子树中所有节点小。

|

||||

|

||||

第3个不是,第三个中,根结点1比2和15小,而15却比3大,19比5大,不满足堆的性质。

|

||||

第 3 个不是,第三个中,根结点 1 比 2 和 15 小,而 15 却比 3 大,19 比 5 大,不满足堆的性质。

|

||||

|

||||

## 堆的用途

|

||||

|

||||

当我们只关心所有数据中的最大值或者最小值,存在多次获取最大值或者最小值,多次插入或删除数据时,就可以使用堆。

|

||||

|

||||

有小伙伴可能会想到用有序数组,初始化一个有序数组时间复杂度是 `O(nlog(n))`,查找最大值或者最小值时间复杂度都是 `O(1)`,但是,涉及到更新(插入或删除)数据时,时间复杂度为 `O(n)`,即使是使用复杂度为 `O(log(n))` 的二分法找到要插入或者删除的数据,在移动数据时也需要 `O(n)` 的时间复杂度。

|

||||

@ -39,25 +40,30 @@ tag:

|

||||

## 堆的分类

|

||||

|

||||

堆分为 **最大堆** 和 **最小堆**。二者的区别在于节点的排序方式。

|

||||

|

||||

- **最大堆** :堆中的每一个节点的值都大于等于子树中所有节点的值

|

||||

- **最小堆** :堆中的每一个节点的值都小于等于子树中所有节点的值

|

||||

|

||||

如下图所示,图1是最大堆,图2是最小堆

|

||||

如下图所示,图 1 是最大堆,图 2 是最小堆

|

||||

|

||||

|

||||

|

||||

|

||||

## 堆的存储

|

||||

之前介绍树的时候说过,由于完全二叉树的优秀性质,利用数组存储二叉树即节省空间,又方便索引(若根结点的序号为1,那么对于树中任意节点i,其左子节点序号为 `2*i`,右子节点序号为 `2*i+1`)。

|

||||

|

||||

之前介绍树的时候说过,由于完全二叉树的优秀性质,利用数组存储二叉树即节省空间,又方便索引(若根结点的序号为 1,那么对于树中任意节点 i,其左子节点序号为 `2*i`,右子节点序号为 `2*i+1`)。

|

||||

|

||||

为了方便存储和索引,(二叉)堆可以用完全二叉树的形式进行存储。存储的方式如下图所示:

|

||||

|

||||

|

||||

|

||||

## 堆的操作

|

||||

堆的更新操作主要包括两种 : **插入元素** 和 **删除堆顶元素**。操作过程需要着重掌握和理解。

|

||||

|

||||

堆的更新操作主要包括两种 : **插入元素** 和 **删除堆顶元素**。操作过程需要着重掌握和理解。

|

||||

|

||||

> 在进入正题之前,再重申一遍,堆是一个公平的公司,有能力的人自然会走到与他能力所匹配的位置

|

||||

|

||||

### 插入元素

|

||||

|

||||

> 插入元素,作为一个新入职的员工,初来乍到,这个员工需要从基层做起

|

||||

|

||||

**1.将要插入的元素放到最后**

|

||||

@ -85,20 +91,16 @@ tag:

|

||||

|

||||

> 在堆这个公司中,会出现老大离职的现象,老大离职之后,他的位置就空出来了

|

||||

|

||||

首先删除堆顶元素,使得数组中下标为1的位置空出。

|

||||

|

||||

|

||||

首先删除堆顶元素,使得数组中下标为 1 的位置空出。

|

||||

|

||||

|

||||

|

||||

|

||||

> 那么他的位置由谁来接替呢,当然是他的直接下属了,谁能力强就让谁上呗

|

||||

|

||||

比较根结点的左子节点和右子节点,也就是下标为2,3的数组元素,将较大的元素填充到根结点(下标为1)的位置。

|

||||

比较根结点的左子节点和右子节点,也就是下标为 2,3 的数组元素,将较大的元素填充到根结点(下标为 1)的位置。

|

||||

|

||||

|

||||

|

||||

|

||||

> 这个时候又空出一个位置了,老规矩,谁有能力谁上

|

||||

|

||||

一直循环比较空出位置的左右子节点,并将较大者移至空位,直到堆的最底部

|

||||

@ -108,6 +110,7 @@ tag:

|

||||

这个时候已经完成了自底向上的堆化,没有元素可以填补空缺了,但是,我们可以看到数组中出现了“气泡”,这会导致存储空间的浪费。接下来我们试试自顶向下堆化。

|

||||

|

||||

#### 自顶向下堆化

|

||||

|

||||

自顶向下的堆化用一个词形容就是“石沉大海”,那么第一件事情,就是把石头抬起来,从海面扔下去。这个石头就是堆的最后一个元素,我们将最后一个元素移动到堆顶。

|

||||

|

||||

|

||||

@ -118,14 +121,11 @@ tag:

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

### 堆的操作总结

|

||||

|

||||

- **插入元素** :先将元素放至数组末尾,再自底向上堆化,将末尾元素上浮

|

||||

- **删除堆顶元素** :删除堆顶元素,将末尾元素放至堆顶,再自顶向下堆化,将堆顶元素下沉。也可以自底向上堆化,只是会产生“气泡”,浪费存储空间。最好采用自顶向下堆化的方式。

|

||||

|

||||

|

||||

## 堆排序

|

||||

|

||||

堆排序的过程分为两步:

|

||||

@ -137,22 +137,22 @@ tag:

|

||||

|

||||

如果你已经足够了解堆化的过程,那么建堆的过程掌握起来就比较容易了。建堆的过程就是一个对所有非叶节点的自顶向下堆化过程。

|

||||

|

||||

首先要了解哪些是非叶节点,最后一个节点的父结点及它之前的元素,都是非叶节点。也就是说,如果节点个数为n,那么我们需要对n/2到1的节点进行自顶向下(沉底)堆化。

|

||||

首先要了解哪些是非叶节点,最后一个节点的父结点及它之前的元素,都是非叶节点。也就是说,如果节点个数为 n,那么我们需要对 n/2 到 1 的节点进行自顶向下(沉底)堆化。

|

||||

|

||||

具体过程如下图:

|

||||

|

||||

|

||||

|

||||

将初始的无序数组抽象为一棵树,图中的节点个数为6,所以4,5,6节点为叶节点,1,2,3节点为非叶节点,所以要对1-3号节点进行自顶向下(沉底)堆化,注意,顺序是从后往前堆化,从3号节点开始,一直到1号节点。

|

||||

3号节点堆化结果:

|

||||

将初始的无序数组抽象为一棵树,图中的节点个数为 6,所以 4,5,6 节点为叶节点,1,2,3 节点为非叶节点,所以要对 1-3 号节点进行自顶向下(沉底)堆化,注意,顺序是从后往前堆化,从 3 号节点开始,一直到 1 号节点。

|

||||

3 号节点堆化结果:

|

||||

|

||||

|

||||

|

||||

2号节点堆化结果:

|

||||

2 号节点堆化结果:

|

||||

|

||||

|

||||

|

||||

1号节点堆化结果:

|

||||

1 号节点堆化结果:

|

||||

|

||||

|

||||

|

||||

|

||||

@ -10,13 +10,12 @@ tag:

|

||||

|

||||

1. 每个节点非红即黑;

|

||||

2. 根节点总是黑色的;

|

||||

3. 每个叶子节点都是黑色的空节点(NIL节点);

|

||||

3. 每个叶子节点都是黑色的空节点(NIL 节点);

|

||||

4. 如果节点是红色的,则它的子节点必须是黑色的(反之不一定);

|

||||

5. 从根节点到叶节点或空子节点的每条路径,必须包含相同数目的黑色节点(即相同的黑色高度)。

|

||||

|

||||

**红黑树的应用** :TreeMap、TreeSet以及JDK1.8的HashMap底层都用到了红黑树。

|

||||

**红黑树的应用** :TreeMap、TreeSet 以及 JDK1.8 的 HashMap 底层都用到了红黑树。

|

||||

|

||||

**为什么要用红黑树?** 简单来说红黑树就是为了解决二叉查找树的缺陷,因为二叉查找树在某些情况下会退化成一个线性结构。详细了解可以查看 [漫画:什么是红黑树?](https://juejin.im/post/5a27c6946fb9a04509096248#comment)(也介绍到了二叉查找树,非常推荐)

|

||||

|

||||

**相关阅读** :[《红黑树深入剖析及Java实现》](https://zhuanlan.zhihu.com/p/24367771)(美团点评技术团队)

|

||||

|

||||

**相关阅读** :[《红黑树深入剖析及 Java 实现》](https://zhuanlan.zhihu.com/p/24367771)(美团点评技术团队)

|

||||

|

||||

@ -38,7 +38,7 @@ tag:

|

||||

|

||||

**二叉树** 的分支通常被称作“**左子树**”或“**右子树**”。并且,**二叉树** 的分支具有左右次序,不能随意颠倒。

|

||||

|

||||

**二叉树** 的第 i 层至多拥有 `2^(i-1)` 个节点,深度为 k 的二叉树至多总共有 `2^(k+1)-1` 个节点(满二叉树的情况),至少有 2^(k) 个节点(关于节点的深度的定义国内争议比较多,我个人比较认可维基百科对[节点深度的定义](https://zh.wikipedia.org/wiki/%E6%A0%91_(%E6%95%B0%E6%8D%AE%E7%BB%93%E6%9E%84)#/%E6%9C%AF%E8%AF%AD))。

|

||||

**二叉树** 的第 i 层至多拥有 `2^(i-1)` 个节点,深度为 k 的二叉树至多总共有 `2^(k+1)-1` 个节点(满二叉树的情况),至少有 2^(k) 个节点(关于节点的深度的定义国内争议比较多,我个人比较认可维基百科对[节点深度的定义](<https://zh.wikipedia.org/wiki/%E6%A0%91_(%E6%95%B0%E6%8D%AE%E7%BB%93%E6%9E%84)#/%E6%9C%AF%E8%AF%AD>))。

|

||||

|

||||

|

||||

|

||||

@ -48,8 +48,6 @@ tag:

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

### 完全二叉树

|

||||

|

||||

除最后一层外,若其余层都是满的,并且最后一层或者是满的,或者是在右边缺少连续若干节点,则这个二叉树就是 **完全二叉树** 。

|

||||

|

||||

@ -5,8 +5,6 @@ tag:

|

||||

- 计算机网络

|

||||

---

|

||||

|

||||

|

||||

|

||||

## HTTP:超文本传输协议

|

||||

|

||||

**超文本传输协议(HTTP,HyperText Transfer Protocol)** 是一种用于传输超文本和多媒体内容的协议,主要是为 Web 浏览器与 Web 服务器之间的通信而设计的。当我们使用浏览器浏览网页的时候,我们网页就是通过 HTTP 请求进行加载的。

|

||||

@ -112,4 +110,4 @@ DNS(Domain Name System,域名管理系统)基于 UDP 协议,用于解决

|

||||

## 参考

|

||||

|

||||

- 《计算机网络自顶向下方法》(第七版)

|

||||

- RTP 协议介绍:https://mthli.xyz/rtp-introduction/

|

||||

- RTP 协议介绍:https://mthli.xyz/rtp-introduction/

|

||||

|

||||

@ -100,4 +100,4 @@ ARP 的工作原理将分两种场景讨论:

|

||||

|

||||

7. 路由器接口将对 IP 数据报重新封装成链路层帧,目标 MAC 地址为主机 B 的 MAC 地址,单播发送,直到目的地。

|

||||

|

||||

|

||||

|

||||

|

||||

@ -5,12 +5,11 @@ tag:

|

||||

- 计算机网络

|

||||

---

|

||||

|

||||

|

||||

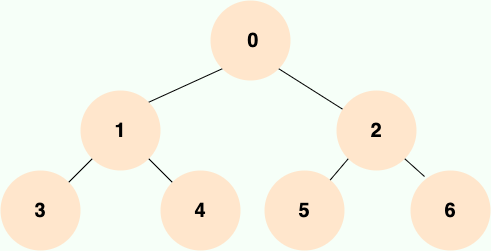

本文是我在大二学习计算机网络期间整理, 大部分内容都来自于谢希仁老师的[《计算机网络》第七版 ](https://www.elias.ltd/usr/local/etc/%E8%AE%A1%E7%AE%97%E6%9C%BA%E7%BD%91%E7%BB%9C%EF%BC%88%E7%AC%AC7%E7%89%88%EF%BC%89%E8%B0%A2%E5%B8%8C%E4%BB%81.pdf)这本书。为了内容更容易理解,我对之前的整理进行了一波重构,并配上了一些相关的示意图便于理解。

|

||||

|

||||

|

||||

|

||||

相关问题:[如何评价谢希仁的计算机网络(第七版)? - 知乎](https://www.zhihu.com/question/327872966) 。

|

||||

相关问题:[如何评价谢希仁的计算机网络(第七版)? - 知乎](https://www.zhihu.com/question/327872966) 。

|

||||

|

||||

## 1. 计算机网络概述

|

||||

|

||||

|

||||

@ -1,5 +1,5 @@

|

||||

---

|

||||

title: DNS 域名系统详解(应用层)

|

||||

title: DNS 域名系统详解(应用层)

|

||||

category: 计算机基础

|

||||

tag:

|

||||

- 计算机网络

|

||||

@ -99,4 +99,4 @@ foo.example.com. A 192.0.2.23

|

||||

|

||||

- DNS 服务器类型:https://www.cloudflare.com/zh-cn/learning/dns/dns-server-types/

|

||||

- DNS Message Resource Record Field Formats:http://www.tcpipguide.com/free/t_DNSMessageResourceRecordFieldFormats-2.htm

|

||||

- Understanding Different Types of Record in DNS Server:https://www.mustbegeek.com/understanding-different-types-of-record-in-dns-server/

|

||||

- Understanding Different Types of Record in DNS Server:https://www.mustbegeek.com/understanding-different-types-of-record-in-dns-server/

|

||||

|

||||

@ -1,5 +1,5 @@

|

||||

---

|

||||

title: HTTP vs HTTPS(应用层)

|

||||

title: HTTP vs HTTPS(应用层)

|

||||

category: 计算机基础

|

||||

tag:

|

||||

- 计算机网络

|

||||

@ -39,7 +39,7 @@ HTTPS 协议中,SSL 通道通常使用基于密钥的加密算法,密钥长

|

||||

|

||||

保密性好、信任度高。

|

||||

|

||||

## HTTPS 的核心—SSL/TLS协议

|

||||

## HTTPS 的核心—SSL/TLS 协议

|

||||

|

||||

HTTPS 之所以能达到较高的安全性要求,就是结合了 SSL/TLS 和 TCP 协议,对通信数据进行加密,解决了 HTTP 数据透明的问题。接下来重点介绍一下 SSL/TLS 的工作原理。

|

||||

|

||||

@ -138,6 +138,3 @@ SSL/TLS 介绍到这里,了解信息安全的朋友又会想到一个安全隐

|

||||

- **端口号** :HTTP 默认是 80,HTTPS 默认是 443。

|

||||

- **URL 前缀** :HTTP 的 URL 前缀是 `http://`,HTTPS 的 URL 前缀是 `https://`。

|

||||

- **安全性和资源消耗** : HTTP 协议运行在 TCP 之上,所有传输的内容都是明文,客户端和服务器端都无法验证对方的身份。HTTPS 是运行在 SSL/TLS 之上的 HTTP 协议,SSL/TLS 运行在 TCP 之上。所有传输的内容都经过加密,加密采用对称加密,但对称加密的密钥用服务器方的证书进行了非对称加密。所以说,HTTP 安全性没有 HTTPS 高,但是 HTTPS 比 HTTP 耗费更多服务器资源。

|

||||

|

||||

|

||||

|

||||

|

||||

@ -1,11 +1,11 @@

|

||||

---

|

||||

title: HTTP 常见状态码总结(应用层)

|

||||

title: HTTP 常见状态码总结(应用层)

|

||||

category: 计算机基础

|

||||

tag:

|

||||

- 计算机网络

|

||||

---

|

||||

|

||||

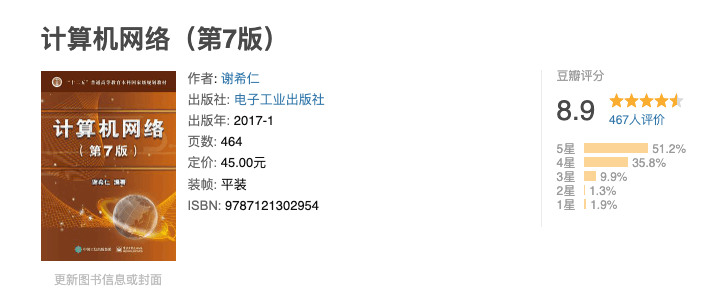

HTTP 状态码用于描述 HTTP 请求的结果,比如2xx 就代表请求被成功处理。

|

||||

HTTP 状态码用于描述 HTTP 请求的结果,比如 2xx 就代表请求被成功处理。

|

||||

|

||||

|

||||

|

||||

@ -15,32 +15,32 @@ HTTP 状态码用于描述 HTTP 请求的结果,比如2xx 就代表请求被

|

||||

|

||||

### 2xx Success(成功状态码)

|

||||

|

||||

- **200 OK** :请求被成功处理。比如我们发送一个查询用户数据的HTTP 请求到服务端,服务端正确返回了用户数据。这个是我们平时最常见的一个 HTTP 状态码。

|

||||

- **200 OK** :请求被成功处理。比如我们发送一个查询用户数据的 HTTP 请求到服务端,服务端正确返回了用户数据。这个是我们平时最常见的一个 HTTP 状态码。

|

||||

- **201 Created** :请求被成功处理并且在服务端创建了一个新的资源。比如我们通过 POST 请求创建一个新的用户。

|

||||

- **202 Accepted** :服务端已经接收到了请求,但是还未处理。

|

||||

- **204 No Content** : 服务端已经成功处理了请求,但是没有返回任何内容。

|

||||

- **204 No Content** : 服务端已经成功处理了请求,但是没有返回任何内容。

|

||||

|

||||

这里格外提一下 204 状态码,平时学习/工作中见到的次数并不多。

|

||||

|

||||

[HTTP RFC 2616对204状态码的描述](https://tools.ietf.org/html/rfc2616#section-10.2.5)如下:

|

||||

[HTTP RFC 2616 对 204 状态码的描述](https://tools.ietf.org/html/rfc2616#section-10.2.5)如下:

|

||||

|

||||

> The server has fulfilled the request but does not need to return an

|

||||

> entity-body, and might want to return updated metainformation. The

|

||||

> response MAY include new or updated metainformation in the form of

|

||||

> entity-headers, which if present SHOULD be associated with the

|

||||

> requested variant.

|

||||

> The server has fulfilled the request but does not need to return an

|

||||

> entity-body, and might want to return updated metainformation. The

|

||||

> response MAY include new or updated metainformation in the form of

|

||||

> entity-headers, which if present SHOULD be associated with the

|

||||

> requested variant.

|

||||

>

|

||||

> If the client is a user agent, it SHOULD NOT change its document view

|

||||

> from that which caused the request to be sent. This response is

|

||||

> primarily intended to allow input for actions to take place without

|

||||

> causing a change to the user agent's active document view, although

|

||||

> any new or updated metainformation SHOULD be applied to the document

|

||||

> currently in the user agent's active view.

|

||||

> If the client is a user agent, it SHOULD NOT change its document view

|

||||

> from that which caused the request to be sent. This response is

|

||||

> primarily intended to allow input for actions to take place without

|

||||

> causing a change to the user agent's active document view, although

|

||||

> any new or updated metainformation SHOULD be applied to the document

|

||||

> currently in the user agent's active view.

|

||||

>

|

||||

> The 204 response MUST NOT include a message-body, and thus is always

|

||||

> terminated by the first empty line after the header fields.

|

||||

> The 204 response MUST NOT include a message-body, and thus is always

|

||||

> terminated by the first empty line after the header fields.

|

||||

|

||||

简单来说,204状态码描述的是我们向服务端发送 HTTP 请求之后,只关注处理结果是否成功的场景。也就是说我们需要的就是一个结果:true/false。

|

||||

简单来说,204 状态码描述的是我们向服务端发送 HTTP 请求之后,只关注处理结果是否成功的场景。也就是说我们需要的就是一个结果:true/false。

|

||||

|

||||

举个例子:你要追一个女孩子,你问女孩子:“我能追你吗?”,女孩子回答:“好!”。我们把这个女孩子当做是服务端就很好理解 204 状态码了。

|

||||

|

||||

@ -51,15 +51,15 @@ HTTP 状态码用于描述 HTTP 请求的结果,比如2xx 就代表请求被

|

||||

|

||||

### 4xx Client Error(客户端错误状态码)

|

||||

|

||||

- **400 Bad Request** : 发送的HTTP请求存在问题。比如请求参数不合法、请求方法错误。

|

||||

- **400 Bad Request** : 发送的 HTTP 请求存在问题。比如请求参数不合法、请求方法错误。

|

||||

- **401 Unauthorized** : 未认证却请求需要认证之后才能访问的资源。

|

||||

- **403 Forbidden** :直接拒绝HTTP请求,不处理。一般用来针对非法请求。

|

||||

- **403 Forbidden** :直接拒绝 HTTP 请求,不处理。一般用来针对非法请求。

|

||||

- **404 Not Found** : 你请求的资源未在服务端找到。比如你请求某个用户的信息,服务端并没有找到指定的用户。

|

||||

- **409 Conflict** : 表示请求的资源与服务端当前的状态存在冲突,请求无法被处理。

|

||||

|

||||

### 5xx Server Error(服务端错误状态码)

|

||||

|

||||

- **500 Internal Server Error** : 服务端出问题了(通常是服务端出Bug了)。比如你服务端处理请求的时候突然抛出异常,但是异常并未在服务端被正确处理。

|

||||

- **500 Internal Server Error** : 服务端出问题了(通常是服务端出 Bug 了)。比如你服务端处理请求的时候突然抛出异常,但是异常并未在服务端被正确处理。

|

||||

- **502 Bad Gateway** :我们的网关将请求转发到服务端,但是服务端返回的却是一个错误的响应。

|

||||

|

||||

### 参考

|

||||

@ -68,4 +68,3 @@ HTTP 状态码用于描述 HTTP 请求的结果,比如2xx 就代表请求被

|

||||

- https://developer.mozilla.org/zh-CN/docs/Web/HTTP/Status

|

||||

- https://en.wikipedia.org/wiki/List_of_HTTP_status_codes

|

||||

- https://segmentfault.com/a/1190000018264501

|

||||

|

||||

|

||||

@ -1,5 +1,5 @@

|

||||

---

|

||||

title: HTTP 1.0 vs HTTP 1.1(应用层)

|

||||

title: HTTP 1.0 vs HTTP 1.1(应用层)

|

||||

category: 计算机基础

|

||||

tag:

|

||||

- 计算机网络

|

||||

@ -10,12 +10,12 @@ tag:

|

||||

- 响应状态码

|

||||

- 缓存处理

|

||||

- 连接方式

|

||||

- Host头处理

|

||||

- Host 头处理

|

||||

- 带宽优化

|

||||

|

||||

## 响应状态码

|

||||

|

||||

HTTP/1.0仅定义了16种状态码。HTTP/1.1中新加入了大量的状态码,光是错误响应状态码就新增了24种。比如说,`100 (Continue)`——在请求大资源前的预热请求,`206 (Partial Content)`——范围请求的标识码,`409 (Conflict)`——请求与当前资源的规定冲突,`410 (Gone)`——资源已被永久转移,而且没有任何已知的转发地址。

|

||||

HTTP/1.0 仅定义了 16 种状态码。HTTP/1.1 中新加入了大量的状态码,光是错误响应状态码就新增了 24 种。比如说,`100 (Continue)`——在请求大资源前的预热请求,`206 (Partial Content)`——范围请求的标识码,`409 (Conflict)`——请求与当前资源的规定冲突,`410 (Gone)`——资源已被永久转移,而且没有任何已知的转发地址。

|

||||

|

||||

## 缓存处理

|

||||

|

||||

@ -23,7 +23,7 @@ HTTP/1.0仅定义了16种状态码。HTTP/1.1中新加入了大量的状态码

|

||||

|

||||

### HTTP/1.0

|

||||

|

||||

HTTP/1.0提供的缓存机制非常简单。服务器端使用`Expires`标签来标志(时间)一个响应体,在`Expires`标志时间内的请求,都会获得该响应体缓存。服务器端在初次返回给客户端的响应体中,有一个`Last-Modified`标签,该标签标记了被请求资源在服务器端的最后一次修改。在请求头中,使用`If-Modified-Since`标签,该标签标志一个时间,意为客户端向服务器进行问询:“该时间之后,我要请求的资源是否有被修改过?”通常情况下,请求头中的`If-Modified-Since`的值即为上一次获得该资源时,响应体中的`Last-Modified`的值。

|

||||

HTTP/1.0 提供的缓存机制非常简单。服务器端使用`Expires`标签来标志(时间)一个响应体,在`Expires`标志时间内的请求,都会获得该响应体缓存。服务器端在初次返回给客户端的响应体中,有一个`Last-Modified`标签,该标签标记了被请求资源在服务器端的最后一次修改。在请求头中,使用`If-Modified-Since`标签,该标签标志一个时间,意为客户端向服务器进行问询:“该时间之后,我要请求的资源是否有被修改过?”通常情况下,请求头中的`If-Modified-Since`的值即为上一次获得该资源时,响应体中的`Last-Modified`的值。

|

||||

|

||||

如果服务器接收到了请求头,并判断`If-Modified-Since`时间后,资源确实没有修改过,则返回给客户端一个`304 not modified`响应头,表示”缓冲可用,你从浏览器里拿吧!”。

|

||||

|

||||

@ -35,27 +35,27 @@ HTTP/1.0提供的缓存机制非常简单。服务器端使用`Expires`标签来

|

||||

|

||||

### HTTP/1.1

|

||||

|

||||

HTTP/1.1的缓存机制在HTTP/1.0的基础上,大大增加了灵活性和扩展性。基本工作原理和HTTP/1.0保持不变,而是增加了更多细致的特性。其中,请求头中最常见的特性就是`Cache-Control`,详见MDN Web文档 [Cache-Control](https://developer.mozilla.org/zh-CN/docs/Web/HTTP/Headers/Cache-Control).

|

||||

HTTP/1.1 的缓存机制在 HTTP/1.0 的基础上,大大增加了灵活性和扩展性。基本工作原理和 HTTP/1.0 保持不变,而是增加了更多细致的特性。其中,请求头中最常见的特性就是`Cache-Control`,详见 MDN Web 文档 [Cache-Control](https://developer.mozilla.org/zh-CN/docs/Web/HTTP/Headers/Cache-Control).

|

||||

|

||||

## 连接方式

|

||||

|

||||

**HTTP/1.0 默认使用短连接** ,也就是说,客户端和服务器每进行一次 HTTP 操作,就建立一次连接,任务结束就中断连接。当客户端浏览器访问的某个 HTML 或其他类型的 Web 页中包含有其他的 Web 资源(如 JavaScript 文件、图像文件、CSS 文件等),每遇到这样一个 Web 资源,浏览器就会重新建立一个TCP连接,这样就会导致有大量的“握手报文”和“挥手报文”占用了带宽。

|

||||

**HTTP/1.0 默认使用短连接** ,也就是说,客户端和服务器每进行一次 HTTP 操作,就建立一次连接,任务结束就中断连接。当客户端浏览器访问的某个 HTML 或其他类型的 Web 页中包含有其他的 Web 资源(如 JavaScript 文件、图像文件、CSS 文件等),每遇到这样一个 Web 资源,浏览器就会重新建立一个 TCP 连接,这样就会导致有大量的“握手报文”和“挥手报文”占用了带宽。

|

||||

|

||||

**为了解决 HTTP/1.0 存在的资源浪费的问题, HTTP/1.1 优化为默认长连接模式 。** 采用长连接模式的请求报文会通知服务端:“我向你请求连接,并且连接成功建立后,请不要关闭”。因此,该TCP连接将持续打开,为后续的客户端-服务端的数据交互服务。也就是说在使用长连接的情况下,当一个网页打开完成后,客户端和服务器之间用于传输 HTTP 数据的 TCP 连接不会关闭,客户端再次访问这个服务器时,会继续使用这一条已经建立的连接。

|

||||

**为了解决 HTTP/1.0 存在的资源浪费的问题, HTTP/1.1 优化为默认长连接模式 。** 采用长连接模式的请求报文会通知服务端:“我向你请求连接,并且连接成功建立后,请不要关闭”。因此,该 TCP 连接将持续打开,为后续的客户端-服务端的数据交互服务。也就是说在使用长连接的情况下,当一个网页打开完成后,客户端和服务器之间用于传输 HTTP 数据的 TCP 连接不会关闭,客户端再次访问这个服务器时,会继续使用这一条已经建立的连接。

|

||||

|

||||

如果 TCP 连接一直保持的话也是对资源的浪费,因此,一些服务器软件(如 Apache)还会支持超时时间的时间。在超时时间之内没有新的请求达到,TCP 连接才会被关闭。

|

||||

|

||||

有必要说明的是,HTTP/1.0仍提供了长连接选项,即在请求头中加入`Connection: Keep-alive`。同样的,在HTTP/1.1中,如果不希望使用长连接选项,也可以在请求头中加入`Connection: close`,这样会通知服务器端:“我不需要长连接,连接成功后即可关闭”。

|

||||

有必要说明的是,HTTP/1.0 仍提供了长连接选项,即在请求头中加入`Connection: Keep-alive`。同样的,在 HTTP/1.1 中,如果不希望使用长连接选项,也可以在请求头中加入`Connection: close`,这样会通知服务器端:“我不需要长连接,连接成功后即可关闭”。

|

||||

|

||||

**HTTP 协议的长连接和短连接,实质上是 TCP 协议的长连接和短连接。**

|

||||

|

||||

**实现长连接需要客户端和服务端都支持长连接。**

|

||||

|

||||

## Host头处理

|

||||

## Host 头处理

|

||||

|

||||

域名系统(DNS)允许多个主机名绑定到同一个IP地址上,但是HTTP/1.0并没有考虑这个问题,假设我们有一个资源URL是http://example1.org/home.html,HTTP/1.0的请求报文中,将会请求的是`GET /home.html HTTP/1.0`.也就是不会加入主机名。这样的报文送到服务器端,服务器是理解不了客户端想请求的真正网址。

|

||||

域名系统(DNS)允许多个主机名绑定到同一个 IP 地址上,但是 HTTP/1.0 并没有考虑这个问题,假设我们有一个资源 URL 是http://example1.org/home.html,HTTP/1.0的请求报文中,将会请求的是`GET /home.html HTTP/1.0`.也就是不会加入主机名。这样的报文送到服务器端,服务器是理解不了客户端想请求的真正网址。

|

||||

|

||||

因此,HTTP/1.1在请求头中加入了`Host`字段。加入`Host`字段的报文头部将会是:

|

||||

因此,HTTP/1.1 在请求头中加入了`Host`字段。加入`Host`字段的报文头部将会是:

|

||||

|

||||

```

|

||||

GET /home.html HTTP/1.1

|

||||

@ -68,37 +68,37 @@ Host: example1.org

|

||||

|

||||

### 范围请求

|

||||

|

||||

HTTP/1.1引入了范围请求(range request)机制,以避免带宽的浪费。当客户端想请求一个文件的一部分,或者需要继续下载一个已经下载了部分但被终止的文件,HTTP/1.1可以在请求中加入`Range`头部,以请求(并只能请求字节型数据)数据的一部分。服务器端可以忽略`Range`头部,也可以返回若干`Range`响应。

|

||||

HTTP/1.1 引入了范围请求(range request)机制,以避免带宽的浪费。当客户端想请求一个文件的一部分,或者需要继续下载一个已经下载了部分但被终止的文件,HTTP/1.1 可以在请求中加入`Range`头部,以请求(并只能请求字节型数据)数据的一部分。服务器端可以忽略`Range`头部,也可以返回若干`Range`响应。

|

||||

|

||||

如果一个响应包含部分数据的话,那么将带有`206 (Partial Content)`状态码。该状态码的意义在于避免了HTTP/1.0代理缓存错误地把该响应认为是一个完整的数据响应,从而把他当作为一个请求的响应缓存。

|

||||

如果一个响应包含部分数据的话,那么将带有`206 (Partial Content)`状态码。该状态码的意义在于避免了 HTTP/1.0 代理缓存错误地把该响应认为是一个完整的数据响应,从而把他当作为一个请求的响应缓存。

|

||||

|

||||

在范围响应中,`Content-Range`头部标志指示出了该数据块的偏移量和数据块的长度。

|

||||

|

||||

### 状态码100

|

||||

### 状态码 100

|

||||

|

||||

HTTP/1.1中新加入了状态码`100`。该状态码的使用场景为,存在某些较大的文件请求,服务器可能不愿意响应这种请求,此时状态码`100`可以作为指示请求是否会被正常响应,过程如下图:

|

||||

HTTP/1.1 中新加入了状态码`100`。该状态码的使用场景为,存在某些较大的文件请求,服务器可能不愿意响应这种请求,此时状态码`100`可以作为指示请求是否会被正常响应,过程如下图:

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

然而在HTTP/1.0中,并没有`100 (Continue)`状态码,要想触发这一机制,可以发送一个`Expect`头部,其中包含一个`100-continue`的值。

|

||||

然而在 HTTP/1.0 中,并没有`100 (Continue)`状态码,要想触发这一机制,可以发送一个`Expect`头部,其中包含一个`100-continue`的值。

|

||||

|

||||

### 压缩

|

||||

|

||||

许多格式的数据在传输时都会做预压缩处理。数据的压缩可以大幅优化带宽的利用。然而,HTTP/1.0对数据压缩的选项提供的不多,不支持压缩细节的选择,也无法区分端到端(end-to-end)压缩或者是逐跳(hop-by-hop)压缩。

|

||||

许多格式的数据在传输时都会做预压缩处理。数据的压缩可以大幅优化带宽的利用。然而,HTTP/1.0 对数据压缩的选项提供的不多,不支持压缩细节的选择,也无法区分端到端(end-to-end)压缩或者是逐跳(hop-by-hop)压缩。

|

||||

|

||||

HTTP/1.1则对内容编码(content-codings)和传输编码(transfer-codings)做了区分。内容编码总是端到端的,传输编码总是逐跳的。

|

||||

HTTP/1.1 则对内容编码(content-codings)和传输编码(transfer-codings)做了区分。内容编码总是端到端的,传输编码总是逐跳的。

|

||||

|

||||

HTTP/1.0包含了`Content-Encoding`头部,对消息进行端到端编码。HTTP/1.1加入了`Transfer-Encoding`头部,可以对消息进行逐跳传输编码。HTTP/1.1还加入了`Accept-Encoding`头部,是客户端用来指示他能处理什么样的内容编码。

|

||||

HTTP/1.0 包含了`Content-Encoding`头部,对消息进行端到端编码。HTTP/1.1 加入了`Transfer-Encoding`头部,可以对消息进行逐跳传输编码。HTTP/1.1 还加入了`Accept-Encoding`头部,是客户端用来指示他能处理什么样的内容编码。

|

||||

|

||||

## 总结

|

||||

|

||||

1. **连接方式** : HTTP 1.0 为短连接,HTTP 1.1 支持长连接。

|

||||

1. **状态响应码** : HTTP/1.1中新加入了大量的状态码,光是错误响应状态码就新增了24种。比如说,`100 (Continue)`——在请求大资源前的预热请求,`206 (Partial Content)`——范围请求的标识码,`409 (Conflict)`——请求与当前资源的规定冲突,`410 (Gone)`——资源已被永久转移,而且没有任何已知的转发地址。

|

||||

1. **状态响应码** : HTTP/1.1 中新加入了大量的状态码,光是错误响应状态码就新增了 24 种。比如说,`100 (Continue)`——在请求大资源前的预热请求,`206 (Partial Content)`——范围请求的标识码,`409 (Conflict)`——请求与当前资源的规定冲突,`410 (Gone)`——资源已被永久转移,而且没有任何已知的转发地址。

|

||||

1. **缓存处理** : 在 HTTP1.0 中主要使用 header 里的 If-Modified-Since,Expires 来做为缓存判断的标准,HTTP1.1 则引入了更多的缓存控制策略例如 Entity tag,If-Unmodified-Since, If-Match, If-None-Match 等更多可供选择的缓存头来控制缓存策略。

|

||||

1. **带宽优化及网络连接的使用** :HTTP1.0 中,存在一些浪费带宽的现象,例如客户端只是需要某个对象的一部分,而服务器却将整个对象送过来了,并且不支持断点续传功能,HTTP1.1 则在请求头引入了 range 头域,它允许只请求资源的某个部分,即返回码是 206(Partial Content),这样就方便了开发者自由的选择以便于充分利用带宽和连接。

|

||||

1. **Host头处理** : HTTP/1.1在请求头中加入了`Host`字段。

|

||||

1. **Host 头处理** : HTTP/1.1 在请求头中加入了`Host`字段。

|

||||

|

||||

## 参考资料

|

||||

|

||||

|

||||

@ -1,13 +1,13 @@

|

||||

---

|

||||

title: 网络攻击常见手段总结

|

||||

title: 网络攻击常见手段总结

|

||||

category: 计算机基础

|

||||

tag:

|

||||

- 计算机网络

|

||||

---

|

||||

|

||||

> 本文整理完善自[TCP/IP常见攻击手段 - 暖蓝笔记 - 2021](https://mp.weixin.qq.com/s/AZwWrOlLxRSSi-ywBgZ0fA)这篇文章。

|

||||

> 本文整理完善自[TCP/IP 常见攻击手段 - 暖蓝笔记 - 2021](https://mp.weixin.qq.com/s/AZwWrOlLxRSSi-ywBgZ0fA)这篇文章。

|

||||

|

||||

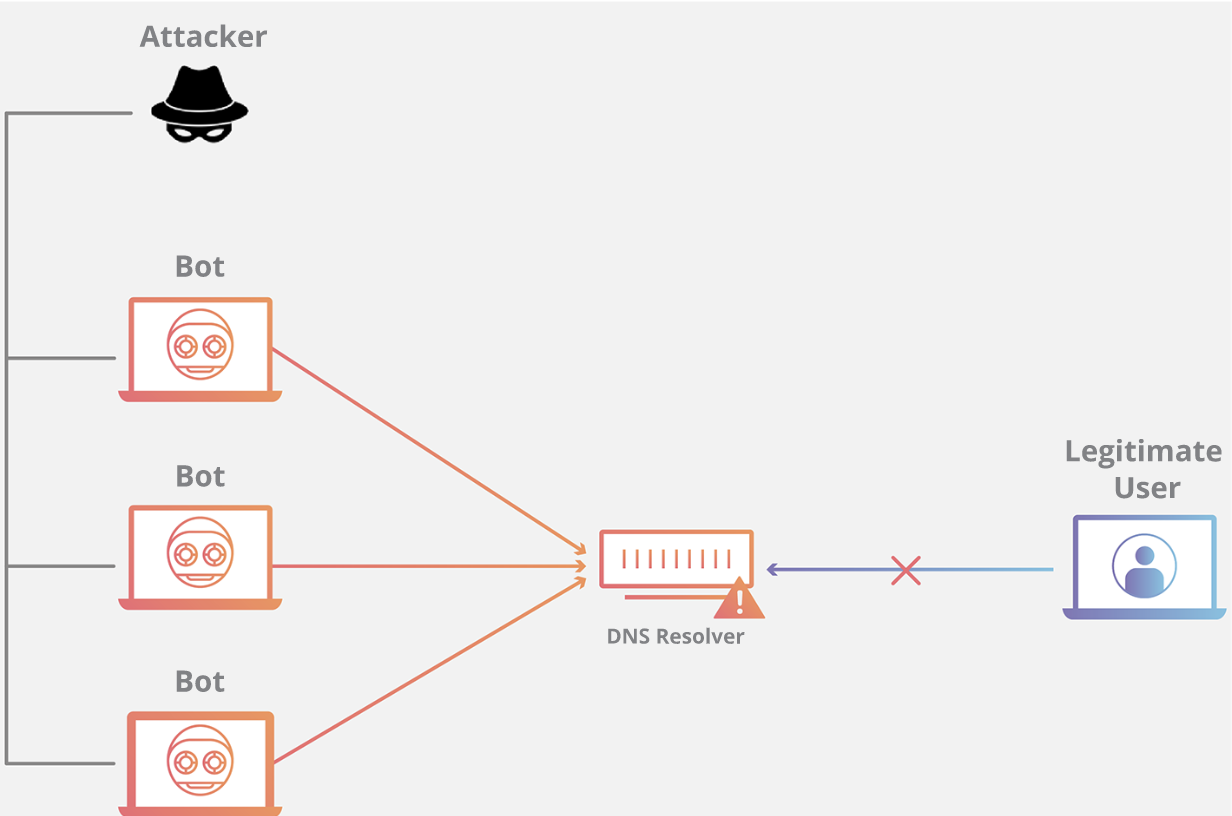

这篇文章的内容主要是介绍 TCP/IP常见攻击手段,尤其是 DDoS 攻击,也会补充一些其他的常见网络攻击手段。

|

||||

这篇文章的内容主要是介绍 TCP/IP 常见攻击手段,尤其是 DDoS 攻击,也会补充一些其他的常见网络攻击手段。

|

||||

|

||||

## IP 欺骗

|

||||

|

||||

@ -153,15 +153,15 @@ HTTP 洪水攻击有两种:

|

||||

|

||||

### DNS Flood 是什么?

|

||||

|

||||

域名系统(DNS)服务器是互联网的“电话簿“;互联网设备通过这些服务器来查找特定 Web 服务器以便访问互联网内容。DNS Flood攻击是一种分布式拒绝服务(DDoS)攻击,攻击者用大量流量淹没某个域的 DNS 服务器,以尝试中断该域的 DNS 解析。如果用户无法找到电话簿,就无法查找到用于调用特定资源的地址。通过中断 DNS 解析,DNS Flood攻击将破坏网站、API 或 Web 应用程序响应合法流量的能力。很难将 DNS Flood攻击与正常的大流量区分开来,因为这些大规模流量往往来自多个唯一地址,查询该域的真实记录,模仿合法流量。

|

||||

域名系统(DNS)服务器是互联网的“电话簿“;互联网设备通过这些服务器来查找特定 Web 服务器以便访问互联网内容。DNS Flood 攻击是一种分布式拒绝服务(DDoS)攻击,攻击者用大量流量淹没某个域的 DNS 服务器,以尝试中断该域的 DNS 解析。如果用户无法找到电话簿,就无法查找到用于调用特定资源的地址。通过中断 DNS 解析,DNS Flood 攻击将破坏网站、API 或 Web 应用程序响应合法流量的能力。很难将 DNS Flood 攻击与正常的大流量区分开来,因为这些大规模流量往往来自多个唯一地址,查询该域的真实记录,模仿合法流量。

|

||||

|

||||

### DNS Flood 的攻击原理是什么?

|

||||

|

||||

|

||||

|

||||

域名系统的功能是将易于记忆的名称(例如example.com)转换成难以记住的网站服务器地址(例如192.168.0.1),因此成功攻击 DNS 基础设施将导致大多数人无法使用互联网。DNS Flood攻击是一种相对较新的基于 DNS 的攻击,这种攻击是在高带宽[物联网(IoT)](https://www.cloudflare.com/learning/ddos/glossary/internet-of-things-iot/)[僵尸网络](https://www.cloudflare.com/learning/ddos/what-is-a-ddos-botnet/)(如 [Mirai](https://www.cloudflare.com/learning/ddos/glossary/mirai-botnet/))兴起后激增的。DNS Flood攻击使用 IP 摄像头、DVR 盒和其他 IoT 设备的高带宽连接直接淹没主要提供商的 DNS 服务器。来自 IoT 设备的大量请求淹没 DNS 提供商的服务,阻止合法用户访问提供商的 DNS 服务器。

|

||||

域名系统的功能是将易于记忆的名称(例如 example.com)转换成难以记住的网站服务器地址(例如 192.168.0.1),因此成功攻击 DNS 基础设施将导致大多数人无法使用互联网。DNS Flood 攻击是一种相对较新的基于 DNS 的攻击,这种攻击是在高带宽[物联网(IoT)](https://www.cloudflare.com/learning/ddos/glossary/internet-of-things-iot/)[僵尸网络](https://www.cloudflare.com/learning/ddos/what-is-a-ddos-botnet/)(如 [Mirai](https://www.cloudflare.com/learning/ddos/glossary/mirai-botnet/))兴起后激增的。DNS Flood 攻击使用 IP 摄像头、DVR 盒和其他 IoT 设备的高带宽连接直接淹没主要提供商的 DNS 服务器。来自 IoT 设备的大量请求淹没 DNS 提供商的服务,阻止合法用户访问提供商的 DNS 服务器。

|

||||

|

||||

DNS Flood攻击不同于 [DNS 放大攻击](https://www.cloudflare.com/zh-cn/learning/ddos/dns-amplification-ddos-attack/)。与 DNS Flood攻击不同,DNS 放大攻击反射并放大不安全 DNS 服务器的流量,以便隐藏攻击的源头并提高攻击的有效性。DNS 放大攻击使用连接带宽较小的设备向不安全的 DNS 服务器发送无数请求。这些设备对非常大的 DNS 记录发出小型请求,但在发出请求时,攻击者伪造返回地址为目标受害者。这种放大效果让攻击者能借助有限的攻击资源来破坏较大的目标。

|

||||

DNS Flood 攻击不同于 [DNS 放大攻击](https://www.cloudflare.com/zh-cn/learning/ddos/dns-amplification-ddos-attack/)。与 DNS Flood 攻击不同,DNS 放大攻击反射并放大不安全 DNS 服务器的流量,以便隐藏攻击的源头并提高攻击的有效性。DNS 放大攻击使用连接带宽较小的设备向不安全的 DNS 服务器发送无数请求。这些设备对非常大的 DNS 记录发出小型请求,但在发出请求时,攻击者伪造返回地址为目标受害者。这种放大效果让攻击者能借助有限的攻击资源来破坏较大的目标。

|

||||

|

||||

### 如何防护 DNS Flood?

|

||||

|

||||

|

||||

@ -1,5 +1,5 @@

|

||||

---

|

||||

title: OSI 和 TCP/IP 网络分层模型详解(基础)

|

||||

title: OSI 和 TCP/IP 网络分层模型详解(基础)

|

||||

category: 计算机基础

|

||||

tag:

|

||||

- 计算机网络

|

||||

|

||||

@ -132,40 +132,40 @@ HTTP 状态码用于描述 HTTP 请求的结果,比如 2xx 就代表请求被

|

||||

|

||||

### HTTP Header 中常见的字段有哪些?

|

||||

|

||||

| 请求头字段名 | 说明 | 示例 |

|

||||

| :------------------ | :----------------------------------------------------------- | :----------------------------------------------------------- |

|

||||

| Accept | 能够接受的回应内容类型(Content-Types)。 | Accept: text/plain |

|

||||

| Accept-Charset | 能够接受的字符集 | Accept-Charset: utf-8 |

|

||||

| Accept-Datetime | 能够接受的按照时间来表示的版本 | Accept-Datetime: Thu, 31 May 2007 20:35:00 GMT |

|

||||

| Accept-Encoding | 能够接受的编码方式列表。参考 HTTP 压缩。 | Accept-Encoding: gzip, deflate |

|

||||

| Accept-Language | 能够接受的回应内容的自然语言列表。 | Accept-Language: en-US |

|

||||

| Authorization | 用于超文本传输协议的认证的认证信息 | Authorization: Basic QWxhZGRpbjpvcGVuIHNlc2FtZQ== |

|

||||

| Cache-Control | 用来指定在这次的请求/响应链中的所有缓存机制 都必须 遵守的指令 | Cache-Control: no-cache |

|

||||

| Connection | 该浏览器想要优先使用的连接类型 | Connection: keep-alive Connection: Upgrade |

|

||||

| Content-Length | 以 八位字节数组 (8 位的字节)表示的请求体的长度 | Content-Length: 348 |

|

||||

| Content-MD5 | 请求体的内容的二进制 MD5 散列值,以 Base64 编码的结果 | Content-MD5: Q2hlY2sgSW50ZWdyaXR5IQ== |

|

||||

| Content-Type | 请求体的 多媒体类型 (用于 POST 和 PUT 请求中) | Content-Type: application/x-www-form-urlencoded |

|

||||

| Cookie | 之前由服务器通过 Set- Cookie (下文详述)发送的一个 超文本传输协议 Cookie | Cookie: \$Version=1; Skin=new; |

|

||||

| Date | 发送该消息的日期和时间(按照 RFC 7231 中定义的"超文本传输协议日期"格式来发送) | Date: Tue, 15 Nov 1994 08:12:31 GMT |

|

||||

| Expect | 表明客户端要求服务器做出特定的行为 | Expect: 100-continue |

|

||||

| From | 发起此请求的用户的邮件地址 | From: [user@example.com](mailto:user@example.com) |

|

||||

| Host | 服务器的域名(用于虚拟主机 ),以及服务器所监听的传输控制协议端口号。如果所请求的端口是对应的服务的标准端口,则端口号可被省略。 | Host: en.wikipedia.org:80 |

|

||||

| If-Match | 仅当客户端提供的实体与服务器上对应的实体相匹配时,才进行对应的操作。主要作用时,用作像 PUT 这样的方法中,仅当从用户上次更新某个资源以来,该资源未被修改的情况下,才更新该资源。 | If-Match: “737060cd8c284d8af7ad3082f209582d” |

|

||||

| If-Modified-Since | 允许在对应的内容未被修改的情况下返回 304 未修改( 304 Not Modified ) | If-Modified-Since: Sat, 29 Oct 1994 19:43:31 GMT |

|

||||

| If-None-Match | 允许在对应的内容未被修改的情况下返回 304 未修改( 304 Not Modified ) | If-None-Match: “737060cd8c284d8af7ad3082f209582d” |

|

||||

| If-Range | 如果该实体未被修改过,则向我发送我所缺少的那一个或多个部分;否则,发送整个新的实体 | If-Range: “737060cd8c284d8af7ad3082f209582d” |

|

||||

| If-Unmodified-Since | 仅当该实体自某个特定时间已来未被修改的情况下,才发送回应。 | If-Unmodified-Since: Sat, 29 Oct 1994 19:43:31 GMT |

|

||||

| Max-Forwards | 限制该消息可被代理及网关转发的次数。 | Max-Forwards: 10 |

|

||||

| Origin | 发起一个针对 跨来源资源共享 的请求。 | Origin: [http://www.example-social-network.com](http://www.example-social-network.com/) |

|

||||

| Pragma | 与具体的实现相关,这些字段可能在请求/回应链中的任何时候产生多种效果。 | Pragma: no-cache |

|

||||

| Proxy-Authorization | 用来向代理进行认证的认证信息。 | Proxy-Authorization: Basic QWxhZGRpbjpvcGVuIHNlc2FtZQ== |

|

||||

| Range | 仅请求某个实体的一部分。字节偏移以 0 开始。参见字节服务。 | Range: bytes=500-999 |

|

||||

| Referer | 表示浏览器所访问的前一个页面,正是那个页面上的某个链接将浏览器带到了当前所请求的这个页面。 | Referer: [http://en.wikipedia.org/wiki/Main_Page](https://en.wikipedia.org/wiki/Main_Page) |

|

||||

| TE | 浏览器预期接受的传输编码方式:可使用回应协议头 Transfer-Encoding 字段中的值; | TE: trailers, deflate |

|

||||

| Upgrade | 要求服务器升级到另一个协议。 | Upgrade: HTTP/2.0, SHTTP/1.3, IRC/6.9, RTA/x11 |

|

||||

| User-Agent | 浏览器的浏览器身份标识字符串 | User-Agent: Mozilla/5.0 (X11; Linux x86_64; rv:12.0) Gecko/20100101 Firefox/21.0 |

|

||||

| Via | 向服务器告知,这个请求是由哪些代理发出的。 | Via: 1.0 fred, 1.1 example.com (Apache/1.1) |

|

||||

| Warning | 一个一般性的警告,告知,在实体内容体中可能存在错误。 | Warning: 199 Miscellaneous warning |

|

||||

| 请求头字段名 | 说明 | 示例 |

|

||||

| :------------------ | :------------------------------------------------------------------------------------------------------------------------------------------------------------------------------ | :----------------------------------------------------------------------------------------- |

|

||||

| Accept | 能够接受的回应内容类型(Content-Types)。 | Accept: text/plain |

|

||||

| Accept-Charset | 能够接受的字符集 | Accept-Charset: utf-8 |

|

||||

| Accept-Datetime | 能够接受的按照时间来表示的版本 | Accept-Datetime: Thu, 31 May 2007 20:35:00 GMT |

|

||||

| Accept-Encoding | 能够接受的编码方式列表。参考 HTTP 压缩。 | Accept-Encoding: gzip, deflate |

|

||||

| Accept-Language | 能够接受的回应内容的自然语言列表。 | Accept-Language: en-US |

|

||||

| Authorization | 用于超文本传输协议的认证的认证信息 | Authorization: Basic QWxhZGRpbjpvcGVuIHNlc2FtZQ== |

|

||||

| Cache-Control | 用来指定在这次的请求/响应链中的所有缓存机制 都必须 遵守的指令 | Cache-Control: no-cache |

|

||||

| Connection | 该浏览器想要优先使用的连接类型 | Connection: keep-alive Connection: Upgrade |

|

||||

| Content-Length | 以 八位字节数组 (8 位的字节)表示的请求体的长度 | Content-Length: 348 |

|

||||

| Content-MD5 | 请求体的内容的二进制 MD5 散列值,以 Base64 编码的结果 | Content-MD5: Q2hlY2sgSW50ZWdyaXR5IQ== |

|

||||

| Content-Type | 请求体的 多媒体类型 (用于 POST 和 PUT 请求中) | Content-Type: application/x-www-form-urlencoded |

|

||||

| Cookie | 之前由服务器通过 Set- Cookie (下文详述)发送的一个 超文本传输协议 Cookie | Cookie: \$Version=1; Skin=new; |

|

||||

| Date | 发送该消息的日期和时间(按照 RFC 7231 中定义的"超文本传输协议日期"格式来发送) | Date: Tue, 15 Nov 1994 08:12:31 GMT |

|

||||

| Expect | 表明客户端要求服务器做出特定的行为 | Expect: 100-continue |

|

||||

| From | 发起此请求的用户的邮件地址 | From: [user@example.com](mailto:user@example.com) |

|

||||

| Host | 服务器的域名(用于虚拟主机 ),以及服务器所监听的传输控制协议端口号。如果所请求的端口是对应的服务的标准端口,则端口号可被省略。 | Host: en.wikipedia.org:80 |

|

||||

| If-Match | 仅当客户端提供的实体与服务器上对应的实体相匹配时,才进行对应的操作。主要作用时,用作像 PUT 这样的方法中,仅当从用户上次更新某个资源以来,该资源未被修改的情况下,才更新该资源。 | If-Match: “737060cd8c284d8af7ad3082f209582d” |

|

||||

| If-Modified-Since | 允许在对应的内容未被修改的情况下返回 304 未修改( 304 Not Modified ) | If-Modified-Since: Sat, 29 Oct 1994 19:43:31 GMT |

|

||||

| If-None-Match | 允许在对应的内容未被修改的情况下返回 304 未修改( 304 Not Modified ) | If-None-Match: “737060cd8c284d8af7ad3082f209582d” |

|

||||

| If-Range | 如果该实体未被修改过,则向我发送我所缺少的那一个或多个部分;否则,发送整个新的实体 | If-Range: “737060cd8c284d8af7ad3082f209582d” |

|

||||

| If-Unmodified-Since | 仅当该实体自某个特定时间已来未被修改的情况下,才发送回应。 | If-Unmodified-Since: Sat, 29 Oct 1994 19:43:31 GMT |

|

||||

| Max-Forwards | 限制该消息可被代理及网关转发的次数。 | Max-Forwards: 10 |

|

||||

| Origin | 发起一个针对 跨来源资源共享 的请求。 | Origin: [http://www.example-social-network.com](http://www.example-social-network.com/) |

|

||||

| Pragma | 与具体的实现相关,这些字段可能在请求/回应链中的任何时候产生多种效果。 | Pragma: no-cache |

|

||||

| Proxy-Authorization | 用来向代理进行认证的认证信息。 | Proxy-Authorization: Basic QWxhZGRpbjpvcGVuIHNlc2FtZQ== |

|

||||

| Range | 仅请求某个实体的一部分。字节偏移以 0 开始。参见字节服务。 | Range: bytes=500-999 |

|

||||

| Referer | 表示浏览器所访问的前一个页面,正是那个页面上的某个链接将浏览器带到了当前所请求的这个页面。 | Referer: [http://en.wikipedia.org/wiki/Main_Page](https://en.wikipedia.org/wiki/Main_Page) |

|

||||

| TE | 浏览器预期接受的传输编码方式:可使用回应协议头 Transfer-Encoding 字段中的值; | TE: trailers, deflate |

|

||||

| Upgrade | 要求服务器升级到另一个协议。 | Upgrade: HTTP/2.0, SHTTP/1.3, IRC/6.9, RTA/x11 |

|

||||

| User-Agent | 浏览器的浏览器身份标识字符串 | User-Agent: Mozilla/5.0 (X11; Linux x86_64; rv:12.0) Gecko/20100101 Firefox/21.0 |

|

||||

| Via | 向服务器告知,这个请求是由哪些代理发出的。 | Via: 1.0 fred, 1.1 example.com (Apache/1.1) |

|

||||

| Warning | 一个一般性的警告,告知,在实体内容体中可能存在错误。 | Warning: 199 Miscellaneous warning |

|

||||

|

||||

### HTTP 和 HTTPS 有什么区别?(重要)

|

||||

|

||||

|

||||

@ -96,21 +96,19 @@ tag:

|

||||

|

||||

每个连入互联网的设备或域(如计算机、服务器、路由器等)都被分配一个 **IP 地址(Internet Protocol address)**,作为唯一标识符。每个 IP 地址都是一个字符序列,如 192.168.1.1(IPv4)、2001:0db8:85a3:0000:0000:8a2e:0370:7334(IPv6) 。

|

||||

|

||||

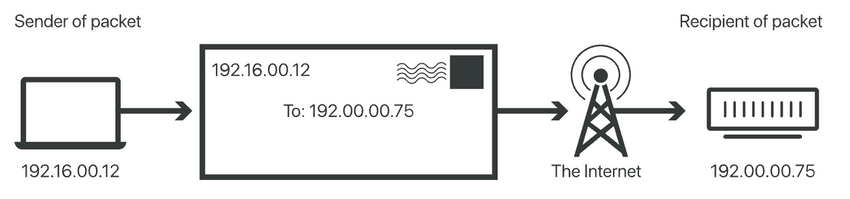

当网络设备发送IP数据包时,数据包中包含了 **源IP地址** 和 **目的IP地址** 。源IP地址用于标识数据包的发送方设备或域,而目的IP地址则用于标识数据包的接收方设备或域。这类似于一封邮件中同时包含了目的地地址和回邮地址。

|

||||

当网络设备发送 IP 数据包时,数据包中包含了 **源 IP 地址** 和 **目的 IP 地址** 。源 IP 地址用于标识数据包的发送方设备或域,而目的 IP 地址则用于标识数据包的接收方设备或域。这类似于一封邮件中同时包含了目的地地址和回邮地址。

|

||||

|

||||

网络设备根据目的IP地址来判断数据包的目的地,并将数据包转发到正确的目的地网络或子网络,从而实现了设备间的通信。

|

||||

网络设备根据目的 IP 地址来判断数据包的目的地,并将数据包转发到正确的目的地网络或子网络,从而实现了设备间的通信。

|

||||

|

||||

这种基于IP地址的寻址方式是互联网通信的基础,它允许数据包在不同的网络之间传递,从而实现了全球范围内的网络互联互通。IP地址的唯一性和全局性保证了网络中的每个设备都可以通过其独特的IP地址进行标识和寻址。

|

||||

这种基于 IP 地址的寻址方式是互联网通信的基础,它允许数据包在不同的网络之间传递,从而实现了全球范围内的网络互联互通。IP 地址的唯一性和全局性保证了网络中的每个设备都可以通过其独特的 IP 地址进行标识和寻址。

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

### 什么是 IP 地址过滤?

|

||||

|

||||

**IP 地址过滤(IP Address Filtering)** 简单来说就是限制或阻止特定IP地址或IP地址范围的访问。例如,你有一个图片服务突然被某一个 IP 地址攻击,那我们就可以禁止这个 IP 地址访问图片服务。

|

||||

**IP 地址过滤(IP Address Filtering)** 简单来说就是限制或阻止特定 IP 地址或 IP 地址范围的访问。例如,你有一个图片服务突然被某一个 IP 地址攻击,那我们就可以禁止这个 IP 地址访问图片服务。

|

||||

|

||||

IP地址过滤是一种简单的网络安全措施,实际应用中一般会结合其他网络安全措施,如认证、授权、加密等一起使用。单独使用 IP地址过滤并不能完全保证网络的安全。

|

||||