mirror of

https://github.com/Snailclimb/JavaGuide

synced 2025-08-01 16:28:03 +08:00

commit

ee60e5e42b

34

.gitignore

vendored

Normal file

34

.gitignore

vendored

Normal file

@ -0,0 +1,34 @@

|

|||||||

|

.gradle

|

||||||

|

/build/

|

||||||

|

/**/build/

|

||||||

|

|

||||||

|

### STS ###

|

||||||

|

.apt_generated

|

||||||

|

.classpath

|

||||||

|

.factorypath

|

||||||

|

.project

|

||||||

|

.settings

|

||||||

|

.springBeans

|

||||||

|

.sts4-cache

|

||||||

|

|

||||||

|

### IntelliJ IDEA ###

|

||||||

|

.idea

|

||||||

|

*.iws

|

||||||

|

*.iml

|

||||||

|

*.ipr

|

||||||

|

/out/

|

||||||

|

/**/out/

|

||||||

|

.shelf/

|

||||||

|

.ideaDataSources/

|

||||||

|

dataSources/

|

||||||

|

|

||||||

|

### NetBeans ###

|

||||||

|

/nbproject/private/

|

||||||

|

/nbbuild/

|

||||||

|

/dist/

|

||||||

|

/nbdist/

|

||||||

|

/.nb-gradle/

|

||||||

|

/node_modules/

|

||||||

|

|

||||||

|

### OS ###

|

||||||

|

.DS_Store

|

||||||

236

HomePage.md

Normal file

236

HomePage.md

Normal file

@ -0,0 +1,236 @@

|

|||||||

|

点击订阅[Java面试进阶指南](https://xiaozhuanlan.com/javainterview?rel=javaguide)(专为Java面试方向准备)。[为什么要弄这个专栏?](https://shimo.im/./9BJjNsNg7S4dCnz3/)

|

||||||

|

|

||||||

|

<h1 align="center">Java 学习/面试指南</h1>

|

||||||

|

<p align="center">

|

||||||

|

<a href="https://github.com/Snailclimb/JavaGuide" target="_blank">

|

||||||

|

<img src="https://my-blog-to-use.oss-cn-beijing.aliyuncs.com/2019-3/logo - 副本.png" width=""/>

|

||||||

|

</a>

|

||||||

|

|

||||||

|

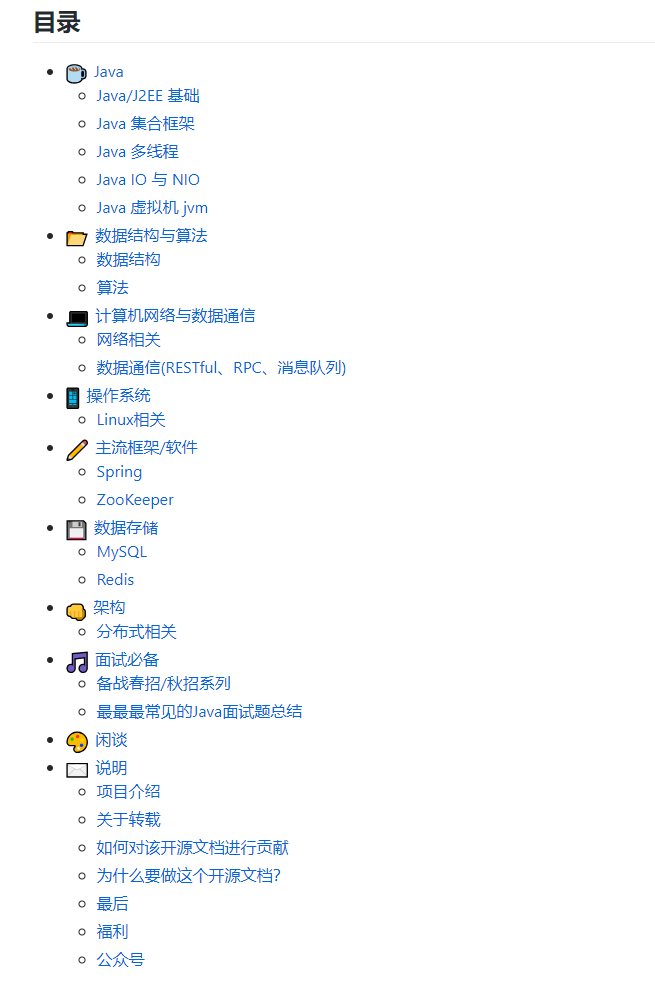

## 目录

|

||||||

|

|

||||||

|

- [Java](#java)

|

||||||

|

- [基础](#基础)

|

||||||

|

- [容器](#容器)

|

||||||

|

- [并发](#并发)

|

||||||

|

- [JVM](#jvm)

|

||||||

|

- [I/O](#io)

|

||||||

|

- [Java 8](#java-8)

|

||||||

|

- [编程规范](#编程规范)

|

||||||

|

- [网络](#网络)

|

||||||

|

- [操作系统](#操作系统)

|

||||||

|

- [Linux相关](#linux相关)

|

||||||

|

- [数据结构与算法](#数据结构与算法)

|

||||||

|

- [数据结构](#数据结构)

|

||||||

|

- [算法](#算法)

|

||||||

|

- [数据库](#数据库)

|

||||||

|

- [MySQL](#mysql)

|

||||||

|

- [Redis](#redis)

|

||||||

|

- [系统设计](#系统设计)

|

||||||

|

- [设计模式(工厂模式、单例模式 ... )](#设计模式)

|

||||||

|

- [常用框架(Spring、Zookeeper ... )](#常用框架)

|

||||||

|

- [数据通信(消息队列、Dubbo ... )](#数据通信)

|

||||||

|

- [网站架构](#网站架构)

|

||||||

|

- [面试指南](#面试指南)

|

||||||

|

- [备战面试](#备战面试)

|

||||||

|

- [常见面试题总结](#常见面试题总结)

|

||||||

|

- [面经](#面经)

|

||||||

|

- [工具](#工具)

|

||||||

|

- [Git](#git)

|

||||||

|

- [Docker](#Docker)

|

||||||

|

- [资料](#资料)

|

||||||

|

- [书单](#书单)

|

||||||

|

- [Github榜单](#Github榜单)

|

||||||

|

- [待办](#待办)

|

||||||

|

- [说明](#说明)

|

||||||

|

|

||||||

|

## Java

|

||||||

|

|

||||||

|

### 基础

|

||||||

|

|

||||||

|

* [Java 基础知识回顾](java/Java基础知识.md)

|

||||||

|

* [Java 基础知识疑难点总结](java/Java疑难点.md)

|

||||||

|

* [J2EE 基础知识回顾](java/J2EE基础知识.md)

|

||||||

|

|

||||||

|

### 容器

|

||||||

|

|

||||||

|

* [Java容器常见面试题/知识点总结](java/collection/Java集合框架常见面试题.md)

|

||||||

|

* [ArrayList 源码学习](java/collection/ArrayList.md)

|

||||||

|

* [LinkedList 源码学习](java/collection/LinkedList.md)

|

||||||

|

* [HashMap(JDK1.8)源码学习](java/collection/HashMap.md)

|

||||||

|

|

||||||

|

### 并发

|

||||||

|

|

||||||

|

* [Java 并发基础常见面试题总结](java/Multithread/JavaConcurrencyBasicsCommonInterviewQuestionsSummary.md)

|

||||||

|

* [Java 并发进阶常见面试题总结](java/Multithread/JavaConcurrencyAdvancedCommonInterviewQuestions.md)

|

||||||

|

* [并发容器总结](java/Multithread/并发容器总结.md)

|

||||||

|

* [乐观锁与悲观锁](essential-content-for-interview/面试必备之乐观锁与悲观锁.md)

|

||||||

|

* [JUC 中的 Atomic 原子类总结](java/Multithread/Atomic.md)

|

||||||

|

* [AQS 原理以及 AQS 同步组件总结](java/Multithread/AQS.md)

|

||||||

|

|

||||||

|

### JVM

|

||||||

|

* [一 Java内存区域](java/jvm/Java内存区域.md)

|

||||||

|

* [二 JVM垃圾回收](java/jvm/JVM垃圾回收.md)

|

||||||

|

* [三 JDK 监控和故障处理工具](java/jvm/JDK监控和故障处理工具总结.md)

|

||||||

|

* [四 类文件结构](java/jvm/类文件结构.md)

|

||||||

|

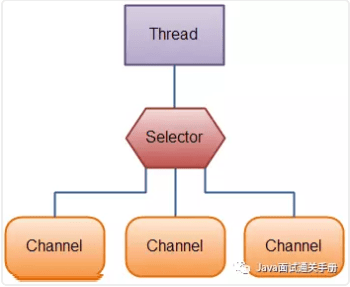

* [五 类加载过程](java/jvm/类加载过程.md)

|

||||||

|

* [六 类加载器](java/jvm/类加载器.md)

|

||||||

|

|

||||||

|

### I/O

|

||||||

|

|

||||||

|

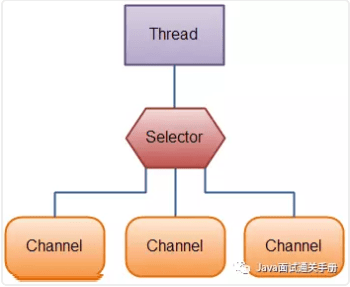

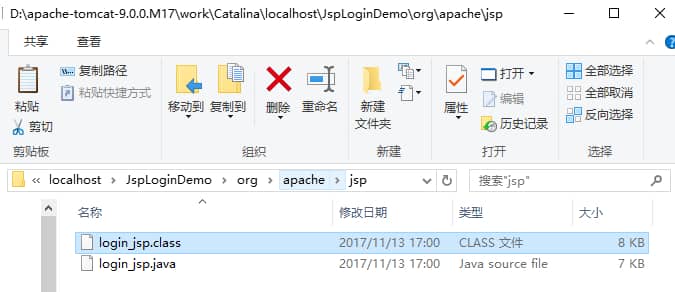

* [BIO,NIO,AIO 总结 ](java/BIO-NIO-AIO.md)

|

||||||

|

* [Java IO 与 NIO系列文章](java/Java%20IO与NIO.md)

|

||||||

|

|

||||||

|

### Java 8

|

||||||

|

|

||||||

|

* [Java 8 新特性总结](java/What's%20New%20in%20JDK8/Java8Tutorial.md)

|

||||||

|

* [Java 8 学习资源推荐](java/What's%20New%20in%20JDK8/Java8教程推荐.md)

|

||||||

|

|

||||||

|

### 编程规范

|

||||||

|

|

||||||

|

- [Java 编程规范](java/Java编程规范.md)

|

||||||

|

|

||||||

|

## 网络

|

||||||

|

|

||||||

|

* [计算机网络常见面试题](network/计算机网络.md)

|

||||||

|

* [计算机网络基础知识总结](network/干货:计算机网络知识总结.md)

|

||||||

|

* [HTTPS中的TLS](network/HTTPS中的TLS.md)

|

||||||

|

|

||||||

|

## 操作系统

|

||||||

|

|

||||||

|

### Linux相关

|

||||||

|

|

||||||

|

* [后端程序员必备的 Linux 基础知识](operating-system/后端程序员必备的Linux基础知识.md)

|

||||||

|

* [Shell 编程入门](operating-system/Shell.md)

|

||||||

|

|

||||||

|

## 数据结构与算法

|

||||||

|

|

||||||

|

### 数据结构

|

||||||

|

|

||||||

|

- [数据结构知识学习与面试](dataStructures-algorithms/数据结构.md)

|

||||||

|

|

||||||

|

### 算法

|

||||||

|

|

||||||

|

- [算法学习资源推荐](dataStructures-algorithms/算法学习资源推荐.md)

|

||||||

|

- [几道常见的字符串算法题总结 ](dataStructures-algorithms/几道常见的子符串算法题.md)

|

||||||

|

- [几道常见的链表算法题总结 ](dataStructures-algorithms/几道常见的链表算法题.md)

|

||||||

|

- [剑指offer部分编程题](dataStructures-algorithms/剑指offer部分编程题.md)

|

||||||

|

- [公司真题](dataStructures-algorithms/公司真题.md)

|

||||||

|

- [回溯算法经典案例之N皇后问题](dataStructures-algorithms/Backtracking-NQueens.md)

|

||||||

|

|

||||||

|

## 数据库

|

||||||

|

|

||||||

|

### MySQL

|

||||||

|

|

||||||

|

* [MySQL 学习与面试](database/MySQL.md)

|

||||||

|

* [一千行MySQL学习笔记](database/一千行MySQL命令.md)

|

||||||

|

* [MySQL高性能优化规范建议](database/MySQL高性能优化规范建议.md)

|

||||||

|

* [数据库索引总结](database/MySQL%20Index.md)

|

||||||

|

* [事务隔离级别(图文详解)](database/事务隔离级别(图文详解).md)

|

||||||

|

* [一条SQL语句在MySQL中如何执行的](database/一条sql语句在mysql中如何执行的.md)

|

||||||

|

|

||||||

|

### Redis

|

||||||

|

|

||||||

|

* [Redis 总结](database/Redis/Redis.md)

|

||||||

|

* [Redlock分布式锁](database/Redis/Redlock分布式锁.md)

|

||||||

|

* [如何做可靠的分布式锁,Redlock真的可行么](database/Redis/如何做可靠的分布式锁,Redlock真的可行么.md)

|

||||||

|

|

||||||

|

## 系统设计

|

||||||

|

|

||||||

|

### 设计模式

|

||||||

|

|

||||||

|

- [设计模式系列文章](system-design/设计模式.md)

|

||||||

|

|

||||||

|

### 常用框架

|

||||||

|

|

||||||

|

#### Spring

|

||||||

|

|

||||||

|

- [Spring 学习与面试](system-design/framework/spring/Spring.md)

|

||||||

|

- [Spring 常见问题总结](system-design/framework/spring/SpringInterviewQuestions.md)

|

||||||

|

- [Spring中bean的作用域与生命周期](system-design/framework/spring/SpringBean.md)

|

||||||

|

- [SpringMVC 工作原理详解](system-design/framework/spring/SpringMVC-Principle.md)

|

||||||

|

- [Spring中都用到了那些设计模式?](system-design/framework/spring/Spring-Design-Patterns.md)

|

||||||

|

|

||||||

|

#### ZooKeeper

|

||||||

|

|

||||||

|

- [ZooKeeper 相关概念总结](system-design/framework/ZooKeeper.md)

|

||||||

|

- [ZooKeeper 数据模型和常见命令](system-design/framework/ZooKeeper数据模型和常见命令.md)

|

||||||

|

|

||||||

|

### 数据通信

|

||||||

|

|

||||||

|

- [数据通信(RESTful、RPC、消息队列)相关知识点总结](system-design/data-communication/summary.md)

|

||||||

|

- [Dubbo 总结:关于 Dubbo 的重要知识点](system-design/data-communication/dubbo.md)

|

||||||

|

- [消息队列总结](system-design/data-communication/message-queue.md)

|

||||||

|

- [RabbitMQ 入门](system-design/data-communication/rabbitmq.md)

|

||||||

|

- [RocketMQ的几个简单问题与答案](system-design/data-communication/RocketMQ-Questions.md)

|

||||||

|

|

||||||

|

### 网站架构

|

||||||

|

|

||||||

|

- [一文读懂分布式应该学什么](system-design/website-architecture/分布式.md)

|

||||||

|

- [8 张图读懂大型网站技术架构](system-design/website-architecture/8%20张图读懂大型网站技术架构.md)

|

||||||

|

- [【面试精选】关于大型网站系统架构你不得不懂的10个问题](system-design/website-architecture/【面试精选】关于大型网站系统架构你不得不懂的10个问题.md)

|

||||||

|

|

||||||

|

## 面试指南

|

||||||

|

|

||||||

|

### 备战面试

|

||||||

|

|

||||||

|

* [【备战面试1】程序员的简历就该这样写](essential-content-for-interview/PreparingForInterview/程序员的简历之道.md)

|

||||||

|

* [【备战面试2】初出茅庐的程序员该如何准备面试?](essential-content-for-interview/PreparingForInterview/interviewPrepare.md)

|

||||||

|

* [【备战面试3】7个大部分程序员在面试前很关心的问题](essential-content-for-interview/PreparingForInterview/JavaProgrammerNeedKnow.md)

|

||||||

|

* [【备战面试4】Github上开源的Java面试/学习相关的仓库推荐](essential-content-for-interview/PreparingForInterview/JavaInterviewLibrary.md)

|

||||||

|

* [【备战面试5】如果面试官问你“你有什么问题问我吗?”时,你该如何回答](essential-content-for-interview/PreparingForInterview/如果面试官问你“你有什么问题问我吗?”时,你该如何回答.md)

|

||||||

|

* [【备战面试6】美团面试常见问题总结(附详解答案)](essential-content-for-interview/PreparingForInterview/美团面试常见问题总结.md)

|

||||||

|

|

||||||

|

### 常见面试题总结

|

||||||

|

|

||||||

|

* [第一周(2018-8-7)](essential-content-for-interview/MostCommonJavaInterviewQuestions/第一周(2018-8-7).md) (为什么 Java 中只有值传递、==与equals、 hashCode与equals)

|

||||||

|

* [第二周(2018-8-13)](essential-content-for-interview/MostCommonJavaInterviewQuestions/第二周(2018-8-13).md)(String和StringBuffer、StringBuilder的区别是什么?String为什么是不可变的?、什么是反射机制?反射机制的应用场景有哪些?......)

|

||||||

|

* [第三周(2018-08-22)](java/collection/Java集合框架常见面试题.md) (Arraylist 与 LinkedList 异同、ArrayList 与 Vector 区别、HashMap的底层实现、HashMap 和 Hashtable 的区别、HashMap 的长度为什么是2的幂次方、HashSet 和 HashMap 区别、ConcurrentHashMap 和 Hashtable 的区别、ConcurrentHashMap线程安全的具体实现方式/底层具体实现、集合框架底层数据结构总结)

|

||||||

|

* [第四周(2018-8-30).md](essential-content-for-interview/MostCommonJavaInterviewQuestions/第四周(2018-8-30).md) (主要内容是几道面试常问的多线程基础题。)

|

||||||

|

|

||||||

|

### 面经

|

||||||

|

|

||||||

|

- [5面阿里,终获offer(2018年秋招)](essential-content-for-interview/BATJrealInterviewExperience/5面阿里,终获offer.md)

|

||||||

|

- [蚂蚁金服2019实习生面经总结(已拿口头offer)](essential-content-for-interview/BATJrealInterviewExperience/蚂蚁金服实习生面经总结(已拿口头offer).md)

|

||||||

|

- [2019年蚂蚁金服、头条、拼多多的面试总结](essential-content-for-interview/BATJrealInterviewExperience/2019alipay-pinduoduo-toutiao.md)

|

||||||

|

|

||||||

|

## 工具

|

||||||

|

|

||||||

|

### Git

|

||||||

|

|

||||||

|

* [Git入门](tools/Git.md)

|

||||||

|

|

||||||

|

### Docker

|

||||||

|

|

||||||

|

* [Docker 入门](tools/Docker.md)

|

||||||

|

* [一文搞懂 Docker 镜像的常用操作!](tools/Docker-Image.md)

|

||||||

|

|

||||||

|

## 资料

|

||||||

|

|

||||||

|

### 书单

|

||||||

|

|

||||||

|

- [Java程序员必备书单](data/java-recommended-books.md)

|

||||||

|

|

||||||

|

### Github榜单

|

||||||

|

|

||||||

|

- [Java 项目月榜单](github-trending/JavaGithubTrending.md)

|

||||||

|

|

||||||

|

***

|

||||||

|

|

||||||

|

## 待办

|

||||||

|

|

||||||

|

- [x] [Java 8 新特性总结](./java/What's%20New%20in%20JDK8/Java8Tutorial.md)

|

||||||

|

- [x] [Java 8 新特性详解](./java/What's%20New%20in%20JDK8/Java8教程推荐.md)

|

||||||

|

- [ ] Java 多线程类别知识重构(---正在进行中---)

|

||||||

|

- [x] [BIO,NIO,AIO 总结 ](./java/BIO-NIO-AIO.md)

|

||||||

|

- [ ] Netty 总结(---正在进行中---)

|

||||||

|

- [ ] 数据结构总结重构(---正在进行中---)

|

||||||

|

|

||||||

|

## 公众号

|

||||||

|

|

||||||

|

- 如果大家想要实时关注我更新的文章以及分享的干货的话,可以关注我的公众号。

|

||||||

|

- 由本文档衍生的专为面试而生的《Java面试突击》V2.0 PDF 版本公众号后台回复 **"Java面试突击"** 即可免费领取!

|

||||||

|

- 一些Java工程师常用学习资源公众号后台回复关键字 **“1”** 即可免费无套路获取。

|

||||||

|

|

||||||

|

<p align="center">

|

||||||

|

<img src="https://user-gold-cdn.xitu.io/2018/11/28/167598cd2e17b8ec?w=258&h=258&f=jpeg&s=27334" width=""/>

|

||||||

|

</p>

|

||||||

201

LICENSE

Normal file

201

LICENSE

Normal file

@ -0,0 +1,201 @@

|

|||||||

|

Apache License

|

||||||

|

Version 2.0, January 2004

|

||||||

|

http://www.apache.org/licenses/

|

||||||

|

|

||||||

|

TERMS AND CONDITIONS FOR USE, REPRODUCTION, AND DISTRIBUTION

|

||||||

|

|

||||||

|

1. Definitions.

|

||||||

|

|

||||||

|

"License" shall mean the terms and conditions for use, reproduction,

|

||||||

|

and distribution as defined by Sections 1 through 9 of this document.

|

||||||

|

|

||||||

|

"Licensor" shall mean the copyright owner or entity authorized by

|

||||||

|

the copyright owner that is granting the License.

|

||||||

|

|

||||||

|

"Legal Entity" shall mean the union of the acting entity and all

|

||||||

|

other entities that control, are controlled by, or are under common

|

||||||

|

control with that entity. For the purposes of this definition,

|

||||||

|

"control" means (i) the power, direct or indirect, to cause the

|

||||||

|

direction or management of such entity, whether by contract or

|

||||||

|

otherwise, or (ii) ownership of fifty percent (50%) or more of the

|

||||||

|

outstanding shares, or (iii) beneficial ownership of such entity.

|

||||||

|

|

||||||

|

"You" (or "Your") shall mean an individual or Legal Entity

|

||||||

|

exercising permissions granted by this License.

|

||||||

|

|

||||||

|

"Source" form shall mean the preferred form for making modifications,

|

||||||

|

including but not limited to software source code, documentation

|

||||||

|

source, and configuration files.

|

||||||

|

|

||||||

|

"Object" form shall mean any form resulting from mechanical

|

||||||

|

transformation or translation of a Source form, including but

|

||||||

|

not limited to compiled object code, generated documentation,

|

||||||

|

and conversions to other media types.

|

||||||

|

|

||||||

|

"Work" shall mean the work of authorship, whether in Source or

|

||||||

|

Object form, made available under the License, as indicated by a

|

||||||

|

copyright notice that is included in or attached to the work

|

||||||

|

(an example is provided in the Appendix below).

|

||||||

|

|

||||||

|

"Derivative Works" shall mean any work, whether in Source or Object

|

||||||

|

form, that is based on (or derived from) the Work and for which the

|

||||||

|

editorial revisions, annotations, elaborations, or other modifications

|

||||||

|

represent, as a whole, an original work of authorship. For the purposes

|

||||||

|

of this License, Derivative Works shall not include works that remain

|

||||||

|

separable from, or merely link (or bind by name) to the interfaces of,

|

||||||

|

the Work and Derivative Works thereof.

|

||||||

|

|

||||||

|

"Contribution" shall mean any work of authorship, including

|

||||||

|

the original version of the Work and any modifications or additions

|

||||||

|

to that Work or Derivative Works thereof, that is intentionally

|

||||||

|

submitted to Licensor for inclusion in the Work by the copyright owner

|

||||||

|

or by an individual or Legal Entity authorized to submit on behalf of

|

||||||

|

the copyright owner. For the purposes of this definition, "submitted"

|

||||||

|

means any form of electronic, verbal, or written communication sent

|

||||||

|

to the Licensor or its representatives, including but not limited to

|

||||||

|

communication on electronic mailing lists, source code control systems,

|

||||||

|

and issue tracking systems that are managed by, or on behalf of, the

|

||||||

|

Licensor for the purpose of discussing and improving the Work, but

|

||||||

|

excluding communication that is conspicuously marked or otherwise

|

||||||

|

designated in writing by the copyright owner as "Not a Contribution."

|

||||||

|

|

||||||

|

"Contributor" shall mean Licensor and any individual or Legal Entity

|

||||||

|

on behalf of whom a Contribution has been received by Licensor and

|

||||||

|

subsequently incorporated within the Work.

|

||||||

|

|

||||||

|

2. Grant of Copyright License. Subject to the terms and conditions of

|

||||||

|

this License, each Contributor hereby grants to You a perpetual,

|

||||||

|

worldwide, non-exclusive, no-charge, royalty-free, irrevocable

|

||||||

|

copyright license to reproduce, prepare Derivative Works of,

|

||||||

|

publicly display, publicly perform, sublicense, and distribute the

|

||||||

|

Work and such Derivative Works in Source or Object form.

|

||||||

|

|

||||||

|

3. Grant of Patent License. Subject to the terms and conditions of

|

||||||

|

this License, each Contributor hereby grants to You a perpetual,

|

||||||

|

worldwide, non-exclusive, no-charge, royalty-free, irrevocable

|

||||||

|

(except as stated in this section) patent license to make, have made,

|

||||||

|

use, offer to sell, sell, import, and otherwise transfer the Work,

|

||||||

|

where such license applies only to those patent claims licensable

|

||||||

|

by such Contributor that are necessarily infringed by their

|

||||||

|

Contribution(s) alone or by combination of their Contribution(s)

|

||||||

|

with the Work to which such Contribution(s) was submitted. If You

|

||||||

|

institute patent litigation against any entity (including a

|

||||||

|

cross-claim or counterclaim in a lawsuit) alleging that the Work

|

||||||

|

or a Contribution incorporated within the Work constitutes direct

|

||||||

|

or contributory patent infringement, then any patent licenses

|

||||||

|

granted to You under this License for that Work shall terminate

|

||||||

|

as of the date such litigation is filed.

|

||||||

|

|

||||||

|

4. Redistribution. You may reproduce and distribute copies of the

|

||||||

|

Work or Derivative Works thereof in any medium, with or without

|

||||||

|

modifications, and in Source or Object form, provided that You

|

||||||

|

meet the following conditions:

|

||||||

|

|

||||||

|

(a) You must give any other recipients of the Work or

|

||||||

|

Derivative Works a copy of this License; and

|

||||||

|

|

||||||

|

(b) You must cause any modified files to carry prominent notices

|

||||||

|

stating that You changed the files; and

|

||||||

|

|

||||||

|

(c) You must retain, in the Source form of any Derivative Works

|

||||||

|

that You distribute, all copyright, patent, trademark, and

|

||||||

|

attribution notices from the Source form of the Work,

|

||||||

|

excluding those notices that do not pertain to any part of

|

||||||

|

the Derivative Works; and

|

||||||

|

|

||||||

|

(d) If the Work includes a "NOTICE" text file as part of its

|

||||||

|

distribution, then any Derivative Works that You distribute must

|

||||||

|

include a readable copy of the attribution notices contained

|

||||||

|

within such NOTICE file, excluding those notices that do not

|

||||||

|

pertain to any part of the Derivative Works, in at least one

|

||||||

|

of the following places: within a NOTICE text file distributed

|

||||||

|

as part of the Derivative Works; within the Source form or

|

||||||

|

documentation, if provided along with the Derivative Works; or,

|

||||||

|

within a display generated by the Derivative Works, if and

|

||||||

|

wherever such third-party notices normally appear. The contents

|

||||||

|

of the NOTICE file are for informational purposes only and

|

||||||

|

do not modify the License. You may add Your own attribution

|

||||||

|

notices within Derivative Works that You distribute, alongside

|

||||||

|

or as an addendum to the NOTICE text from the Work, provided

|

||||||

|

that such additional attribution notices cannot be construed

|

||||||

|

as modifying the License.

|

||||||

|

|

||||||

|

You may add Your own copyright statement to Your modifications and

|

||||||

|

may provide additional or different license terms and conditions

|

||||||

|

for use, reproduction, or distribution of Your modifications, or

|

||||||

|

for any such Derivative Works as a whole, provided Your use,

|

||||||

|

reproduction, and distribution of the Work otherwise complies with

|

||||||

|

the conditions stated in this License.

|

||||||

|

|

||||||

|

5. Submission of Contributions. Unless You explicitly state otherwise,

|

||||||

|

any Contribution intentionally submitted for inclusion in the Work

|

||||||

|

by You to the Licensor shall be under the terms and conditions of

|

||||||

|

this License, without any additional terms or conditions.

|

||||||

|

Notwithstanding the above, nothing herein shall supersede or modify

|

||||||

|

the terms of any separate license agreement you may have executed

|

||||||

|

with Licensor regarding such Contributions.

|

||||||

|

|

||||||

|

6. Trademarks. This License does not grant permission to use the trade

|

||||||

|

names, trademarks, service marks, or product names of the Licensor,

|

||||||

|

except as required for reasonable and customary use in describing the

|

||||||

|

origin of the Work and reproducing the content of the NOTICE file.

|

||||||

|

|

||||||

|

7. Disclaimer of Warranty. Unless required by applicable law or

|

||||||

|

agreed to in writing, Licensor provides the Work (and each

|

||||||

|

Contributor provides its Contributions) on an "AS IS" BASIS,

|

||||||

|

WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or

|

||||||

|

implied, including, without limitation, any warranties or conditions

|

||||||

|

of TITLE, NON-INFRINGEMENT, MERCHANTABILITY, or FITNESS FOR A

|

||||||

|

PARTICULAR PURPOSE. You are solely responsible for determining the

|

||||||

|

appropriateness of using or redistributing the Work and assume any

|

||||||

|

risks associated with Your exercise of permissions under this License.

|

||||||

|

|

||||||

|

8. Limitation of Liability. In no event and under no legal theory,

|

||||||

|

whether in tort (including negligence), contract, or otherwise,

|

||||||

|

unless required by applicable law (such as deliberate and grossly

|

||||||

|

negligent acts) or agreed to in writing, shall any Contributor be

|

||||||

|

liable to You for damages, including any direct, indirect, special,

|

||||||

|

incidental, or consequential damages of any character arising as a

|

||||||

|

result of this License or out of the use or inability to use the

|

||||||

|

Work (including but not limited to damages for loss of goodwill,

|

||||||

|

work stoppage, computer failure or malfunction, or any and all

|

||||||

|

other commercial damages or losses), even if such Contributor

|

||||||

|

has been advised of the possibility of such damages.

|

||||||

|

|

||||||

|

9. Accepting Warranty or Additional Liability. While redistributing

|

||||||

|

the Work or Derivative Works thereof, You may choose to offer,

|

||||||

|

and charge a fee for, acceptance of support, warranty, indemnity,

|

||||||

|

or other liability obligations and/or rights consistent with this

|

||||||

|

License. However, in accepting such obligations, You may act only

|

||||||

|

on Your own behalf and on Your sole responsibility, not on behalf

|

||||||

|

of any other Contributor, and only if You agree to indemnify,

|

||||||

|

defend, and hold each Contributor harmless for any liability

|

||||||

|

incurred by, or claims asserted against, such Contributor by reason

|

||||||

|

of your accepting any such warranty or additional liability.

|

||||||

|

|

||||||

|

END OF TERMS AND CONDITIONS

|

||||||

|

|

||||||

|

APPENDIX: How to apply the Apache License to your work.

|

||||||

|

|

||||||

|

To apply the Apache License to your work, attach the following

|

||||||

|

boilerplate notice, with the fields enclosed by brackets "[]"

|

||||||

|

replaced with your own identifying information. (Don't include

|

||||||

|

the brackets!) The text should be enclosed in the appropriate

|

||||||

|

comment syntax for the file format. We also recommend that a

|

||||||

|

file or class name and description of purpose be included on the

|

||||||

|

same "printed page" as the copyright notice for easier

|

||||||

|

identification within third-party archives.

|

||||||

|

|

||||||

|

Copyright [yyyy] [name of copyright owner]

|

||||||

|

|

||||||

|

Licensed under the Apache License, Version 2.0 (the "License");

|

||||||

|

you may not use this file except in compliance with the License.

|

||||||

|

You may obtain a copy of the License at

|

||||||

|

|

||||||

|

http://www.apache.org/licenses/LICENSE-2.0

|

||||||

|

|

||||||

|

Unless required by applicable law or agreed to in writing, software

|

||||||

|

distributed under the License is distributed on an "AS IS" BASIS,

|

||||||

|

WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

|

||||||

|

See the License for the specific language governing permissions and

|

||||||

|

limitations under the License.

|

||||||

478

README.md

478

README.md

@ -1,27 +1,39 @@

|

|||||||

<h1 align="center">Java 学习/面试指南</h1>

|

> JavaGuide 的Star数量虽然比较多,但是它的价值和含金量一定是不能和 Dubbo、Nacos这些优秀的国产开源项目比的。希望国内可以出更多优秀的开源项目!

|

||||||

|

>

|

||||||

|

> 另外,希望大家对面试不要抱有侥幸的心理,打铁还需自身硬! 我希望这个文档是为你学习 Java 指明方向,而不是用来应付面试用的。加油!奥利给!

|

||||||

|

|

||||||

|

**开始阅读之前必看** :

|

||||||

|

|

||||||

|

1. [完结撒花!JavaGuide面试突击版来啦!](./docs/javaguide面试突击版.md)

|

||||||

|

2. [JavaGuide重大更新记录](./docs/update-history.md)

|

||||||

|

|

||||||

|

更多原创内容和干货分享:

|

||||||

|

|

||||||

|

1. [公众号—JavaGuide](#公众号) : 最新原创文章+免费领取本文档配套的《Java面试突击》以及Java工程师必备学习资源)

|

||||||

|

|

||||||

|

Github用户如果访问速度缓慢的话,可以转移到[码云](https://gitee.com/SnailClimb/JavaGuide )查看,或者[在线阅读](https://snailclimb.gitee.io/javaguide )。

|

||||||

|

|

||||||

<p align="center">

|

<p align="center">

|

||||||

<img src="https://my-blog-to-use.oss-cn-beijing.aliyuncs.com/2019-3/logo - 副本.png" width=""/>

|

<a href="https://github.com/Snailclimb/JavaGuide" target="_blank">

|

||||||

|

<img src="https://my-blog-to-use.oss-cn-beijing.aliyuncs.com/2019-3/logo - 副本.png" width=""/>

|

||||||

|

</a>

|

||||||

</p>

|

</p>

|

||||||

|

|

||||||

<p align="center">

|

<p align="center">

|

||||||

<a href="https://snailclimb.gitee.io/javaguide"><img src="https://img.shields.io/badge/阅读-read-brightgreen.svg" alt="阅读"></a>

|

<a href="https://snailclimb.gitee.io/javaguide"><img src="https://img.shields.io/badge/阅读-read-brightgreen.svg" alt="阅读"></a>

|

||||||

<a href="#联系我"><img src="https://img.shields.io/badge/chat-微信群-blue.svg" alt="微信群"></a>

|

|

||||||

<a href="#公众号"><img src="https://img.shields.io/badge/%E5%85%AC%E4%BC%97%E5%8F%B7-JavaGuide-lightgrey.svg" alt="公众号"></a>

|

<a href="#公众号"><img src="https://img.shields.io/badge/%E5%85%AC%E4%BC%97%E5%8F%B7-JavaGuide-lightgrey.svg" alt="公众号"></a>

|

||||||

<a href="#公众号"><img src="https://img.shields.io/badge/PDF-Java面试突击-important.svg" alt="公众号"></a>

|

<a href="#公众号"><img src="https://img.shields.io/badge/PDF-Java面试突击-important.svg" alt="公众号"></a>

|

||||||

<a href="#投稿"><img src="https://img.shields.io/badge/support-投稿-critical.svg" alt="投稿"></a>

|

<a href="#投稿"><img src="https://img.shields.io/badge/support-投稿-critical.svg" alt="投稿"></a>

|

||||||

<h2 align="center">Special Sponsors</h2>

|

<a href="https://xiaozhuanlan.com/javainterview?rel=javaguide"><img src="https://img.shields.io/badge/Java-面试指南-important" alt="投稿"></a>

|

||||||

</p>

|

</p>

|

||||||

|

|

||||||

|

<h3 align="center">Sponsor</h3>

|

||||||

<p align="center">

|

<p align="center">

|

||||||

<a href="https://e.coding.net/?utm_source=JavaGuide" target="_blank">

|

<a href="https://mp.weixin.qq.com/s/li9_YXNVxan6Qgt3Q9FYqA">

|

||||||

<img src="https://my-blog-to-use.oss-cn-beijing.aliyuncs.com/2019-3/Coding Devops.png" width=""/>

|

<img src="https://my-blog-to-use.oss-cn-beijing.aliyuncs.com/2019-7/WechatIMG1.png" style="margin: 0 auto;width:400px"/>

|

||||||

</a>

|

</a >

|

||||||

</p>

|

</p>

|

||||||

|

|

||||||

由于对文件目录结构进行了大幅度修改,所以如果遇到文章中有 Github 404 链接请 [联系我](#联系我)

|

|

||||||

|

|

||||||

推荐使用 <https://snailclimb.top/JavaGuide/> 在线阅读(访问速度慢的话,请使用 <https://snailclimb.gitee.io/javaguide> ),在线阅读内容本仓库同步一致。这种方式阅读的优势在于:有侧边栏阅读体验更好,Gitee pages 的访问速度相对来说也比较快。

|

|

||||||

|

|

||||||

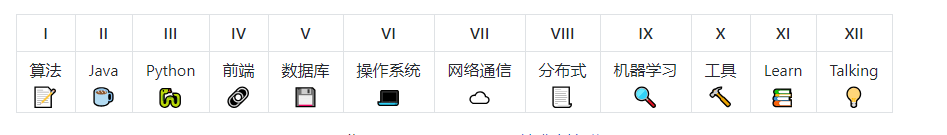

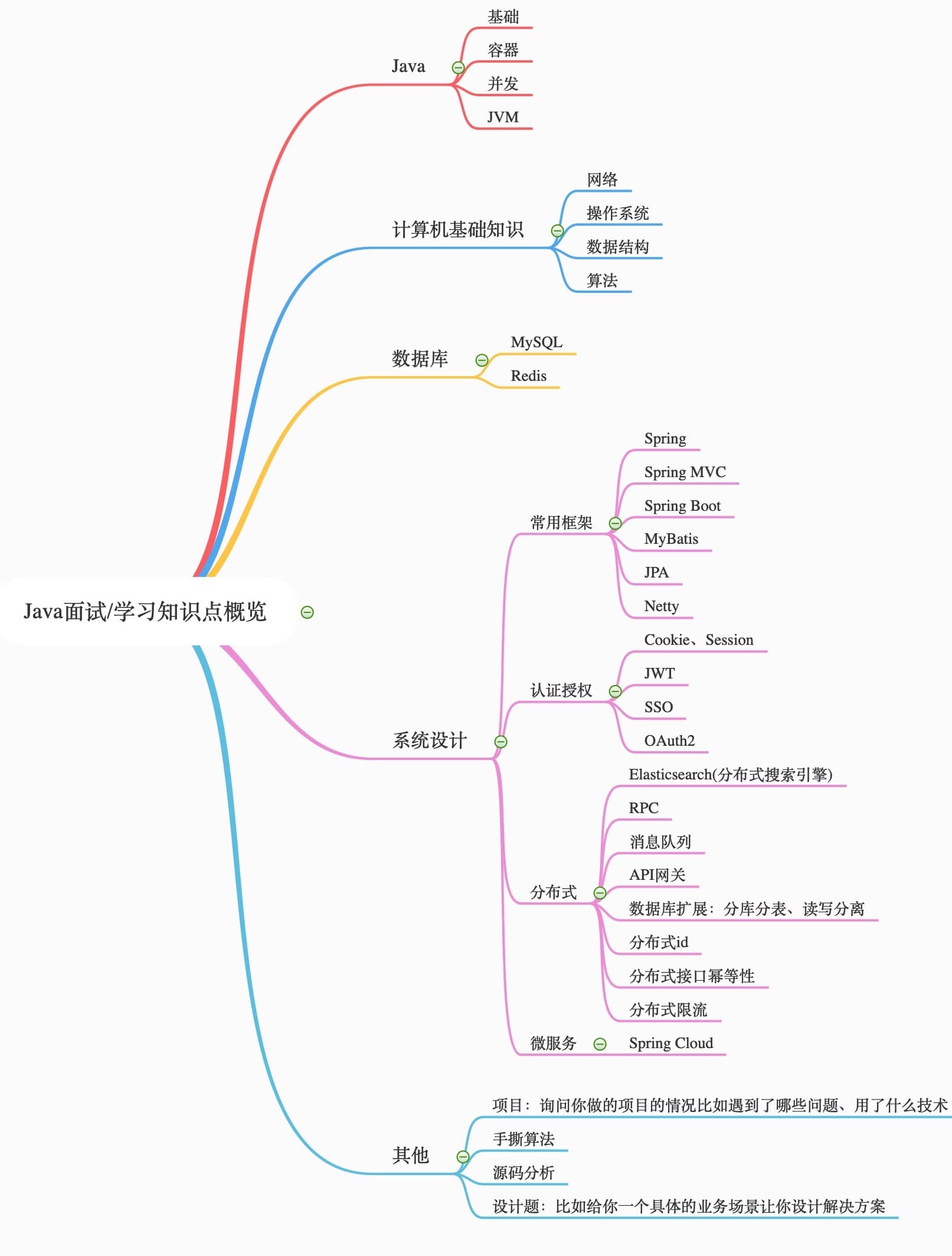

## 目录

|

## 目录

|

||||||

|

|

||||||

- [Java](#java)

|

- [Java](#java)

|

||||||

@ -29,186 +41,307 @@

|

|||||||

- [容器](#容器)

|

- [容器](#容器)

|

||||||

- [并发](#并发)

|

- [并发](#并发)

|

||||||

- [JVM](#jvm)

|

- [JVM](#jvm)

|

||||||

- [I/O](#io)

|

- [其他](#其他)

|

||||||

- [Java 8](#java-8)

|

|

||||||

- [编程规范](#编程规范)

|

|

||||||

- [网络](#网络)

|

- [网络](#网络)

|

||||||

- [操作系统](#操作系统)

|

- [操作系统](#操作系统)

|

||||||

- [Linux相关](#linux相关)

|

- [Linux](#linux)

|

||||||

- [数据结构与算法](#数据结构与算法)

|

- **[数据结构与算法](#数据结构与算法)**

|

||||||

- [数据结构](#数据结构)

|

- [数据结构](#数据结构)

|

||||||

- [算法](#算法)

|

- [算法](#算法)

|

||||||

- [数据库](#数据库)

|

- [数据库](#数据库)

|

||||||

- [MySQL](#mysql)

|

- [MySQL](#mysql)

|

||||||

- [Redis](#redis)

|

- [Redis](#redis)

|

||||||

- [系统设计](#系统设计)

|

- [系统设计](#系统设计)

|

||||||

- [设计模式](#设计模式)

|

- [必知](#必知)

|

||||||

- [常用框架](#常用框架)

|

- [常用框架](#常用框架)

|

||||||

- [数据通信](#数据通信)

|

- [Spring](#spring)

|

||||||

- [网站架构](#网站架构)

|

- [SpringBoot](#springboot)

|

||||||

- [面试指南](#面试指南)

|

- [MyBatis](#mybatis)

|

||||||

- [备战面试](#备战面试)

|

- [认证授权(JWT、SSO)](#认证授权)

|

||||||

- [常见面试题总结](#常见面试题总结)

|

- [分布式](#分布式)

|

||||||

- [面经](#面经)

|

- [Elasticsearch(分布式搜索引擎)](#elasticsearch分布式搜索引擎)

|

||||||

- [工具](#工具)

|

- [RPC](#rpc)

|

||||||

|

- [消息队列](#消息队列)

|

||||||

|

- [API 网关](#api-网关)

|

||||||

|

- [分布式id](#分布式id)

|

||||||

|

- [分布式限流](#分布式限流)

|

||||||

|

- [分布式接口幂等性](#分布式接口幂等性)

|

||||||

|

- [数据库扩展](#数据库扩展)

|

||||||

|

- [ZooKeeper](#zookeeper)

|

||||||

|

- [大型网站架构](#大型网站架构)

|

||||||

|

- [性能测试](#性能测试)

|

||||||

|

- [高并发](#高并发)

|

||||||

|

- [高可用](#高可用)

|

||||||

|

- [微服务](#微服务)

|

||||||

|

- [Spring Cloud](#spring-cloud)

|

||||||

|

- [必会工具](#必会工具)

|

||||||

- [Git](#git)

|

- [Git](#git)

|

||||||

- [Docker](#Docker)

|

- [Docker](#docker)

|

||||||

- [资料](#资料)

|

- [面试指南](#面试指南)

|

||||||

- [书单](#书单)

|

- [Java学习常见问题汇总](#java学习常见问题汇总)

|

||||||

- [Github榜单](#Github榜单)

|

- [资源](#资源)

|

||||||

- [闲谈](#闲谈)

|

- [书单推荐](#书单推荐)

|

||||||

|

- [实战项目推荐](#实战项目推荐)

|

||||||

- [待办](#待办)

|

- [待办](#待办)

|

||||||

- [说明](#说明)

|

- [说明](#说明)

|

||||||

|

|

||||||

|

|

||||||

## Java

|

## Java

|

||||||

|

|

||||||

### 基础

|

### 基础

|

||||||

|

|

||||||

* [Java 基础知识回顾](docs/java/Java基础知识.md)

|

**基础知识系统总结:**

|

||||||

* [J2EE 基础知识回顾](docs/java/J2EE基础知识.md)

|

|

||||||

* [Collections 工具类和 Arrays 工具类常见方法](docs/java/Basis/Arrays%2CCollectionsCommonMethods.md)

|

1. **[Java 基础知识](docs/java/Java基础知识.md)**

|

||||||

* [Java常见关键字总结:static、final、this、super](docs/java/Basis/final、static、this、super.md)

|

2. **[Java 基础知识疑难点/易错点](docs/java/Java疑难点.md)**

|

||||||

|

3. [【选看】J2EE 基础知识](docs/java/J2EE基础知识.md)

|

||||||

|

|

||||||

|

**重要知识点详解:**

|

||||||

|

|

||||||

|

1. [枚举](docs/java/basic/用好Java中的枚举真的没有那么简单.md) (很重要的一个数据结构,用好枚举真的没有那么简单!)

|

||||||

|

2. [Java 常见关键字总结:final、static、this、super!](docs/java/basic/final,static,this,super.md)

|

||||||

|

3. [什么是反射机制?反射机制的应用场景有哪些?](docs/java/basic/reflection.md)

|

||||||

|

|

||||||

|

**其他:**

|

||||||

|

|

||||||

|

1. [JAD反编译](docs/java/JAD反编译tricks.md)

|

||||||

|

|

||||||

### 容器

|

### 容器

|

||||||

|

|

||||||

* **常见问题总结:**

|

1. **[Java容器常见面试题/知识点总结](docs/java/collection/Java集合框架常见面试题.md)**

|

||||||

* [这几道Java集合框架面试题几乎必问](docs/java/这几道Java集合框架面试题几乎必问.md)

|

2. [ArrayList 源码](docs/java/collection/ArrayList.md) 、[LinkedList 源码](docs/java/collection/LinkedList.md) 、[HashMap(JDK1.8)源码](docs/java/collection/HashMap.md)

|

||||||

* [Java 集合框架常见面试题总结](docs/java/Java集合框架常见面试题总结.md)

|

|

||||||

* **源码分析:**

|

|

||||||

* [ArrayList 源码学习](docs/java/ArrayList.md)

|

|

||||||

* [【面试必备】透过源码角度一步一步带你分析 ArrayList 扩容机制](docs/java/ArrayList-Grow.md)

|

|

||||||

* [LinkedList 源码学习](docs/java/LinkedList.md)

|

|

||||||

* [HashMap(JDK1.8)源码学习](docs/java/HashMap.md)

|

|

||||||

|

|

||||||

### 并发

|

### 并发

|

||||||

|

|

||||||

* [并发编程面试必备:synchronized 关键字使用、底层原理、JDK1.6 之后的底层优化以及 和ReenTrantLock 的对比](docs/java/synchronized.md)

|

**[多线程学习指南](./docs/java/Multithread/多线程学习指南.md)**

|

||||||

* [并发编程面试必备:乐观锁与悲观锁](docs/essential-content-for-interview/面试必备之乐观锁与悲观锁.md)

|

|

||||||

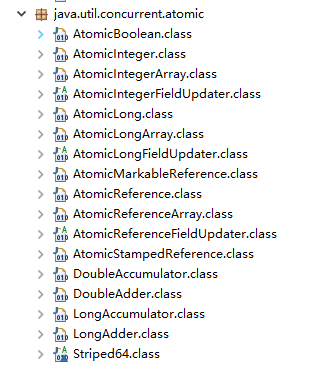

* [并发编程面试必备:JUC 中的 Atomic 原子类总结](docs/java/Multithread/Atomic.md)

|

**面试题总结:**

|

||||||

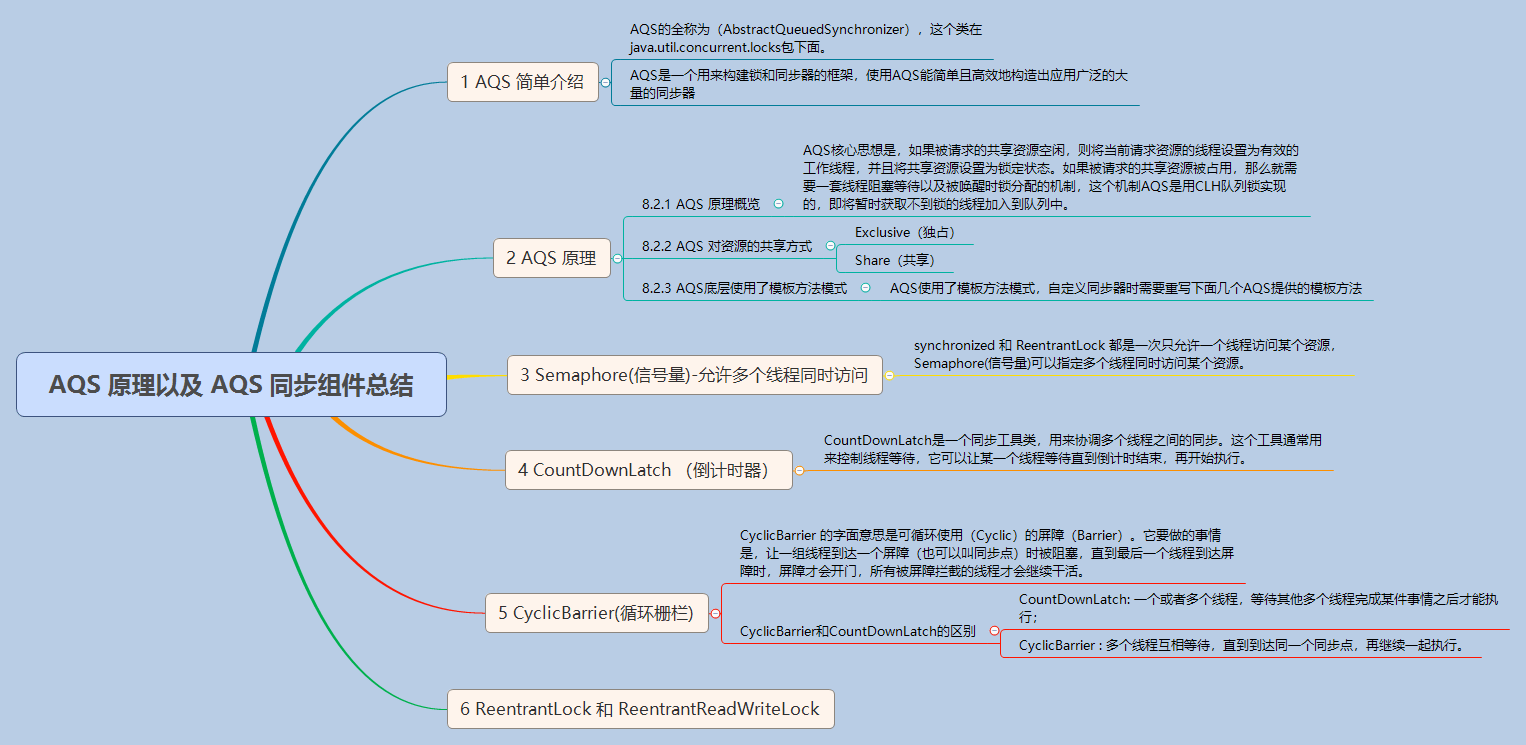

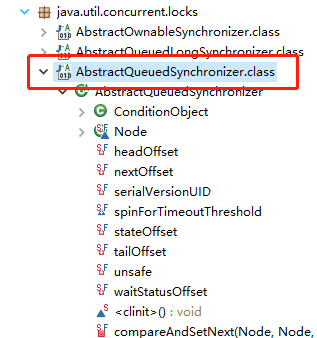

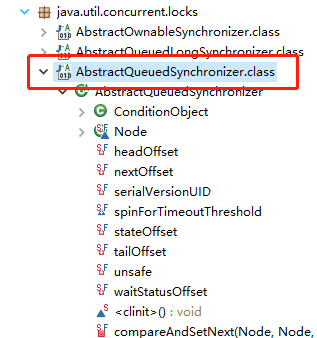

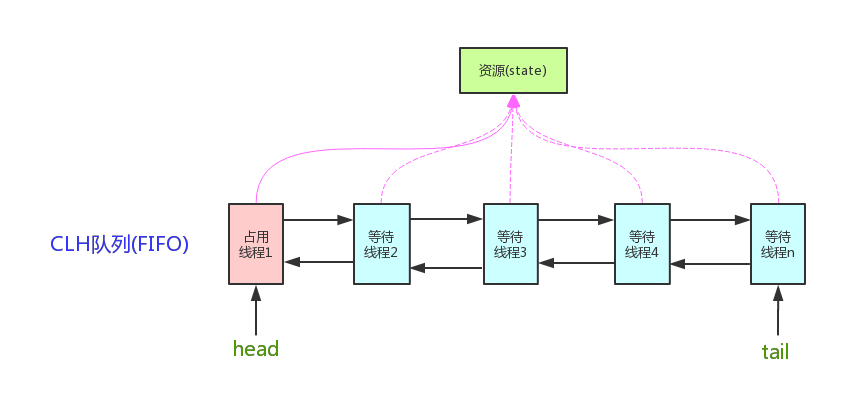

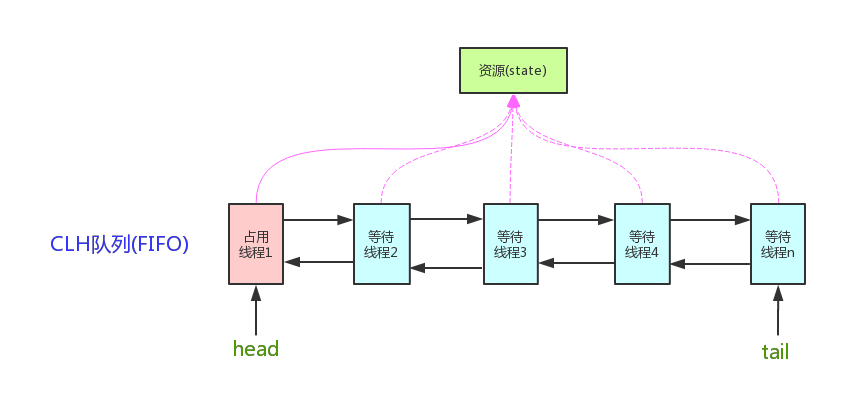

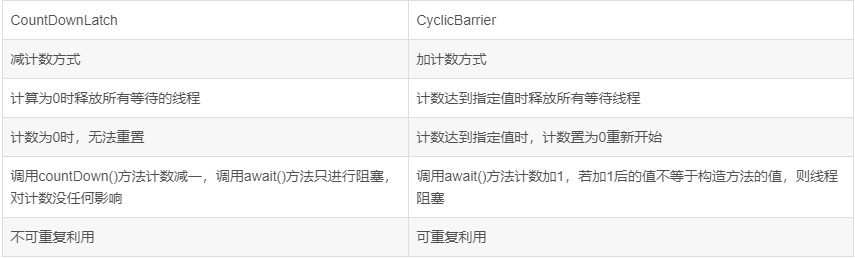

* [并发编程面试必备:AQS 原理以及 AQS 同步组件总结](docs/java/Multithread/AQS.md)

|

|

||||||

* [BATJ都爱问的多线程面试题](docs/java/Multithread/BATJ都爱问的多线程面试题.md)

|

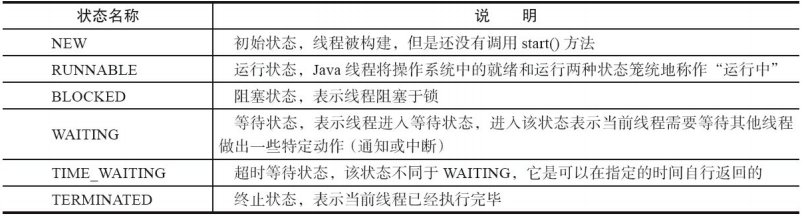

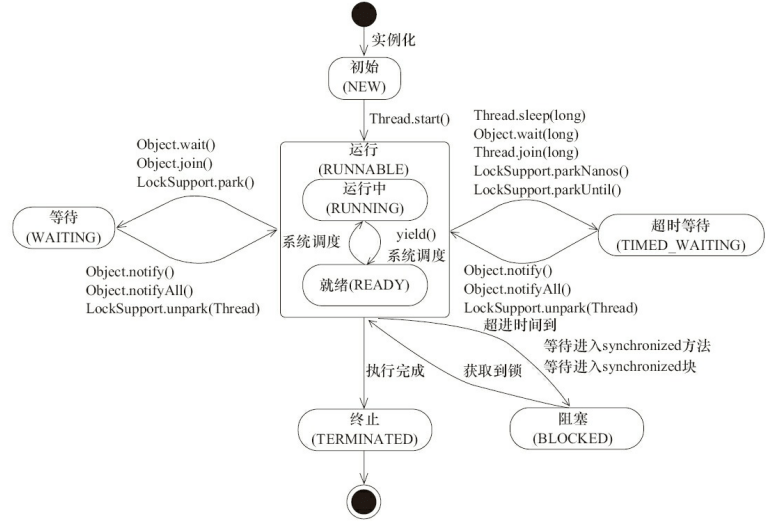

1. **[Java 并发基础常见面试题总结](docs/java/Multithread/JavaConcurrencyBasicsCommonInterviewQuestionsSummary.md)**

|

||||||

* [并发容器总结](docs/java/Multithread/并发容器总结.md)

|

2. **[Java 并发进阶常见面试题总结](docs/java/Multithread/JavaConcurrencyAdvancedCommonInterviewQuestions.md)**

|

||||||

|

|

||||||

|

**必备知识点:**

|

||||||

|

|

||||||

|

1. [并发容器总结](docs/java/Multithread/并发容器总结.md)

|

||||||

|

2. **[Java线程池学习总结](./docs/java/Multithread/java线程池学习总结.md)**

|

||||||

|

3. [乐观锁与悲观锁](docs/essential-content-for-interview/面试必备之乐观锁与悲观锁.md)

|

||||||

|

4. [JUC 中的 Atomic 原子类总结](docs/java/Multithread/Atomic.md)

|

||||||

|

5. [AQS 原理以及 AQS 同步组件总结](docs/java/Multithread/AQS.md)

|

||||||

|

|

||||||

### JVM

|

### JVM

|

||||||

|

|

||||||

* [可能是把Java内存区域讲的最清楚的一篇文章](docs/java/可能是把Java内存区域讲的最清楚的一篇文章.md)

|

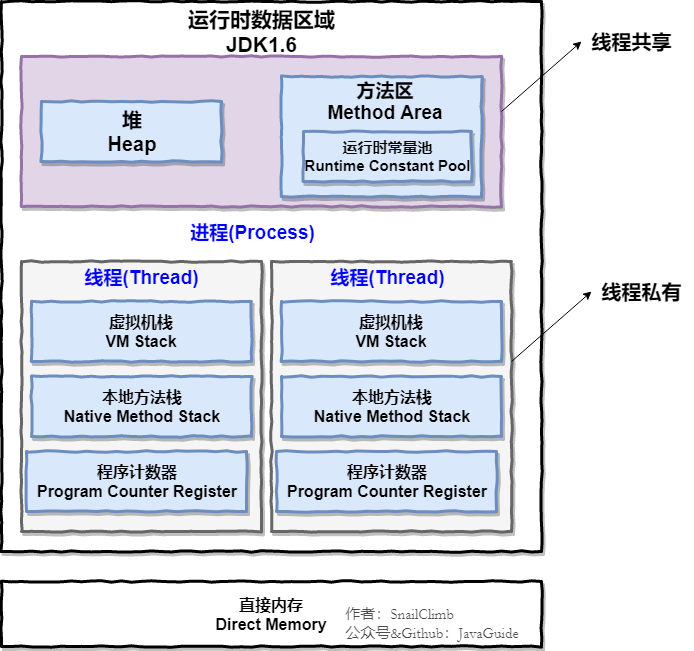

1. **[Java内存区域](docs/java/jvm/Java内存区域.md)**

|

||||||

* [搞定JVM垃圾回收就是这么简单](docs/java/搞定JVM垃圾回收就是这么简单.md)

|

2. **[JVM垃圾回收](docs/java/jvm/JVM垃圾回收.md)**

|

||||||

* [《深入理解Java虚拟机》第2版学习笔记](docs/java/Java虚拟机(jvm).md)

|

3. [JDK 监控和故障处理工具](docs/java/jvm/JDK监控和故障处理工具总结.md)

|

||||||

|

4. [类文件结构](docs/java/jvm/类文件结构.md)

|

||||||

|

5. **[类加载过程](docs/java/jvm/类加载过程.md)**

|

||||||

|

6. [类加载器](docs/java/jvm/类加载器.md)

|

||||||

|

7. **[【待完成】最重要的 JVM 参数指南(翻译完善了一半)](docs/java/jvm/最重要的JVM参数指南.md)**

|

||||||

|

8. [JVM 配置常用参数和常用 GC 调优策略](docs/java/jvm/GC调优参数.md)

|

||||||

|

9. **[【加餐】大白话带你认识JVM](docs/java/jvm/[加餐]大白话带你认识JVM.md)**

|

||||||

|

|

||||||

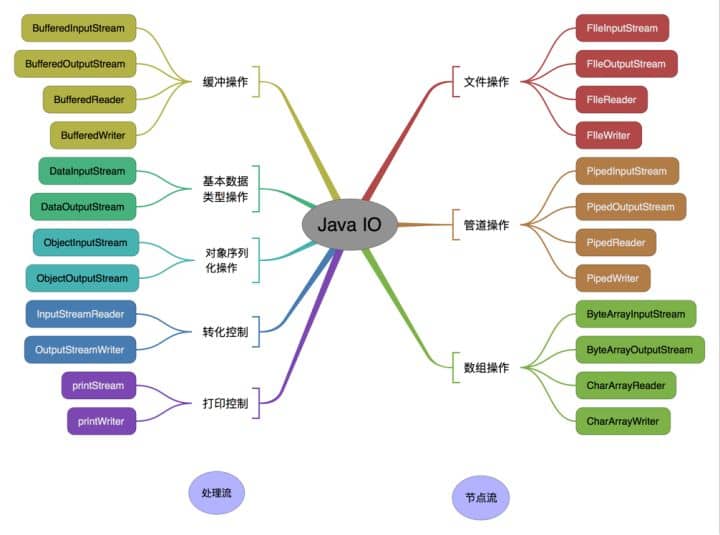

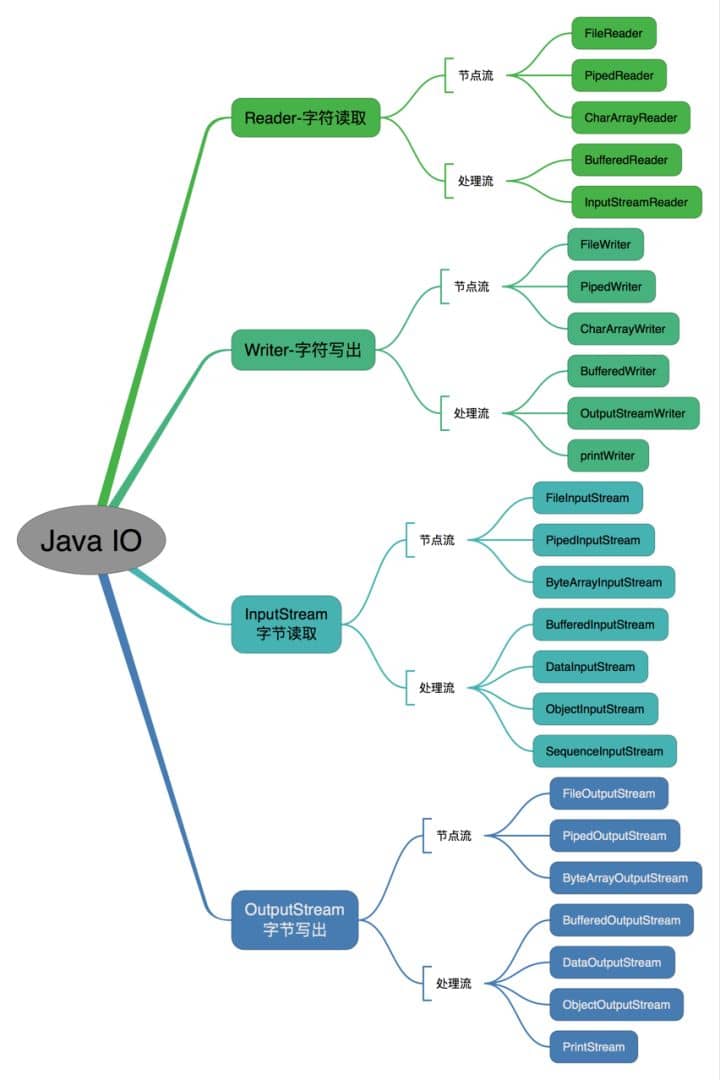

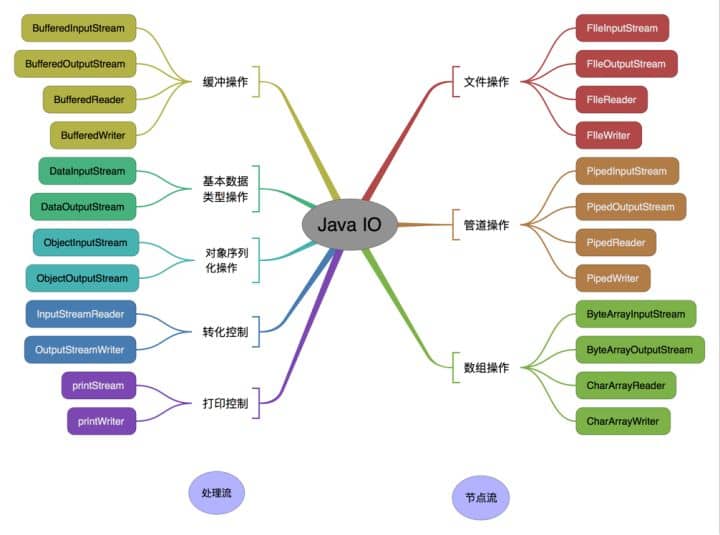

### I/O

|

### 其他

|

||||||

|

|

||||||

* [BIO,NIO,AIO 总结 ](docs/java/BIO-NIO-AIO.md)

|

1. **I/O** :[BIO,NIO,AIO 总结 ](docs/java/BIO-NIO-AIO.md)

|

||||||

* [Java IO 与 NIO系列文章](docs/java/Java%20IO与NIO.md)

|

2. **Java 8** :[Java 8 新特性总结](docs/java/What's%20New%20in%20JDK8/Java8Tutorial.md)、[Java 8 学习资源推荐](docs/java/What's%20New%20in%20JDK8/Java8教程推荐.md)、[Java8 forEach 指南](docs/java/What's%20New%20in%20JDK8/Java8foreach指南.md)

|

||||||

|

3. **Java9~Java14** : [一文带你看遍JDK9~14的重要新特性!](./docs/java/jdk-new-features/new-features-from-jdk8-to-jdk14.md)

|

||||||

### Java 8

|

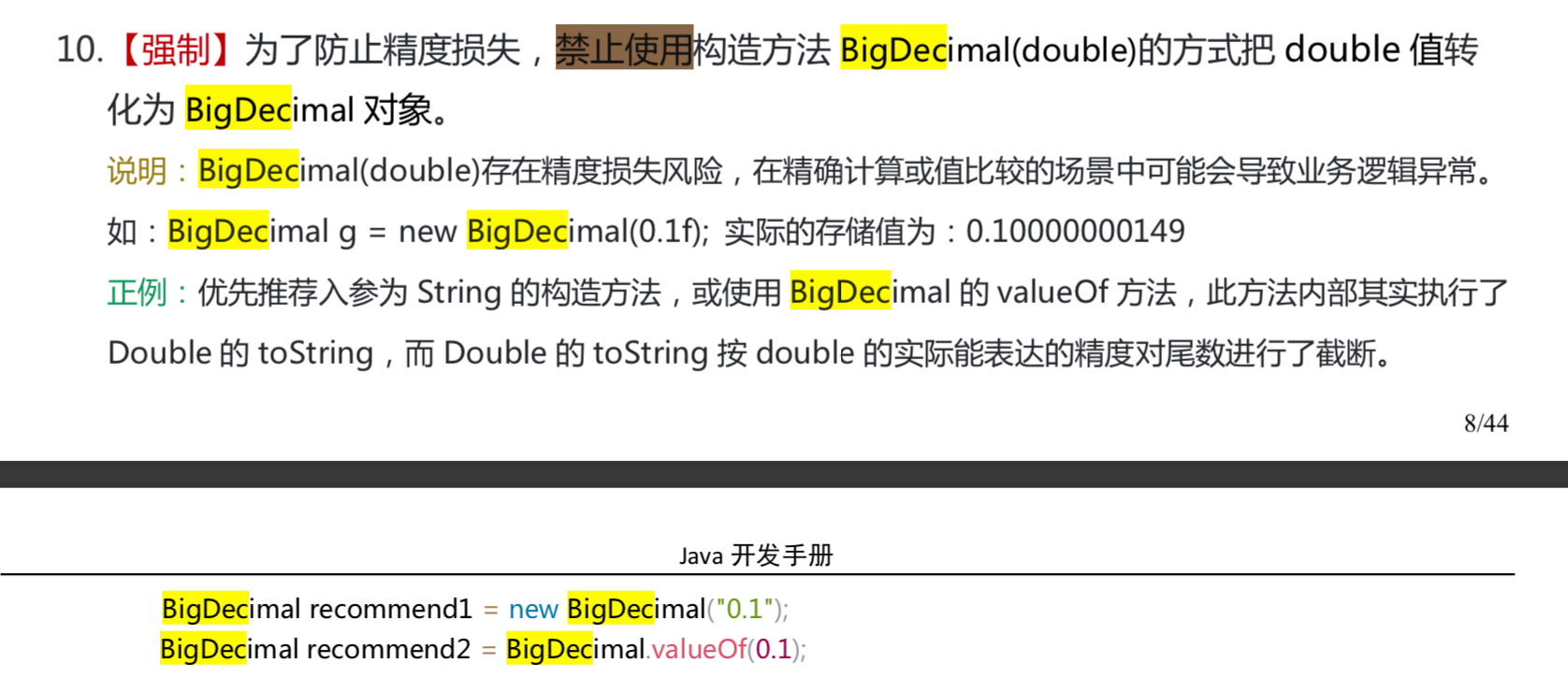

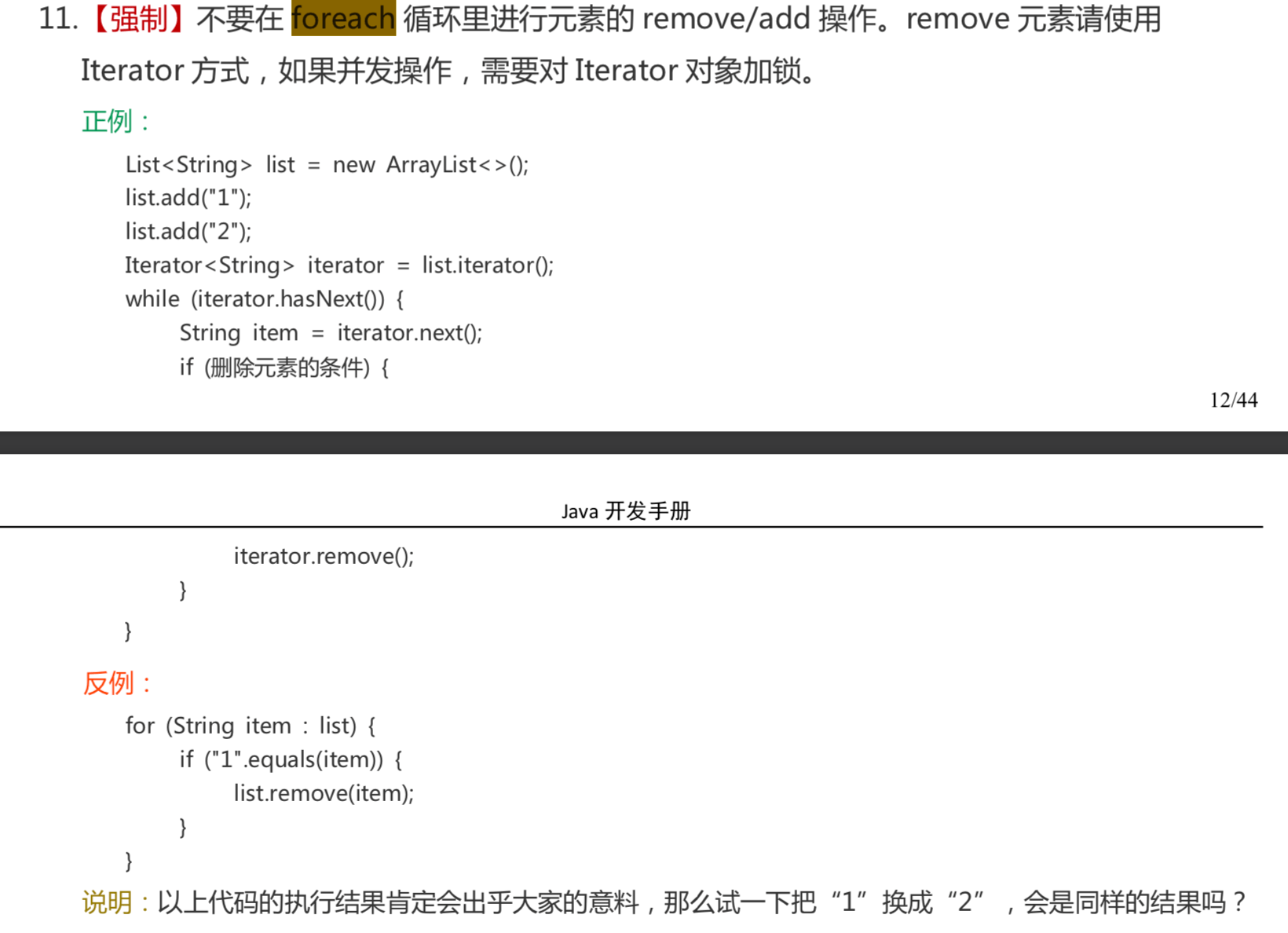

4. Java编程规范:**[Java 编程规范以及优雅 Java 代码实践总结](docs/java/Java编程规范.md)** 、[告别编码5分钟,命名2小时!史上最全的Java命名规范参考!](docs/java/java-naming-conventions.md)

|

||||||

|

5. 设计模式 :[设计模式系列文章](docs/system-design/设计模式.md)

|

||||||

* [Java 8 新特性总结](docs/java/What's%20New%20in%20JDK8/Java8Tutorial.md)

|

|

||||||

* [Java 8 学习资源推荐](docs/java/What's%20New%20in%20JDK8/Java8教程推荐.md)

|

|

||||||

|

|

||||||

### 编程规范

|

|

||||||

|

|

||||||

- [Java 编程规范](docs/java/Java编程规范.md)

|

|

||||||

|

|

||||||

## 网络

|

## 网络

|

||||||

|

|

||||||

* [计算机网络常见面试题](docs/network/计算机网络.md)

|

1. [计算机网络常见面试题](docs/network/计算机网络.md)

|

||||||

* [计算机网络基础知识总结](docs/network/干货:计算机网络知识总结.md)

|

2. [计算机网络基础知识总结](docs/network/干货:计算机网络知识总结.md)

|

||||||

* [HTTPS中的TLS](docs/network/HTTPS中的TLS.md)

|

3. [HTTPS中的TLS](docs/network/HTTPS中的TLS.md)

|

||||||

|

|

||||||

## 操作系统

|

## 操作系统

|

||||||

|

|

||||||

### Linux相关

|

[最硬核的操作系统常见问题总结!](docs/operating-system/basis.md)

|

||||||

|

|

||||||

* [后端程序员必备的 Linux 基础知识](docs/operating-system/后端程序员必备的Linux基础知识.md)

|

### Linux

|

||||||

* [Shell 编程入门](docs/operating-system/Shell.md)

|

|

||||||

|

* [后端程序员必备的 Linux 基础知识](docs/operating-system/linux.md)

|

||||||

|

* [Shell 编程入门](docs/operating-system/Shell.md)

|

||||||

|

|

||||||

## 数据结构与算法

|

## 数据结构与算法

|

||||||

|

|

||||||

### 数据结构

|

### 数据结构

|

||||||

|

|

||||||

|

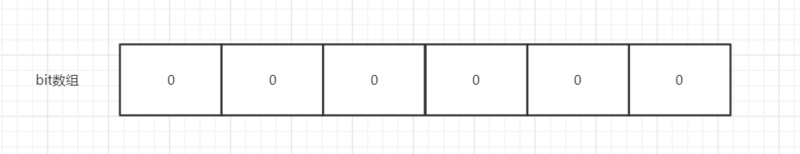

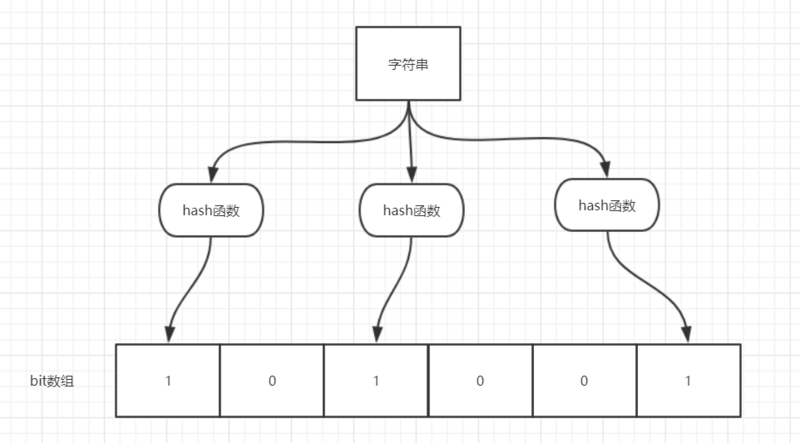

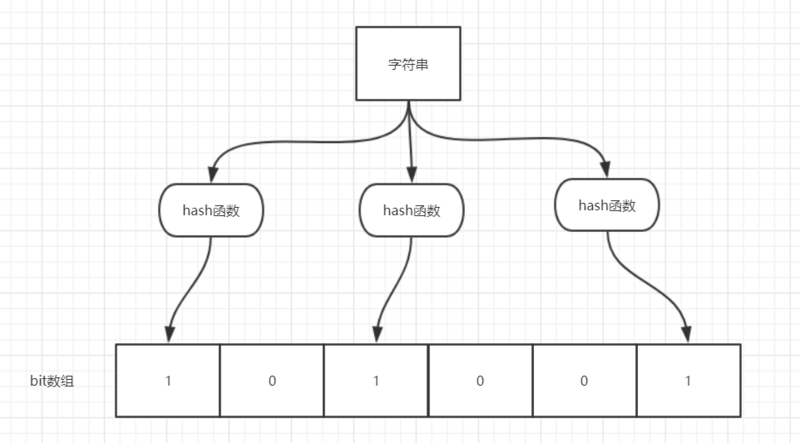

- [不了解布隆过滤器?一文给你整的明明白白!](docs/dataStructures-algorithms/data-structure/bloom-filter.md)

|

||||||

- [数据结构知识学习与面试](docs/dataStructures-algorithms/数据结构.md)

|

- [数据结构知识学习与面试](docs/dataStructures-algorithms/数据结构.md)

|

||||||

|

|

||||||

### 算法

|

### 算法

|

||||||

|

|

||||||

- [算法学习资源推荐](docs/dataStructures-algorithms/算法学习资源推荐.md)

|

- [硬核的算法学习书籍+资源推荐](docs/dataStructures-algorithms/算法学习资源推荐.md)

|

||||||

- [算法总结——几道常见的子符串算法题 ](docs/dataStructures-algorithms/几道常见的子符串算法题.md)

|

- 常见算法问题总结:

|

||||||

- [算法总结——几道常见的链表算法题 ](docs/dataStructures-algorithms/几道常见的链表算法题.md)

|

- [几道常见的字符串算法题总结 ](docs/dataStructures-algorithms/几道常见的子符串算法题.md)

|

||||||

- [剑指offer部分编程题](docs/dataStructures-algorithms/剑指offer部分编程题.md)

|

- [几道常见的链表算法题总结 ](docs/dataStructures-algorithms/几道常见的链表算法题.md)

|

||||||

- [公司真题](docs/dataStructures-algorithms/公司真题.md)

|

- [剑指offer部分编程题](docs/dataStructures-algorithms/剑指offer部分编程题.md)

|

||||||

- [回溯算法经典案例之N皇后问题](./dataStructures-algorithms/Backtracking-NQueens.md)

|

- [公司真题](docs/dataStructures-algorithms/公司真题.md)

|

||||||

|

- [回溯算法经典案例之N皇后问题](docs/dataStructures-algorithms/Backtracking-NQueens.md)

|

||||||

|

|

||||||

## 数据库

|

## 数据库

|

||||||

|

|

||||||

### MySQL

|

### MySQL

|

||||||

|

|

||||||

* [MySQL 学习与面试](docs/database/MySQL.md)

|

**总结:**

|

||||||

* [一千行MySQL学习笔记](docs/database/一千行MySQL命令.md)

|

|

||||||

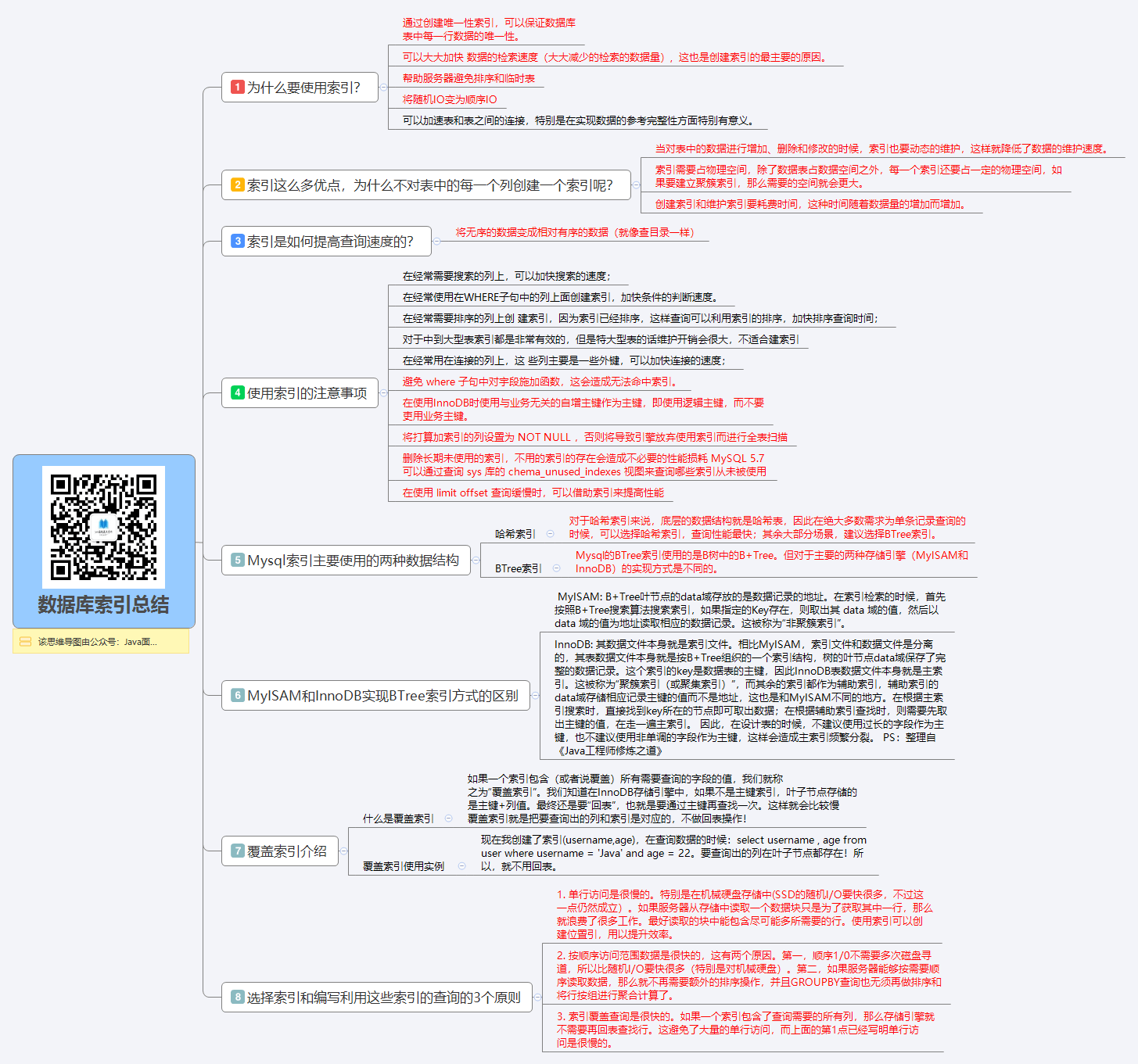

* [【思维导图-索引篇】搞定数据库索引就是这么简单](docs/database/MySQL%20Index.md)

|

1. **[【推荐】MySQL/数据库 知识点总结](docs/database/MySQL.md)**

|

||||||

* [事务隔离级别(图文详解)](docs/database/事务隔离级别(图文详解).md)

|

2. **[阿里巴巴开发手册数据库部分的一些最佳实践](docs/database/阿里巴巴开发手册数据库部分的一些最佳实践.md)**

|

||||||

|

3. **[一千行MySQL学习笔记](docs/database/一千行MySQL命令.md)**

|

||||||

|

4. [MySQL高性能优化规范建议](docs/database/MySQL高性能优化规范建议.md)

|

||||||

|

|

||||||

|

**重要知识点:**

|

||||||

|

|

||||||

|

1. [数据库索引总结1](docs/database/MySQL%20Index.md)、[数据库索引总结2](docs/database/数据库索引.md)

|

||||||

|

2. [事务隔离级别(图文详解)](docs/database/事务隔离级别(图文详解).md)

|

||||||

|

3. [一条SQL语句在MySQL中如何执行的](docs/database/一条sql语句在mysql中如何执行的.md)

|

||||||

|

4. **[关于数据库中如何存储时间的一点思考](docs/database/关于数据库存储时间的一点思考.md)**

|

||||||

|

|

||||||

### Redis

|

### Redis

|

||||||

|

|

||||||

* [Redis 总结](docs/database/Redis/Redis.md)

|

* [Redis 常见问题总结](docs/database/Redis/Redis.md)

|

||||||

* [Redlock分布式锁](docs/database/Redis/Redlock分布式锁.md)

|

* **Redis 系列文章合集:**

|

||||||

* [如何做可靠的分布式锁,Redlock真的可行么](docs/database/Redis/如何做可靠的分布式锁,Redlock真的可行么.md)

|

1. [5种基本数据结构](docs/database/Redis/redis-collection/Redis(1)——5种基本数据结构.md)

|

||||||

|

2. [跳跃表](docs/database/Redis/redis-collection/Redis(2)——跳跃表.md)

|

||||||

|

3. [分布式锁深入探究](docs/database/Redis/redis-collection/Redis(3)——分布式锁深入探究.md) 、 [Redlock分布式锁](docs/database/Redis/Redlock分布式锁.md) 、[如何做可靠的分布式锁,Redlock真的可行么](docs/database/Redis/如何做可靠的分布式锁,Redlock真的可行么.md)

|

||||||

|

4. [神奇的HyperLoglog解决统计问题](docs/database/Redis/redis-collection/Reids(4)——神奇的HyperLoglog解决统计问题.md)

|

||||||

|

5. [亿级数据过滤和布隆过滤器](docs/database/Redis/redis-collection/Redis(5)——亿级数据过滤和布隆过滤器.md)

|

||||||

|

6. [GeoHash查找附近的人](docs/database/Redis/redis-collection/Redis(6)——GeoHash查找附近的人.md)

|

||||||

|

7. [持久化](docs/database/Redis/redis-collection/Redis(7)——持久化.md)

|

||||||

|

8. [发布订阅与Stream](docs/database/Redis/redis-collection/Redis(8)——发布订阅与Stream.md)

|

||||||

|

9. [史上最强【集群】入门实践教程](docs/database/Redis/redis-collection/Redis(9)——集群入门实践教程.md)

|

||||||

|

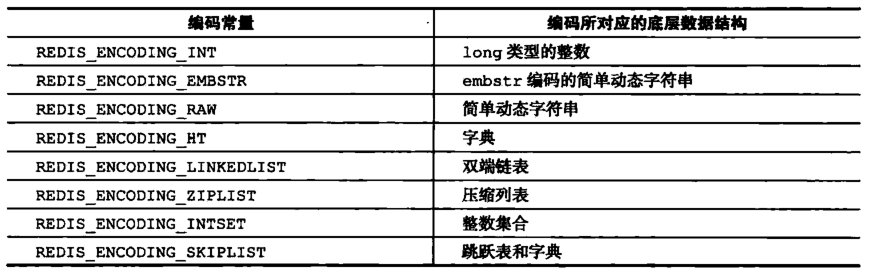

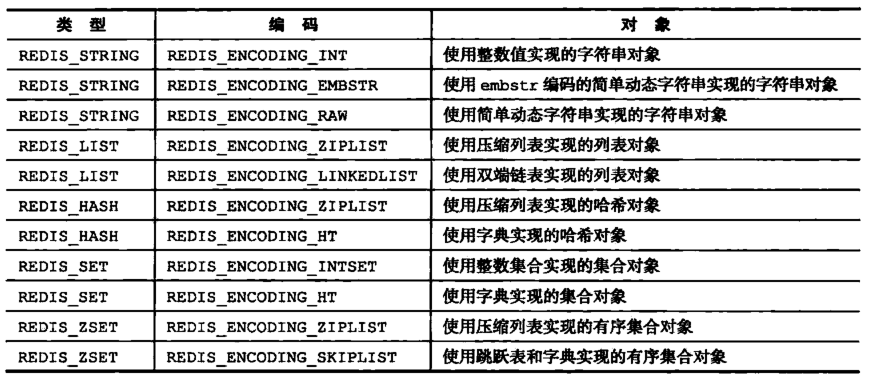

10. [Redis数据类型、编码、底层数据结构的关系看这篇](docs/database/Redis/redis-collection/Redis(10)——Redis数据类型、编码、数据结构的关系.md)

|

||||||

|

|

||||||

## 系统设计

|

## 系统设计

|

||||||

|

|

||||||

### 设计模式

|

### 必知

|

||||||

|

|

||||||

- [设计模式系列文章](docs/system-design/设计模式.md)

|

1. **[RestFul API 简明教程](docs/system-design/restful-api.md)**

|

||||||

|

|

||||||

### 常用框架

|

### 常用框架

|

||||||

|

|

||||||

#### Spring

|

#### Spring/SpringBoot

|

||||||

|

|

||||||

- [Spring 学习与面试](docs/system-design/framework/Spring学习与面试.md)

|

1. [Spring 学习与面试(待重构)](docs/system-design/framework/spring/Spring.md)

|

||||||

- [Spring中bean的作用域与生命周期](docs/system-design/framework/SpringBean.md)

|

2. **[Spring 常见问题总结](docs/system-design/framework/spring/SpringInterviewQuestions.md)**

|

||||||

- [SpringMVC 工作原理详解](docs/system-design/framework/SpringMVC%20%E5%B7%A5%E4%BD%9C%E5%8E%9F%E7%90%86%E8%AF%A6%E8%A7%A3.md)

|

3. **[Spring/Spring常用注解总结!安排!](./docs/system-design/framework/spring/spring-annotations.md)**

|

||||||

|

4. **[SpringBoot 指南/常见面试题总结](https://github.com/Snailclimb/springboot-guide)**

|

||||||

|

5. [Spring中 Bean 的作用域与生命周期](docs/system-design/framework/spring/SpringBean.md)

|

||||||

|

6. [SpringMVC 工作原理详解](docs/system-design/framework/spring/SpringMVC-Principle.md)

|

||||||

|

7. [Spring中都用到了那些设计模式?](docs/system-design/framework/spring/Spring-Design-Patterns.md)

|

||||||

|

|

||||||

|

#### MyBatis

|

||||||

|

|

||||||

|

- [MyBatis常见面试题总结](docs/system-design/framework/mybatis/mybatis-interview.md)

|

||||||

|

|

||||||

|

### 认证授权

|

||||||

|

|

||||||

|

**[认证授权基础:搞清Authentication,Authorization以及Cookie、Session、Token、OAuth 2、SSO](docs/system-design/authority-certification/basis-of-authority-certification.md)**

|

||||||

|

|

||||||

|

#### JWT

|

||||||

|

|

||||||

|

- **[JWT 优缺点分析以及常见问题解决方案](docs/system-design/authority-certification/JWT-advantages-and-disadvantages.md)**

|

||||||

|

- **[适合初学者入门 Spring Security With JWT 的 Demo](https://github.com/Snailclimb/spring-security-jwt-guide)**

|

||||||

|

|

||||||

|

#### SSO(单点登录)

|

||||||

|

|

||||||

|

SSO(Single Sign On)即单点登录说的是用户登陆多个子系统的其中一个就有权访问与其相关的其他系统。举个例子我们在登陆了京东金融之后,我们同时也成功登陆京东的京东超市、京东家电等子系统。相关阅读:**[SSO 单点登录看这篇就够了!](docs/system-design/authority-certification/sso.md)**

|

||||||

|

|

||||||

|

### 分布式

|

||||||

|

|

||||||

|

[分布式相关概念入门](docs/system-design/website-architecture/分布式.md)

|

||||||

|

|

||||||

|

#### Elasticsearch(分布式搜索引擎)

|

||||||

|

|

||||||

|

提高搜索效率。常见于电商购物网站的商品搜索于分类。

|

||||||

|

|

||||||

|

代办......

|

||||||

|

|

||||||

|

#### RPC

|

||||||

|

|

||||||

|

让调用远程服务调用像调用本地方法那样简单。

|

||||||

|

|

||||||

|

- [Dubbo 总结:关于 Dubbo 的重要知识点](docs/system-design/data-communication/dubbo.md)

|

||||||

|

- [服务之间的调用为啥不直接用 HTTP 而用 RPC?](docs/system-design/data-communication/why-use-rpc.md)

|

||||||

|

|

||||||

|

#### 消息队列

|

||||||

|

|

||||||

|

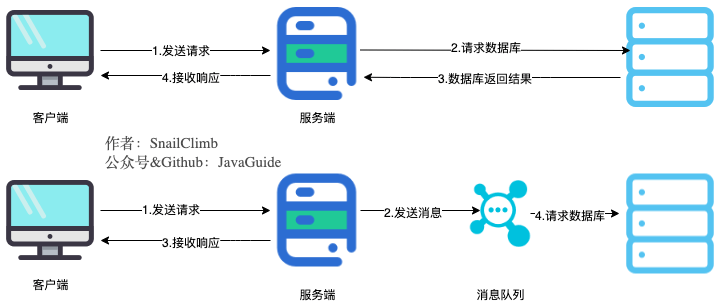

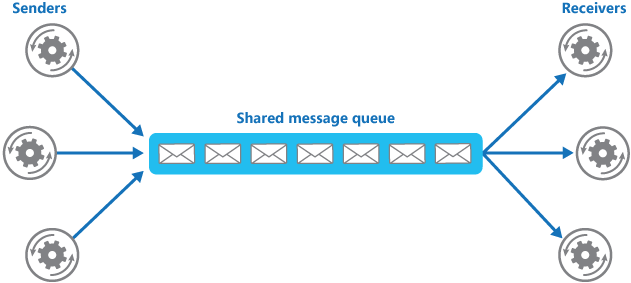

消息队列在分布式系统中主要是为了接耦和削峰。相关阅读: **[消息队列总结](docs/system-design/data-communication/message-queue.md)** 。

|

||||||

|

|

||||||

|

**RabbitMQ:**

|

||||||

|

|

||||||

|

1. [RabbitMQ 入门](docs/system-design/data-communication/rabbitmq.md)

|

||||||

|

|

||||||

|

**RocketMQ:**

|

||||||

|

|

||||||

|

1. [RocketMQ 入门](docs/system-design/data-communication/RocketMQ.md)

|

||||||

|

2. [RocketMQ的几个简单问题与答案](docs/system-design/data-communication/RocketMQ-Questions.md)

|

||||||

|

|

||||||

|

**Kafka:**

|

||||||

|

|

||||||

|

1. **[Kafka 入门+SpringBoot整合Kafka系列](https://github.com/Snailclimb/springboot-kafka)**

|

||||||

|

2. **[Kafka 常见面试题总结](docs/system-design/data-communication/kafka-inverview.md)**

|

||||||

|

3. [【加餐】Kafka入门看这一篇就够了](docs/system-design/data-communication/Kafka入门看这一篇就够了.md)

|

||||||

|

|

||||||

|

#### API 网关

|

||||||

|

|

||||||

|

网关主要用于请求转发、安全认证、协议转换、容灾。

|

||||||

|

|

||||||

|

1. [为什么要网关?你知道有哪些常见的网关系统?](docs/system-design/micro-service/api-gateway-intro.md)

|

||||||

|

2. [如何设计一个亿级网关(API Gateway)?](docs/system-design/micro-service/API网关.md)

|

||||||

|

|

||||||

|

#### 分布式id

|

||||||

|

|

||||||

|

1. [为什么要分布式 id ?分布式 id 生成方案有哪些?](docs/system-design/micro-service/分布式id生成方案总结.md)

|

||||||

|

|

||||||

|

#### 分布式限流

|

||||||

|

|

||||||

|

1. [限流算法有哪些?](docs/system-design/micro-service/limit-request.md)

|

||||||

|

|

||||||

|

#### 分布式接口幂等性

|

||||||

|

|

||||||

#### ZooKeeper

|

#### ZooKeeper

|

||||||

|

|

||||||

- [可能是把 ZooKeeper 概念讲的最清楚的一篇文章](docs/system-design/framework/ZooKeeper.md)

|

> 前两篇文章可能有内容重合部分,推荐都看一遍。

|

||||||

- [ZooKeeper 数据模型和常见命令了解一下,速度收藏!](docs/system-design/framework/ZooKeeper数据模型和常见命令.md)

|

|

||||||

|

|

||||||

### 数据通信

|

1. [【入门】ZooKeeper 相关概念总结](docs/system-design/framework/ZooKeeper.md)

|

||||||

|

2. [【进阶】Zookeeper 原理简单入门!](docs/system-design/framework/ZooKeeper-plus.md)

|

||||||

|

3. [【拓展】ZooKeeper 数据模型和常见命令](docs/system-design/framework/ZooKeeper数据模型和常见命令.md)

|

||||||

|

|

||||||

- [数据通信(RESTful、RPC、消息队列)相关知识点总结](docs/system-design/data-communication/数据通信(RESTful、RPC、消息队列).md)

|

#### 其他

|

||||||

- [Dubbo 总结:关于 Dubbo 的重要知识点](docs/system-design/data-communication/dubbo.md)

|

|

||||||

- [消息队列总结:新手也能看懂,消息队列其实很简单](docs/system-design/data-communication/message-queue.md)

|

|

||||||

- [一文搞懂 RabbitMQ 的重要概念以及安装](docs/system-design/data-communication/rabbitmq.md)

|

|

||||||

|

|

||||||

### 网站架构

|

- 接口幂等性(代办):分布式系统必须要考虑接口的幂等性。

|

||||||

|

|

||||||

|

#### 数据库扩展

|

||||||

|

|

||||||

|

读写分离、分库分表。

|

||||||

|

|

||||||

|

代办.....

|

||||||

|

|

||||||

|

### 大型网站架构

|

||||||

|

|

||||||

- [一文读懂分布式应该学什么](docs/system-design/website-architecture/分布式.md)

|

|

||||||

- [8 张图读懂大型网站技术架构](docs/system-design/website-architecture/8%20张图读懂大型网站技术架构.md)

|

- [8 张图读懂大型网站技术架构](docs/system-design/website-architecture/8%20张图读懂大型网站技术架构.md)

|

||||||

- [【面试精选】关于大型网站系统架构你不得不懂的10个问题](docs/system-design/website-architecture/【面试精选】关于大型网站系统架构你不得不懂的10个问题.md)

|

- [关于大型网站系统架构你不得不懂的10个问题](docs/system-design/website-architecture/关于大型网站系统架构你不得不懂的10个问题.md)

|

||||||

|

|

||||||

## 面试指南

|

#### 性能测试

|

||||||

|

|

||||||

### 备战面试

|

- [后端程序员也要懂的性能测试知识](https://articles.zsxq.com/id_lwl39teglv3d.html) (知识星球)

|

||||||

|

|

||||||

* [【备战面试1】程序员的简历就该这样写](docs/essential-content-for-interview/PreparingForInterview/程序员的简历之道.md)

|

#### 高并发

|

||||||

* [【备战面试2】初出茅庐的程序员该如何准备面试?](docs/essential-content-for-interview/PreparingForInterview/interviewPrepare.md)

|

|

||||||

* [【备战面试3】7个大部分程序员在面试前很关心的问题](docs/essential-content-for-interview/PreparingForInterview/JavaProgrammerNeedKnow.md)

|

|

||||||

* [【备战面试4】Java程序员必备书单](docs/essential-content-for-interview/PreparingForInterview/books.md)

|

|

||||||

* [【备战面试5】Github上开源的Java面试/学习相关的仓库推荐](docs/essential-content-for-interview/PreparingForInterview/JavaInterviewLibrary.md)

|

|

||||||

* [【备战面试6】如果面试官问你“你有什么问题问我吗?”时,你该如何回答](docs/essential-content-for-interview/PreparingForInterview/如果面试官问你“你有什么问题问我吗?”时,你该如何回答.md)

|

|

||||||

* [【备战面试7】美团面试常见问题总结(附详解答案)](docs/essential-content-for-interview/PreparingForInterview/美团面试常见问题总结.md)

|

|

||||||

|

|

||||||

### 常见面试题总结

|

待办......

|

||||||

|

|

||||||

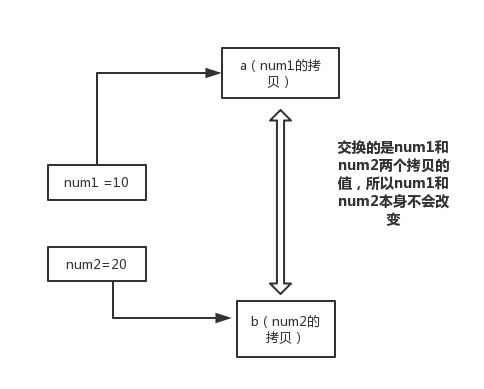

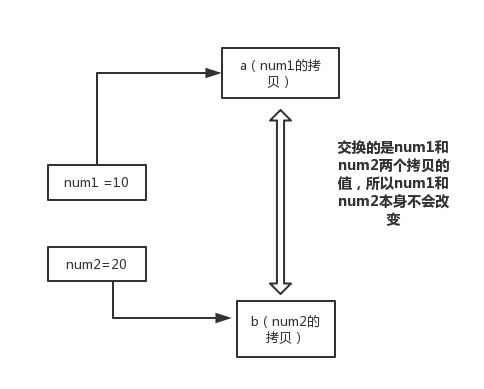

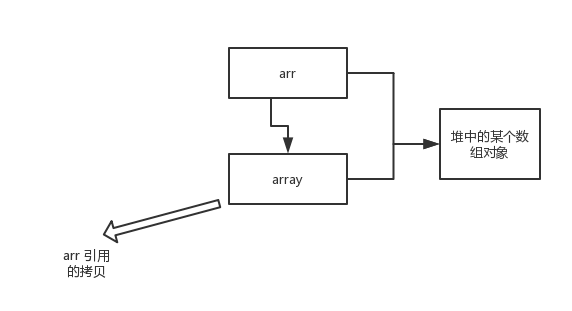

* [第一周(2018-8-7)](docs/essential-content-for-interview/MostCommonJavaInterviewQuestions/第一周(2018-8-7).md) (为什么 Java 中只有值传递、==与equals、 hashCode与equals)

|

#### 高可用

|

||||||

* [第二周(2018-8-13)](docs/essential-content-for-interview/MostCommonJavaInterviewQuestions/第二周(2018-8-13).md)(String和StringBuffer、StringBuilder的区别是什么?String为什么是不可变的?、什么是反射机制?反射机制的应用场景有哪些?......)

|

|

||||||

* [第三周(2018-08-22)](docs/java/这几道Java集合框架面试题几乎必问.md) (Arraylist 与 LinkedList 异同、ArrayList 与 Vector 区别、HashMap的底层实现、HashMap 和 Hashtable 的区别、HashMap 的长度为什么是2的幂次方、HashSet 和 HashMap 区别、ConcurrentHashMap 和 Hashtable 的区别、ConcurrentHashMap线程安全的具体实现方式/底层具体实现、集合框架底层数据结构总结)

|

|

||||||

* [第四周(2018-8-30).md](docs/essential-content-for-interview/MostCommonJavaInterviewQuestions/第四周(2018-8-30).md) (主要内容是几道面试常问的多线程基础题。)

|

|

||||||

|

|

||||||

### 面经

|

高可用描述的是一个系统在大部分时间都是可用的,可以为我们提供服务的。高可用代表系统即使在发生硬件故障或者系统升级的时候,服务仍然是可用的 。相关阅读: **《[如何设计一个高可用系统?要考虑哪些地方?](docs/system-design/website-architecture/如何设计一个高可用系统?要考虑哪些地方?.md)》** 。

|

||||||

|

|

||||||

- [5面阿里,终获offer(2018年秋招)](docs/essential-content-for-interview/BATJrealInterviewExperience/5面阿里,终获offer.md)

|

### 微服务

|

||||||

|

|

||||||

## 工具

|

#### Spring Cloud

|

||||||

|

|

||||||

|

- [ 大白话入门 Spring Cloud](docs/system-design/micro-service/spring-cloud.md)

|

||||||

|

|

||||||

|

## 必会工具

|

||||||

|

|

||||||

### Git

|

### Git

|

||||||

|

|

||||||

@ -216,38 +349,64 @@

|

|||||||

|

|

||||||

### Docker

|

### Docker

|

||||||

|

|

||||||

* [Docker 入门](docs/tools/Docker.md)

|

1. [Docker 基本概念解读](docs/tools/Docker.md)

|

||||||

|

2. [一文搞懂 Docker 镜像的常用操作!](docs/tools/Docker-Image.md )

|

||||||

|

|

||||||

## 资料

|

### 其他

|

||||||

|

|

||||||

### 书单

|

- [【原创】如何使用云服务器?希望这篇文章能够对你有帮助!](https://mp.weixin.qq.com/s?__biz=Mzg2OTA0Njk0OA==&mid=2247485738&idx=1&sn=f97e91a50e444944076c30b0717b303a&chksm=cea246e1f9d5cff73faf6a778b147ea85162d1f3ed55ca90473c6ebae1e2c4d13e89282aeb24&token=406194678&lang=zh_CN#rd)

|

||||||

|

|

||||||

- [Java程序员必备书单](docs/essential-content-for-interview/PreparingForInterview/books.md)

|

## 面试指南

|

||||||

|

|

||||||

### Github榜单

|

> 这部分很多内容比如大厂面经、真实面经分析被移除,详见[完结撒花!JavaGuide面试突击版来啦!](./docs/javaguide面试突击版.md)。

|

||||||

|

|

||||||

- [Java 项目月榜单](docs/github-trending/JavaGithubTrending.md)

|

1. **[【备战面试1】程序员的简历就该这样写](docs/essential-content-for-interview/PreparingForInterview/程序员的简历之道.md)**

|

||||||

|

2. **[【备战面试2】初出茅庐的程序员该如何准备面试?](docs/essential-content-for-interview/PreparingForInterview/interviewPrepare.md)**

|

||||||

|

3. **[【备战面试3】7个大部分程序员在面试前很关心的问题](docs/essential-content-for-interview/PreparingForInterview/JavaProgrammerNeedKnow.md)**

|

||||||

|

4. **[【备战面试4】Github上开源的Java面试/学习相关的仓库推荐](docs/essential-content-for-interview/PreparingForInterview/JavaInterviewLibrary.md)**

|

||||||

|

5. **[【备战面试5】如果面试官问你“你有什么问题问我吗?”时,你该如何回答](docs/essential-content-for-interview/PreparingForInterview/面试官-你有什么问题要问我.md)**

|

||||||

|

6. [【备战面试6】应届生面试最爱问的几道 Java 基础问题](docs/essential-content-for-interview/PreparingForInterview/应届生面试最爱问的几道Java基础问题.md)

|

||||||

|

7. **[【备战面试6】美团面试常见问题总结(附详解答案)](docs/essential-content-for-interview/PreparingForInterview/美团面试常见问题总结.md)**

|

||||||

|

|

||||||

## 闲谈

|

## Java学习常见问题汇总

|

||||||

|

|

||||||

* [如何提问](docs/chat/如何提问.md)

|

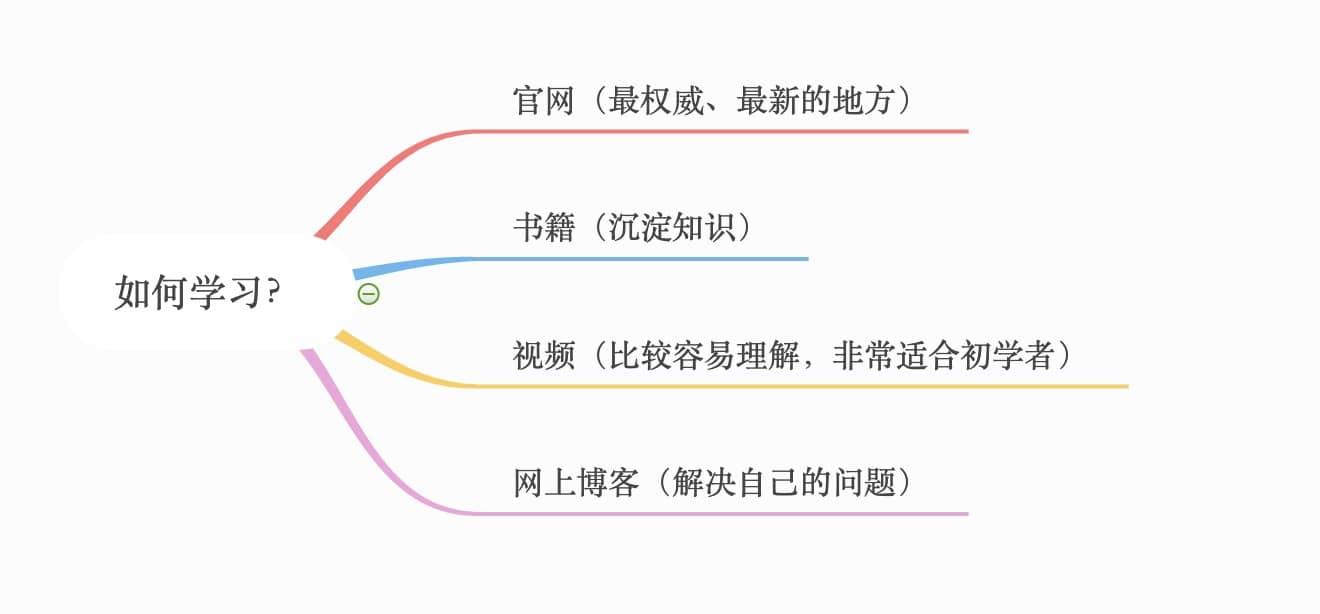

1. [Java学习路线和方法推荐](docs/questions/java-learning-path-and-methods.md)

|

||||||

* [选择技术方向都要考虑哪些因素](docs/chat/选择技术方向都要考虑哪些因素.md)

|

2. [Java培训四个月能学会吗?](docs/questions/java-training-4-month.md)

|

||||||

* [结束了我短暂的秋招,说点自己的感受](docs/chat/2018%20%E7%A7%8B%E6%8B%9B.md)

|

3. [新手学习Java,有哪些Java相关的博客,专栏,和技术学习网站推荐?](docs/questions/java-learning-website-blog.md)

|

||||||

|

4. [Java 还是大数据,你需要了解这些东西!](docs/questions/java-big-data)

|

||||||

|

5. [Java 后台开发/大数据?你需要了解这些东西!](https://articles.zsxq.com/id_wto1iwd5g72o.html)(知识星球)

|

||||||

|

|

||||||

|

## 资源

|

||||||

|

|

||||||

|

### 书单推荐

|

||||||

|

|

||||||

|

- **[Java程序员必备书单](docs/books/java.md)**

|

||||||

|

|

||||||

|

### 实战项目推荐

|

||||||

|

|

||||||

|

- **[Java、SpringBoot实战项目推荐](https://github.com/Snailclimb/awesome-java#实战项目)**

|

||||||

|

|

||||||

|

### Github

|

||||||

|

|

||||||

|

- [Github 上非常棒的 Java 开源项目集合](https://github.com/Snailclimb/awesome-java)

|

||||||

|

- [Github 上 Star 数最多的 10 个项目,看完之后很意外!](docs/tools/github/github-star-ranking.md)

|

||||||

|

- [年末将至,值得你关注的16个Java 开源项目!](docs/github-trending/2019-12.md)

|

||||||

|

- [Java 项目历史月榜单](docs/github-trending/JavaGithubTrending.md)

|

||||||

|

|

||||||

***

|

***

|

||||||

|

|

||||||

## 待办

|

## 待办

|

||||||

|

|

||||||

- [x] [Java 8 新特性总结](docs/java/What's%20New%20in%20JDK8/Java8Tutorial.md)

|

- [ ] Netty 总结(---正在进行中---)

|

||||||

- [ ] Java 8 新特性详解

|

- [ ] 数据结构总结重构(---正在进行中---)

|

||||||

- [ ] Java 多线程类别知识重构

|

|

||||||

- [x] [BIO,NIO,AIO 总结 ](docs/java/BIO-NIO-AIO.md)

|

|

||||||

- [ ] Netty 总结

|

|

||||||

- [ ] 数据结构总结重构

|

|

||||||

|

|

||||||

## 说明

|

## 说明

|

||||||

|

|

||||||

### 介绍

|

开源项目在于大家的参与,这才使得它的价值得到提升。感谢🙏有你!

|

||||||

|

|

||||||

|

### JavaGuide介绍

|

||||||

|

|

||||||

|

开源 JavaGuide 初始想法源于自己的个人那一段比较迷茫的学习经历。主要目的是为了通过这个开源平台来帮助一些在学习 Java 或者面试过程中遇到问题的小伙伴。

|

||||||

|

|

||||||

* **对于 Java 初学者来说:** 本文档倾向于给你提供一个比较详细的学习路径,让你对于Java整体的知识体系有一个初步认识。另外,本文的一些文章

|

* **对于 Java 初学者来说:** 本文档倾向于给你提供一个比较详细的学习路径,让你对于Java整体的知识体系有一个初步认识。另外,本文的一些文章

|

||||||

也是你学习和复习 Java 知识不错的实践;

|

也是你学习和复习 Java 知识不错的实践;

|

||||||

@ -255,7 +414,7 @@

|

|||||||

|

|

||||||

Markdown 格式参考:[Github Markdown格式](https://guides.github.com/features/mastering-markdown/),表情素材来自:[EMOJI CHEAT SHEET](https://www.webpagefx.com/tools/emoji-cheat-sheet/)。

|

Markdown 格式参考:[Github Markdown格式](https://guides.github.com/features/mastering-markdown/),表情素材来自:[EMOJI CHEAT SHEET](https://www.webpagefx.com/tools/emoji-cheat-sheet/)。

|

||||||

|

|

||||||

利用 docsify 生成文档部署在 Github pages: [docsify 官网介绍](https://docsify.js.org/#/)

|

利用 docsify 生成文档部署在 Github pages: [docsify 官网介绍](https://docsify.js.org/#/) ,另见[《Guide哥手把手教你搭建一个文档类型的网站!免费且高速!》](https://mp.weixin.qq.com/s?__biz=Mzg2OTA0Njk0OA==&mid=2247486555&idx=2&sn=8486026ee9f9ba645ff0363df6036184&chksm=cea24390f9d5ca86ff4177c0aca5e719de17dc89e918212513ee661dd56f17ca8269f4a6e303&token=298703358&lang=zh_CN#rd) 。

|

||||||

|

|

||||||

### 关于转载

|

### 关于转载

|

||||||

|

|

||||||

@ -265,40 +424,39 @@ Markdown 格式参考:[Github Markdown格式](https://guides.github.com/featur

|

|||||||

|

|

||||||

1. 笔记内容大多是手敲,所以难免会有笔误,你可以帮我找错别字。

|

1. 笔记内容大多是手敲,所以难免会有笔误,你可以帮我找错别字。

|

||||||

2. 很多知识点我可能没有涉及到,所以你可以对其他知识点进行补充。

|

2. 很多知识点我可能没有涉及到,所以你可以对其他知识点进行补充。

|

||||||

3. 现有的知识点难免存在不完善或者错误,所以你可以对已有知识点的修改/补充。

|

3. 现有的知识点难免存在不完善或者错误,所以你可以对已有知识点进行修改/补充。

|

||||||

|

|

||||||

### 为什么要做这个开源文档?

|

|

||||||

|

|

||||||

初始想法源于自己的个人那一段比较迷茫的学习经历。主要目的是为了通过这个开源平台来帮助一些在学习 Java 或者面试过程中遇到问题的小伙伴。

|

|

||||||

|

|

||||||

### 投稿

|

|

||||||

|

|

||||||

由于我个人能力有限,很多知识点我可能没有涉及到,所以你可以对其他知识点进行补充。大家也可以对自己的文章进行自荐,对于不错的文章不仅可以成功在本仓库展示出来更可以获得作者送出的 50 元左右的任意书籍进行奖励(当然你也可以直接折现50元)。

|

|

||||||

|

|

||||||

### 联系我

|

### 联系我

|

||||||

|

|

||||||

添加我的微信备注“Github”,回复关键字 **“加群”** 即可入群。

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

### Contributor

|

### Contributor

|

||||||

|

|

||||||

下面是笔主收集的一些对本仓库提过有价值的pr或者issue的朋友,人数较多,如果你也对本仓库提过不错的pr或者issue的话,你可以加我的微信与我联系。下面的排名不分先后!

|

下面是笔主收集的一些对本仓库提过有价值的pr或者issue的朋友,人数较多,如果你也对本仓库提过不错的pr或者issue的话,你可以加我的微信与我联系。下面的排名不分先后!

|

||||||

|

|

||||||

|

|

||||||

<a href="https://github.com/spikesp">

|

|

||||||

<img src="https://avatars0.githubusercontent.com/u/12581996?s=460&v=4" width="45px"></a>

|

|

||||||

<a href="https://github.com/fanofxiaofeng">

|

<a href="https://github.com/fanofxiaofeng">

|

||||||

<img src="https://avatars0.githubusercontent.com/u/3983683?s=460&v=4" width="45px"></a>

|

<img src="https://avatars0.githubusercontent.com/u/3983683?s=460&v=4" width="45px">

|

||||||

<a href="https://github.com/Gene1994">

|

|

||||||

<img src="https://avatars3.githubusercontent.com/u/24930369?s=460&v=4" width="45px">

|

|

||||||

</a>

|

|

||||||

<a href="https://github.com/illusorycloud">

|

|

||||||

<img src="https://avatars3.githubusercontent.com/u/31980412?s=460&v=4" width="45px">

|

|

||||||

</a>

|

</a>

|

||||||

<a href="https://github.com/LiWenGu">

|

<a href="https://github.com/LiWenGu">

|

||||||

<img src="https://avatars0.githubusercontent.com/u/15909210?s=460&v=4" width="45px">

|

<img src="https://avatars0.githubusercontent.com/u/15909210?s=460&v=4" width="45px">

|

||||||

</a>

|

</a>

|

||||||

|

<a href="https://github.com/fanchenggang">

|

||||||

|

<img src="https://avatars2.githubusercontent.com/u/8225921?s=460&v=4" width="45px">

|

||||||

|

</a>

|

||||||

|

<a href="https://github.com/Rustin-Liu">

|

||||||

|

<img src="https://avatars2.githubusercontent.com/u/29879298?s=400&v=4" width="45px">

|

||||||

|

</a>

|

||||||

|

|

||||||

|

<a href="https://github.com/ipofss">

|

||||||

|

<img src="https://avatars1.githubusercontent.com/u/5917359?s=460&v=4" width="45px"></a>

|

||||||

|

<a href="https://github.com/Gene1994">

|

||||||

|

<img src="https://avatars3.githubusercontent.com/u/24930369?s=460&v=4" width="45px">

|

||||||

|

</a>

|

||||||

|

<a href="https://github.com/spikesp">

|

||||||

|

<img src="https://avatars0.githubusercontent.com/u/12581996?s=460&v=4" width="45px"></a>

|

||||||

|

<a href="https://github.com/illusorycloud">

|

||||||

|

<img src="https://avatars3.githubusercontent.com/u/31980412?s=460&v=4" width="45px">

|

||||||

|

</a>

|

||||||

<a href="https://github.com/kinglaw1204">

|

<a href="https://github.com/kinglaw1204">

|

||||||

<img src="https://avatars1.githubusercontent.com/u/20039931?s=460&v=4" width="45px">

|

<img src="https://avatars1.githubusercontent.com/u/20039931?s=460&v=4" width="45px">

|

||||||

</a>

|

</a>

|

||||||

@ -320,6 +478,12 @@ Markdown 格式参考:[Github Markdown格式](https://guides.github.com/featur

|

|||||||

<a href="https://github.com/yuechuanx">

|

<a href="https://github.com/yuechuanx">

|

||||||

<img src="https://avatars3.githubusercontent.com/u/19339293?s=460&v=4" width="45px">

|

<img src="https://avatars3.githubusercontent.com/u/19339293?s=460&v=4" width="45px">

|

||||||

</a>

|

</a>

|

||||||

|

<a href="https://github.com/cnLGMing">

|

||||||

|

<img src="https://avatars2.githubusercontent.com/u/15910705?s=460&v=4" width="45px">