mirror of

https://github.com/Snailclimb/JavaGuide

synced 2025-08-01 16:28:03 +08:00

docs: add linter

This commit is contained in:

parent

893c673f1c

commit

6bdc809e2f

19

.markdownlint.json

Normal file

19

.markdownlint.json

Normal file

@ -0,0 +1,19 @@

|

|||||||

|

{

|

||||||

|

"default": true,

|

||||||

|

"MD003": {

|

||||||

|

"style": "atx"

|

||||||

|

},

|

||||||

|

"MD004": {

|

||||||

|

"style": "dash"

|

||||||

|

},

|

||||||

|

"MD013": false,

|

||||||

|

"MD024": {

|

||||||

|

"allow_different_nesting": true

|

||||||

|

},

|

||||||

|

"MD035": {

|

||||||

|

"style": "---"

|

||||||

|

},

|

||||||

|

"MD040": false,

|

||||||

|

"MD046": false,

|

||||||

|

"MD049": false

|

||||||

|

}

|

||||||

4

.markdownlintignore

Normal file

4

.markdownlintignore

Normal file

@ -0,0 +1,4 @@

|

|||||||

|

**/node_modules/**

|

||||||

|

|

||||||

|

# markdown snippets

|

||||||

|

*.snippet.md

|

||||||

15

.prettierignore

Normal file

15

.prettierignore

Normal file

@ -0,0 +1,15 @@

|

|||||||

|

# Vuepress Cache

|

||||||

|

**/.vuepress/.cache/**

|

||||||

|

# Vuepress Temp

|

||||||

|

**/.vuepress/.temp/**

|

||||||

|

# Vuepress Output

|

||||||

|

dist/

|

||||||

|

|

||||||

|

# Node modules

|

||||||

|

node_modules/

|

||||||

|

|

||||||

|

# pnpm lock file

|

||||||

|

pnpm-lock.yaml

|

||||||

|

|

||||||

|

index.html

|

||||||

|

sw.js

|

||||||

@ -2,7 +2,11 @@ import { navbar } from "vuepress-theme-hope";

|

|||||||

|

|

||||||

export default navbar([

|

export default navbar([

|

||||||

{ text: "面试指南", icon: "java", link: "/home.md" },

|

{ text: "面试指南", icon: "java", link: "/home.md" },

|

||||||

{ text: "知识星球", icon: "code", link: "/about-the-author/zhishixingqiu-two-years.md" },

|

{

|

||||||

|

text: "知识星球",

|

||||||

|

icon: "code",

|

||||||

|

link: "/about-the-author/zhishixingqiu-two-years.md",

|

||||||

|

},

|

||||||

{ text: "开源项目", icon: "github", link: "/open-source-project/" },

|

{ text: "开源项目", icon: "github", link: "/open-source-project/" },

|

||||||

{ text: "技术书籍", icon: "book", link: "/books/" },

|

{ text: "技术书籍", icon: "book", link: "/books/" },

|

||||||

{

|

{

|

||||||

|

|||||||

@ -76,8 +76,8 @@ public ListNode addTwoNumbers(ListNode l1, ListNode l2) {

|

|||||||

|

|

||||||

## 2. 翻转链表

|

## 2. 翻转链表

|

||||||

|

|

||||||

|

|

||||||

### 题目描述

|

### 题目描述

|

||||||

|

|

||||||

> 剑指 offer:输入一个链表,反转链表后,输出链表的所有元素。

|

> 剑指 offer:输入一个链表,反转链表后,输出链表的所有元素。

|

||||||

|

|

||||||

|

|

||||||

@ -88,7 +88,6 @@ public ListNode addTwoNumbers(ListNode l1, ListNode l2) {

|

|||||||

|

|

||||||

### Solution

|

### Solution

|

||||||

|

|

||||||

|

|

||||||

```java

|

```java

|

||||||

public class ListNode {

|

public class ListNode {

|

||||||

int val;

|

int val;

|

||||||

@ -174,7 +173,6 @@ public class Solution {

|

|||||||

|

|

||||||

首先两个节点/指针,一个节点 node1 先开始跑,指针 node1 跑到 k-1 个节点后,另一个节点 node2 开始跑,当 node1 跑到最后时,node2 所指的节点就是倒数第 k 个节点也就是正数第(L-K+1)个节点。

|

首先两个节点/指针,一个节点 node1 先开始跑,指针 node1 跑到 k-1 个节点后,另一个节点 node2 开始跑,当 node1 跑到最后时,node2 所指的节点就是倒数第 k 个节点也就是正数第(L-K+1)个节点。

|

||||||

|

|

||||||

|

|

||||||

### Solution

|

### Solution

|

||||||

|

|

||||||

```java

|

```java

|

||||||

@ -221,10 +219,8 @@ public class Solution {

|

|||||||

}

|

}

|

||||||

```

|

```

|

||||||

|

|

||||||

|

|

||||||

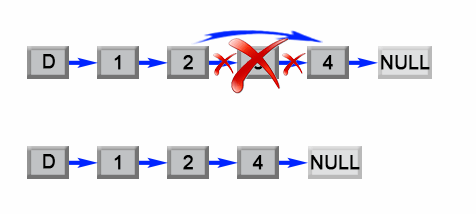

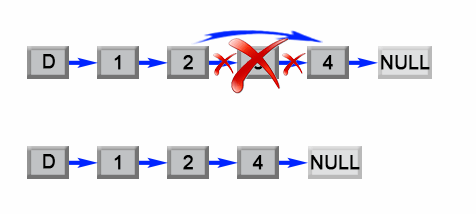

## 4. 删除链表的倒数第 N 个节点

|

## 4. 删除链表的倒数第 N 个节点

|

||||||

|

|

||||||

|

|

||||||

> Leetcode:给定一个链表,删除链表的倒数第 n 个节点,并且返回链表的头结点。

|

> Leetcode:给定一个链表,删除链表的倒数第 n 个节点,并且返回链表的头结点。

|

||||||

|

|

||||||

**示例:**

|

**示例:**

|

||||||

@ -248,7 +244,6 @@ public class Solution {

|

|||||||

|

|

||||||

### 问题分析

|

### 问题分析

|

||||||

|

|

||||||

|

|

||||||

我们注意到这个问题可以容易地简化成另一个问题:删除从列表开头数起的第 (L - n + 1)个结点,其中 L 是列表的长度。只要我们找到列表的长度 L,这个问题就很容易解决。

|

我们注意到这个问题可以容易地简化成另一个问题:删除从列表开头数起的第 (L - n + 1)个结点,其中 L 是列表的长度。只要我们找到列表的长度 L,这个问题就很容易解决。

|

||||||

|

|

||||||

|

|

||||||

@ -301,11 +296,8 @@ public class Solution {

|

|||||||

- **时间复杂度 O(L)** :该算法对列表进行了两次遍历,首先计算了列表的长度 LL 其次找到第 (L - n)(L−n) 个结点。 操作执行了 2L-n2L−n 步,时间复杂度为 O(L)O(L)。

|

- **时间复杂度 O(L)** :该算法对列表进行了两次遍历,首先计算了列表的长度 LL 其次找到第 (L - n)(L−n) 个结点。 操作执行了 2L-n2L−n 步,时间复杂度为 O(L)O(L)。

|

||||||

- **空间复杂度 O(1)** :我们只用了常量级的额外空间。

|

- **空间复杂度 O(1)** :我们只用了常量级的额外空间。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

**进阶——一次遍历法:**

|

**进阶——一次遍历法:**

|

||||||

|

|

||||||

|

|

||||||

> 链表中倒数第 N 个节点也就是正数第(L-N+1)个节点。

|

> 链表中倒数第 N 个节点也就是正数第(L-N+1)个节点。

|

||||||

|

|

||||||

其实这种方法就和我们上面第四题找“链表中倒数第 k 个节点”所用的思想是一样的。**基本思路就是:** 定义两个节点 node1、node2;node1 节点先跑,node1 节点 跑到第 n+1 个节点的时候,node2 节点开始跑.当 node1 节点跑到最后一个节点时,node2 节点所在的位置就是第 (L-n ) 个节点(L 代表总链表长度,也就是倒数第 n+1 个节点)

|

其实这种方法就和我们上面第四题找“链表中倒数第 k 个节点”所用的思想是一样的。**基本思路就是:** 定义两个节点 node1、node2;node1 节点先跑,node1 节点 跑到第 n+1 个节点的时候,node2 节点开始跑.当 node1 节点跑到最后一个节点时,node2 节点所在的位置就是第 (L-n ) 个节点(L 代表总链表长度,也就是倒数第 n+1 个节点)

|

||||||

@ -345,10 +337,6 @@ public class Solution {

|

|||||||

}

|

}

|

||||||

```

|

```

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

## 5. 合并两个排序的链表

|

## 5. 合并两个排序的链表

|

||||||

|

|

||||||

### 题目描述

|

### 题目描述

|

||||||

@ -400,4 +388,3 @@ public ListNode Merge(ListNode list1,ListNode list2) {

|

|||||||

}

|

}

|

||||||

}

|

}

|

||||||

```

|

```

|

||||||

|

|

||||||

|

|||||||

@ -116,7 +116,7 @@ int jumpFloor(int number) {

|

|||||||

所以在 n>=2 的情况下:

|

所以在 n>=2 的情况下:

|

||||||

f(n)=f(n-1)+f(n-2)+...+f(1)

|

f(n)=f(n-1)+f(n-2)+...+f(1)

|

||||||

因为 f(n-1)=f(n-2)+f(n-3)+...+f(1)

|

因为 f(n-1)=f(n-2)+f(n-3)+...+f(1)

|

||||||

所以f(n)=2*f(n-1) 又f(1)=1,所以可得**f(n)=2^(number-1)**

|

所以 f(n)=2\*f(n-1) 又 f(1)=1,所以可得**f(n)=2^(number-1)**

|

||||||

|

|

||||||

**示例代码:**

|

**示例代码:**

|

||||||

|

|

||||||

@ -140,7 +140,6 @@ int b = a << 2;//左移2,等同于16 * 2的2次方,也就是16 * 4

|

|||||||

int c = a >> 2;//右移2,等同于16 / 2的2次方,也就是16 / 4

|

int c = a >> 2;//右移2,等同于16 / 2的2次方,也就是16 / 4

|

||||||

```

|

```

|

||||||

|

|

||||||

|

|

||||||

## 二维数组查找

|

## 二维数组查找

|

||||||

|

|

||||||

**题目描述:**

|

**题目描述:**

|

||||||

@ -228,12 +227,9 @@ public String replaceSpace(StringBuffer str) {

|

|||||||

**问题解析:**

|

**问题解析:**

|

||||||

|

|

||||||

这道题算是比较麻烦和难一点的一个了。我这里采用的是**二分幂**思想,当然也可以采用**快速幂**。

|

这道题算是比较麻烦和难一点的一个了。我这里采用的是**二分幂**思想,当然也可以采用**快速幂**。

|

||||||

更具剑指offer书中细节,该题的解题思路如下:

|

更具剑指 offer 书中细节,该题的解题思路如下: 1.当底数为 0 且指数<0 时,会出现对 0 求倒数的情况,需进行错误处理,设置一个全局变量; 2.判断底数是否等于 0,由于 base 为 double 型,所以不能直接用==判断 3.优化求幂函数(二分幂)。

|

||||||

1.当底数为0且指数<0时,会出现对0求倒数的情况,需进行错误处理,设置一个全局变量;

|

当 n 为偶数,a^n =(a^n/2)_(a^n/2);

|

||||||

2.判断底数是否等于0,由于base为double型,所以不能直接用==判断

|

当 n 为奇数,a^n = a^[(n-1)/2] _ a^[(n-1)/2] \* a。时间复杂度 O(logn)

|

||||||

3.优化求幂函数(二分幂)。

|

|

||||||

当n为偶数,a^n =(a^n/2)*(a^n/2);

|

|

||||||

当n为奇数,a^n = a^[(n-1)/2] * a^[(n-1)/2] * a。时间复杂度O(logn)

|

|

||||||

|

|

||||||

**时间复杂度**:O(logn)

|

**时间复杂度**:O(logn)

|

||||||

|

|

||||||

|

|||||||

@ -57,7 +57,6 @@ tag:

|

|||||||

1. 判断给定数据是否存在:比如判断一个数字是否存在于包含大量数字的数字集中(数字集很大,5 亿以上!)、 防止缓存穿透(判断请求的数据是否有效避免直接绕过缓存请求数据库)等等、邮箱的垃圾邮件过滤、黑名单功能等等。

|

1. 判断给定数据是否存在:比如判断一个数字是否存在于包含大量数字的数字集中(数字集很大,5 亿以上!)、 防止缓存穿透(判断请求的数据是否有效避免直接绕过缓存请求数据库)等等、邮箱的垃圾邮件过滤、黑名单功能等等。

|

||||||

2. 去重:比如爬给定网址的时候对已经爬取过的 URL 去重。

|

2. 去重:比如爬给定网址的时候对已经爬取过的 URL 去重。

|

||||||

|

|

||||||

|

|

||||||

## 编码实战

|

## 编码实战

|

||||||

|

|

||||||

### 通过 Java 编程手动实现布隆过滤器

|

### 通过 Java 编程手动实现布隆过滤器

|

||||||

@ -245,9 +244,9 @@ Redis v4.0 之后有了 Module(模块/插件) 功能,Redis Modules 让 Red

|

|||||||

另外,官网推荐了一个 RedisBloom 作为 Redis 布隆过滤器的 Module,地址:https://github.com/RedisBloom/RedisBloom

|

另外,官网推荐了一个 RedisBloom 作为 Redis 布隆过滤器的 Module,地址:https://github.com/RedisBloom/RedisBloom

|

||||||

其他还有:

|

其他还有:

|

||||||

|

|

||||||

* redis-lua-scaling-bloom-filter(lua 脚本实现):https://github.com/erikdubbelboer/redis-lua-scaling-bloom-filter

|

- redis-lua-scaling-bloom-filter(lua 脚本实现):https://github.com/erikdubbelboer/redis-lua-scaling-bloom-filter

|

||||||

* pyreBloom(Python 中的快速 Redis 布隆过滤器) :https://github.com/seomoz/pyreBloom

|

- pyreBloom(Python 中的快速 Redis 布隆过滤器) :https://github.com/seomoz/pyreBloom

|

||||||

* ......

|

- ......

|

||||||

|

|

||||||

RedisBloom 提供了多种语言的客户端支持,包括:Python、Java、JavaScript 和 PHP。

|

RedisBloom 提供了多种语言的客户端支持,包括:Python、Java、JavaScript 和 PHP。

|

||||||

|

|

||||||

@ -287,7 +286,7 @@ root@21396d02c252:/data# redis-cli

|

|||||||

|

|

||||||

可选参数:

|

可选参数:

|

||||||

|

|

||||||

* expansion:如果创建了一个新的子过滤器,则其大小将是当前过滤器的大小乘以`expansion`。默认扩展值为 2。这意味着每个后续子过滤器将是前一个子过滤器的两倍。

|

- expansion:如果创建了一个新的子过滤器,则其大小将是当前过滤器的大小乘以`expansion`。默认扩展值为 2。这意味着每个后续子过滤器将是前一个子过滤器的两倍。

|

||||||

|

|

||||||

### 实际使用

|

### 实际使用

|

||||||

|

|

||||||

|

|||||||

@ -25,21 +25,25 @@ tag:

|

|||||||

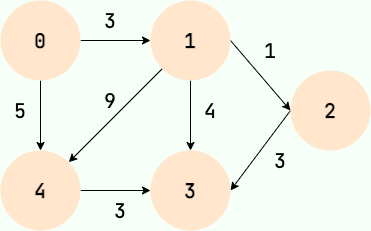

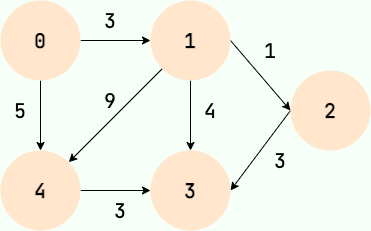

## 图的基本概念

|

## 图的基本概念

|

||||||

|

|

||||||

### 顶点

|

### 顶点

|

||||||

|

|

||||||

图中的数据元素,我们称之为顶点,图至少有一个顶点(非空有穷集合)

|

图中的数据元素,我们称之为顶点,图至少有一个顶点(非空有穷集合)

|

||||||

|

|

||||||

对应到好友关系图,每一个用户就代表一个顶点。

|

对应到好友关系图,每一个用户就代表一个顶点。

|

||||||

|

|

||||||

### 边

|

### 边

|

||||||

|

|

||||||

顶点之间的关系用边表示。

|

顶点之间的关系用边表示。

|

||||||

|

|

||||||

对应到好友关系图,两个用户是好友的话,那两者之间就存在一条边。

|

对应到好友关系图,两个用户是好友的话,那两者之间就存在一条边。

|

||||||

|

|

||||||

### 度

|

### 度

|

||||||

|

|

||||||

度表示一个顶点包含多少条边,在有向图中,还分为出度和入度,出度表示从该顶点出去的边的条数,入度表示进入该顶点的边的条数。

|

度表示一个顶点包含多少条边,在有向图中,还分为出度和入度,出度表示从该顶点出去的边的条数,入度表示进入该顶点的边的条数。

|

||||||

|

|

||||||

对应到好友关系图,度就代表了某个人的好友数量。

|

对应到好友关系图,度就代表了某个人的好友数量。

|

||||||

|

|

||||||

### 无向图和有向图

|

### 无向图和有向图

|

||||||

|

|

||||||

边表示的是顶点之间的关系,有的关系是双向的,比如同学关系,A 是 B 的同学,那么 B 也肯定是 A 的同学,那么在表示 A 和 B 的关系时,就不用关注方向,用不带箭头的边表示,这样的图就是无向图。

|

边表示的是顶点之间的关系,有的关系是双向的,比如同学关系,A 是 B 的同学,那么 B 也肯定是 A 的同学,那么在表示 A 和 B 的关系时,就不用关注方向,用不带箭头的边表示,这样的图就是无向图。

|

||||||

|

|

||||||

有的关系是有方向的,比如父子关系,师生关系,微博的关注关系,A 是 B 的爸爸,但 B 肯定不是 A 的爸爸,A 关注 B,B 不一定关注 A。在这种情况下,我们就用带箭头的边表示二者的关系,这样的图就是有向图。

|

有的关系是有方向的,比如父子关系,师生关系,微博的关注关系,A 是 B 的爸爸,但 B 肯定不是 A 的爸爸,A 关注 B,B 不一定关注 A。在这种情况下,我们就用带箭头的边表示二者的关系,这样的图就是有向图。

|

||||||

@ -55,7 +59,9 @@ tag:

|

|||||||

|

|

||||||

|

|

||||||

## 图的存储

|

## 图的存储

|

||||||

|

|

||||||

### 邻接矩阵存储

|

### 邻接矩阵存储

|

||||||

|

|

||||||

邻接矩阵将图用二维矩阵存储,是一种较为直观的表示方式。

|

邻接矩阵将图用二维矩阵存储,是一种较为直观的表示方式。

|

||||||

|

|

||||||

如果第 i 个顶点和第 j 个顶点之间有关系,且关系权值为 n,则 `A[i][j]=n` 。

|

如果第 i 个顶点和第 j 个顶点之间有关系,且关系权值为 n,则 `A[i][j]=n` 。

|

||||||

@ -86,7 +92,9 @@ tag:

|

|||||||

- 在有向图中,邻接表元素个数等于边的条数,如右图所示的有向图中,边的条数为 8,邻接表存储的元素个数为 8。

|

- 在有向图中,邻接表元素个数等于边的条数,如右图所示的有向图中,边的条数为 8,邻接表存储的元素个数为 8。

|

||||||

|

|

||||||

## 图的搜索

|

## 图的搜索

|

||||||

|

|

||||||

### 广度优先搜索

|

### 广度优先搜索

|

||||||

|

|

||||||

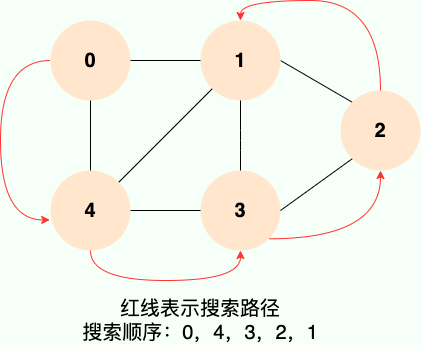

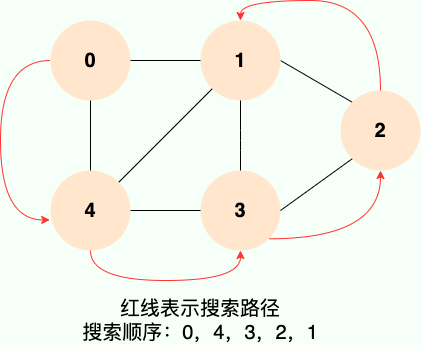

广度优先搜索就像水面上的波纹一样一层一层向外扩展,如下图所示:

|

广度优先搜索就像水面上的波纹一样一层一层向外扩展,如下图所示:

|

||||||

|

|

||||||

|

|

||||||

@ -123,7 +131,6 @@ tag:

|

|||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

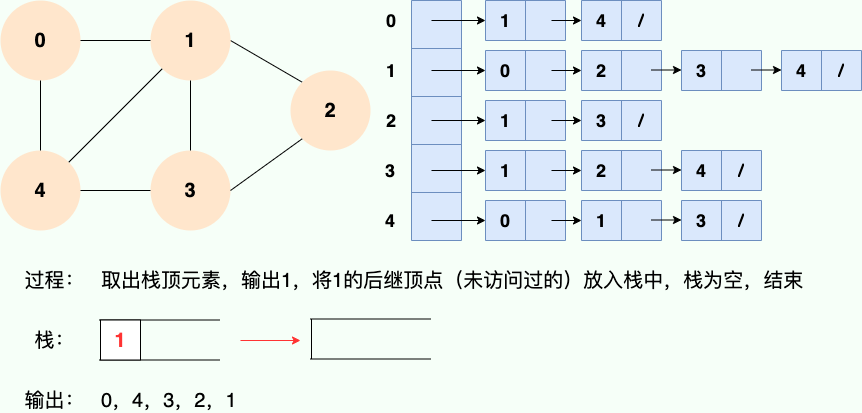

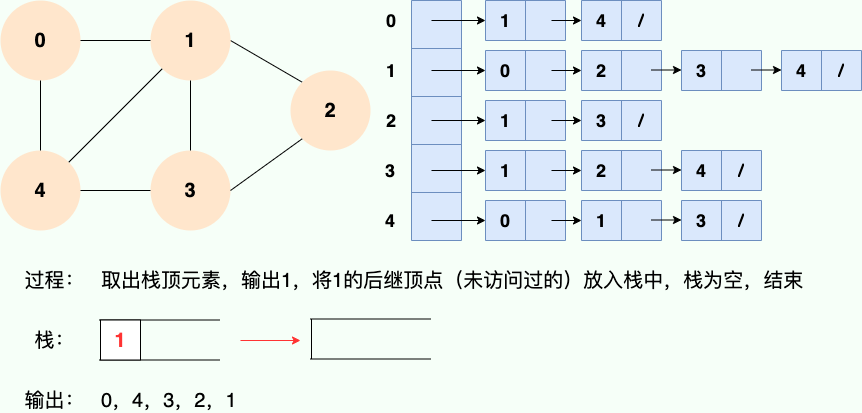

**和广度优先搜索类似,深度优先搜索的具体实现用到了另一种线性数据结构——栈** 。具体过程如下图所示:

|

**和广度优先搜索类似,深度优先搜索的具体实现用到了另一种线性数据结构——栈** 。具体过程如下图所示:

|

||||||

|

|

||||||

**第 1 步:**

|

**第 1 步:**

|

||||||

@ -149,4 +156,3 @@ tag:

|

|||||||

**第 6 步:**

|

**第 6 步:**

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|||||||

@ -28,6 +28,7 @@ tag:

|

|||||||

第 3 个不是,第三个中,根结点 1 比 2 和 15 小,而 15 却比 3 大,19 比 5 大,不满足堆的性质。

|

第 3 个不是,第三个中,根结点 1 比 2 和 15 小,而 15 却比 3 大,19 比 5 大,不满足堆的性质。

|

||||||

|

|

||||||

## 堆的用途

|

## 堆的用途

|

||||||

|

|

||||||

当我们只关心所有数据中的最大值或者最小值,存在多次获取最大值或者最小值,多次插入或删除数据时,就可以使用堆。

|

当我们只关心所有数据中的最大值或者最小值,存在多次获取最大值或者最小值,多次插入或删除数据时,就可以使用堆。

|

||||||

|

|

||||||

有小伙伴可能会想到用有序数组,初始化一个有序数组时间复杂度是 `O(nlog(n))`,查找最大值或者最小值时间复杂度都是 `O(1)`,但是,涉及到更新(插入或删除)数据时,时间复杂度为 `O(n)`,即使是使用复杂度为 `O(log(n))` 的二分法找到要插入或者删除的数据,在移动数据时也需要 `O(n)` 的时间复杂度。

|

有小伙伴可能会想到用有序数组,初始化一个有序数组时间复杂度是 `O(nlog(n))`,查找最大值或者最小值时间复杂度都是 `O(1)`,但是,涉及到更新(插入或删除)数据时,时间复杂度为 `O(n)`,即使是使用复杂度为 `O(log(n))` 的二分法找到要插入或者删除的数据,在移动数据时也需要 `O(n)` 的时间复杂度。

|

||||||

@ -39,6 +40,7 @@ tag:

|

|||||||

## 堆的分类

|

## 堆的分类

|

||||||

|

|

||||||

堆分为 **最大堆** 和 **最小堆**。二者的区别在于节点的排序方式。

|

堆分为 **最大堆** 和 **最小堆**。二者的区别在于节点的排序方式。

|

||||||

|

|

||||||

- **最大堆** :堆中的每一个节点的值都大于等于子树中所有节点的值

|

- **最大堆** :堆中的每一个节点的值都大于等于子树中所有节点的值

|

||||||

- **最小堆** :堆中的每一个节点的值都小于等于子树中所有节点的值

|

- **最小堆** :堆中的每一个节点的值都小于等于子树中所有节点的值

|

||||||

|

|

||||||

@ -46,8 +48,8 @@ tag:

|

|||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

## 堆的存储

|

## 堆的存储

|

||||||

|

|

||||||

之前介绍树的时候说过,由于完全二叉树的优秀性质,利用数组存储二叉树即节省空间,又方便索引(若根结点的序号为 1,那么对于树中任意节点 i,其左子节点序号为 `2*i`,右子节点序号为 `2*i+1`)。

|

之前介绍树的时候说过,由于完全二叉树的优秀性质,利用数组存储二叉树即节省空间,又方便索引(若根结点的序号为 1,那么对于树中任意节点 i,其左子节点序号为 `2*i`,右子节点序号为 `2*i+1`)。

|

||||||

|

|

||||||

为了方便存储和索引,(二叉)堆可以用完全二叉树的形式进行存储。存储的方式如下图所示:

|

为了方便存储和索引,(二叉)堆可以用完全二叉树的形式进行存储。存储的方式如下图所示:

|

||||||

@ -55,9 +57,13 @@ tag:

|

|||||||

|

|

||||||

|

|

||||||

## 堆的操作

|

## 堆的操作

|

||||||

|

|

||||||

堆的更新操作主要包括两种 : **插入元素** 和 **删除堆顶元素**。操作过程需要着重掌握和理解。

|

堆的更新操作主要包括两种 : **插入元素** 和 **删除堆顶元素**。操作过程需要着重掌握和理解。

|

||||||

|

|

||||||

> 在进入正题之前,再重申一遍,堆是一个公平的公司,有能力的人自然会走到与他能力所匹配的位置

|

> 在进入正题之前,再重申一遍,堆是一个公平的公司,有能力的人自然会走到与他能力所匹配的位置

|

||||||

|

|

||||||

### 插入元素

|

### 插入元素

|

||||||

|

|

||||||

> 插入元素,作为一个新入职的员工,初来乍到,这个员工需要从基层做起

|

> 插入元素,作为一个新入职的员工,初来乍到,这个员工需要从基层做起

|

||||||

|

|

||||||

**1.将要插入的元素放到最后**

|

**1.将要插入的元素放到最后**

|

||||||

@ -87,18 +93,14 @@ tag:

|

|||||||

|

|

||||||

首先删除堆顶元素,使得数组中下标为 1 的位置空出。

|

首先删除堆顶元素,使得数组中下标为 1 的位置空出。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

> 那么他的位置由谁来接替呢,当然是他的直接下属了,谁能力强就让谁上呗

|

> 那么他的位置由谁来接替呢,当然是他的直接下属了,谁能力强就让谁上呗

|

||||||

|

|

||||||

比较根结点的左子节点和右子节点,也就是下标为 2,3 的数组元素,将较大的元素填充到根结点(下标为 1)的位置。

|

比较根结点的左子节点和右子节点,也就是下标为 2,3 的数组元素,将较大的元素填充到根结点(下标为 1)的位置。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

> 这个时候又空出一个位置了,老规矩,谁有能力谁上

|

> 这个时候又空出一个位置了,老规矩,谁有能力谁上

|

||||||

|

|

||||||

一直循环比较空出位置的左右子节点,并将较大者移至空位,直到堆的最底部

|

一直循环比较空出位置的左右子节点,并将较大者移至空位,直到堆的最底部

|

||||||

@ -108,6 +110,7 @@ tag:

|

|||||||

这个时候已经完成了自底向上的堆化,没有元素可以填补空缺了,但是,我们可以看到数组中出现了“气泡”,这会导致存储空间的浪费。接下来我们试试自顶向下堆化。

|

这个时候已经完成了自底向上的堆化,没有元素可以填补空缺了,但是,我们可以看到数组中出现了“气泡”,这会导致存储空间的浪费。接下来我们试试自顶向下堆化。

|

||||||

|

|

||||||

#### 自顶向下堆化

|

#### 自顶向下堆化

|

||||||

|

|

||||||

自顶向下的堆化用一个词形容就是“石沉大海”,那么第一件事情,就是把石头抬起来,从海面扔下去。这个石头就是堆的最后一个元素,我们将最后一个元素移动到堆顶。

|

自顶向下的堆化用一个词形容就是“石沉大海”,那么第一件事情,就是把石头抬起来,从海面扔下去。这个石头就是堆的最后一个元素,我们将最后一个元素移动到堆顶。

|

||||||

|

|

||||||

|

|

||||||

@ -118,14 +121,11 @@ tag:

|

|||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

### 堆的操作总结

|

### 堆的操作总结

|

||||||

|

|

||||||

- **插入元素** :先将元素放至数组末尾,再自底向上堆化,将末尾元素上浮

|

- **插入元素** :先将元素放至数组末尾,再自底向上堆化,将末尾元素上浮

|

||||||

- **删除堆顶元素** :删除堆顶元素,将末尾元素放至堆顶,再自顶向下堆化,将堆顶元素下沉。也可以自底向上堆化,只是会产生“气泡”,浪费存储空间。最好采用自顶向下堆化的方式。

|

- **删除堆顶元素** :删除堆顶元素,将末尾元素放至堆顶,再自顶向下堆化,将堆顶元素下沉。也可以自底向上堆化,只是会产生“气泡”,浪费存储空间。最好采用自顶向下堆化的方式。

|

||||||

|

|

||||||

|

|

||||||

## 堆排序

|

## 堆排序

|

||||||

|

|

||||||

堆排序的过程分为两步:

|

堆排序的过程分为两步:

|

||||||

|

|||||||

@ -19,4 +19,3 @@ tag:

|

|||||||

**为什么要用红黑树?** 简单来说红黑树就是为了解决二叉查找树的缺陷,因为二叉查找树在某些情况下会退化成一个线性结构。详细了解可以查看 [漫画:什么是红黑树?](https://juejin.im/post/5a27c6946fb9a04509096248#comment)(也介绍到了二叉查找树,非常推荐)

|

**为什么要用红黑树?** 简单来说红黑树就是为了解决二叉查找树的缺陷,因为二叉查找树在某些情况下会退化成一个线性结构。详细了解可以查看 [漫画:什么是红黑树?](https://juejin.im/post/5a27c6946fb9a04509096248#comment)(也介绍到了二叉查找树,非常推荐)

|

||||||

|

|

||||||

**相关阅读** :[《红黑树深入剖析及 Java 实现》](https://zhuanlan.zhihu.com/p/24367771)(美团点评技术团队)

|

**相关阅读** :[《红黑树深入剖析及 Java 实现》](https://zhuanlan.zhihu.com/p/24367771)(美团点评技术团队)

|

||||||

|

|

||||||

|

|||||||

@ -38,7 +38,7 @@ tag:

|

|||||||

|

|

||||||

**二叉树** 的分支通常被称作“**左子树**”或“**右子树**”。并且,**二叉树** 的分支具有左右次序,不能随意颠倒。

|

**二叉树** 的分支通常被称作“**左子树**”或“**右子树**”。并且,**二叉树** 的分支具有左右次序,不能随意颠倒。

|

||||||

|

|

||||||

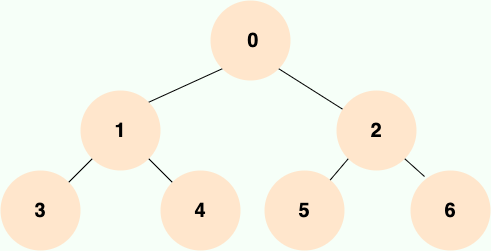

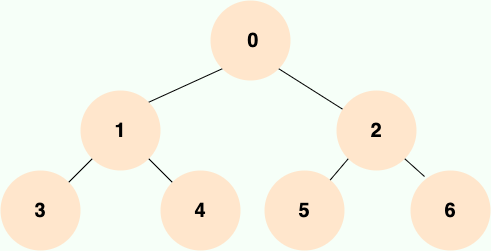

**二叉树** 的第 i 层至多拥有 `2^(i-1)` 个节点,深度为 k 的二叉树至多总共有 `2^(k+1)-1` 个节点(满二叉树的情况),至少有 2^(k) 个节点(关于节点的深度的定义国内争议比较多,我个人比较认可维基百科对[节点深度的定义](https://zh.wikipedia.org/wiki/%E6%A0%91_(%E6%95%B0%E6%8D%AE%E7%BB%93%E6%9E%84)#/%E6%9C%AF%E8%AF%AD))。

|

**二叉树** 的第 i 层至多拥有 `2^(i-1)` 个节点,深度为 k 的二叉树至多总共有 `2^(k+1)-1` 个节点(满二叉树的情况),至少有 2^(k) 个节点(关于节点的深度的定义国内争议比较多,我个人比较认可维基百科对[节点深度的定义](<https://zh.wikipedia.org/wiki/%E6%A0%91_(%E6%95%B0%E6%8D%AE%E7%BB%93%E6%9E%84)#/%E6%9C%AF%E8%AF%AD>))。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

@ -48,8 +48,6 @@ tag:

|

|||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

### 完全二叉树

|

### 完全二叉树

|

||||||

|

|

||||||

除最后一层外,若其余层都是满的,并且最后一层或者是满的,或者是在右边缺少连续若干节点,则这个二叉树就是 **完全二叉树** 。

|

除最后一层外,若其余层都是满的,并且最后一层或者是满的,或者是在右边缺少连续若干节点,则这个二叉树就是 **完全二叉树** 。

|

||||||

|

|||||||

@ -5,8 +5,6 @@ tag:

|

|||||||

- 计算机网络

|

- 计算机网络

|

||||||

---

|

---

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

## HTTP:超文本传输协议

|

## HTTP:超文本传输协议

|

||||||

|

|

||||||

**超文本传输协议(HTTP,HyperText Transfer Protocol)** 是一种用于传输超文本和多媒体内容的协议,主要是为 Web 浏览器与 Web 服务器之间的通信而设计的。当我们使用浏览器浏览网页的时候,我们网页就是通过 HTTP 请求进行加载的。

|

**超文本传输协议(HTTP,HyperText Transfer Protocol)** 是一种用于传输超文本和多媒体内容的协议,主要是为 Web 浏览器与 Web 服务器之间的通信而设计的。当我们使用浏览器浏览网页的时候,我们网页就是通过 HTTP 请求进行加载的。

|

||||||

|

|||||||

@ -5,7 +5,6 @@ tag:

|

|||||||

- 计算机网络

|

- 计算机网络

|

||||||

---

|

---

|

||||||

|

|

||||||

|

|

||||||

本文是我在大二学习计算机网络期间整理, 大部分内容都来自于谢希仁老师的[《计算机网络》第七版 ](https://www.elias.ltd/usr/local/etc/%E8%AE%A1%E7%AE%97%E6%9C%BA%E7%BD%91%E7%BB%9C%EF%BC%88%E7%AC%AC7%E7%89%88%EF%BC%89%E8%B0%A2%E5%B8%8C%E4%BB%81.pdf)这本书。为了内容更容易理解,我对之前的整理进行了一波重构,并配上了一些相关的示意图便于理解。

|

本文是我在大二学习计算机网络期间整理, 大部分内容都来自于谢希仁老师的[《计算机网络》第七版 ](https://www.elias.ltd/usr/local/etc/%E8%AE%A1%E7%AE%97%E6%9C%BA%E7%BD%91%E7%BB%9C%EF%BC%88%E7%AC%AC7%E7%89%88%EF%BC%89%E8%B0%A2%E5%B8%8C%E4%BB%81.pdf)这本书。为了内容更容易理解,我对之前的整理进行了一波重构,并配上了一些相关的示意图便于理解。

|

||||||

|

|

||||||

|

|

||||||

|

|||||||

@ -138,6 +138,3 @@ SSL/TLS 介绍到这里,了解信息安全的朋友又会想到一个安全隐

|

|||||||

- **端口号** :HTTP 默认是 80,HTTPS 默认是 443。

|

- **端口号** :HTTP 默认是 80,HTTPS 默认是 443。

|

||||||

- **URL 前缀** :HTTP 的 URL 前缀是 `http://`,HTTPS 的 URL 前缀是 `https://`。

|

- **URL 前缀** :HTTP 的 URL 前缀是 `http://`,HTTPS 的 URL 前缀是 `https://`。

|

||||||

- **安全性和资源消耗** : HTTP 协议运行在 TCP 之上,所有传输的内容都是明文,客户端和服务器端都无法验证对方的身份。HTTPS 是运行在 SSL/TLS 之上的 HTTP 协议,SSL/TLS 运行在 TCP 之上。所有传输的内容都经过加密,加密采用对称加密,但对称加密的密钥用服务器方的证书进行了非对称加密。所以说,HTTP 安全性没有 HTTPS 高,但是 HTTPS 比 HTTP 耗费更多服务器资源。

|

- **安全性和资源消耗** : HTTP 协议运行在 TCP 之上,所有传输的内容都是明文,客户端和服务器端都无法验证对方的身份。HTTPS 是运行在 SSL/TLS 之上的 HTTP 协议,SSL/TLS 运行在 TCP 之上。所有传输的内容都经过加密,加密采用对称加密,但对称加密的密钥用服务器方的证书进行了非对称加密。所以说,HTTP 安全性没有 HTTPS 高,但是 HTTPS 比 HTTP 耗费更多服务器资源。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|||||||

@ -68,4 +68,3 @@ HTTP 状态码用于描述 HTTP 请求的结果,比如2xx 就代表请求被

|

|||||||

- https://developer.mozilla.org/zh-CN/docs/Web/HTTP/Status

|

- https://developer.mozilla.org/zh-CN/docs/Web/HTTP/Status

|

||||||

- https://en.wikipedia.org/wiki/List_of_HTTP_status_codes

|

- https://en.wikipedia.org/wiki/List_of_HTTP_status_codes

|

||||||

- https://segmentfault.com/a/1190000018264501

|

- https://segmentfault.com/a/1190000018264501

|

||||||

|

|

||||||

|

|||||||

@ -133,7 +133,7 @@ HTTP 状态码用于描述 HTTP 请求的结果,比如 2xx 就代表请求被

|

|||||||

### HTTP Header 中常见的字段有哪些?

|

### HTTP Header 中常见的字段有哪些?

|

||||||

|

|

||||||

| 请求头字段名 | 说明 | 示例 |

|

| 请求头字段名 | 说明 | 示例 |

|

||||||

| :------------------ | :----------------------------------------------------------- | :----------------------------------------------------------- |

|

| :------------------ | :------------------------------------------------------------------------------------------------------------------------------------------------------------------------------ | :----------------------------------------------------------------------------------------- |

|

||||||

| Accept | 能够接受的回应内容类型(Content-Types)。 | Accept: text/plain |

|

| Accept | 能够接受的回应内容类型(Content-Types)。 | Accept: text/plain |

|

||||||

| Accept-Charset | 能够接受的字符集 | Accept-Charset: utf-8 |

|

| Accept-Charset | 能够接受的字符集 | Accept-Charset: utf-8 |

|

||||||

| Accept-Datetime | 能够接受的按照时间来表示的版本 | Accept-Datetime: Thu, 31 May 2007 20:35:00 GMT |

|

| Accept-Datetime | 能够接受的按照时间来表示的版本 | Accept-Datetime: Thu, 31 May 2007 20:35:00 GMT |

|

||||||

|

|||||||

@ -104,8 +104,6 @@ tag:

|

|||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

### 什么是 IP 地址过滤?

|

### 什么是 IP 地址过滤?

|

||||||

|

|

||||||

**IP 地址过滤(IP Address Filtering)** 简单来说就是限制或阻止特定 IP 地址或 IP 地址范围的访问。例如,你有一个图片服务突然被某一个 IP 地址攻击,那我们就可以禁止这个 IP 地址访问图片服务。

|

**IP 地址过滤(IP Address Filtering)** 简单来说就是限制或阻止特定 IP 地址或 IP 地址范围的访问。例如,你有一个图片服务突然被某一个 IP 地址攻击,那我们就可以禁止这个 IP 地址访问图片服务。

|

||||||

|

|||||||

@ -5,7 +5,6 @@ tag:

|

|||||||

- 计算机网络

|

- 计算机网络

|

||||||

---

|

---

|

||||||

|

|

||||||

|

|

||||||

为了准确无误地把数据送达目标处,TCP 协议采用了三次握手策略。

|

为了准确无误地把数据送达目标处,TCP 协议采用了三次握手策略。

|

||||||

|

|

||||||

## 建立连接-TCP 三次握手

|

## 建立连接-TCP 三次握手

|

||||||

@ -14,7 +13,6 @@ tag:

|

|||||||

|

|

||||||

建立一个 TCP 连接需要“三次握手”,缺一不可 :

|

建立一个 TCP 连接需要“三次握手”,缺一不可 :

|

||||||

|

|

||||||

|

|

||||||

- **一次握手**:客户端发送带有 SYN(SEQ=x) 标志的数据包 -> 服务端,然后客户端进入 **SYN_SEND** 状态,等待服务器的确认;

|

- **一次握手**:客户端发送带有 SYN(SEQ=x) 标志的数据包 -> 服务端,然后客户端进入 **SYN_SEND** 状态,等待服务器的确认;

|

||||||

- **二次握手**:服务端发送带有 SYN+ACK(SEQ=y,ACK=x+1) 标志的数据包 –> 客户端,然后服务端进入 **SYN_RECV** 状态

|

- **二次握手**:服务端发送带有 SYN+ACK(SEQ=y,ACK=x+1) 标志的数据包 –> 客户端,然后服务端进入 **SYN_RECV** 状态

|

||||||

- **三次握手**:客户端发送带有 ACK(ACK=y+1) 标志的数据包 –> 服务端,然后客户端和服务器端都进入**ESTABLISHED** 状态,完成 TCP 三次握手。

|

- **三次握手**:客户端发送带有 ACK(ACK=y+1) 标志的数据包 –> 服务端,然后客户端和服务器端都进入**ESTABLISHED** 状态,完成 TCP 三次握手。

|

||||||

@ -24,6 +22,7 @@ tag:

|

|||||||

### 为什么要三次握手?

|

### 为什么要三次握手?

|

||||||

|

|

||||||

三次握手的目的是建立可靠的通信信道,说到通讯,简单来说就是数据的发送与接收,而三次握手最主要的目的就是双方确认自己与对方的发送与接收是正常的。

|

三次握手的目的是建立可靠的通信信道,说到通讯,简单来说就是数据的发送与接收,而三次握手最主要的目的就是双方确认自己与对方的发送与接收是正常的。

|

||||||

|

|

||||||

1. **第一次握手** :Client 什么都不能确认;Server 确认了对方发送正常,自己接收正常

|

1. **第一次握手** :Client 什么都不能确认;Server 确认了对方发送正常,自己接收正常

|

||||||

2. **第二次握手** :Client 确认了:自己发送、接收正常,对方发送、接收正常;Server 确认了:对方发送正常,自己接收正常

|

2. **第二次握手** :Client 确认了:自己发送、接收正常,对方发送、接收正常;Server 确认了:对方发送正常,自己接收正常

|

||||||

3. **第三次握手** :Client 确认了:自己发送、接收正常,对方发送、接收正常;Server 确认了:自己发送、接收正常,对方发送、接收正常

|

3. **第三次握手** :Client 确认了:自己发送、接收正常,对方发送、接收正常;Server 确认了:自己发送、接收正常,对方发送、接收正常

|

||||||

@ -64,28 +63,22 @@ TCP是全双工通信,可以双向传输数据。任何一方都可以在数

|

|||||||

|

|

||||||

### 为什么不能把服务器发送的 ACK 和 FIN 合并起来,变成三次挥手?

|

### 为什么不能把服务器发送的 ACK 和 FIN 合并起来,变成三次挥手?

|

||||||

|

|

||||||

|

|

||||||

因为服务器收到客户端断开连接的请求时,可能还有一些数据没有发完,这时先回复 ACK,表示接收到了断开连接的请求。等到数据发完之后再发 FIN,断开服务器到客户端的数据传送。

|

因为服务器收到客户端断开连接的请求时,可能还有一些数据没有发完,这时先回复 ACK,表示接收到了断开连接的请求。等到数据发完之后再发 FIN,断开服务器到客户端的数据传送。

|

||||||

|

|

||||||

### 如果第二次挥手时服务器的 ACK 没有送达客户端,会怎样?

|

### 如果第二次挥手时服务器的 ACK 没有送达客户端,会怎样?

|

||||||

|

|

||||||

|

|

||||||

客户端没有收到 ACK 确认,会重新发送 FIN 请求。

|

客户端没有收到 ACK 确认,会重新发送 FIN 请求。

|

||||||

|

|

||||||

### 为什么第四次挥手客户端需要等待 2\*MSL(报文段最长寿命)时间后才进入 CLOSED 状态?

|

### 为什么第四次挥手客户端需要等待 2\*MSL(报文段最长寿命)时间后才进入 CLOSED 状态?

|

||||||

|

|

||||||

|

|

||||||

第四次挥手时,客户端发送给服务器的 ACK 有可能丢失,如果服务端因为某些原因而没有收到 ACK 的话,服务端就会重发 FIN,如果客户端在 2\*MSL 的时间内收到了 FIN,就会重新发送 ACK 并再次等待 2MSL,防止 Server 没有收到 ACK 而不断重发 FIN。

|

第四次挥手时,客户端发送给服务器的 ACK 有可能丢失,如果服务端因为某些原因而没有收到 ACK 的话,服务端就会重发 FIN,如果客户端在 2\*MSL 的时间内收到了 FIN,就会重新发送 ACK 并再次等待 2MSL,防止 Server 没有收到 ACK 而不断重发 FIN。

|

||||||

|

|

||||||

> **MSL(Maximum Segment Lifetime)** : 一个片段在网络中最大的存活时间,2MSL 就是一个发送和一个回复所需的最大时间。如果直到 2MSL,Client 都没有再次收到 FIN,那么 Client 推断 ACK 已经被成功接收,则结束 TCP 连接。

|

> **MSL(Maximum Segment Lifetime)** : 一个片段在网络中最大的存活时间,2MSL 就是一个发送和一个回复所需的最大时间。如果直到 2MSL,Client 都没有再次收到 FIN,那么 Client 推断 ACK 已经被成功接收,则结束 TCP 连接。

|

||||||

|

|

||||||

## 参考

|

## 参考

|

||||||

|

|

||||||

|

|

||||||

- 《计算机网络(第 7 版)》

|

- 《计算机网络(第 7 版)》

|

||||||

|

|

||||||

- 《图解 HTTP》

|

- 《图解 HTTP》

|

||||||

|

|

||||||

- TCP and UDP Tutorial:https://www.9tut.com/tcp-and-udp-tutorial

|

- TCP and UDP Tutorial:https://www.9tut.com/tcp-and-udp-tutorial

|

||||||

|

|

||||||

|

|

||||||

|

|||||||

@ -60,7 +60,6 @@ TCP 为全双工(Full-Duplex, FDX)通信,双方可以进行双向通信,客

|

|||||||

|

|

||||||

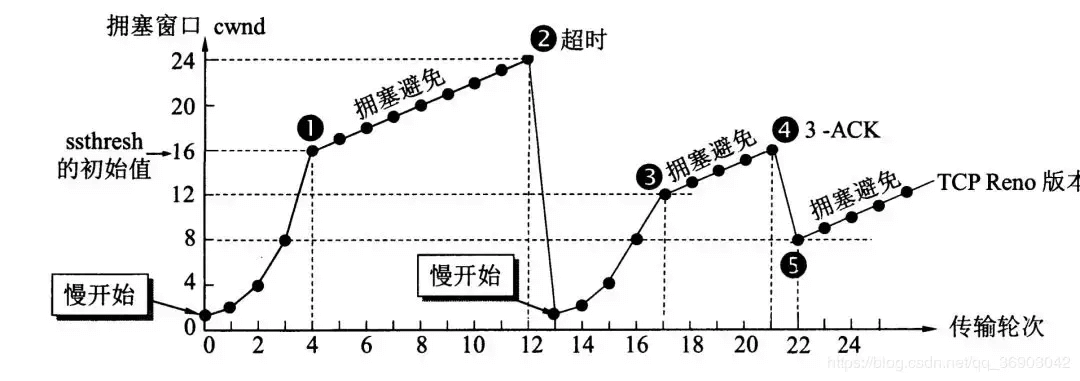

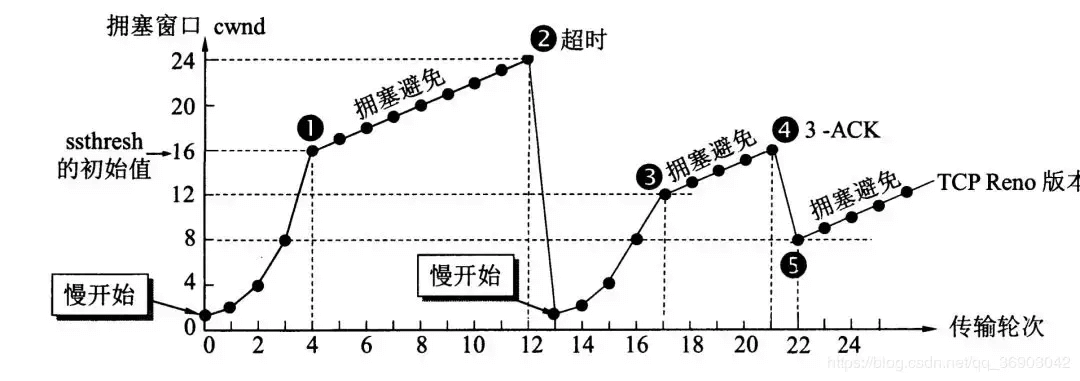

## TCP 的拥塞控制是怎么实现的?

|

## TCP 的拥塞控制是怎么实现的?

|

||||||

|

|

||||||

|

|

||||||

在某段时间,若对网络中某一资源的需求超过了该资源所能提供的可用部分,网络的性能就要变坏。这种情况就叫拥塞。拥塞控制就是为了防止过多的数据注入到网络中,这样就可以使网络中的路由器或链路不致过载。拥塞控制所要做的都有一个前提,就是网络能够承受现有的网络负荷。拥塞控制是一个全局性的过程,涉及到所有的主机,所有的路由器,以及与降低网络传输性能有关的所有因素。相反,流量控制往往是点对点通信量的控制,是个端到端的问题。流量控制所要做到的就是抑制发送端发送数据的速率,以便使接收端来得及接收。

|

在某段时间,若对网络中某一资源的需求超过了该资源所能提供的可用部分,网络的性能就要变坏。这种情况就叫拥塞。拥塞控制就是为了防止过多的数据注入到网络中,这样就可以使网络中的路由器或链路不致过载。拥塞控制所要做的都有一个前提,就是网络能够承受现有的网络负荷。拥塞控制是一个全局性的过程,涉及到所有的主机,所有的路由器,以及与降低网络传输性能有关的所有因素。相反,流量控制往往是点对点通信量的控制,是个端到端的问题。流量控制所要做到的就是抑制发送端发送数据的速率,以便使接收端来得及接收。

|

||||||

|

|

||||||

|

|

||||||

@ -100,7 +99,6 @@ ARQ 包括停止等待 ARQ 协议和连续 ARQ 协议。

|

|||||||

|

|

||||||

### 连续 ARQ 协议

|

### 连续 ARQ 协议

|

||||||

|

|

||||||

|

|

||||||

连续 ARQ 协议可提高信道利用率。发送方维持一个发送窗口,凡位于发送窗口内的分组可以连续发送出去,而不需要等待对方确认。接收方一般采用累计确认,对按序到达的最后一个分组发送确认,表明到这个分组为止的所有分组都已经正确收到了。

|

连续 ARQ 协议可提高信道利用率。发送方维持一个发送窗口,凡位于发送窗口内的分组可以连续发送出去,而不需要等待对方确认。接收方一般采用累计确认,对按序到达的最后一个分组发送确认,表明到这个分组为止的所有分组都已经正确收到了。

|

||||||

|

|

||||||

**优点:** 信道利用率高,容易实现,即使确认丢失,也不必重传。

|

**优点:** 信道利用率高,容易实现,即使确认丢失,也不必重传。

|

||||||

@ -109,7 +107,6 @@ ARQ 包括停止等待 ARQ 协议和连续 ARQ 协议。

|

|||||||

|

|

||||||

## Reference

|

## Reference

|

||||||

|

|

||||||

|

|

||||||

1. 《计算机网络(第 7 版)》

|

1. 《计算机网络(第 7 版)》

|

||||||

2. 《图解 HTTP》

|

2. 《图解 HTTP》

|

||||||

3. [https://www.9tut.com/tcp-and-udp-tutorial](https://www.9tut.com/tcp-and-udp-tutorial)

|

3. [https://www.9tut.com/tcp-and-udp-tutorial](https://www.9tut.com/tcp-and-udp-tutorial)

|

||||||

|

|||||||

@ -45,8 +45,6 @@ head:

|

|||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

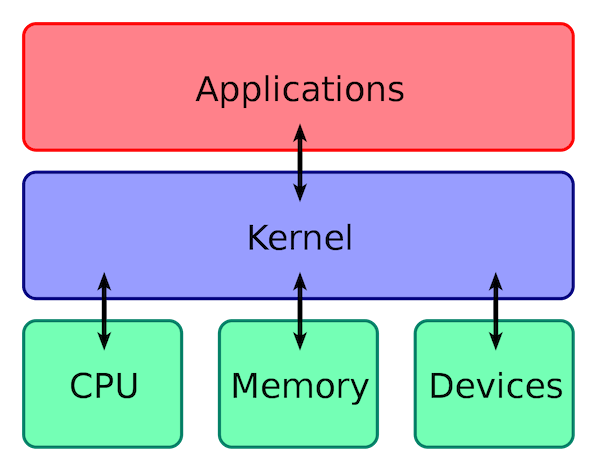

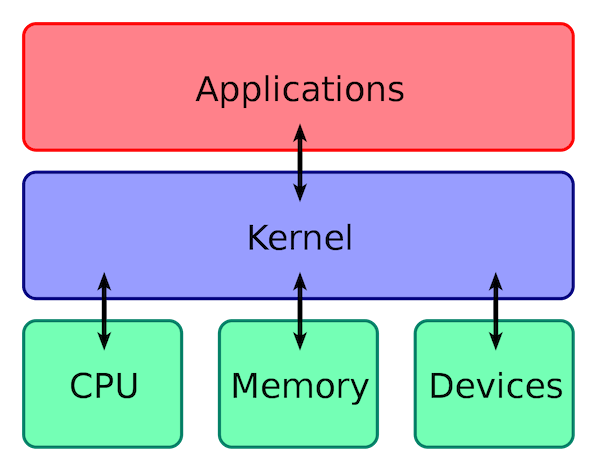

### 操作系统主要有哪些功能?

|

### 操作系统主要有哪些功能?

|

||||||

|

|

||||||

从资源管理的角度来看,操作系统有 6 大功能:

|

从资源管理的角度来看,操作系统有 6 大功能:

|

||||||

|

|||||||

@ -29,7 +29,7 @@ MongoDB 的存储结构区别于传统的关系型数据库,主要由如下三

|

|||||||

**SQL 与 MongoDB 常见术语对比** :

|

**SQL 与 MongoDB 常见术语对比** :

|

||||||

|

|

||||||

| SQL | MongoDB |

|

| SQL | MongoDB |

|

||||||

| ----------------------- | ------------------------------ |

|

| ------------------------ | ------------------------------- |

|

||||||

| 表(Table) | 集合(Collection) |

|

| 表(Table) | 集合(Collection) |

|

||||||

| 行(Row) | 文档(Document) |

|

| 行(Row) | 文档(Document) |

|

||||||

| 列(Col) | 字段(Field) |

|

| 列(Col) | 字段(Field) |

|

||||||

@ -197,7 +197,7 @@ MongoDB 聚合管道由多个阶段组成,每个阶段在文档通过管道时

|

|||||||

**常用阶段操作符** :

|

**常用阶段操作符** :

|

||||||

|

|

||||||

| 操作符 | 简述 |

|

| 操作符 | 简述 |

|

||||||

| --------- | ------------------------------------------------------------ |

|

| --------- | ---------------------------------------------------------------------------------------------------- |

|

||||||

| \$match | 匹配操作符,用于对文档集合进行筛选 |

|

| \$match | 匹配操作符,用于对文档集合进行筛选 |

|

||||||

| \$project | 投射操作符,用于重构每一个文档的字段,可以提取字段,重命名字段,甚至可以对原有字段进行操作后新增字段 |

|

| \$project | 投射操作符,用于重构每一个文档的字段,可以提取字段,重命名字段,甚至可以对原有字段进行操作后新增字段 |

|

||||||

| \$sort | 排序操作符,用于根据一个或多个字段对文档进行排序 |

|

| \$sort | 排序操作符,用于根据一个或多个字段对文档进行排序 |

|

||||||

|

|||||||

@ -953,4 +953,3 @@ OPTIMIZE [LOCAL | NO_WRITE_TO_BINLOG] TABLE tbl_name [, tbl_name] ...

|

|||||||

6. SQL对大小写不敏感

|

6. SQL对大小写不敏感

|

||||||

7. 清除已有语句:\c

|

7. 清除已有语句:\c

|

||||||

```

|

```

|

||||||

|

|

||||||

|

|||||||

@ -84,15 +84,16 @@ select * from tb_student A where A.age='18' and A.name=' 张三 ';

|

|||||||

|

|

||||||

结合上面的说明,我们分析下这个语句的执行流程:

|

结合上面的说明,我们分析下这个语句的执行流程:

|

||||||

|

|

||||||

* 先检查该语句是否有权限,如果没有权限,直接返回错误信息,如果有权限,在 MySQL8.0 版本以前,会先查询缓存,以这条 SQL 语句为 key 在内存中查询是否有结果,如果有直接缓存,如果没有,执行下一步。

|

- 先检查该语句是否有权限,如果没有权限,直接返回错误信息,如果有权限,在 MySQL8.0 版本以前,会先查询缓存,以这条 SQL 语句为 key 在内存中查询是否有结果,如果有直接缓存,如果没有,执行下一步。

|

||||||

* 通过分析器进行词法分析,提取 SQL 语句的关键元素,比如提取上面这个语句是查询 select,提取需要查询的表名为 tb_student,需要查询所有的列,查询条件是这个表的 id='1'。然后判断这个 SQL 语句是否有语法错误,比如关键词是否正确等等,如果检查没问题就执行下一步。

|

- 通过分析器进行词法分析,提取 SQL 语句的关键元素,比如提取上面这个语句是查询 select,提取需要查询的表名为 tb_student,需要查询所有的列,查询条件是这个表的 id='1'。然后判断这个 SQL 语句是否有语法错误,比如关键词是否正确等等,如果检查没问题就执行下一步。

|

||||||

* 接下来就是优化器进行确定执行方案,上面的 SQL 语句,可以有两种执行方案:

|

- 接下来就是优化器进行确定执行方案,上面的 SQL 语句,可以有两种执行方案:

|

||||||

|

|

||||||

a.先查询学生表中姓名为“张三”的学生,然后判断是否年龄是 18。

|

a.先查询学生表中姓名为“张三”的学生,然后判断是否年龄是 18。

|

||||||

b.先找出学生中年龄 18 岁的学生,然后再查询姓名为“张三”的学生。

|

b.先找出学生中年龄 18 岁的学生,然后再查询姓名为“张三”的学生。

|

||||||

|

|

||||||

那么优化器根据自己的优化算法进行选择执行效率最好的一个方案(优化器认为,有时候不一定最好)。那么确认了执行计划后就准备开始执行了。

|

那么优化器根据自己的优化算法进行选择执行效率最好的一个方案(优化器认为,有时候不一定最好)。那么确认了执行计划后就准备开始执行了。

|

||||||

|

|

||||||

* 进行权限校验,如果没有权限就会返回错误信息,如果有权限就会调用数据库引擎接口,返回引擎的执行结果。

|

- 进行权限校验,如果没有权限就会返回错误信息,如果有权限就会调用数据库引擎接口,返回引擎的执行结果。

|

||||||

|

|

||||||

### 2.2 更新语句

|

### 2.2 更新语句

|

||||||

|

|

||||||

@ -101,12 +102,13 @@ select * from tb_student A where A.age='18' and A.name=' 张三 ';

|

|||||||

```

|

```

|

||||||

update tb_student A set A.age='19' where A.name=' 张三 ';

|

update tb_student A set A.age='19' where A.name=' 张三 ';

|

||||||

```

|

```

|

||||||

|

|

||||||

我们来给张三修改下年龄,在实际数据库肯定不会设置年龄这个字段的,不然要被技术负责人打的。其实这条语句也基本上会沿着上一个查询的流程走,只不过执行更新的时候肯定要记录日志啦,这就会引入日志模块了,MySQL 自带的日志模块是 **binlog(归档日志)** ,所有的存储引擎都可以使用,我们常用的 InnoDB 引擎还自带了一个日志模块 **redo log(重做日志)**,我们就以 InnoDB 模式下来探讨这个语句的执行流程。流程如下:

|

我们来给张三修改下年龄,在实际数据库肯定不会设置年龄这个字段的,不然要被技术负责人打的。其实这条语句也基本上会沿着上一个查询的流程走,只不过执行更新的时候肯定要记录日志啦,这就会引入日志模块了,MySQL 自带的日志模块是 **binlog(归档日志)** ,所有的存储引擎都可以使用,我们常用的 InnoDB 引擎还自带了一个日志模块 **redo log(重做日志)**,我们就以 InnoDB 模式下来探讨这个语句的执行流程。流程如下:

|

||||||

|

|

||||||

* 先查询到张三这一条数据,如果有缓存,也是会用到缓存。

|

- 先查询到张三这一条数据,如果有缓存,也是会用到缓存。

|

||||||

* 然后拿到查询的语句,把 age 改为 19,然后调用引擎 API 接口,写入这一行数据,InnoDB 引擎把数据保存在内存中,同时记录 redo log,此时 redo log 进入 prepare 状态,然后告诉执行器,执行完成了,随时可以提交。

|

- 然后拿到查询的语句,把 age 改为 19,然后调用引擎 API 接口,写入这一行数据,InnoDB 引擎把数据保存在内存中,同时记录 redo log,此时 redo log 进入 prepare 状态,然后告诉执行器,执行完成了,随时可以提交。

|

||||||

* 执行器收到通知后记录 binlog,然后调用引擎接口,提交 redo log 为提交状态。

|

- 执行器收到通知后记录 binlog,然后调用引擎接口,提交 redo log 为提交状态。

|

||||||

* 更新完成。

|

- 更新完成。

|

||||||

|

|

||||||

**这里肯定有同学会问,为什么要用两个日志模块,用一个日志模块不行吗?**

|

**这里肯定有同学会问,为什么要用两个日志模块,用一个日志模块不行吗?**

|

||||||

|

|

||||||

@ -114,25 +116,25 @@ update tb_student A set A.age='19' where A.name=' 张三 ';

|

|||||||

|

|

||||||

并不是说只用一个日志模块不可以,只是 InnoDB 引擎就是通过 redo log 来支持事务的。那么,又会有同学问,我用两个日志模块,但是不要这么复杂行不行,为什么 redo log 要引入 prepare 预提交状态?这里我们用反证法来说明下为什么要这么做?

|

并不是说只用一个日志模块不可以,只是 InnoDB 引擎就是通过 redo log 来支持事务的。那么,又会有同学问,我用两个日志模块,但是不要这么复杂行不行,为什么 redo log 要引入 prepare 预提交状态?这里我们用反证法来说明下为什么要这么做?

|

||||||

|

|

||||||

* **先写 redo log 直接提交,然后写 binlog**,假设写完 redo log 后,机器挂了,binlog 日志没有被写入,那么机器重启后,这台机器会通过 redo log 恢复数据,但是这个时候 binlog 并没有记录该数据,后续进行机器备份的时候,就会丢失这一条数据,同时主从同步也会丢失这一条数据。

|

- **先写 redo log 直接提交,然后写 binlog**,假设写完 redo log 后,机器挂了,binlog 日志没有被写入,那么机器重启后,这台机器会通过 redo log 恢复数据,但是这个时候 binlog 并没有记录该数据,后续进行机器备份的时候,就会丢失这一条数据,同时主从同步也会丢失这一条数据。

|

||||||

* **先写 binlog,然后写 redo log**,假设写完了 binlog,机器异常重启了,由于没有 redo log,本机是无法恢复这一条记录的,但是 binlog 又有记录,那么和上面同样的道理,就会产生数据不一致的情况。

|

- **先写 binlog,然后写 redo log**,假设写完了 binlog,机器异常重启了,由于没有 redo log,本机是无法恢复这一条记录的,但是 binlog 又有记录,那么和上面同样的道理,就会产生数据不一致的情况。

|

||||||

|

|

||||||

如果采用 redo log 两阶段提交的方式就不一样了,写完 binlog 后,然后再提交 redo log 就会防止出现上述的问题,从而保证了数据的一致性。那么问题来了,有没有一个极端的情况呢?假设 redo log 处于预提交状态,binlog 也已经写完了,这个时候发生了异常重启会怎么样呢?

|

如果采用 redo log 两阶段提交的方式就不一样了,写完 binlog 后,然后再提交 redo log 就会防止出现上述的问题,从而保证了数据的一致性。那么问题来了,有没有一个极端的情况呢?假设 redo log 处于预提交状态,binlog 也已经写完了,这个时候发生了异常重启会怎么样呢?

|

||||||

这个就要依赖于 MySQL 的处理机制了,MySQL 的处理过程如下:

|

这个就要依赖于 MySQL 的处理机制了,MySQL 的处理过程如下:

|

||||||

|

|

||||||

* 判断 redo log 是否完整,如果判断是完整的,就立即提交。

|

- 判断 redo log 是否完整,如果判断是完整的,就立即提交。

|

||||||

* 如果 redo log 只是预提交但不是 commit 状态,这个时候就会去判断 binlog 是否完整,如果完整就提交 redo log, 不完整就回滚事务。

|

- 如果 redo log 只是预提交但不是 commit 状态,这个时候就会去判断 binlog 是否完整,如果完整就提交 redo log, 不完整就回滚事务。

|

||||||

|

|

||||||

这样就解决了数据一致性的问题。

|

这样就解决了数据一致性的问题。

|

||||||

|

|

||||||

## 三 总结

|

## 三 总结

|

||||||

|

|

||||||

* MySQL 主要分为 Server 层和引擎层,Server 层主要包括连接器、查询缓存、分析器、优化器、执行器,同时还有一个日志模块(binlog),这个日志模块所有执行引擎都可以共用,redolog 只有 InnoDB 有。

|

- MySQL 主要分为 Server 层和引擎层,Server 层主要包括连接器、查询缓存、分析器、优化器、执行器,同时还有一个日志模块(binlog),这个日志模块所有执行引擎都可以共用,redolog 只有 InnoDB 有。

|

||||||

* 引擎层是插件式的,目前主要包括,MyISAM,InnoDB,Memory 等。

|

- 引擎层是插件式的,目前主要包括,MyISAM,InnoDB,Memory 等。

|

||||||

* 查询语句的执行流程如下:权限校验(如果命中缓存)--->查询缓存--->分析器--->优化器--->权限校验--->执行器--->引擎

|

- 查询语句的执行流程如下:权限校验(如果命中缓存)--->查询缓存--->分析器--->优化器--->权限校验--->执行器--->引擎

|

||||||

* 更新语句执行流程如下:分析器---->权限校验---->执行器--->引擎---redo log(prepare 状态)--->binlog--->redo log(commit状态)

|

- 更新语句执行流程如下:分析器---->权限校验---->执行器--->引擎---redo log(prepare 状态)--->binlog--->redo log(commit 状态)

|

||||||

|

|

||||||

## 四 参考

|

## 四 参考

|

||||||

|

|

||||||

* 《MySQL 实战45讲》

|

- 《MySQL 实战 45 讲》

|

||||||

* MySQL 5.6参考手册:<https://dev.MySQL.com/doc/refman/5.6/en/>

|

- MySQL 5.6 参考手册:<https://dev.MySQL.com/doc/refman/5.6/en/>

|

||||||

|

|||||||

@ -89,8 +89,7 @@ id 如果相同,从上往下依次执行。id 不同,id 值越大,执行

|

|||||||

查询用到的表名,每行都有对应的表名,表名除了正常的表之外,也可能是以下列出的值:

|

查询用到的表名,每行都有对应的表名,表名除了正常的表之外,也可能是以下列出的值:

|

||||||

|

|

||||||

- **`<unionM,N>`** : 本行引用了 id 为 M 和 N 的行的 UNION 结果;

|

- **`<unionM,N>`** : 本行引用了 id 为 M 和 N 的行的 UNION 结果;

|

||||||

- **`<derivedN>`** : 本行引用了 id 为 N 的表所产生的的派生表结果。派生表有可能产生自 FROM 语句中的子查询。

|

- **`<derivedN>`** : 本行引用了 id 为 N 的表所产生的的派生表结果。派生表有可能产生自 FROM 语句中的子查询。 -**`<subqueryN>`** : 本行引用了 id 为 N 的表所产生的的物化子查询结果。

|

||||||

-**`<subqueryN>`** : 本行引用了 id 为 N 的表所产生的的物化子查询结果。

|

|

||||||

|

|

||||||

### type(重要)

|

### type(重要)

|

||||||

|

|

||||||

|

|||||||

@ -73,7 +73,7 @@ SET [SESSION|GLOBAL] TRANSACTION ISOLATION LEVEL [READ UNCOMMITTED|READ COMMITTE

|

|||||||

|

|

||||||

### 脏读(读未提交)

|

### 脏读(读未提交)

|

||||||

|

|

||||||

%E5%AE%9E%E4%BE%8B.jpg)

|

%E5%AE%9E%E4%BE%8B.jpg>)

|

||||||

|

|

||||||

### 避免脏读(读已提交)

|

### 避免脏读(读已提交)

|

||||||

|

|

||||||

|

|||||||

@ -5,7 +5,6 @@ tag:

|

|||||||

- Redis

|

- Redis

|

||||||

---

|

---

|

||||||

|

|

||||||

|

|

||||||

看到很多小伙伴简历上写了“**熟练使用缓存**”,但是被我问到“**缓存常用的 3 种读写策略**”的时候却一脸懵逼。

|

看到很多小伙伴简历上写了“**熟练使用缓存**”,但是被我问到“**缓存常用的 3 种读写策略**”的时候却一脸懵逼。

|

||||||

|

|

||||||

在我看来,造成这个问题的原因是我们在学习 Redis 的时候,可能只是简单了写一些 Demo,并没有去关注缓存的读写策略,或者说压根不知道这回事。

|

在我看来,造成这个问题的原因是我们在学习 Redis 的时候,可能只是简单了写一些 Demo,并没有去关注缓存的读写策略,或者说压根不知道这回事。

|

||||||

|

|||||||

@ -9,7 +9,6 @@ tag:

|

|||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

[《Java 面试指北》](https://javaguide.cn/zhuanlan/java-mian-shi-zhi-bei.html)(点击链接即可查看详细介绍)的部分内容展示如下,你可以将其看作是 [JavaGuide](https://javaguide.cn) 的补充完善,两者可以配合使用。

|

[《Java 面试指北》](https://javaguide.cn/zhuanlan/java-mian-shi-zhi-bei.html)(点击链接即可查看详细介绍)的部分内容展示如下,你可以将其看作是 [JavaGuide](https://javaguide.cn) 的补充完善,两者可以配合使用。

|

||||||

|

|

||||||

|

|

||||||

|

|||||||

@ -388,7 +388,7 @@ Sorted Set 类似于 Set,但和 Set 相比,Sorted Set 增加了一个权重

|

|||||||

### 常用命令

|

### 常用命令

|

||||||

|

|

||||||

| 命令 | 介绍 |

|

| 命令 | 介绍 |

|

||||||

| --------------------------------------------- | ------------------------------------------------------------ |

|

| --------------------------------------------- | ------------------------------------------------------------------------------------------------------------- |

|

||||||

| ZADD key score1 member1 score2 member2 ... | 向指定有序集合添加一个或多个元素 |

|

| ZADD key score1 member1 score2 member2 ... | 向指定有序集合添加一个或多个元素 |

|

||||||

| ZCARD KEY | 获取指定有序集合的元素数量 |

|

| ZCARD KEY | 获取指定有序集合的元素数量 |

|

||||||

| ZSCORE key member | 获取指定有序集合中指定元素的 score 值 |

|

| ZSCORE key member | 获取指定有序集合中指定元素的 score 值 |

|

||||||

|

|||||||

@ -27,7 +27,7 @@ Bitmap 存储的是连续的二进制数字(0 和 1),通过 Bitmap, 只需

|

|||||||

### 常用命令

|

### 常用命令

|

||||||

|

|

||||||

| 命令 | 介绍 |

|

| 命令 | 介绍 |

|

||||||

| ------------------------------------- | ------------------------------------------------------------ |

|

| ------------------------------------- | ---------------------------------------------------------------- |

|

||||||

| SETBIT key offset value | 设置指定 offset 位置的值 |

|

| SETBIT key offset value | 设置指定 offset 位置的值 |

|

||||||

| GETBIT key offset | 获取指定 offset 位置的值 |

|

| GETBIT key offset | 获取指定 offset 位置的值 |

|

||||||

| BITCOUNT key start end | 获取 start 和 end 之前值为 1 的元素个数 |

|

| BITCOUNT key start end | 获取 start 和 end 之前值为 1 的元素个数 |

|

||||||

@ -87,7 +87,7 @@ HyperLogLog 的使用非常简单,但原理非常复杂。HyperLogLog 的原

|

|||||||

HyperLogLog 相关的命令非常少,最常用的也就 3 个。

|

HyperLogLog 相关的命令非常少,最常用的也就 3 个。

|

||||||

|

|

||||||

| 命令 | 介绍 |

|

| 命令 | 介绍 |

|

||||||

| ----------------------------------------- | ------------------------------------------------------------ |

|

| ----------------------------------------- | -------------------------------------------------------------------------------- |

|

||||||

| PFADD key element1 element2 ... | 添加一个或多个元素到 HyperLogLog 中 |

|

| PFADD key element1 element2 ... | 添加一个或多个元素到 HyperLogLog 中 |

|

||||||

| PFCOUNT key1 key2 | 获取一个或者多个 HyperLogLog 的唯一计数。 |

|

| PFCOUNT key1 key2 | 获取一个或者多个 HyperLogLog 的唯一计数。 |

|

||||||

| PFMERGE destkey sourcekey1 sourcekey2 ... | 将多个 HyperLogLog 合并到 destkey 中,destkey 会结合多个源,算出对应的唯一计数。 |

|

| PFMERGE destkey sourcekey1 sourcekey2 ... | 将多个 HyperLogLog 合并到 destkey 中,destkey 会结合多个源,算出对应的唯一计数。 |

|

||||||

@ -133,7 +133,7 @@ Geospatial index(地理空间索引,简称 GEO) 主要用于存储地理

|

|||||||

### 常用命令

|

### 常用命令

|

||||||

|

|

||||||

| 命令 | 介绍 |

|

| 命令 | 介绍 |

|

||||||

| ------------------------------------------------ | ------------------------------------------------------------ |

|

| ------------------------------------------------ | ---------------------------------------------------------------------------------------------------- |

|

||||||

| GEOADD key longitude1 latitude1 member1 ... | 添加一个或多个元素对应的经纬度信息到 GEO 中 |

|

| GEOADD key longitude1 latitude1 member1 ... | 添加一个或多个元素对应的经纬度信息到 GEO 中 |

|

||||||

| GEOPOS key member1 member2 ... | 返回给定元素的经纬度信息 |

|

| GEOPOS key member1 member2 ... | 返回给定元素的经纬度信息 |

|

||||||

| GEODIST key member1 member2 M/KM/FT/MI | 返回两个给定元素之间的距离 |

|

| GEODIST key member1 member2 M/KM/FT/MI | 返回两个给定元素之间的距离 |

|

||||||

|

|||||||

@ -248,7 +248,7 @@ struct __attribute__ ((__packed__)) sdshdr64 {

|

|||||||

通过源码可以看出,SDS 共有五种实现方式 SDS_TYPE_5(并未用到)、SDS_TYPE_8、SDS_TYPE_16、SDS_TYPE_32、SDS_TYPE_64,其中只有后四种实际用到。Redis 会根据初始化的长度决定使用哪种类型,从而减少内存的使用。

|

通过源码可以看出,SDS 共有五种实现方式 SDS_TYPE_5(并未用到)、SDS_TYPE_8、SDS_TYPE_16、SDS_TYPE_32、SDS_TYPE_64,其中只有后四种实际用到。Redis 会根据初始化的长度决定使用哪种类型,从而减少内存的使用。

|

||||||

|

|

||||||

| 类型 | 字节 | 位 |

|

| 类型 | 字节 | 位 |

|

||||||

| -------- | ---- | ---- |

|

| -------- | ---- | --- |

|

||||||

| sdshdr5 | < 1 | <8 |

|

| sdshdr5 | < 1 | <8 |

|

||||||

| sdshdr8 | 1 | 8 |

|

| sdshdr8 | 1 | 8 |

|

||||||

| sdshdr16 | 2 | 16 |

|

| sdshdr16 | 2 | 16 |

|

||||||

@ -593,4 +593,3 @@ Redis 提供 6 种数据淘汰策略:

|

|||||||

- 《Redis 设计与实现》

|

- 《Redis 设计与实现》

|

||||||

- Redis 命令手册:https://www.redis.com.cn/commands.html

|

- Redis 命令手册:https://www.redis.com.cn/commands.html

|

||||||

- WHY Redis choose single thread (vs multi threads): [https://medium.com/@jychen7/sharing-redis-single-thread-vs-multi-threads-5870bd44d153](https://medium.com/@jychen7/sharing-redis-single-thread-vs-multi-threads-5870bd44d153)

|

- WHY Redis choose single thread (vs multi threads): [https://medium.com/@jychen7/sharing-redis-single-thread-vs-multi-threads-5870bd44d153](https://medium.com/@jychen7/sharing-redis-single-thread-vs-multi-threads-5870bd44d153)

|

||||||

|

|

||||||

|

|||||||

@ -1204,7 +1204,7 @@ ORDER BY c.cust_name

|

|||||||

SQL 允许在 `JOIN` 左边加上一些修饰性的关键词,从而形成不同类型的连接,如下表所示:

|

SQL 允许在 `JOIN` 左边加上一些修饰性的关键词,从而形成不同类型的连接,如下表所示:

|

||||||

|

|

||||||

| 连接类型 | 说明 |

|

| 连接类型 | 说明 |

|

||||||

| ---------------------------------------- | ------------------------------------------------------------ |

|

| ---------------------------------------- | --------------------------------------------------------------------------------------------- |

|

||||||

| INNER JOIN 内连接 | (默认连接方式)只有当两个表都存在满足条件的记录时才会返回行。 |

|

| INNER JOIN 内连接 | (默认连接方式)只有当两个表都存在满足条件的记录时才会返回行。 |

|

||||||

| LEFT JOIN / LEFT OUTER JOIN 左(外)连接 | 返回左表中的所有行,即使右表中没有满足条件的行也是如此。 |

|

| LEFT JOIN / LEFT OUTER JOIN 左(外)连接 | 返回左表中的所有行,即使右表中没有满足条件的行也是如此。 |

|

||||||

| RIGHT JOIN / RIGHT OUTER JOIN 右(外)连接 | 返回右表中的所有行,即使左表中没有满足条件的行也是如此。 |

|

| RIGHT JOIN / RIGHT OUTER JOIN 右(外)连接 | 返回右表中的所有行,即使左表中没有满足条件的行也是如此。 |

|

||||||

|

|||||||

@ -490,7 +490,7 @@ order by c.cust_name;

|

|||||||

SQL 允许在 `JOIN` 左边加上一些修饰性的关键词,从而形成不同类型的连接,如下表所示:

|

SQL 允许在 `JOIN` 左边加上一些修饰性的关键词,从而形成不同类型的连接,如下表所示:

|

||||||

|

|

||||||

| 连接类型 | 说明 |

|

| 连接类型 | 说明 |

|

||||||

| ---------------------------------------- | ------------------------------------------------------------ |

|

| ---------------------------------------- | --------------------------------------------------------------------------------------------- |

|

||||||

| INNER JOIN 内连接 | (默认连接方式)只有当两个表都存在满足条件的记录时才会返回行。 |

|

| INNER JOIN 内连接 | (默认连接方式)只有当两个表都存在满足条件的记录时才会返回行。 |

|

||||||

| LEFT JOIN / LEFT OUTER JOIN 左(外)连接 | 返回左表中的所有行,即使右表中没有满足条件的行也是如此。 |

|

| LEFT JOIN / LEFT OUTER JOIN 左(外)连接 | 返回左表中的所有行,即使右表中没有满足条件的行也是如此。 |

|

||||||

| RIGHT JOIN / RIGHT OUTER JOIN 右(外)连接 | 返回右表中的所有行,即使左表中没有满足条件的行也是如此。 |

|

| RIGHT JOIN / RIGHT OUTER JOIN 右(外)连接 | 返回右表中的所有行,即使左表中没有满足条件的行也是如此。 |

|

||||||

@ -919,7 +919,7 @@ SELECT user FROM user;

|

|||||||

下表说明了可用于`GRANT`和`REVOKE`语句的所有允许权限:

|

下表说明了可用于`GRANT`和`REVOKE`语句的所有允许权限:

|

||||||

|

|

||||||

| **特权** | **说明** | **级别** | | | | | |

|

| **特权** | **说明** | **级别** | | | | | |

|

||||||

| ----------------------- | ------------------------------------------------------------ | -------- | ------ | -------- | -------- | ---- | ---- |

|

| ----------------------- | ------------------------------------------------------------------------------------------------------- | -------- | ------ | -------- | -------- | --- | --- |

|

||||||

| **全局** | 数据库 | **表** | **列** | **程序** | **代理** | | |

|

| **全局** | 数据库 | **表** | **列** | **程序** | **代理** | | |

|

||||||

| ALL [PRIVILEGES] | 授予除 GRANT OPTION 之外的指定访问级别的所有权限 | | | | | | |

|

| ALL [PRIVILEGES] | 授予除 GRANT OPTION 之外的指定访问级别的所有权限 | | | | | | |

|

||||||

| ALTER | 允许用户使用 ALTER TABLE 语句 | X | X | X | | | |

|

| ALTER | 允许用户使用 ALTER TABLE 语句 | X | X | X | | | |

|

||||||

|

|||||||

@ -293,8 +293,3 @@ zkClient.setData().forPath("/node1/00001","c++".getBytes());//更新节点数据

|

|||||||

```java

|

```java

|

||||||

List<String> childrenPaths = zkClient.getChildren().forPath("/node1");

|

List<String> childrenPaths = zkClient.getChildren().forPath("/node1");

|

||||||

```

|

```

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|||||||

@ -125,7 +125,7 @@ Stat 类中包含了一个数据节点的所有状态信息的字段,包括事

|

|||||||

下面我们来看一下每个 znode 状态信息究竟代表的是什么吧!(下面的内容来源于《从 Paxos 到 ZooKeeper 分布式一致性原理与实践》,因为 Guide 确实也不是特别清楚,要学会参考资料的嘛! ) :

|

下面我们来看一下每个 znode 状态信息究竟代表的是什么吧!(下面的内容来源于《从 Paxos 到 ZooKeeper 分布式一致性原理与实践》,因为 Guide 确实也不是特别清楚,要学会参考资料的嘛! ) :

|

||||||

|

|

||||||

| znode 状态信息 | 解释 |

|

| znode 状态信息 | 解释 |

|

||||||

| -------------- | ------------------------------------------------------------ |

|

| -------------- | --------------------------------------------------------------------------------------------------- |

|

||||||

| cZxid | create ZXID,即该数据节点被创建时的事务 id |

|

| cZxid | create ZXID,即该数据节点被创建时的事务 id |

|

||||||

| ctime | create time,即该节点的创建时间 |

|

| ctime | create time,即该节点的创建时间 |

|

||||||

| mZxid | modified ZXID,即该节点最终一次更新时的事务 id |

|

| mZxid | modified ZXID,即该节点最终一次更新时的事务 id |

|

||||||

@ -202,7 +202,7 @@ Session 有一个属性叫做:`sessionTimeout` ,`sessionTimeout` 代表会

|

|||||||

ZooKeeper 集群中的所有机器通过一个 **Leader 选举过程** 来选定一台称为 “**Leader**” 的机器,Leader 既可以为客户端提供写服务又能提供读服务。除了 Leader 外,**Follower** 和 **Observer** 都只能提供读服务。Follower 和 Observer 唯一的区别在于 Observer 机器不参与 Leader 的选举过程,也不参与写操作的“过半写成功”策略,因此 Observer 机器可以在不影响写性能的情况下提升集群的读性能。

|

ZooKeeper 集群中的所有机器通过一个 **Leader 选举过程** 来选定一台称为 “**Leader**” 的机器,Leader 既可以为客户端提供写服务又能提供读服务。除了 Leader 外,**Follower** 和 **Observer** 都只能提供读服务。Follower 和 Observer 唯一的区别在于 Observer 机器不参与 Leader 的选举过程,也不参与写操作的“过半写成功”策略,因此 Observer 机器可以在不影响写性能的情况下提升集群的读性能。

|

||||||

|

|

||||||

| 角色 | 说明 |

|

| 角色 | 说明 |

|

||||||

| -------- | ------------------------------------------------------------ |

|

| -------- | --------------------------------------------------------------------------------------------------------------------------------------------------------------------------------- |

|

||||||

| Leader | 为客户端提供读和写的服务,负责投票的发起和决议,更新系统状态。 |

|

| Leader | 为客户端提供读和写的服务,负责投票的发起和决议,更新系统状态。 |

|

||||||

| Follower | 为客户端提供读服务,如果是写服务则转发给 Leader。参与选举过程中的投票。 |

|

| Follower | 为客户端提供读服务,如果是写服务则转发给 Leader。参与选举过程中的投票。 |

|

||||||

| Observer | 为客户端提供读服务,如果是写服务则转发给 Leader。不参与选举过程中的投票,也不参与“过半写成功”策略。在不影响写性能的情况下提升集群的读性能。此角色于 ZooKeeper3.3 系列新增的角色。 |

|

| Observer | 为客户端提供读服务,如果是写服务则转发给 Leader。不参与选举过程中的投票,也不参与“过半写成功”策略。在不影响写性能的情况下提升集群的读性能。此角色于 ZooKeeper3.3 系列新增的角色。 |

|

||||||

|

|||||||

@ -79,9 +79,9 @@ tag:

|

|||||||

|

|

||||||

|

|

||||||

|

|

||||||

* **单点故障问题**,如果协调者挂了那么整个系统都处于不可用的状态了。

|

- **单点故障问题**,如果协调者挂了那么整个系统都处于不可用的状态了。

|

||||||

* **阻塞问题**,即当协调者发送 `prepare` 请求,参与者收到之后如果能处理那么它将会进行事务的处理但并不提交,这个时候会一直占用着资源不释放,如果此时协调者挂了,那么这些资源都不会再释放了,这会极大影响性能。

|

- **阻塞问题**,即当协调者发送 `prepare` 请求,参与者收到之后如果能处理那么它将会进行事务的处理但并不提交,这个时候会一直占用着资源不释放,如果此时协调者挂了,那么这些资源都不会再释放了,这会极大影响性能。

|

||||||

* **数据不一致问题**,比如当第二阶段,协调者只发送了一部分的 `commit` 请求就挂了,那么也就意味着,收到消息的参与者会进行事务的提交,而后面没收到的则不会进行事务提交,那么这时候就会产生数据不一致性问题。

|

- **数据不一致问题**,比如当第二阶段,协调者只发送了一部分的 `commit` 请求就挂了,那么也就意味着,收到消息的参与者会进行事务的提交,而后面没收到的则不会进行事务提交,那么这时候就会产生数据不一致性问题。

|

||||||

|

|

||||||

### 3PC(三阶段提交)

|

### 3PC(三阶段提交)

|

||||||

|

|

||||||

@ -109,8 +109,8 @@ tag:

|

|||||||

|

|

||||||

#### prepare 阶段

|

#### prepare 阶段

|

||||||

|

|

||||||

* `Proposer提案者`:负责提出 `proposal`,每个提案者在提出提案时都会首先获取到一个 **具有全局唯一性的、递增的提案编号N**,即在整个集群中是唯一的编号 N,然后将该编号赋予其要提出的提案,在**第一阶段是只将提案编号发送给所有的表决者**。

|

- `Proposer提案者`:负责提出 `proposal`,每个提案者在提出提案时都会首先获取到一个 **具有全局唯一性的、递增的提案编号 N**,即在整个集群中是唯一的编号 N,然后将该编号赋予其要提出的提案,在**第一阶段是只将提案编号发送给所有的表决者**。

|

||||||

* `Acceptor表决者`:每个表决者在 `accept` 某提案后,会将该提案编号N记录在本地,这样每个表决者中保存的已经被 accept 的提案中会存在一个**编号最大的提案**,其编号假设为 `maxN`。每个表决者仅会 `accept` 编号大于自己本地 `maxN` 的提案,在批准提案时表决者会将以前接受过的最大编号的提案作为响应反馈给 `Proposer` 。

|

- `Acceptor表决者`:每个表决者在 `accept` 某提案后,会将该提案编号 N 记录在本地,这样每个表决者中保存的已经被 accept 的提案中会存在一个**编号最大的提案**,其编号假设为 `maxN`。每个表决者仅会 `accept` 编号大于自己本地 `maxN` 的提案,在批准提案时表决者会将以前接受过的最大编号的提案作为响应反馈给 `Proposer` 。

|

||||||

|

|

||||||

> 下面是 `prepare` 阶段的流程图,你可以对照着参考一下。

|

> 下面是 `prepare` 阶段的流程图,你可以对照着参考一下。

|

||||||

|

|

||||||

@ -156,9 +156,9 @@ tag:

|

|||||||

|

|

||||||

和介绍 `Paxos` 一样,在介绍 `ZAB` 协议之前,我们首先来了解一下在 `ZAB` 中三个主要的角色,`Leader 领导者`、`Follower跟随者`、`Observer观察者` 。

|

和介绍 `Paxos` 一样,在介绍 `ZAB` 协议之前,我们首先来了解一下在 `ZAB` 中三个主要的角色,`Leader 领导者`、`Follower跟随者`、`Observer观察者` 。

|

||||||

|

|

||||||

* `Leader` :集群中 **唯一的写请求处理者** ,能够发起投票(投票也是为了进行写请求)。

|

- `Leader` :集群中 **唯一的写请求处理者** ,能够发起投票(投票也是为了进行写请求)。

|

||||||

* `Follower`:能够接收客户端的请求,如果是读请求则可以自己处理,**如果是写请求则要转发给 `Leader`** 。在选举过程中会参与投票,**有选举权和被选举权** 。

|

- `Follower`:能够接收客户端的请求,如果是读请求则可以自己处理,**如果是写请求则要转发给 `Leader`** 。在选举过程中会参与投票,**有选举权和被选举权** 。

|

||||||

* `Observer` :就是没有选举权和被选举权的 `Follower` 。

|

- `Observer` :就是没有选举权和被选举权的 `Follower` 。

|

||||||

|

|

||||||

在 `ZAB` 协议中对 `zkServer`(即上面我们说的三个角色的总称) 还有两种模式的定义,分别是 **消息广播** 和 **崩溃恢复** 。

|

在 `ZAB` 协议中对 `zkServer`(即上面我们说的三个角色的总称) 还有两种模式的定义,分别是 **消息广播** 和 **崩溃恢复** 。

|

||||||

|

|

||||||

@ -242,24 +242,24 @@ tag:

|

|||||||

|

|

||||||

其中节点类型可以分为 **持久节点**、**持久顺序节点**、**临时节点** 和 **临时顺序节点**。

|

其中节点类型可以分为 **持久节点**、**持久顺序节点**、**临时节点** 和 **临时顺序节点**。

|

||||||

|

|

||||||

* 持久节点:一旦创建就一直存在,直到将其删除。

|

- 持久节点:一旦创建就一直存在,直到将其删除。

|

||||||

* 持久顺序节点:一个父节点可以为其子节点 **维护一个创建的先后顺序** ,这个顺序体现在 **节点名称** 上,是节点名称后自动添加一个由 10 位数字组成的数字串,从 0 开始计数。

|

- 持久顺序节点:一个父节点可以为其子节点 **维护一个创建的先后顺序** ,这个顺序体现在 **节点名称** 上,是节点名称后自动添加一个由 10 位数字组成的数字串,从 0 开始计数。

|

||||||

* 临时节点:临时节点的生命周期是与 **客户端会话** 绑定的,**会话消失则节点消失** 。临时节点 **只能做叶子节点** ,不能创建子节点。

|

- 临时节点:临时节点的生命周期是与 **客户端会话** 绑定的,**会话消失则节点消失** 。临时节点 **只能做叶子节点** ,不能创建子节点。

|

||||||

* 临时顺序节点:父节点可以创建一个维持了顺序的临时节点(和前面的持久顺序性节点一样)。

|

- 临时顺序节点:父节点可以创建一个维持了顺序的临时节点(和前面的持久顺序性节点一样)。

|

||||||

|

|

||||||

节点状态中包含了很多节点的属性比如 `czxid` 、`mzxid` 等等,在 `zookeeper` 中是使用 `Stat` 这个类来维护的。下面我列举一些属性解释。

|

节点状态中包含了很多节点的属性比如 `czxid` 、`mzxid` 等等,在 `zookeeper` 中是使用 `Stat` 这个类来维护的。下面我列举一些属性解释。

|

||||||

|

|

||||||

* `czxid`:`Created ZXID`,该数据节点被 **创建** 时的事务ID。

|

- `czxid`:`Created ZXID`,该数据节点被 **创建** 时的事务 ID。

|

||||||

* `mzxid`:`Modified ZXID`,节点 **最后一次被更新时** 的事务ID。

|

- `mzxid`:`Modified ZXID`,节点 **最后一次被更新时** 的事务 ID。

|

||||||

* `ctime`:`Created Time`,该节点被创建的时间。

|

- `ctime`:`Created Time`,该节点被创建的时间。

|

||||||

* `mtime`: `Modified Time`,该节点最后一次被修改的时间。

|

- `mtime`: `Modified Time`,该节点最后一次被修改的时间。

|

||||||

* `version`:节点的版本号。

|

- `version`:节点的版本号。

|

||||||

* `cversion`:**子节点** 的版本号。

|

- `cversion`:**子节点** 的版本号。

|

||||||

* `aversion`:节点的 `ACL` 版本号。

|

- `aversion`:节点的 `ACL` 版本号。

|

||||||

* `ephemeralOwner`:创建该节点的会话的 `sessionID` ,如果该节点为持久节点,该值为0。

|

- `ephemeralOwner`:创建该节点的会话的 `sessionID` ,如果该节点为持久节点,该值为 0。

|

||||||

* `dataLength`:节点数据内容的长度。

|

- `dataLength`:节点数据内容的长度。

|

||||||

* `numChildre`:该节点的子节点个数,如果为临时节点为0。

|

- `numChildre`:该节点的子节点个数,如果为临时节点为 0。

|

||||||

* `pzxid`:该节点子节点列表最后一次被修改时的事务ID,注意是子节点的 **列表** ,不是内容。

|

- `pzxid`:该节点子节点列表最后一次被修改时的事务 ID,注意是子节点的 **列表** ,不是内容。

|

||||||

|

|

||||||

### 会话

|

### 会话

|

||||||

|

|

||||||

@ -271,11 +271,11 @@ tag:

|

|||||||

|

|

||||||

`ACL` 为 `Access Control Lists` ,它是一种权限控制。在 `zookeeper` 中定义了 5 种权限,它们分别为:

|

`ACL` 为 `Access Control Lists` ,它是一种权限控制。在 `zookeeper` 中定义了 5 种权限,它们分别为:

|

||||||

|

|

||||||

* `CREATE` :创建子节点的权限。

|

- `CREATE` :创建子节点的权限。

|

||||||

* `READ`:获取节点数据和子节点列表的权限。

|

- `READ`:获取节点数据和子节点列表的权限。

|

||||||

* `WRITE`:更新节点数据的权限。

|

- `WRITE`:更新节点数据的权限。

|

||||||

* `DELETE`:删除子节点的权限。

|

- `DELETE`:删除子节点的权限。

|

||||||

* `ADMIN`:设置节点 ACL 的权限。

|

- `ADMIN`:设置节点 ACL 的权限。

|

||||||

|

|

||||||

### Watcher 机制

|

### Watcher 机制

|

||||||

|

|

||||||

@ -357,14 +357,14 @@ tag:

|

|||||||

|

|

||||||

这篇文章中我带大家入门了 `zookeeper` 这个强大的分布式协调框架。现在我们来简单梳理一下整篇文章的内容。

|

这篇文章中我带大家入门了 `zookeeper` 这个强大的分布式协调框架。现在我们来简单梳理一下整篇文章的内容。

|

||||||

|

|

||||||

* 分布式与集群的区别

|

- 分布式与集群的区别

|

||||||

|

|

||||||

* `2PC` 、`3PC` 以及 `paxos` 算法这些一致性框架的原理和实现。

|

- `2PC` 、`3PC` 以及 `paxos` 算法这些一致性框架的原理和实现。

|

||||||

|

|

||||||

* `zookeeper` 专门的一致性算法 `ZAB` 原子广播协议的内容(`Leader` 选举、崩溃恢复、消息广播)。

|

- `zookeeper` 专门的一致性算法 `ZAB` 原子广播协议的内容(`Leader` 选举、崩溃恢复、消息广播)。

|

||||||

|

|

||||||

* `zookeeper` 中的一些基本概念,比如 `ACL`,数据节点,会话,`watcher`机制等等。

|

- `zookeeper` 中的一些基本概念,比如 `ACL`,数据节点,会话,`watcher`机制等等。

|

||||||

|

|

||||||

* `zookeeper` 的典型应用场景,比如选主,注册中心等等。

|

- `zookeeper` 的典型应用场景,比如选主,注册中心等等。

|

||||||

|

|

||||||

如果忘了可以回去看看再次理解一下,如果有疑问和建议欢迎提出 🤝🤝🤝。

|

如果忘了可以回去看看再次理解一下,如果有疑问和建议欢迎提出 🤝🤝🤝。

|

||||||

|

|||||||

@ -210,7 +210,6 @@ Dubbo 采用 微内核(Microkernel) + 插件(Plugin) 模式,简单来

|

|||||||

|

|

||||||

不会。两者都宕机也不影响已运行的提供者和消费者,消费者在本地缓存了提供者列表。注册中心和监控中心都是可选的,服务消费者可以直连服务提供者。

|

不会。两者都宕机也不影响已运行的提供者和消费者,消费者在本地缓存了提供者列表。注册中心和监控中心都是可选的,服务消费者可以直连服务提供者。

|

||||||

|

|

||||||

|

|

||||||

## Dubbo 的负载均衡策略

|

## Dubbo 的负载均衡策略

|

||||||

|

|

||||||

### 什么是负载均衡?

|

### 什么是负载均衡?

|

||||||

@ -411,8 +410,6 @@ public class RpcStatus {

|

|||||||

|

|

||||||

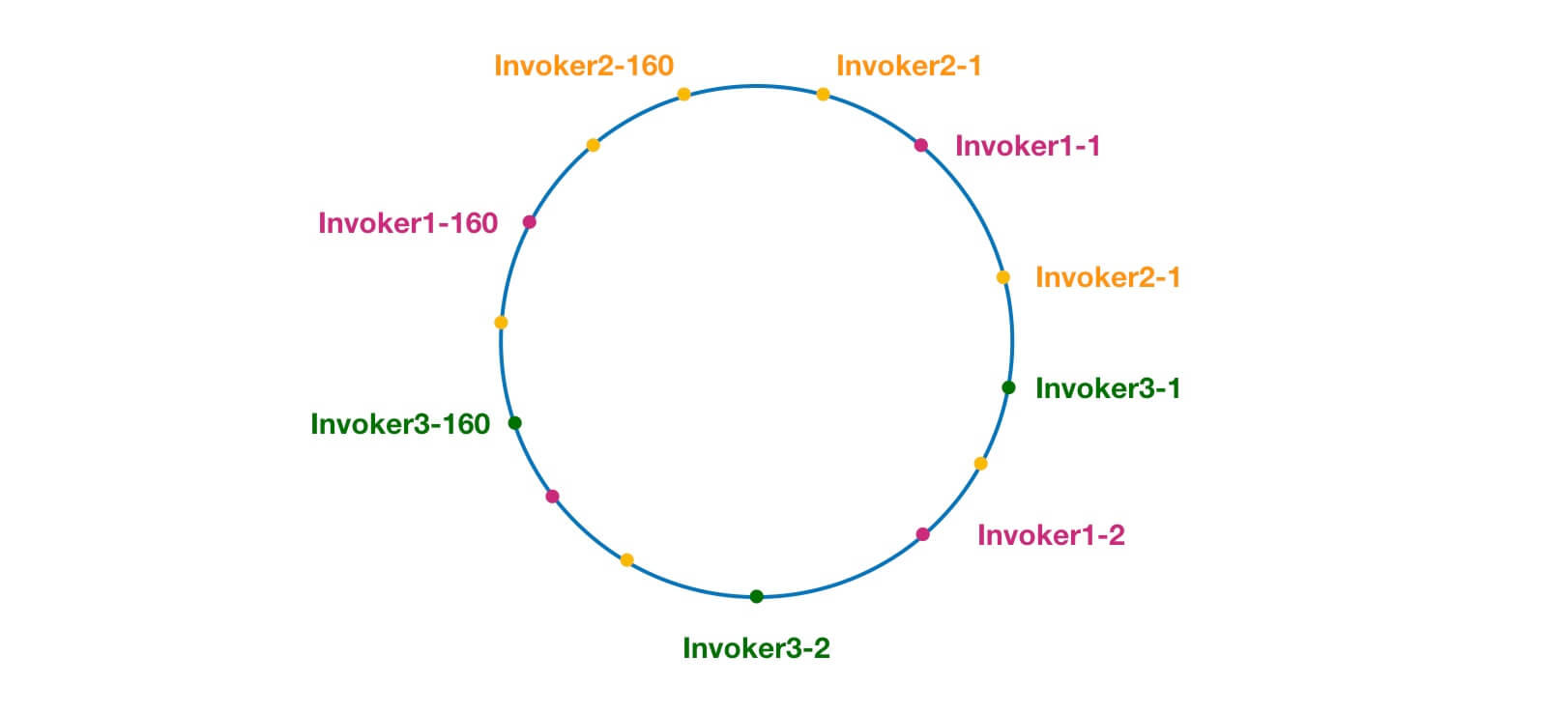

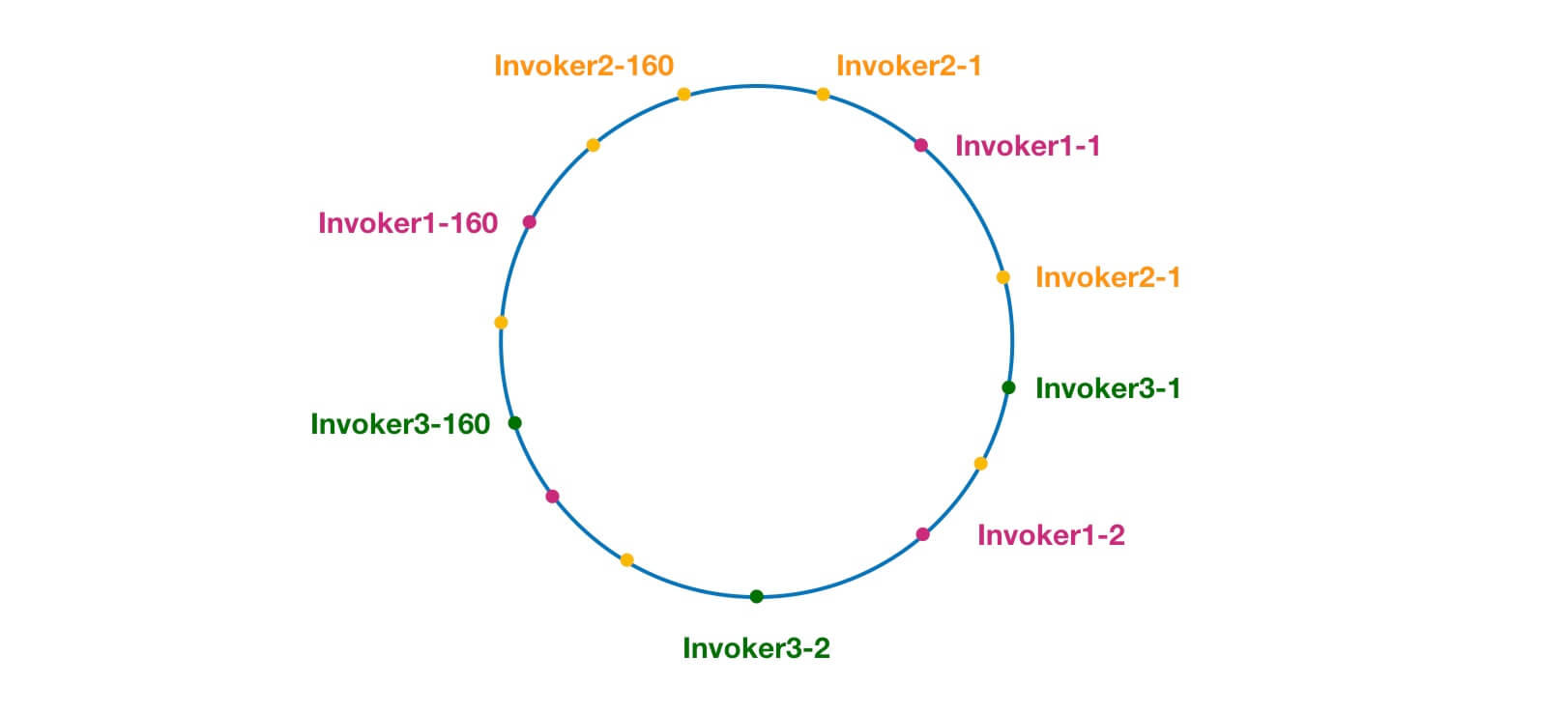

另外,Dubbo 为了避免数据倾斜问题(节点不够分散,大量请求落到同一节点),还引入了虚拟节点的概念。通过虚拟节点可以让节点更加分散,有效均衡各个节点的请求量。

|

另外,Dubbo 为了避免数据倾斜问题(节点不够分散,大量请求落到同一节点),还引入了虚拟节点的概念。通过虚拟节点可以让节点更加分散,有效均衡各个节点的请求量。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

官方有详细的源码分析:[https://dubbo.apache.org/zh/docs/v2.7/dev/source/loadbalance/#23-consistenthashloadbalance](https://dubbo.apache.org/zh/docs/v2.7/dev/source/loadbalance/#23-consistenthashloadbalance) 。这里还有一个相关的 [PR#5440](https://github.com/apache/dubbo/pull/5440) 来修复老版本中 ConsistentHashLoadBalance 存在的一些 Bug。感兴趣的小伙伴,可以多花点时间研究一下。我这里不多分析了,这个作业留给你们!

|

官方有详细的源码分析:[https://dubbo.apache.org/zh/docs/v2.7/dev/source/loadbalance/#23-consistenthashloadbalance](https://dubbo.apache.org/zh/docs/v2.7/dev/source/loadbalance/#23-consistenthashloadbalance) 。这里还有一个相关的 [PR#5440](https://github.com/apache/dubbo/pull/5440) 来修复老版本中 ConsistentHashLoadBalance 存在的一些 Bug。感兴趣的小伙伴,可以多花点时间研究一下。我这里不多分析了,这个作业留给你们!

|

||||||

@ -457,4 +454,3 @@ Kryo和FST这两种序列化方式是 Dubbo 后来才引入的,性能非常好

|

|||||||

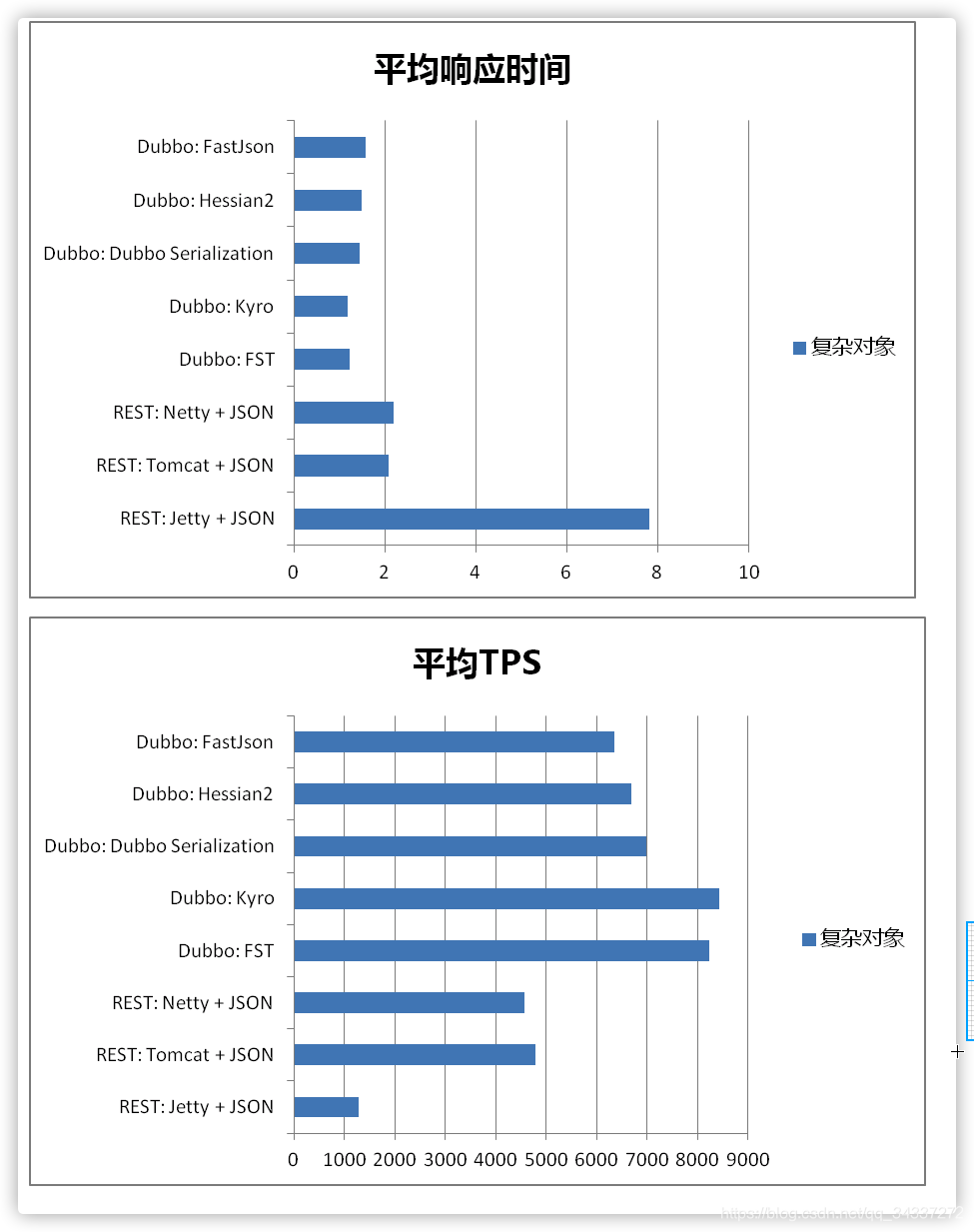

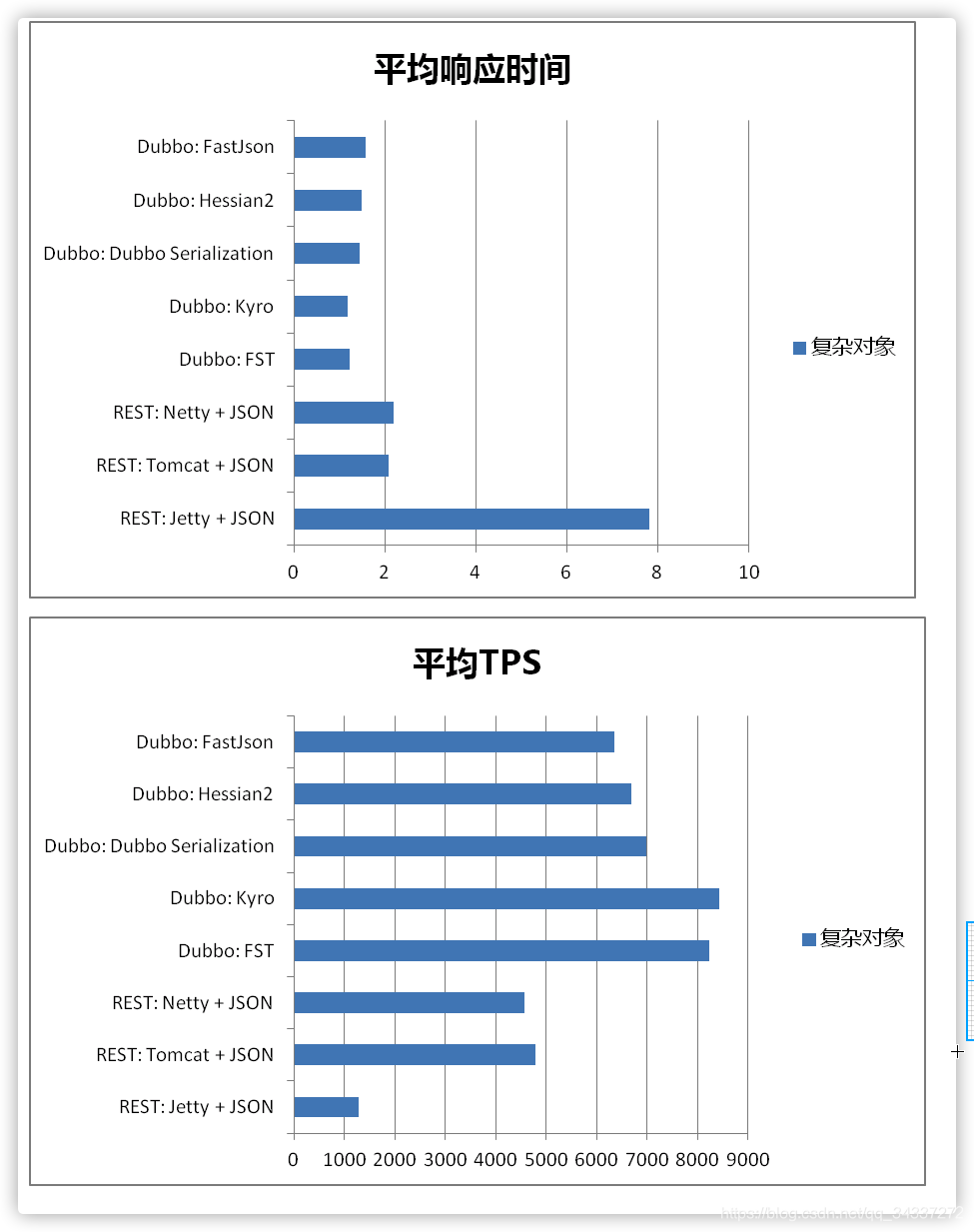

Dubbo 官方文档中还有一个关于这些[序列化协议的性能对比图](https://dubbo.apache.org/zh/docs/v2.7/user/serialization/#m-zhdocsv27userserialization)可供参考。

|

Dubbo 官方文档中还有一个关于这些[序列化协议的性能对比图](https://dubbo.apache.org/zh/docs/v2.7/user/serialization/#m-zhdocsv27userserialization)可供参考。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|||||||

@ -13,10 +13,8 @@ tag:

|

|||||||

|

|

||||||

**为什么要 RPC ?** 因为,两个不同的服务器上的服务提供的方法不在一个内存空间,所以,需要通过网络编程才能传递方法调用所需要的参数。并且,方法调用的结果也需要通过网络编程来接收。但是,如果我们自己手动网络编程来实现这个调用过程的话工作量是非常大的,因为,我们需要考虑底层传输方式(TCP 还是 UDP)、序列化方式等等方面。

|

**为什么要 RPC ?** 因为,两个不同的服务器上的服务提供的方法不在一个内存空间,所以,需要通过网络编程才能传递方法调用所需要的参数。并且,方法调用的结果也需要通过网络编程来接收。但是,如果我们自己手动网络编程来实现这个调用过程的话工作量是非常大的,因为,我们需要考虑底层传输方式(TCP 还是 UDP)、序列化方式等等方面。

|

||||||

|

|

||||||

|

|

||||||

**RPC 能帮助我们做什么呢?** 简单来说,通过 RPC 可以帮助我们调用远程计算机上某个服务的方法,这个过程就像调用本地方法一样简单。并且!我们不需要了解底层网络编程的具体细节。

|

**RPC 能帮助我们做什么呢?** 简单来说,通过 RPC 可以帮助我们调用远程计算机上某个服务的方法,这个过程就像调用本地方法一样简单。并且!我们不需要了解底层网络编程的具体细节。

|

||||||

|

|

||||||

|

|

||||||

举个例子:两个不同的服务 A、B 部署在两台不同的机器上,服务 A 如果想要调用服务 B 中的某个方法的话就可以通过 RPC 来做。

|

举个例子:两个不同的服务 A、B 部署在两台不同的机器上,服务 A 如果想要调用服务 B 中的某个方法的话就可以通过 RPC 来做。

|

||||||

|

|

||||||

一言蔽之:**RPC 的出现就是为了让你调用远程方法像调用本地方法一样简单。**

|

一言蔽之:**RPC 的出现就是为了让你调用远程方法像调用本地方法一样简单。**

|

||||||

@ -25,7 +23,6 @@ tag:

|

|||||||

|

|

||||||

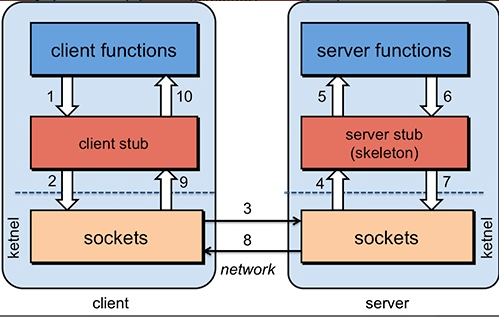

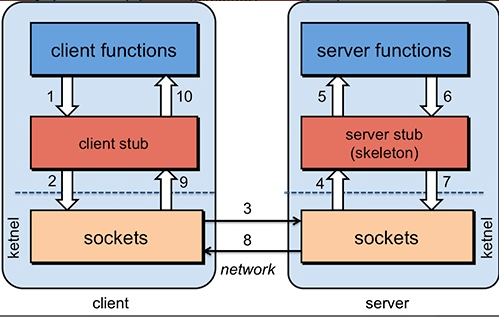

为了能够帮助小伙伴们理解 RPC 原理,我们可以将整个 RPC 的 核心功能看作是下面 👇 5 个部分实现的:

|

为了能够帮助小伙伴们理解 RPC 原理,我们可以将整个 RPC 的 核心功能看作是下面 👇 5 个部分实现的:

|

||||||

|

|

||||||

|

|

||||||

1. **客户端(服务消费端)** :调用远程方法的一端。

|

1. **客户端(服务消费端)** :调用远程方法的一端。

|

||||||

1. **客户端 Stub(桩)** : 这其实就是一代理类。代理类主要做的事情很简单,就是把你调用方法、类、方法参数等信息传递到服务端。

|

1. **客户端 Stub(桩)** : 这其实就是一代理类。代理类主要做的事情很简单,就是把你调用方法、类、方法参数等信息传递到服务端。

|

||||||

1. **网络传输** : 网络传输就是你要把你调用的方法的信息比如说参数啊这些东西传输到服务端,然后服务端执行完之后再把返回结果通过网络传输给你传输回来。网络传输的实现方式有很多种比如最近基本的 Socket 或者性能以及封装更加优秀的 Netty(推荐)。

|

1. **网络传输** : 网络传输就是你要把你调用的方法的信息比如说参数啊这些东西传输到服务端,然后服务端执行完之后再把返回结果通过网络传输给你传输回来。网络传输的实现方式有很多种比如最近基本的 Socket 或者性能以及封装更加优秀的 Netty(推荐)。

|

||||||

@ -34,7 +31,6 @@ tag:

|

|||||||

|

|

||||||

具体原理图如下,后面我会串起来将整个 RPC 的过程给大家说一下。

|

具体原理图如下,后面我会串起来将整个 RPC 的过程给大家说一下。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

1. 服务消费端(client)以本地调用的方式调用远程服务;

|

1. 服务消费端(client)以本地调用的方式调用远程服务;

|

||||||

@ -141,4 +137,3 @@ Dubbo 也是 Spring Cloud Alibaba 里面的一个组件。

|

|||||||

## 既然有了 HTTP 协议,为什么还要有 RPC ?

|

## 既然有了 HTTP 协议,为什么还要有 RPC ?

|

||||||

|

|

||||||

[HTTP 和 RPC 详细对比](http&rpc.md) 。

|

[HTTP 和 RPC 详细对比](http&rpc.md) 。

|

||||||

|

|

||||||

|

|||||||

@ -167,4 +167,3 @@ raft 的要求之一就是安全性不依赖于时间:系统不能仅仅因为

|

|||||||

- https://github.com/OneSizeFitsQuorum/raft-thesis-zh_cn/blob/master/raft-thesis-zh_cn.md

|

- https://github.com/OneSizeFitsQuorum/raft-thesis-zh_cn/blob/master/raft-thesis-zh_cn.md

|

||||||

- https://github.com/ongardie/dissertation/blob/master/stanford.pdf

|

- https://github.com/ongardie/dissertation/blob/master/stanford.pdf

|

||||||

- https://knowledge-sharing.gitbooks.io/raft/content/chapter5.html

|

- https://knowledge-sharing.gitbooks.io/raft/content/chapter5.html

|

||||||

|

|

||||||

|

|||||||

@ -95,8 +95,6 @@ Kafka 将生产者发布的消息发送到 **Topic(主题)** 中,需要这

|

|||||||

|

|

||||||

> **要想搞懂 zookeeper 在 Kafka 中的作用 一定要自己搭建一个 Kafka 环境然后自己进 zookeeper 去看一下有哪些文件夹和 Kafka 有关,每个节点又保存了什么信息。** 一定不要光看不实践,这样学来的也终会忘记!这部分内容参考和借鉴了这篇文章:https://www.jianshu.com/p/a036405f989c 。

|

> **要想搞懂 zookeeper 在 Kafka 中的作用 一定要自己搭建一个 Kafka 环境然后自己进 zookeeper 去看一下有哪些文件夹和 Kafka 有关,每个节点又保存了什么信息。** 一定不要光看不实践,这样学来的也终会忘记!这部分内容参考和借鉴了这篇文章:https://www.jianshu.com/p/a036405f989c 。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

下图就是我的本地 Zookeeper ,它成功和我本地的 Kafka 关联上(以下文件夹结构借助 idea 插件 Zookeeper tool 实现)。

|

下图就是我的本地 Zookeeper ,它成功和我本地的 Kafka 关联上(以下文件夹结构借助 idea 插件 Zookeeper tool 实现)。

|

||||||

|

|

||||||

<img src="https://my-blog-to-use.oss-cn-beijing.aliyuncs.com/2019-11/zookeeper-kafka.jpg" style="zoom:50%;" />

|

<img src="https://my-blog-to-use.oss-cn-beijing.aliyuncs.com/2019-11/zookeeper-kafka.jpg" style="zoom:50%;" />

|

||||||

@ -158,11 +156,11 @@ if (sendResult.getRecordMetadata() != null) {

|

|||||||

|

|

||||||

但是一般不推荐这么做!可以采用为其添加回调函数的形式,示例代码如下:

|

但是一般不推荐这么做!可以采用为其添加回调函数的形式,示例代码如下:

|

||||||

|

|

||||||

````java

|

```java

|

||||||

ListenableFuture<SendResult<String, Object>> future = kafkaTemplate.send(topic, o);

|

ListenableFuture<SendResult<String, Object>> future = kafkaTemplate.send(topic, o);

|

||||||

future.addCallback(result -> logger.info("生产者成功发送消息到topic:{} partition:{}的消息", result.getRecordMetadata().topic(), result.getRecordMetadata().partition()),

|

future.addCallback(result -> logger.info("生产者成功发送消息到topic:{} partition:{}的消息", result.getRecordMetadata().topic(), result.getRecordMetadata().partition()),

|

||||||

ex -> logger.error("生产者发送消失败,原因:{}", ex.getMessage()));

|

ex -> logger.error("生产者发送消失败,原因:{}", ex.getMessage()));

|

||||||

````

|

```

|

||||||

|

|

||||||

如果消息发送失败的话,我们检查失败的原因之后重新发送即可!

|

如果消息发送失败的话,我们检查失败的原因之后重新发送即可!

|

||||||

|

|

||||||

@ -217,8 +215,8 @@ acks 的默认值即为1,代表我们的消息被leader副本接收之后就

|

|||||||

|

|

||||||

- 消费消息服务做幂等校验,比如 Redis 的 set、MySQL 的主键等天然的幂等功能。这种方法最有效。

|

- 消费消息服务做幂等校验,比如 Redis 的 set、MySQL 的主键等天然的幂等功能。这种方法最有效。

|

||||||

- 将 **`enable.auto.commit`** 参数设置为 false,关闭自动提交,开发者在代码中手动提交 offset。那么这里会有个问题:**什么时候提交 offset 合适?**

|

- 将 **`enable.auto.commit`** 参数设置为 false,关闭自动提交,开发者在代码中手动提交 offset。那么这里会有个问题:**什么时候提交 offset 合适?**

|

||||||

* 处理完消息再提交:依旧有消息重复消费的风险,和自动提交一样

|

- 处理完消息再提交:依旧有消息重复消费的风险,和自动提交一样

|

||||||

* 拉取到消息即提交:会有消息丢失的风险。允许消息延时的场景,一般会采用这种方式。然后,通过定时任务在业务不繁忙(比如凌晨)的时候做数据兜底。

|

- 拉取到消息即提交:会有消息丢失的风险。允许消息延时的场景,一般会采用这种方式。然后,通过定时任务在业务不繁忙(比如凌晨)的时候做数据兜底。

|

||||||

|

|

||||||

### Reference

|

### Reference

|

||||||

|

|

||||||

|

|||||||

@ -130,7 +130,7 @@ AMQP,即 Advanced Message Queuing Protocol,一个提供统一消息服务的

|

|||||||

### JMS vs AMQP

|

### JMS vs AMQP

|

||||||

|

|

||||||

| 对比方向 | JMS | AMQP |

|

| 对比方向 | JMS | AMQP |

|

||||||

| :----------: | :-------------------------------------- | :----------------------------------------------------------- |

|

| :----------: | :-------------------------------------- | :------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------- |

|

||||||

| 定义 | Java API | 协议 |

|

| 定义 | Java API | 协议 |

|

||||||

| 跨语言 | 否 | 是 |

|

| 跨语言 | 否 | 是 |

|

||||||

| 跨平台 | 否 | 是 |

|

| 跨平台 | 否 | 是 |

|

||||||

@ -260,7 +260,7 @@ Pulsar 更新记录(可以直观看到项目是否还在维护):https://gi

|

|||||||

> 参考《Java 工程师面试突击第 1 季-中华石杉老师》

|

> 参考《Java 工程师面试突击第 1 季-中华石杉老师》

|

||||||

|

|

||||||

| 对比方向 | 概要 |

|

| 对比方向 | 概要 |

|

||||||

| -------- | ------------------------------------------------------------ |

|

| -------- | ------------------------------------------------------------------------------------------------------------------------------------------------------------------------------- |

|

||||||

| 吞吐量 | 万级的 ActiveMQ 和 RabbitMQ 的吞吐量(ActiveMQ 的性能最差)要比十万级甚至是百万级的 RocketMQ 和 Kafka 低一个数量级。 |

|